**

安装适用于Linux *的OpenVINO™工具包的英特尔®发布版

**

此内容来自安装适用于Linux *的OpenVINO™工具包的英特尔®发布版

1. 介绍

英特尔®分布式OpenVINO™工具包可快速部署模拟人类视觉的应用程序和解决方案。 该工具包基于卷积神经网络(CNN),可扩展英特尔®硬件的计算机视觉(CV)工作负载,从而最大限度地提高性能。 英特尔®OpenlandOpen™管理软件包包括英特尔®深度学习部署工具包(英特尔®DLDT)。适用于Linux *的OpenVINO™工具包的英特尔®分发版:在边缘启用基于CNN的深度学习推理通过英特尔®Movidius™VPU支持跨英特尔®CPU,英特尔®集成显卡,英特尔®Movidius™神经计算棒,英特尔®神经计算棒2和英特尔®视觉加速器设计的异构执行通过易于使用的计算机视觉功能库和预优化的内核,加快产品上市速度包括针对计算机视觉标准的优化调用,包括OpenCV *,OpenCL™和OpenVX *。

2. 发展和目标平台

开发和目标平台具有相同的要求,但您可以根据预期用途在安装期间选择不同的组件。硬件第6代 - 第8代Intel®Core™英特尔®至强®v5系列英特尔®至强®v6系列采用英特尔®高清显卡的英特尔®奔腾®处理器N4200 / 5,N3350 / 5,N3450 / 5英特尔®Movidius™神经计算棒英特尔®神经计算棒2采用Intel®Movidius™VPU的英特尔®视觉加速器设计处理器说明:处理器图形不包含在所有处理器中。 有关处理器的信息,请参阅产品规格。英特尔®至强®处理器需要支持处理器图形的芯片组。操作系统Ubuntu 16.04.x长期支持(LTS),64位:最低支持内核为4.14CentOS 7.4,64位(仅限目标)Yocto Project Poky Jethro v2.0.3,64位(仅限目标并需要修改)

3 概述

本指南提供了有关如何安装英特尔®分布式OpenVINO™工具包的逐步说明。 为每种类型的兼容硬件提供链接,包括下载,初始化和配置步骤。 将涵盖以下步骤:

安装英特尔®分布式OpenVINO™工具包安装外部软件依赖项将OpenVINO™环境变量:

可选更新设置为.bashrc。

配置模型优化程序运行验证脚本以验证安装和编译示例英特尔®处理器显卡(GPU)的步骤

英特尔®Movidius™神经计算棒和英特尔®神经计算棒2的步骤采用Intel®Movidius™VPU的英特尔®视觉加速器设计步骤

安装英特尔®Movidius™VPU后,您将返回本指南以完成OpenVINO™安装。

运行示例应用程序使用人脸检测教程。

4 安装英特尔®分布式OpenVINO™工具包核心组件步骤

从适用于Linux *的OpenVINO™工具包的英特尔®分发版下载英特尔®分布式OpenVINO™工具包软件包。 从下拉菜单中选择英特尔®Exportfor OpenVINO™工具包。

1.打开命令提示符终端窗口。

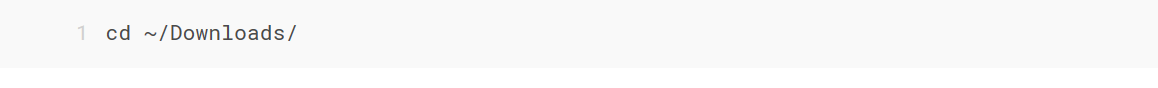

2.将目录更改为您下载英特尔分发OpenVINO工具包for Linux *包文件的位置。如果您将软件包文件下载到当前用户的下载目录:

默认情况下,该文件保存为l_openvino_toolkit_p_ .tgz。

默认情况下,该文件保存为l_openvino_toolkit_p_ .tgz。

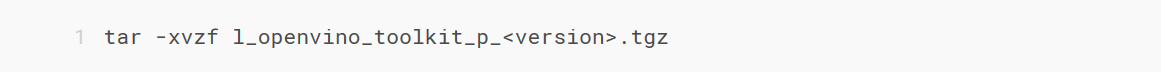

3.解压缩.tgz文件:

这些文件将解压缩到l_openvino_toolkit_p_ 目录。

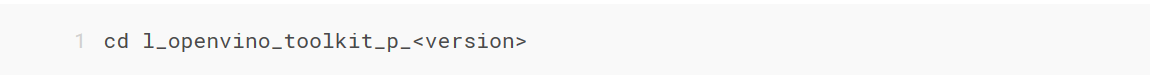

4.转到l_openvino_toolkit_p_ 目录:

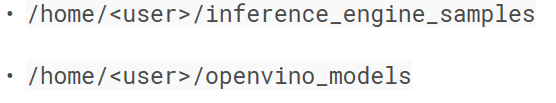

如果您安装了以前版本的Intel Distribution of OpenVINO工具包,请重命名或删除这两个目录:

5.安装说明:

(1)选择安装选项并以root身份运行相关脚本。

(2)您可以使用GUI安装向导或命令行指令(CLI)。

(3)屏幕截图是为GUI提供的,但不是为CLI提供的。 以下信息也适用于CLI,对您的安装有所帮助,您将获得相同的选择和任务。

1.选择您的安装选项:

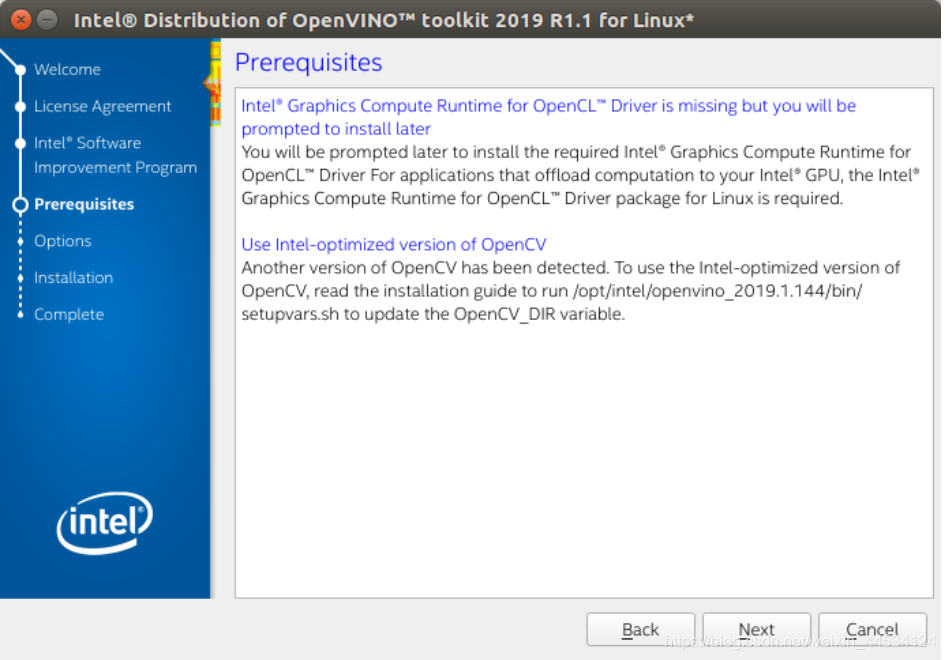

2.按照屏幕上的说明操作。 如果您必须完成其他步骤,请注意以下信息性消息:

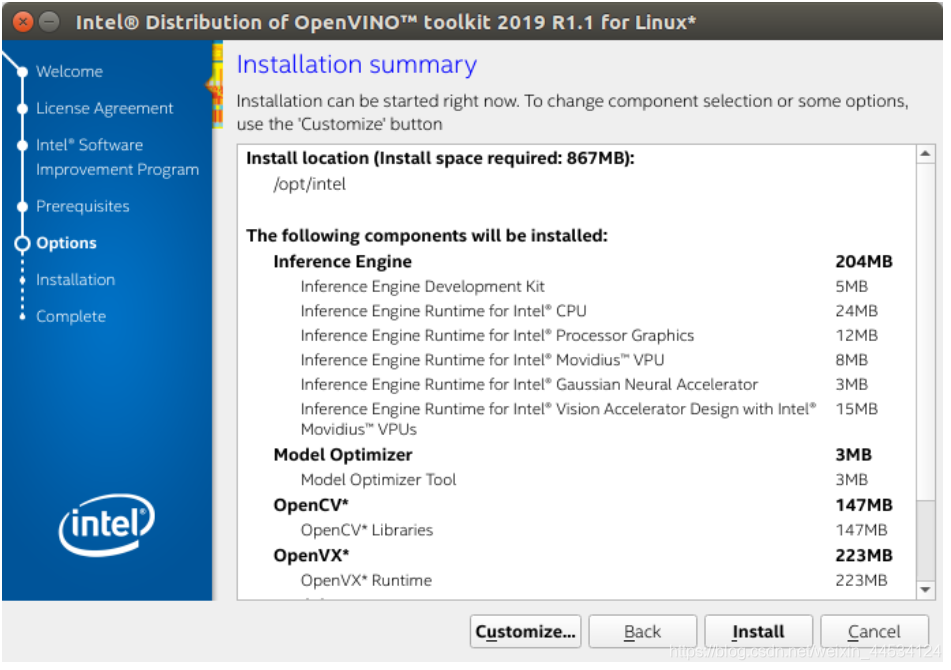

3.如果选择默认选项,则安装摘要GUI屏幕如下所示:

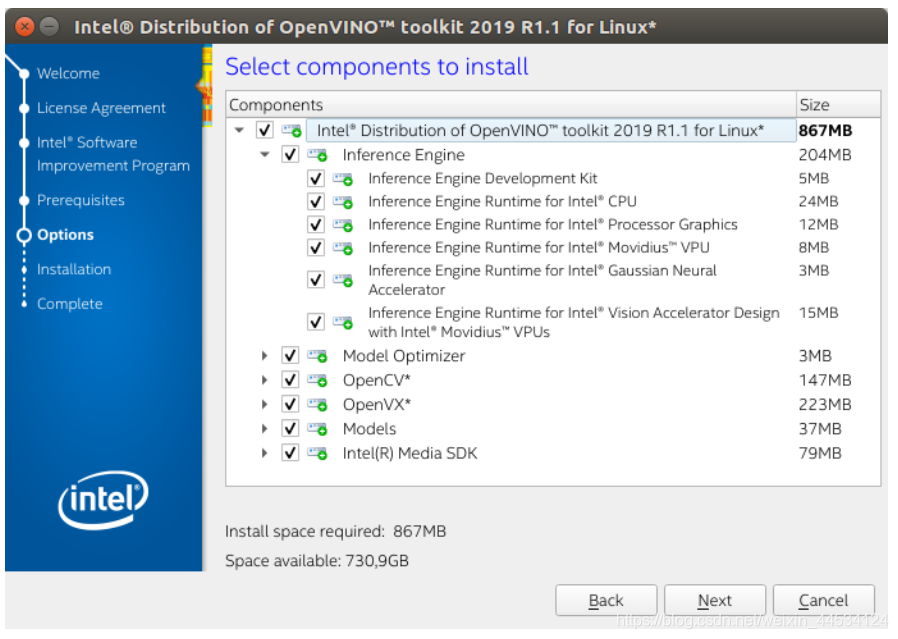

可选:您可以选择“自定义”以更改安装目录或要安装的组件:

以root身份安装时,OpenVINO的Intel Distribution的默认安装目录是/ opt / intel / openvino_ /。为简单起见,还创建了指向最新安装的符号链接:/ opt / intel / openvino /。

以root身份安装时,OpenVINO的Intel Distribution的默认安装目录是/ opt / intel / openvino_ /。为简单起见,还创建了指向最新安装的符号链接:/ opt / intel / openvino /。

注意:无论选择何种OpenVINO安装路径,Intel®MediaSDK组件始终安装在/ opt / intel / mediasdk目录中。

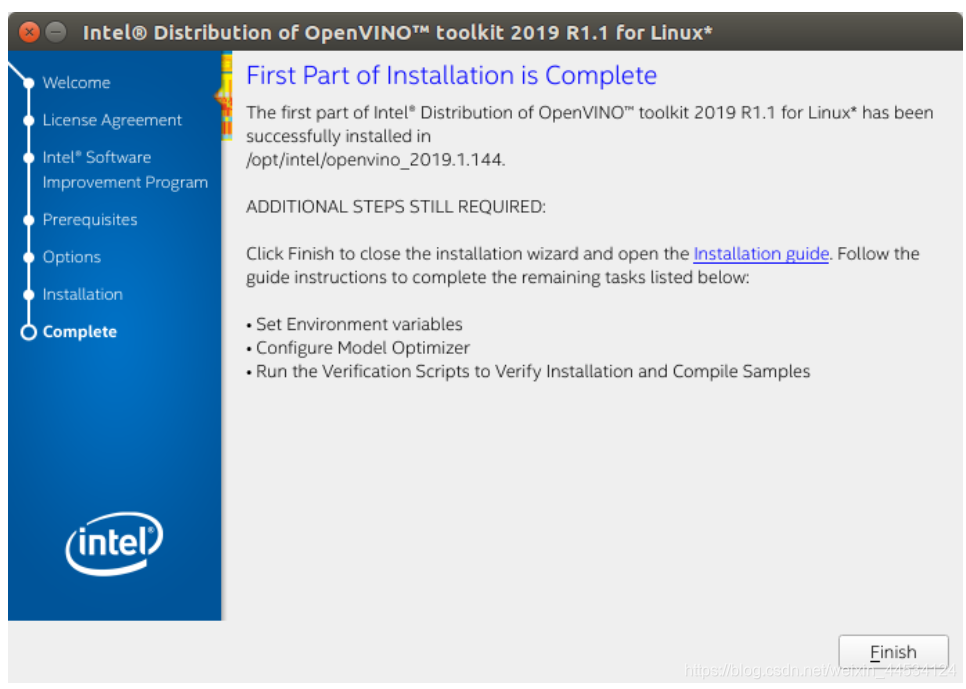

4.完整屏幕表明已安装核心组件:

安装了第一个核心组件。 继续下一部分以安装其他依赖项。

安装了第一个核心组件。 继续下一部分以安装其他依赖项。

6.安装外部软件依赖项

这些依赖关系是必需的:

1.英特尔优化的OpenCV

2.深度学习推理引擎

3.深度学习模型优化工具

切换到install_dependencies目录:

cd / opt / intel / openvino / install_dependencies

运行脚本以下载并安装外部软件依赖项:

sudo -E ./install_openvino_dependencies.sh

已安装依赖项。 继续下一部分以设置环境变量。

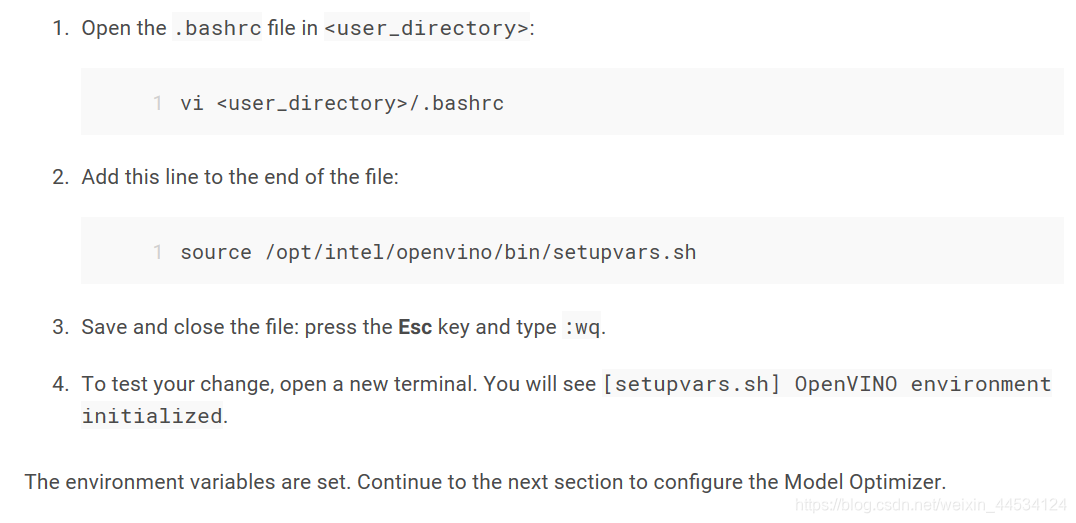

7 设置环境变量

在编译和运行OpenVINO™应用程序之前,必须更新多个环境变量。 运行以下脚本以临时设置环境变量:

source /opt/intel/openvino/bin/setupvars.sh

可选:关闭shell时将删除OpenVINO环境变量。 作为选项,您可以永久设置环境变量,如下所示:

8.配置模型优化程序

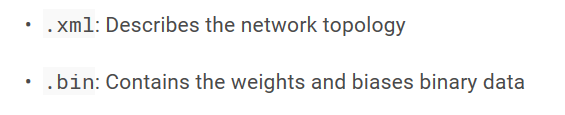

Model Optimizer是一个基于Python *的命令行工具,用于从流行的深度学习框架(如Caffe *,TensorFlow *,Apache MXNet *,ONNX *和Kaldi *)导入经过训练的模型。Model Optimizer是OpenLinkO工具包的Intel Distribution的关键组件。 如果不通过模型优化器运行模型,则无法对训练的模型进行推理。 当您通过模型优化器运行预先训练的模型时,您的输出是网络的中间表示(IR)。 Intermediate Representation是一对描述整个模型的文件:

有关模型优化程序的更多信息,请参阅模型优化程序开发人员指南模型优化指南

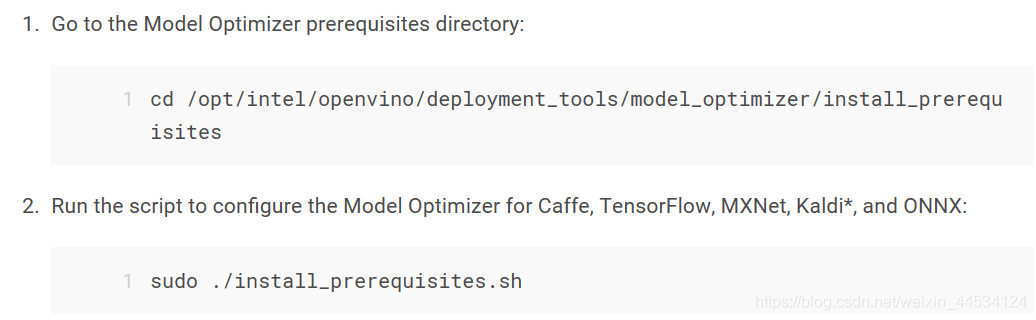

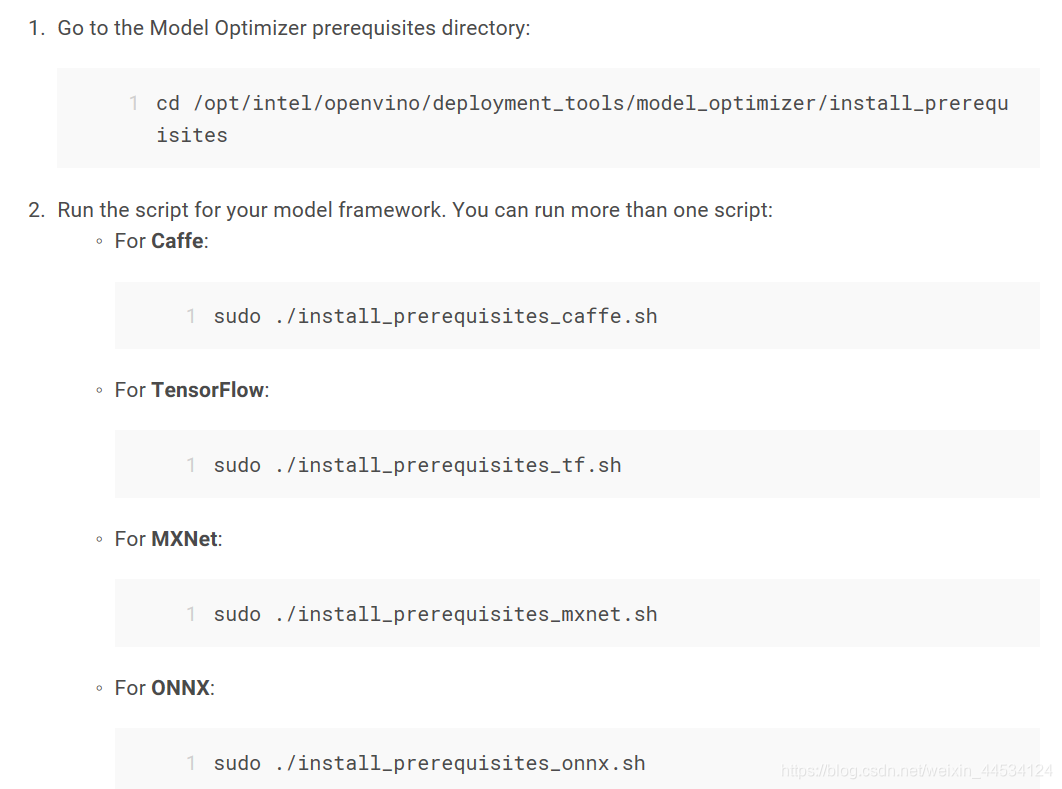

模型优化器配置步骤

您可以选择一次配置所有支持的框架,也可以一次配置一个框架。 选择最适合您需求的选项。 如果看到错误消息,请确保已安装所有依赖项。

**注意:由于CentOS *上未正式支持TensorFlow框架,因此无法在这些系统上配置和运行TensorFlow的模型优化器。**

**重要信息:成功执行以下步骤需要Internet访问权限。 如果您只能通过代理服务器访问Internet,请确保在您的操作系统环境中配置了Internet。**

**注意:如果您将OpenVINO™的英特尔®分发版安装到非默认安装目录,请将/ opt / intel替换为您安装软件的目录。**

选项1:同时配置所有支持的框架

选项2:单独配置每一个框架(仅在未选择上述选项1时单独配置各个框架。)

选项2:单独配置每一个框架(仅在未选择上述选项1时单独配置各个框架。)

您已准备好通过运行验证脚本来编译示例。

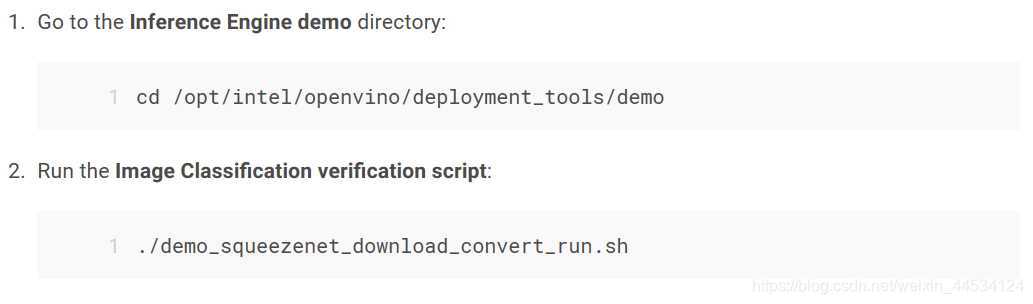

9.运行验证脚本以验证安装

重要提示:此部分是必需的。 除了确认安装成功之外,演示脚本还执行其他步骤,例如设置计算机以使用推理引擎示例。

要验证安装并编译两个示例,请运行CPU上随产品提供的验证应用程序:

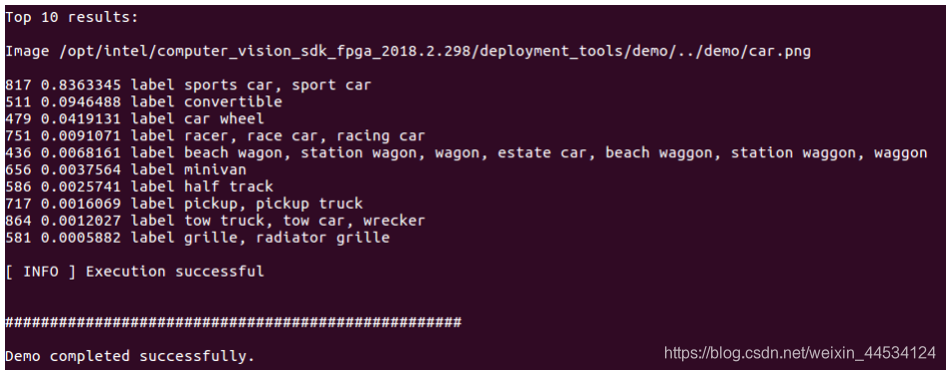

此验证脚本下载SqueezeNet模型,使用模型优化器将模型转换为.bin和.xml中间表示(IR)文件。 推理引擎需要此模型转换,因此它可以使用IR作为输入,并在英特尔硬件上实现最佳性能。此验证脚本构建了Image Classification Sample应用程序,并使用位于demo目录中的car.png图像运行它。 验证脚本完成后,您将获得前10个类别的标签和置信度:

此验证脚本下载SqueezeNet模型,使用模型优化器将模型转换为.bin和.xml中间表示(IR)文件。 推理引擎需要此模型转换,因此它可以使用IR作为输入,并在英特尔硬件上实现最佳性能。此验证脚本构建了Image Classification Sample应用程序,并使用位于demo目录中的car.png图像运行它。 验证脚本完成后,您将获得前10个类别的标签和置信度:

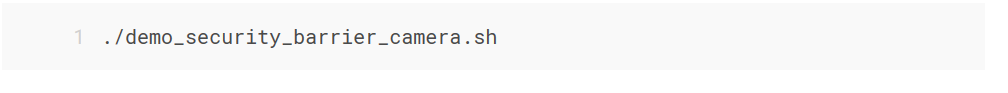

3.运行推理管道验证脚本:

该脚本下载三个预先训练的模型IR,构建安全屏障相机演示应用程序并使用下载的模型和演示目录中的car_1.bmp图像运行它以显示推理管道。 验证脚本使用车辆识别,其中车辆属性相互构建以缩小特定属性。首先,将物体识别为车辆。 该识别用作下一个模型的输入,该模型识别特定车辆属性,包括牌照。 最后,标识为牌照的属性被用作第三模型的输入,第三模型识别牌照中的特定字符。验证脚本完成后,您将看到一个图像,该图像显示生成的帧,其中检测项呈现为边界框和文本:

4.关闭图像查看器窗口以完成验证脚本。

要了解验证脚本,请参阅/ opt / intel / openvino / deployment_tools / demo中的README.txt文件。

有关OpenVINO™预训练对象检测和对象识别模型的英特尔分布的说明,请参阅OpenVINO™Toolkit预训练模型概述。

您已完成本指南中所有必需的安装,配置和构建步骤,以使用CPU来处理经过培训的模型。 要使用其他硬件,请参阅;

Steps for Intel® Processor Graphics (GPU)

Steps for Intel® Movidius™ Neural Compute Stick and Intel® Neural Compute Stick 2

Steps for Intel® Vision Accelerator Design with Intel® Movidius™ VPU

798

798

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?