一,torch.optim.lr_scheduler.CosineAnnealingLR

参数说明:

torch.optim.lr_scheduler.CosineAnnealingLR(optimizer,T_max,eta_min=0,last_epoch=-1)

T_max:因为学习率是周期性变化的,该参数表示周期的1/2,也就是说,初始的学习率为a,经过2*T_max时间后,学习率经过了一个周期变化后还是a。

eta_min:表示学习率可变化的最小值,默认为0

在去噪实验中,将T_max的值设定为总的训练epoch,其学习率的变化如下图所示:

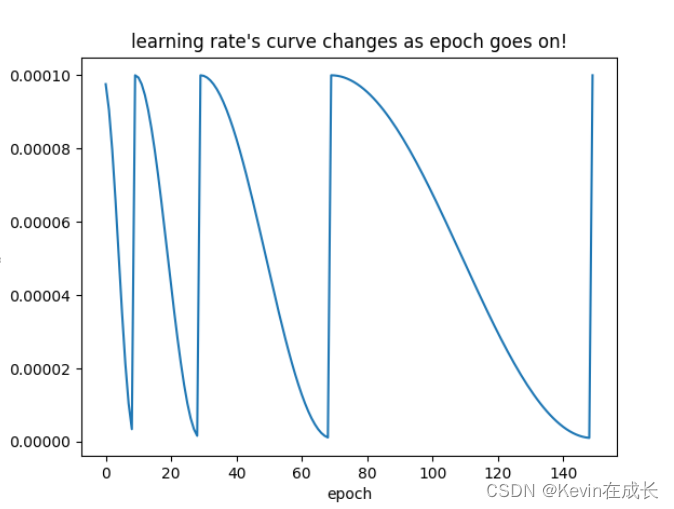

torch.optim.lr_scheduler.CosineAnnealingWarmRestarts(optimizer,T_0,T_mult,eta_min)

T_0:表示学习率第一次周期性变化的epoch数

T_mult:如果设定为1,则是均匀的周期变化;如果设定为大于1,比如2,则学习率的变化周期是:

如下图所示:T_0为10,则表示第一个周期性变化轮次为10

T_mult为2

测试代码

import torch

from torchvision.models import AlexNet

from torch.optim.lr_scheduler import CosineAnnealingLR

import matplotlib.pyplot as plt

model = AlexNet(num_classes=2)

optimizer = torch.optim.Adam(model.parameters(),lr=1e-4)

#eta_min最小的学习率

scheduler =torch.optim.lr_scheduler.CosineAnnealingLR(optimizer, T_max=150) #torch.optim.lr_scheduler.CosineAnnealingWarmRestarts(optimizer,T_0=10,T_mult=2,eta_min=1e-6)

plt.figure()

x = list(range(150))

y = []

for epoch in range(1,151):

optimizer.zero_grad()

optimizer.step()

print("第%d个epoch的学习率:%f" % (epoch,optimizer.param_groups[0]['lr']))

scheduler.step()

y.append(scheduler.get_lr()[0])

# 画出lr的变化

plt.plot(x, y)

plt.xlabel("epoch")

plt.ylabel("lr")

plt.title("learning rate's curve changes as epoch goes on!")

plt.savefig("learning_rate_150_20.png")

283

283

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?