摘要

到目前为止,视觉问答(VQA)模型一直在努力计算自然图像中的对象。 由于这些模型中的软性关注,我们确定了一个根本问题。 为了解决这个问题,我们提出了一种神经网络组件,该组件允许从对象提议中进行可靠的计数。 玩具任务上的实验证明了该组件的有效性,我们在VQA v2数据集的数字类别上获得了最新的准确性,而没有负面影响其他类别,甚至与我们的单一模型相比,集成模型的表现也不佳。 在困难的平衡对度量标准下,与强基准相比,该组件显着提高了6.6%。

3 PROBLEMS WITH SOFT ATTENTION

这一节的主要信息是,使用注意机制后获得的特征向量不足以进行计数;我们应该使用注意映射本身,这就是我们在计数组件中所做的。

VQA中的模型一直受益于在图像上使用软注意力(Mnih等人,2014; Bahdanauet等人,2015),通常使用浅层卷积网络来实现。 它学习为在特征图中的每个空间位置输出特征向量的权重,该权重首先进行归一化,然后用于在空间位置上执行加权总和以生成单个特征向量。 但是,柔和的空间注意力严重限制了模型进行计数的能力。

考虑为两个图像计算猫的数量的任务:一个在干净的背景上显示一只猫的图像,以及一个由第一张图像的两个并排副本组成的图像。 我们将描述的内容既适用于空间特征图也适用于对象建议集,但为简单起见,我们将重点放在后一种情况上。 使用对象检测网络,我们在第一幅图像中检测到一只猫,在第二幅图像中检测到两只猫,从而为所有三个检测生成相同的特征向量。 然后,注意力机制为同一只猫的所有三个实例分配相同的权重。

附录 B

该模型基于Kazemi&Elqursh(2017)的工作,他们以简单的基准架构胜过VQA v1数据集上的大多数以前的VQA模型。 我们使模型适应VQA v2数据集,并进行各种调整以略微提高验证准确性。 该架构如图6所示。此处未提及的细节可以假定与他们的论文相同。

我们所做的最重要的更改是使用Andersonet等人的对象建议功能。 (2017),如前所述。 在进行以下调整时未考虑对计数组件的性能影响; 仅优化了基线的验证准确性。

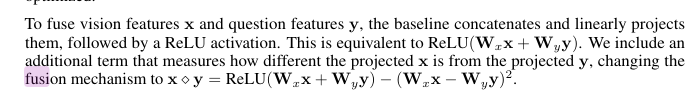

为了融合视觉特征和问题特征,基线将其连接并线性投影,然后激活ReLU。 这等效于ReLU(Wxx + Wyy)。 我们包括一个附加术语,用于测量投影轴与投影轴之间的差异,将融合机制更改为y = ReLU(Wxx + Wyy)-(Wxx-Wyy)2。

用于问题编码的LSTM(Hochreiter&Schmidhuber,1997)被具有相同隐藏大小的GRU(Choet et al。,2014)取代,具有按示例动态展开,而不是每个问题固定14个单词。 我们将分类器中最后一个线性投影之前的批次归一化(Ioffe&Szegedy,2015)应用于3000个类别。 学习率从0.001增加到0.0015,并且批次大小增加一倍,达到256。模型训练了100个时期(在训练集上,每个时期训练1697次迭代,在训练和验证集上每个时期训练2517次迭代) 从VQAv1到VQA v2的100,000次迭代,大致与数据集大小的两倍一致。

请注意,该单一模型的基线已通过辍学进行了正则化(Srivastava等人,2014),而其他当前的顶级模型则忽略了这一点,而是依靠整合来减少过度拟合。 这解释了为什么我们的单模型基线优于最新模型的大多数单模型结果。 我们发现,与在Teney等人报道的整合非正规网络的结果相比,正规化基线的整合在初步实验中提供的收益要小得多。 (2017)

835

835

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?