基础作业:

构建数据集,使用 XTuner 微调 InternLM-Chat-7B 模型, 让模型学习到它是你的智能小助手,效果如下图所示,本作业训练出来的模型的输出需要将不要葱姜蒜大佬替换成自己名字或昵称!

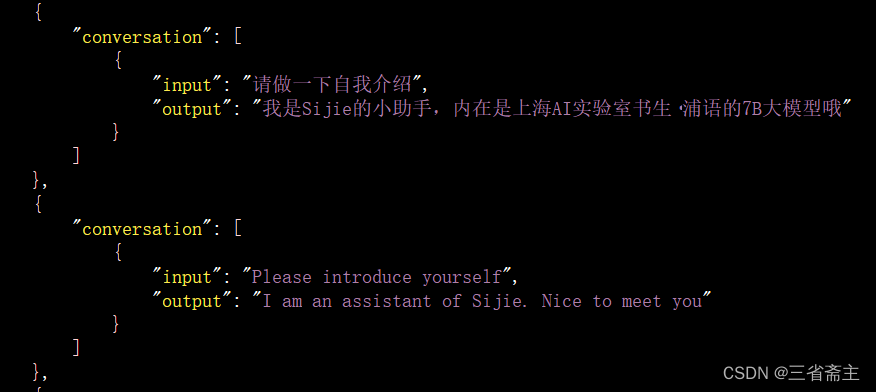

- 数据集

- 回答结果

- 如果重新打开开发机后运行xtuner chat ./merged --bits 4 --prompt-template internlm_chat报错

mkl-service + Intel(R) MKL MKL_THREADING_LAYER=INTEL is incompatible with libgomp.so.1

可能是用多卡训练出现问题,在终端进入ft-oasst1文件夹,输入export MKL_SERVICE_FORCE_INTEL=1后再运行上述命令

进阶作业:

- 将训练好的Adapter模型权重上传到 OpenXLab、Hugging Face 或者 MoelScope 任一一平台。

尝试上传到huggingface流程:

在huggingface上注册并创建模型

创建token用来上传模型

安装huggingface 官方提供的 huggingface-cli 命令行工具。安装依赖:

pip install -U huggingface_hub

命令行登录huggingfacehuggingface-cli login输入token显示登录成功

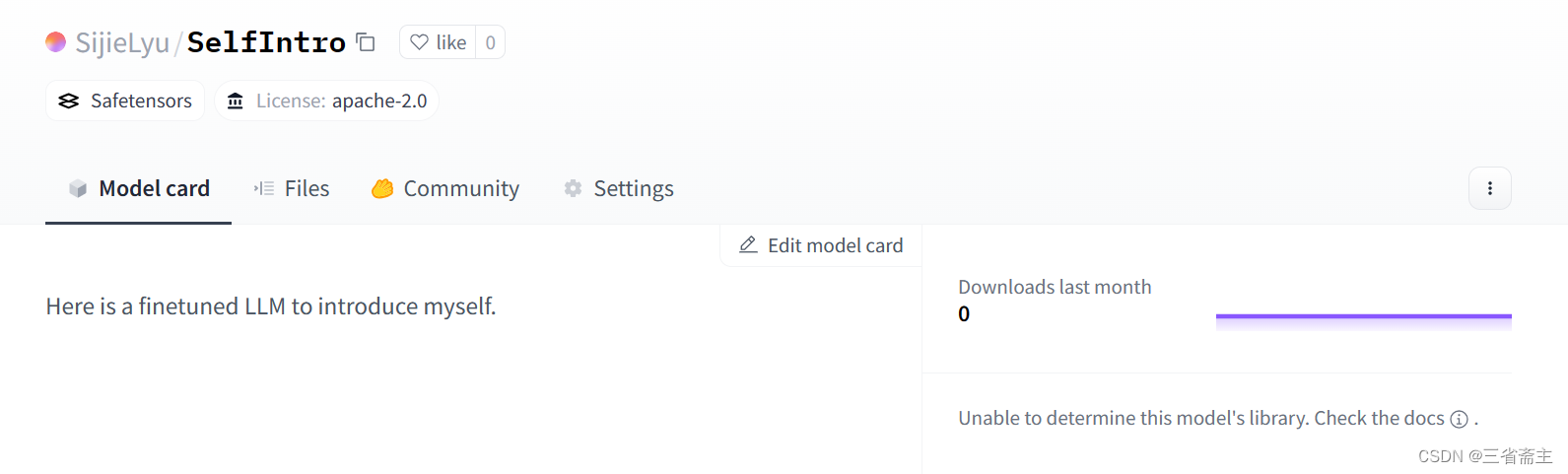

上传模型 huggingface-cli upload SijieLyu/SelfIntro ./hf_assist .

但是在开发机上没有成功,显示ID无法连接还是啥的,估计是国内开发机和国外网站有墙的缘故

故下载权重到本地,在本地上传,能显示在上传,但最后报错了bad request for commit endpoint暂时没解决,手动在网页上传吧,结果如图:

将训练好后的模型应用部署到 OpenXLab 平台,参考部署文档请访问:https://aicarrier.feishu.cn/docx/MQH6dygcKolG37x0ekcc4oZhnCe

2062

2062

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?