第五章. Training Versus Testing

上一章主要介绍机器学习的可行性。由NFL定理可知,机器学习貌似是不可行的,但是随后引入了统计学知识,如果样本数量足够大,且hypothesis数量有限,那么机器学习一般是可行的,本章将讨论机器学习的核心问题,严格证明为什么机器学习可以进行学习,从上一节最后的问题出发,即当hypothesis的数量是无限多的时候,机器学习的可行性是否依然成立?

5.1 Recap and Previe

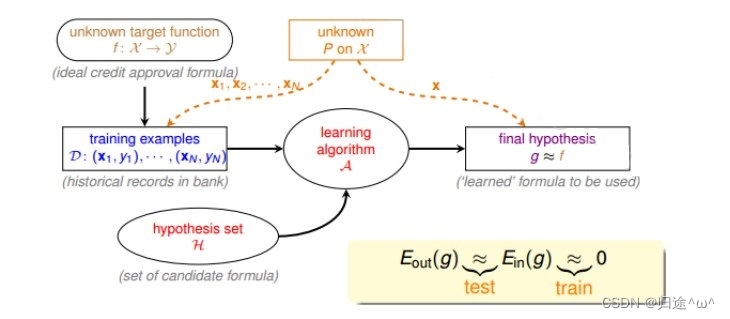

1.统计学层面机器学习流程图

1).描述:

·在训练样本D和最终测试h的样本都是来自同一个数据分布,这是机器能够学习的前提。训练样本也应该足够大,且hypothesis的数量是有限的,这样根据Hoeffding’s inequality,才不会出现Bad Data,保证了Ein≈Eout拥有很好的泛化能力,同时,通过训练,得到使Ein最小的h,作为模型最终的矩g,g接近于目标函数。

2.前四章课程总结

1).内容介绍

①.第一章介绍了机器学习的定义,目标是找到最好的矩g,使g≈f,保证Eout≈0;

②.第二章介绍了如何让Ein≈0,可以使用PLA,pocket等演算法来实现;

③.第三章介绍了机器学习的分类,我们训练的样本是批量数据(batch),处理监督式(supervised),二元分类问题(binary classification);

④.第四章介绍了机器学习的可行性,通过统计学知识把Ein(g)和Eout(g)联系起来,证明了在一定的条件假设下,Ein(g)≈Eout(g)成立。

2).总结

通过上述四节课总结,我们可以把机器学习主要目标分成两个核心问题:

·Ein(g)≈Eout(g)

·Ein(g)足够小

3.机器学习可行性与这两个核心问题之间的关联

1).情况分析

①.当hypothesis set数量M很小时,根据Hoeffding’s inequality可知,Ein(g)≈Eout(g),能保证第一个核心问题成立,但不能保证第二个核心问题成立,因为M很小时,演算法A可以选择的的hypothesis有限,不一定能找到使Ein(g)足够小的hypothesis。

②.当hypothesis set数量M很大时,根据Hoeffding’s inequality可知,Ein(g)与Eout(g)的差异也可能比较大,第一个核心问题不成立,但是第二个核心问题可能成立,因为M很大,演算法A可选择的hypothesis就很多,很有可能找到使Ein(g)足够小的hypothesis。

2).总结

①.由上面的分析可以看出,M的选择可以直接影响两个核心问题是否成立,M不可以太大,也不可以太小。

②.如果M无限大,那是否说明机器学习就不可以正常进行了呢,如果我们将无限大的M限定在一个有限的mH内,问题是否会得到解决呢?

5.2 Effective Number of Line

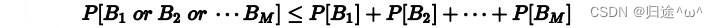

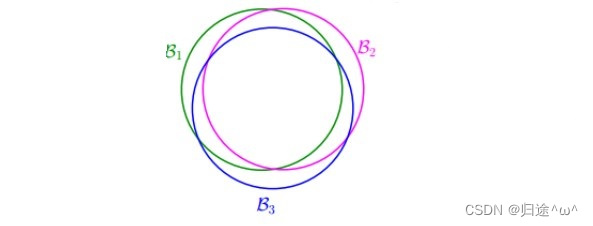

1. 多个hypothesis下Bm的级联不等式

1).Hoeffding’s inequality不等式:

参数说明:

①.M表示hypothesis的个数

2).每个hypothesis下的BAD events Bm级联的不等式:

3).扩展

·当M=∞时,右边不等式值会变得很大,似乎BAD events很大,Ein(g)与Eout(g)不接近。但是BAD events 级联的形式实际上是扩大了上界,union bound过大。最坏的情况是各个hypothesis之间没有交集,但是实际上在很多情况下,都是有交集的,就是说M实际上并没有那么大,union bound被估计过高了。我们的目的是找出不同BAD events之间的重叠部分,将无数个hypothesis分成有限个类别。

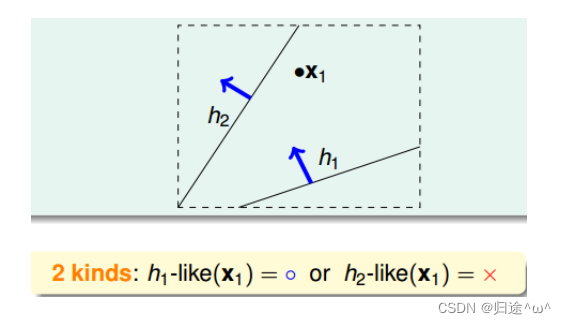

3.如何将无数个个hypothesis分成有限类

1).示例分析

假设将平面上的点用直线分成不同的类别(跟PLA类似):

①.如果平面上只有一个点x1,那么直线的种类有两种:一种将x1划为+1,一种将x1划为1:

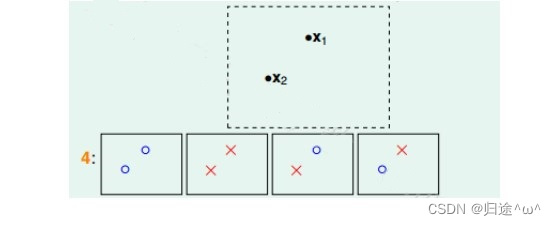

②.如果平面上有两个点x1、x2,那么直线的种类共4种:x1、x2都为+1,x1、x2都为1,x1为+1且x2为1,x1为1且x2为+1:

③.如果平面上有三个点x1、x2、x3,那么直线的种类共8种:

a).第一种情况:

b).第二种情况:

c).对于平面上三个点,不能保证所有的8个类别都能被一条直线划分.

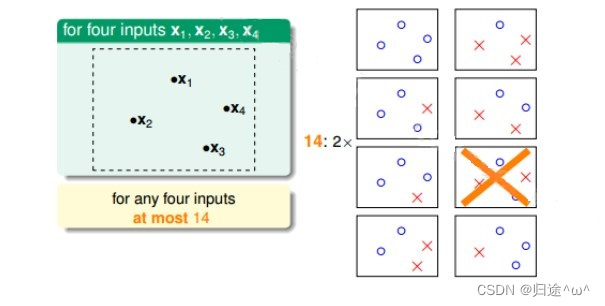

④.如果是四个点x1、x2、x3、x4,那么直线的种类共16种:

a).我们发现,平面上找不到一条直线能将四个点组成的16个类别完全分开,最多只能分开其中的14类,即直线最多只有14种.

2).结论

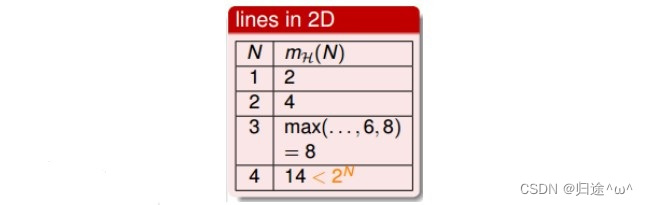

经过分析,我们得到平面上线的种类是有限的,1个点最多有2种线,2个点最多有4种线,3个点最多有8种线,4个点最多有14( <24)种线等等。我们发现,有效直线的数量总是满足 ≤ 2N(N是点的数量)。所以,如果我们可以用effective(N)代替M,Hoeffding’s inequality不等式可以写成:

已知effective(N)< 2N,如果能够保证effective(N)<< 2N,即不等式右边接近于零,那么即使M无限大,直线的种类也很有限,机器学习也是可能的。

5.3 Effective Number of Hypotheses

1. 二分类(dichotomy)

1).目的

·将空间中的点用一条直线分成两类,正类(o)和负类(x)。

2).dichotomy H与hypotheses H的关系

·hypotheses H:平面上的点用直线分开的所有hypothesis h的集合,简单来说就是平面上所有直线的集合,个数可能是无限个;

·dichotomy H:是平面上能将点完全用直线分开的直线种类,它的上界是2N。

3).我们要尝试用dichotomy来代替M,不过这里需要在引入一个新的名词:成长函数

2.成长函数(growth function)

1).定义

·对于由N个点组成的不同集合中,某个集合对应的dichotomy最大,那么这个dichotomy的值就是mH(H),它的上界就是2N。

2).在二维平面上,mH(H)随N的变化关系

·成长函数就是我们5.2中讲的的effective lines数量的最大值,在二维平面上,mH(H)随N的变化关系:

3).成长函数的计算

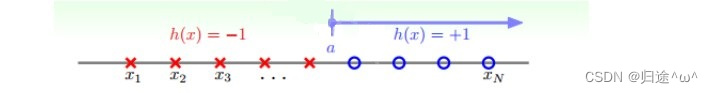

①.以一组一维数据为例来描述计算方式:

a).第一种一维情况Positive Rays:

·描述:

若有N个点,整个区域可以分成N+1段,则成长函数mH(N)=N+1,当N很大时,N+1<<2N,这是我们希望得到的。

b).第二种一维情况Positive Intervals:

·成长函数推导:

公式推导:

以4个点为例,共有11种分类方式:4+3+2+1+1;4+3+2+1的求和公式N(N+1)/2,展开后:1/2N2+1/2N,在加上全部为x/o的情况:1/2N2+1/2N+1,当N很大时,mH(N)=1/2N2+1/2N+1<<2N

②.以二维空间数据为例来描述计算方式:

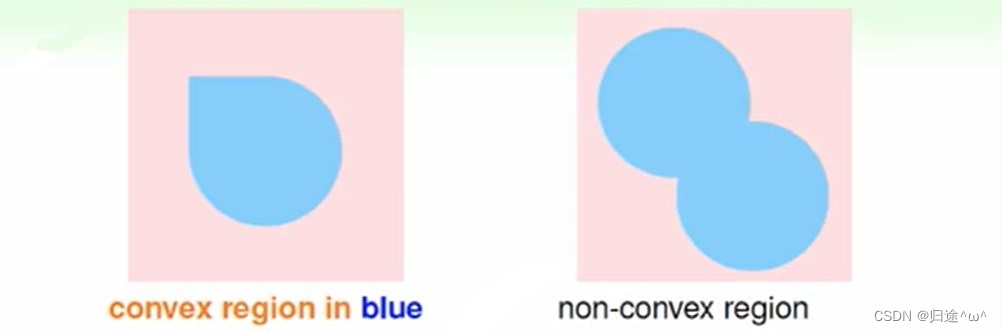

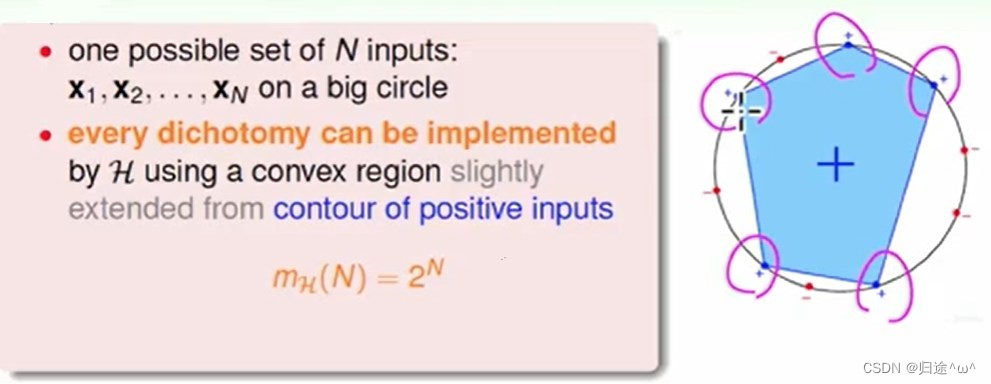

如果hypothesis是凸多边形或类圆构成的封闭,那它的成长函数如何计算呢?

·描述:

如果数据集是按照这种凸分布,我们可以把点分布在圆的边缘,然后把+的点连接成起来,形成一个区域,在向外扩大一点点,目的是为了包含所有的+点,我们也就计算得到成长函数mH = 2N。这种情况下,N个点所有可能的分类情况都能够被hypotheses set覆盖,我们把这种情形称为shattered。简单来说,如果我们能够找到一个数据集,使hypotheses set对N个输入所有分类情况都做考虑到,那么它的成长函数就是2N 。

5.4 Break Point

1.本章主要介绍的4种成长函数

1).positive rays和positive intervals的成长函数都是多项式的,若用mH 代替M,这两种情况是比较好的;

2).convex sets的成长函数是指数的,即等于M,并不能保证机器学习的可行性;

3).2D perceptrons:我们之前分析了1个点,2个点,3个点的dichotomy,分别有2N个的dichotomy,第4个点的时候,就无法做出所有16个点的dichotomy,所有,我们把4称为2D perceptrons的break point,那么4之后的点都是break point,它的成长函数一定小于2N。

4).根据break point的定义,我们知道满足k的最小值就是break point。对于我们之前介绍的四种成长函数,他们的break point分别是:

4).通过观察,我们猜测成长函数可能与break point存在某种关系:

①.对于positive rays,break point k=2,mH(N)=O(N);

②.对于positive intervals,break point k=3,mH(N)=O(N2)。

③.对于convex sets,没有break point,mH(N)=2N;

④.根据这种推论,我们猜测2D perceptrons,mH(N)=O(Nk-1)。

如果关系成立,那我们就可以用mH代替M,满足机器能够学习的条件。

5.5总结

本章我们深入探讨了机器学习的可行性。把机器学习拆分为两个核心问题:Ein(g) ≈ Eout(g) 和Ein(g) ≈ 0。对于第一个问题,我们探讨了M个hypothesis到底可以划分为多少种,也就是成长函数 。并引入了break point的概念,给出了break point的计算方法。下一章节中,我们将详细论证对于2D perceptrons,它的成长函数与break point是否存在多项式的关系,如果存在这样的关系,那么机器学习就是可行的。

文章深入分析了机器学习的核心问题,包括Ein(g)与Eout(g)的接近性以及Ein(g)的大小。讨论了Hoeffding’sinequality在有限和无限hypothesis情况下的应用,引出了成长函数和breakpoint的概念,以解决无限hypotheses集合的可行性问题。通过研究二维感知机(2Dperceptrons)的成长函数与breakpoint的关系,为机器学习的可行性提供了理论基础。

文章深入分析了机器学习的核心问题,包括Ein(g)与Eout(g)的接近性以及Ein(g)的大小。讨论了Hoeffding’sinequality在有限和无限hypothesis情况下的应用,引出了成长函数和breakpoint的概念,以解决无限hypotheses集合的可行性问题。通过研究二维感知机(2Dperceptrons)的成长函数与breakpoint的关系,为机器学习的可行性提供了理论基础。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?