文章目录

一、决策树概述

1、算法思想

决策树是从根节点开始,对实例的某一特征进行测试,根据测试结果将实例分配到其子节点;每一个子节点对应着该特征的一个取值。如此递归地对实例进行测试并分配,直至达到叶节点。最后将实例分配到叶节点的类中。

决策树学习算法包括特征选择、决策树生成和决策树剪枝三部分。本文主要概述前两部分和采用ID3算法构建树。

2、一般流程

决策树的一般流程

(1)收集数据:可以使用任何方法。

(2)准备数据:树构造算法只适用于标称型数据,因此数值型数据必须离散化。

(3)分析数据:可以使用任何方法,构造树完成之后,我们应该检查图形是否符合预期。

(4)训练算法:构造树的数据结构。

(5)测试算法:使用经验树计算错误率。

(6)使用算法:此步骤可以适用于任何监督学习算法,而使用决策树可以更好地理解数据的内在含义。

二、、决策树之判断贷款

1、准备数据

为了简单,本文章使用信息增益作为选择特征的标准。那么,什么是信息增益?在讲解信息增益之前,让我们看一组实例,贷款申请样本数据表。

2、训练算法

2.1特征选择:选择计算信息增益高的

2.11香农熵:为计算信息增益准备

划分数据集的大原则是:将无序的数据变得更加有序。组织杂乱无章数据的一种方法就是使用信息论度量信息。我们可以在划分数据之前使用信息论量化度量信息的内容。在划分数据集之前之后信息发生的变化称为信息增益,如何计算信息增益?集合信息的度量方式称为香农熵或者简称为熵,这个名字来源于信息论之父克劳德•香农。熵是表示随机变量不确定性的度量。

为了计算熵,我们需要计算所有类别所有可能值包含的信息期望值(数学期望),通过下面的公式得到:

期中n是分类的数目。熵越大,随机变量的不确定性就越大。

当熵中的概率由数据估计(特别是最大似然估计)得到时,所对应的熵称为经验熵(empirical entropy)。这经验熵公式可以写为:

根据此公式计算经验熵H(D),分析贷款申请样本数据表中的数据。最终分类结果只有两类,即放贷和不放贷。根据表中的数据统计可知,在15个数据中,9个数据的结果为放贷,6个数据的结果为不放贷。所以数据集D的经验熵H(D)为:

求解熵的代码如下:

年龄:0代表青年,1代表中年,2代表老年;

有工作:0代表否,1代表是;

有自己的房子:0代表否,1代表是;

信贷情况:0代表一般,1代表好,2代表非常好;

类别(是否给贷款):no代表否,yes代表是。

from math import log

def createDataSet():

dataSet = [[0, 0, 0, 0, 'no'], #数据集

[0, 0, 0, 1, 'no'],

[0, 1, 0, 1, 'yes'],

[0, 1, 1, 0, 'yes'],

[0, 0, 0, 0, 'no'],

[1, 0, 0, 0, 'no'],

[1, 0, 0, 1, 'no'],

[1, 1, 1, 1, 'yes'],

[1, 0, 1, 2, 'yes'],

[1, 0, 1, 2, 'yes'],

[2, 0, 1, 2, 'yes'],

[2, 0, 1, 1, 'yes'],

[2, 1, 0, 1, 'yes'],

[2, 1, 0, 2, 'yes'],

[2, 0, 0, 0, 'no']]

labels = ['年龄', '有工作', '有自己的房子', '信贷情况']

return dataSet, labels

def calcShannonEnt(dataSet):

numEntires = len(dataSet) # 计算数据样本个数

labelCounts = {

}

for featVec in dataSet:

currentLabel = featVec[-1]

if currentLabel not in labelCounts.keys():

labelCounts[currentLabel] = 0

labelCounts[currentLabel] += 1 # 计算类别个数

shannonEnt = 0.0 # 经验熵(香农熵)

for key in labelCounts: # 计算香农熵

prob = float(labelCounts[key]) / numEntires # 计算概率

shannonEnt -= prob * log(prob, 2) # 利用上述文本公式计算

return shannonEnt # 返回经验熵(香农熵)

dataSet, features = createDataSet()

print(dataSet)

print(calcShannonEnt(dataSet))

2.22信息增益:选择最优特征

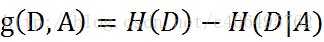

信息增益是相对于特征而言的。所以,特征A对训练数据集D的信息增益g(D,A),定义为集合D的经验熵H(D)与特征A给定条件下D的经验条件熵H(D|A)之差,即

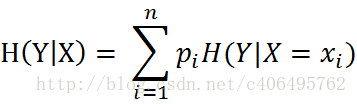

其中H(D|A)是经验条件熵(类似于概率论中得条件概率),其计算公式为:

一般地,熵H(D)与条件熵H(D|A)之差成为互信息(mutual information)。决策树学习中的信息增益等价于训练数据集中类与特征的互信息。

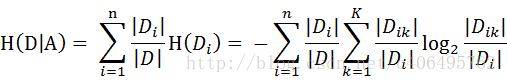

设特征A有n个不同的取值{a1,a2,···,an},根据特征A的取值将D划分为n个子集D1,D2,···,Dn,|Di|为Di的样本个数。记子集Di中属于Ck的样本的集合为Dik,即Dik = Di ∩ Ck,|Dik|为Dik的样本个数。于是经验条件熵的公式可以写为:

函数splitDataSet()按照给定特征划分数据集(返回原数据集去掉抽取的特征列);函数chooseBestFeatureToSplit()计算信息增益,选择信息增益高的(最优特征),其中会调用函数splitDataSet();

# -*- coding: UTF-8 -*-

from math import log

def createDataSet():

dataSet = [[0, 0, 0, 0, 'no'], #数据集

[0, 0, 0, 1, 'no'],

[0, 1, 0, 1, 'yes'],

[0, 1, 1, 0, 'yes'],

[0, 0, 0, 0, 'no'],

[1, 0, 0, 0, 'no'],

[1, 0, 0, 1, 'no'],

[1, 1, 1, 1, 'yes'],

[1, 0, 1, 2, 'yes'],

[1, 0, 1, 2, 'yes'],

[2, 0, 1, 2, 'yes'],

[2, 0, 1, 1, 'yes'],

[2, 1, 0, 1, 'yes'],

[2, 1, 0, 2, 'yes'],

[2, 0, 0, 0, 'no']]

labels = ['年龄',

本文详细介绍了决策树算法,包括算法思想、一般流程,并着重讲解了如何利用信息增益构建决策树来判断贷款。通过具体案例展示了特征选择、训练算法和测试过程,以及如何存储和使用决策树。此外,还展示了如何使用sklearn构建决策树预测隐形眼镜,并通过Graphviz进行可视化。

本文详细介绍了决策树算法,包括算法思想、一般流程,并着重讲解了如何利用信息增益构建决策树来判断贷款。通过具体案例展示了特征选择、训练算法和测试过程,以及如何存储和使用决策树。此外,还展示了如何使用sklearn构建决策树预测隐形眼镜,并通过Graphviz进行可视化。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?