系列文章目录

时间序列的软对比学习 ICLR2024

文章目录

摘要

对比学习已被证明是一种有效的从时间序列中学习表征的自监督方式。然而,在时间序列中比较相似的时间序列实例或相邻时间戳的值会导致忽略它们的内在相关性,从而导致学习表征的质量恶化。为了解决这个问题,我们提出了SoftCLT,一种简单而有效的时间序列软对比学习策略。这是通过引入从0到1的软分配的实例和时间对比损失来实现的。具体来说,我们定义了软分配:1)基于时间序列在数据空间上的距离的实例对比损失;2)基于时间戳差异的时间对比损失。SoftCLT是一种即插即用的时间序列对比学习方法,它可以提高学习表征的质量,而不需要额外的修饰。在实验中,我们证明了SoftCLT在分类、半监督学习、迁移学习和异常检测等下游任务中的性能持续提高,表现出了最先进的性能。代码可在此存储库中获得:https://github.com/seunghan96/softclt

提示:以下是本篇文章正文内容

一、引言

时间序列(TS)数据在许多领域无处不在,包括金融、能源、医疗保健和交通运输(Ding et al., 2020;Lago et al., 2018;Solares等,2020;Cai et al., 2020)。然而,注释TS数据可能具有挑战性,因为它通常需要大量的领域专业知识和时间。为了克服限制并利用没有注释的未标记数据,自监督学习已经成为一种有前途的表示学习方法,不仅在自然语言处理中(Devlin等人,2018;Gao et al., 2021)和计算机视觉(Chen et al., 2020;Dosovitskiy等人,2021),但也在TS分析中(Franceschi等人,2019;Yue et al., 2022)。特别是,对比学习(CL)在不同领域表现出显著的性能(Chen et al., 2020;Gao et al., 2021;Yue et al., 2022)。由于在自监督学习中确定实例的相似性具有挑战性,最近的CL工作应用数据增强来生成每个数据的两个视图,并将来自同一实例的视图作为正对,将其他视图作为负对(Chen et al., 2020)。然而,我们认为标准CL目标可能对TS表示学习有害,因为在相似的TS实例和TS内时间戳附近的值之间的内在相关性,可能是一种强的自我监督,在CL中被忽略了。例如,距离度量(如动态时间规整(DTW))已被广泛用于测量TS数据的相似性,而对比TS数据可能会丢失这些信息。此外,具有相近时间戳的值在自然TS数据中通常是相似的,因此与以前的CL方法相比,使用不同时间戳的所有值具有相同的惩罚程度(Eldele等,2021;Yue et al., 2022)可能不是最佳的。受此启发,我们探索了以下研究问题:我们如何考虑时间序列数据的相似性来更好地进行对比表征学习?

为此,我们提出了时间序列的软对比学习(SoftCLT)。具体来说,我们建议考虑InfoNCE损失(Oord等人,2018),不仅考虑正对,而且考虑所有其他对,并在实例型CL和时间型CL中计算它们的加权和,其中实例型CL对比了TS实例的表示。而时间CL则对单个TS中的时间戳表示进行对比,如图1所示。我们提出了基于实例类分类的TS之间的距离和时间类分类的时间戳差异来分配软分配。这个公式可以看作是标准对比损失的推广,因为如果我们用硬分配代替软分配,即负分配为零或正分配为一,那么所提出的损失就变成了对比损失。

表1:对比学习方法的时间序列比较表。

我们在各种任务中进行了大量的实验,包括TS分类、半监督分类、迁移学习和异常检测任务,以证明所提出方法的有效性。实验结果证实,我们的方法提高了以前的CL方法的性能,在一系列下游任务上实现了最先进的(SOTA)性能。本文的主要贡献总结如下:

•我们提出了SoftCLT,一种简单而有效的软对比学习策略。具体而言,我们分别提出了软对比损失(例如时间维度)和软对比损失(例如时间维度),以解决以前的语言学习方法在TS中的局限性。

•我们在TS的各种任务上提供了广泛的实验结果表明我们的方法在一系列下游任务上提高了SOTA的性能。例如,与SOTA无监督表示相比,SoftCLT在分类任务中分别将125个UCR数据集和29个UEA数据集的平均准确率提高了2.0%和3.9%。

•SoftCLT通过引入软赋值很容易适用于TS的其他CL框架,并且其开销可以忽略不计,使其易于使用。

二、相关工作

自我监督学习。近年来,自监督学习因其从大量未标记数据中学习强大表示的能力而受到广泛关注。自监督学习是在没有监督的情况下,训练一个模型来解决从数据的某一方面衍生出来的借口任务。作为一种自我监督的借口任务,下一个令牌预测(Brown et al., 2020)和掩码令牌预测(Devlin et al., 2018)在自然语言处理中是常用的,而在计算机视觉中则提出了解决拼图(Noroozi & Favaro, 2016)和旋转预测(Gidaris & komodakis, 2018)。特别是,对比学习(Hadsell et al., 2006)已被证明是跨领域的有效借口任务,它可以最大化正对的相似性,同时最小化负对的相似性(Gao et al., 2021;Chen et al., 2020;Yue et al., 2022)。

时间序列的对比学习。在TS分析领域,考虑到TS的不变性,已经提出了几种CL的正对和负对设计。表1比较了TS中包括我们在内的各种CL方法的几个性质。T-Loss (Franceschi等人,2019)从一个TS中随机采样一个子序列,当它们属于它的子序列时将其视为正的,如果属于其他TS的子序列则将其视为负的。Self-Time (Fan等人,2020)通过将相同TS的增广样本定义为正的,否则将其定义为负的,从而捕获TS之间的样本间关系。并通过解决分类任务来捕获TS中的时间内关系,其中类标签是使用子序列之间的时间距离定义的。TNC (Tonekaboni et al., 2021)使用正态分布定义窗口的时间邻域,并将邻域内的样本视为阳性。TS- sd (Shi et al., 2021)使用三元组相似性判别任务训练模型,其目标是识别两个TS中哪一个与给定TS更相似,使用DTW定义相似性。TS-TCC (Eldele et al., 2021)通过增强预测彼此的未来提出了一种时间对比损失,CA-TCC (Eldele et al., 2023)是TS-TCC向半监督环境的扩展,采用了同样的损失。TS2Vec (Yue et al., 2022)将TS划分为两个子序列,并在实例和时间维度上定义了分层对比损失。混合(Wickstrøm et al., 2022)通过混合两个TS来生成新的TS,其目标是预测混合权值。CoST (Woo et al., 2022)利用时域和频域对比损失来学习TS的解耦季节性趋势表示。TimeCLR (Yang et al., 2022)引入了相移和幅度变化增强,这是基于DTW的数据增强方法。TF-C (Zhang et al., 2022)学习了基于时间和频率的TS表示,并提出了一种新的时频一致性架构。在医学领域,Subject-Aware CL (Cheng et al., 2020)提出了一种基于实例的CL框架,其中时间信息被建筑设计纠缠,而CLOCS (Kiyasseh et al., 2021)建议考虑在其应用中具体可用的空间维度。以前用于TS的CL方法计算硬对比损失,其中所有负对之间的相似性同等最小化,而我们为TS引入软对比损失。

图1:SoftCLT的总体框架。与传统的硬CL(对样本对给出正赋值或负赋值)不同,SoftCLT对实例和时间关系都给出软赋值。同一样本的两个视图分别用r和

r

~

\tilde{r}

r~表示。

软对比学习。CL通常是通过批处理实例区分来完成的,其中每个实例被认为是在一个不同的类中。然而,这种方法可能会使相似的样本在嵌入空间中相距更远。为了解决这个问题,已经提出了几种方法,包括基于特征距离和几何接近度量利用图像软分配的方法(Thoma等人,2020)。NNCLR (Dwibedi等人,2021)通过在特征空间中提取top-k个邻居来为每个视图定义额外的正性。NCL (Y 'eche et al., 2021)利用医学领域知识的监督找到邻居,并通过权衡共同优化两个冲突的损失:邻居比对损失是使邻居和正对的相似性最大化,邻居判别损失是使正对的相似性最大化而使邻居的相似性最小化。SNCLR (Ge et al., 2023)通过软分配扩展了NNCLR,使用注意力模块来确定当前样本与相邻样本之间的相关性。CO2 (Wei et al., 2021)引入一致性正则化来强制不同正面视图和所有负面视图之间的相对分布一致性,从而导致样本之间的软关系。ASCL (Feng & Patras, 2022)通过将原实例识别任务转化为多实例软识别任务,引入了软样本间关系。以前的非ts域的软CL方法在嵌入空间上计算软赋值,因为数据空间上实例的相似性难以测量,特别是在计算机视觉中(Chen et al., 2020)。相反,我们建议基于TS实例在数据空间上的距离来计算软分配。

时间序列中的掩模建模。除了CL之外,掩蔽建模最近被研究作为TS中自监督学习的借口任务,通过掩盖一部分TS并预测缺失值。虽然CL在高级分类任务中表现出色,但掩模建模在低级预测任务中表现出色(Dong et al., 2023;黄等人,2022;谢等人,2022)。TST (Zerveas et al., 2021)对TS采用屏蔽建模范式,其目标是重建被屏蔽的时间戳。PatchTST (Nie et al., 2023)旨在预测掩码子序列级补丁,以捕获局部语义信息并减少内存使用。SimMTM (Dong et al., 2023)从多个被屏蔽的TS重构原始TS。

三、方法论

在本节中,我们通过引入对实例和时间对比损失的软赋值来提出SoftCLT,以分别捕获样本间和时间内的关系。例如,我们使用数据空间上TS之间的距离来捕获样本间关系,而对于时间CL,我们使用时间戳之间的差异来考虑单个TS内的时间关系。

3.1问题定义

本文研究了给定一批N个时间序列 X = { x 1 , … , x N } \mathcal{X}=\{x_{1},\ldots,x_{N}\} X={x1,…,xN}学习非线性嵌入函数 f θ : x → r , f_{\theta}:x\to r, fθ:x→r,的问题。我们的目标是学习fθ映射一个时间序列 x i ∈ R T × D x_i\in\mathbb{R}^{T\times D} xi∈RT×D到一个表示向量 r i = [ r i , 1 , … , r i , T ] ⊤ ∈ R T × M \begin{aligned}r_i=\left[r_{i,1},\dots,r_{i,T}\right]^\top\in\mathbb{R}^{T\times M}\end{aligned} ri=[ri,1,…,ri,T]⊤∈RT×M,其中T为序列长度,D为输入特征维数,M为嵌入特征维数。

3.2软实例对比学习

对比批处理中的所有实例可能对TS表示学习有害,因为相似的实例在嵌入空间上被学习得彼此相距很远。与计算机视觉等其他领域不同,在数据空间上计算的TS数据之间的距离对于测量它们的相似性是有用的。例如,通常情况下,两幅不同图像的逐像素距离与它们的相似度无关,而两幅TS数据的逐像素距离对于测量它们的相似度是有用的。使用最小-最大归一化距离度量D(·,·),我们使用sigmoid函数 σ ( a ) = 1 / ( 1 + exp ( − a ) ) \sigma(a)=1/(1+\operatorname{exp}(-a)) σ(a)=1/(1+exp(−a))为实例对比损失定义一对数据索引 ( i , i ′ ) (i,i') (i,i′)的软赋值:

其中 τ I \boldsymbol{\tau}_{I} τI是控制锐度的超参数,α是在[0,1]范围内区分相同TS对和接近的不同TS对的上界;当α = 1时,我们给距离为零的对以及相同TS的对赋值1。注意,TS之间的距离是用原始TS而不是增强视图计算的,因为成对距离矩阵可以离线预计算或缓存以提高效率。

对于距离度量D的选择,我们在表6d中进行了烧烧研究,比较了1)余弦距离,2)欧氏距离,3)动态时间翘曲(DTW)和4)时间对准测量(TAM) (Folgado et al., 2018)。其中,根据表6d的结果,我们选择DTW作为贯穿整个实验的距离度量。虽然对于长度为T的两个TS, DTW的计算复杂度为O( T 2 T^2 T2),这对于大规模数据集来说可能是昂贵的,但它可以离线预计算或缓存以促进高效计算,或者可以使用其快速版本,例如复杂度为O(T)的FastDTW (Salvador & Chan, 2007)。我们通过经验证实,DTW和FastDTW的输出几乎相同,因此CL的结果也相匹配。

为简洁起见,设 r i , t = r i + 2 N , t and r ~ i , t = r i + N , t r_{i,t}=r_{i+2N,t}\text{and}\tilde{r}_{i,t}=r_{i+N,t} ri,t=ri+2N,tandr~i,t=ri+N,t为时间戳t处 x i x_i xi的两个增广的嵌入向量。考虑到对比损失可以解释为交叉熵损失(Lee et al., 2021),我们将计算损失时考虑的所有相似度中相对相似度的softmax概率定义为:

我们使用点积作为相似度度量

o

\text{o}

o。那么,时间戳t时刻

x

i

x_i

xi的软实例对比损失定义为:

ℓ

I

(

i

,

t

)

\ell_I^{(i,t)}

ℓI(i,t)中的第一项对应于正对的损失,第二项对应于软赋值

w

I

(

i

,

i

′

)

w_I(i,i')

wI(i,i′)加权的其他对的损失。请注意,这种损失可以看作是硬实例对比损失的泛化,当

∀

w

I

(

i

,

i

′

)

=

0.

\forall w_I(i,i')=0.

∀wI(i,i′)=0.时就是这种情况。

3.3软时间对比学习

根据相邻时间戳中的值相似的直觉,我们建议基于时间戳之间的差异来计算时间对比损失的软分配。与软实例对比损失类似,当时间戳越来越近时,赋值接近于1,当它们越来越远时,赋值接近于0。我们定义一对时间戳(t, t ')的软赋值,用于时间对比损失:

其中

τ

T

\tau_{T}

τT是控制锐度的超参数。由于不同数据集的时间戳之间的接近程度不同,我们调整

τ

T

\tau_{T}

τT来控制软分配的程度。图2a给出了一个关于时间戳差异与不同

τ

T

\tau_{T}

τT的软赋值的例子。

等级损失。对于时间CL,我们考虑对网络 f θ f_{\theta} fθ中的中间表示进行分层对比,就像之前针对TS的CL方法所做的那样。具体来说,我们采用了TS2Vec中提出的分层对比损失(Yue et al., 2022)。其中损失是沿时间轴在每个最大池化层之后的中间表示上计算的,然后进行聚合。如图2b所示,池化后相邻时间步之间的相似性降低,我们通过乘以Eq. 4中的 m k m^{k} mk来调整 τ T \tau_{T} τT,即 τ T = m k ⋅ τ ~ T \tau_{T}=m^{k}\cdot\tilde{\tau}_{T} τT=mk⋅τ~T,其中m为池化层的核大小,k为深度, τ ~ T \tilde{\tau}_{T} τ~T为基本超参数。

图2 (a)显示了软时间CL的软赋值示例,其中较小的 τ T \tau_{T} τT导致更平滑的赋值。(b)是分层表示的一个例子,表明增加层深度会导致相邻时间步长之间的语义差异更大,因此应该增加 τ T \tau_{T} τT来补偿它。

现在,为了简洁起见,设

r

i

,

t

=

r

i

,

t

+

2

T

r_{i,t}=r_{i,t+2T}

ri,t=ri,t+2T和

r

~

i

,

t

=

r

i

,

t

+

T

\tilde{r}_{i,t}=r_{i,t+T}

r~i,t=ri,t+T作为时间戳t处

x

i

x_i

xi的两个增广的嵌入向量。与Eq. 2类似,我们将计算损失时考虑的所有相似度中相对相似度的softmax概率定义为:

则定义时间戳t时刻

x

i

x_i

xi的软时间对比损失为:

与软实例对比损失类似,这种损失可以看作是硬时间对比损失的概括,当

∀

w

T

(

t

,

t

′

)

=

0

\forall w_T(t,t')=0

∀wT(t,t′)=0时就是这种情况。

SoftCLT的最终损失是软实例和时间对比损失的结合:

其中λ是控制每个损耗贡献的超参数,除非指定,否则设置为0.5。提出的损失有一个有趣的数学解释,它可以被看作是标准化软分配的softmax概率的缩放KL散度,其中尺度是软分配的总和。我们在附录D中提供了更多细节。

四、实验

我们进行了大量的实验来验证所提出的方法,并评估其在不同任务中的性能:(1)采用单变量和多变量TS进行分类;(2)采用(i)自监督学习后进行微调和(ii)半监督学习进行半监督分类;(3)域内和跨域迁移学习;(4)在正常和冷启动设置下进行异常检测。我们还进行消融研究,以验证SoftCLT的有效性及其设计选择。最后,我们将时间表征的成对距离矩阵和t-SNE (Van der Maaten & Hinton, 2008)可视化,以显示SoftCLT相对于以前方法的效果。我们使用了我们应用SoftCLT的方法的数据增强策略:TS2Vec生成两个视图作为重叠的TS段,TS- tcc /CA-TCC分别使用抖动-缩放和排列-抖动策略生成弱和强增强的两个视图。

4.1分类

我们分别使用1251个UCR存档数据集(Dau等人,2019)和292个UEA存档数据集(Bagnall等人,2018)对单变量TS进行了TS分类任务实验。具体来说,我们将SoftCLT应用于TS2Vec (Yue et al., 2022),它已经证明了SOTA在上述数据集上的性能。作为基线方法,我们考虑DTW-D (Chen等人,2013)、TNC (Tonekaboni等人,2021)、TST (Zerveas等人,2021)、TS-TCC (Eldele等人,2021)、T-Loss (Franceschi等人,2019)和TS2Vec (Yue等人,2022)。实验协议遵循T-Loss和TS2Vec,其中具有RBF内核的SVM分类器在所有时间戳的最大池表示获得的实例级表示之上进行训练。图3所示的表2和基于Wilcoxon-Holm方法(Ismail Fawaz et al., 2019)的临界差(CD)图表明,所提出的方法在准确性和排名方面都显著提高了两个数据集的SOTA性能。在图3中,每个数据集的最佳和次优结果分别用红色和蓝色表示。如果这些方法在平均排名方面的差异在统计上不显著,我们也用一条粗线将它们连接起来,置信水平为95%,这表明所提出的方法的性能增益是显著的。

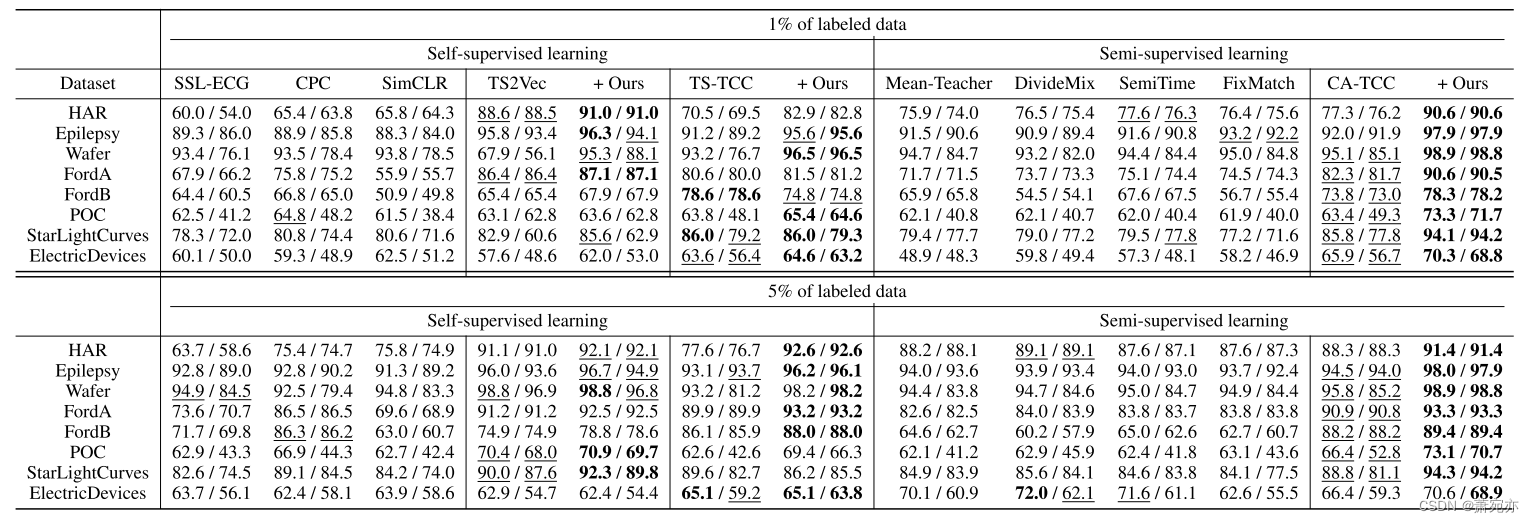

表3:半监督分类结果。该表显示了1%和5%的标签对自监督和半监督模型进行微调的结果。每个数据集的最佳结果用粗体表示,次优结果用下划线表示。准确性和MF1评分按顺序报道。

4.2半监督分类

我们将SoftCLT应用于TS-TCC (Eldele et al., 2021)及其扩展CA-TCC (Eldele et al., 2023)进行半监督分类任务的实验,这两种方法分别将CL纳入自监督学习和半监督学习。作为基线方法,我们考虑SSL-ECG (Sarkar等人,2020)、CPC (Oord等人,2018)、SimCLR (Chen等人,2020)和TS-TCC (Eldele等人,2021)用于自我监督学习,以及Mean-Teacher (Tarvainen和Valpola, 2017)、DivideMix (Li等人,2020)、SemiTime (Fan等人,2021)、FixMatch (Sohn等人,2020)和CA-TCC (Eldele等人,2021)。2023)用于半监督学习。注意,TS-TCC和CA-TCC都执行实例对比和时间对比,然而,它们的时间对比是通过预测一个视图与另一个视图的未来来实现的,这与传统的正负对对比损失不同。因此,我们采用软时间对比损失作为两种方法的额外损失。为了进行评估,我们使用了CA-TCC相同的实验设置和数据集,其中包括八个数据集(Anguita et al., 2013;Andrzejak et al., 2001;Dau等人,2019),其中6个来自UCR档案。我们考虑了两种半监督学习场景,(1)使用未标记数据进行自监督学习,然后使用标记数据进行监督微调;(2)使用标记和未标记数据进行半监督学习,遵循CA-TCC (Eldele et al., 2023)。表3给出了两种方法在1%和5%标记数据集情况下的实验结果,表明在两种情况下,应用SoftCLT在大多数数据集上都获得了最佳的整体性能。

(b)在FD数据集上的自监督和半监督设置下的无适应迁移学习。TSTCC和CA-TCC分别作为自监督学习和半监督学习的基线。

表4:域间和跨域设置下迁移学习任务的结果。

4.3迁移学习

我们对以前工作中使用的域内和跨域设置的分类迁移学习进行了实验(Zhang et al., 2022;Eldele et al., 2021;2023;Dong et al., 2023),通过将我们的SoftCLT应用于TS-TCC和CA-TCC。作为基线方法,我们考虑了TS-SD (Shi等人,2021)、TS2Vec (Yue等人,2022)、mixup (wickstr约m等人,2022)、CLOCS (Kiyasseh等人,2021)、CoST (Woo等人,2022)、LaST (Wang等人,2022)、TF-C (Zhang等人,2022)、TS-TCC (Eldele等人,2021)、TST (Zerveas等人,2021)和SimMTM (Dong等人,2023)。在领域内迁移学习中,模型在sleeppeeg (Kemp et al., 2000)上进行预训练,并在Epilepsy (Andrzejak et al., 2001)上进行微调,两者都是EEG数据集,因此被认为处于相似的领域。跨领域迁移学习涉及在一个数据集上进行预训练和在不同数据集上进行微调,在sleeppeeg上对模型进行预训练,并在FD-B (Lessmeier等人,2016)、Gesture (Liu等人,2009)和EMG (Goldberger等人,2000)三个不同领域的数据集上进行微调。此外,我们在自监督和半监督设置下执行迁移学习而不进行自适应,其中源数据集和目标数据集共享相同的类集,但源数据集只有1%的标签可用,并且不允许在目标数据集上进行进一步的训练。具体来说,模型在故障诊断(FD)数据集中的四种条件(A、B、C、D)之一上进行训练(Lessmeier等人,2016),并在另一种条件下进行测试。表4a显示了域内和跨域迁移学习的结果,表4b显示了FD数据集的自监督和半监督设置的结果。值得注意的是,SoftCLT应用于CA-TCC,将FD数据集的12个迁移学习场景的平均准确率提高了10.68%。

4.4异常检测

我们在两种不同的设置下,采用SoftCLT对TS2Vec (Yue et al., 2022)进行单变量TS异常检测(AD)任务的实验:正常设置将每个数据集按照时间顺序分成两半,分别用于训练和评估,冷启动设置在UCR存档的FordA数据集上预训练模型,并在每个数据集上进行评估。作为基线方法,我们考虑SPOT (Siffer等人,2017)、DSPOT (Siffer等人,2017)、DONUT (Xu等人,2018)、SR (Ren等人,2019)作为正常设置,FFT (Rasheed等人,2009)、Twitter-AD (Vallis等人,2014)、Luminol (LinkedIn, 2018)作为冷启动设置,TS2Vec (Yue等人,2022)用于两者。异常分数是由TS2Vec之后由被屏蔽和未被屏蔽输入编码的两个表示的L1距离计算的。我们在Yahoo (Laptev et al., 2015)和KPI (Ren et al., 2019)数据集上评估了比较方法。我们发现,抑制实例级CL平均会导致更好的AD性能,因此我们报告了没有实例级CL的TS2Vec和SoftCLT性能;如表5所示,SoftCLT在F1得分、准确率和召回率方面都优于两种设置下的基线。具体来说,SoftCLT应用于TS2Vec在正常启动和冷启动设置下的两个数据集中的F1得分都提高了约2%。

表5异常检测结果。

4.5消融研究

SoftCLT的有效性。表6a显示了来自标准硬CL的软赋值的效果。将软赋值应用于实例化或时间化CL可以提高性能,并且将它们应用于两个维度都可以获得最佳性能,分别将UCR和UEA数据集的准确性提高2.7%和3.7%。

软时间CL的设计选择。表6b比较了软赋值wT的不同选择。Neighbor将参考点周围一个窗口内的邻域取正值,其他邻域取负值。线性给出与参考点的时间差成线性比例的软赋值,其中距离最远的值为零。高斯函数根据参考点的均值和标准差作为超参数的高斯分布给出软赋值。其中,Eq. 4中的Sigmoid表现最好,如表6b所示。

软实例CL的上界。在软实例对比损失中,引入α来避免相同TS对和不同TS对在距离为0的情况下的相同分配,其中α = 1使两者具有相同的分配。表6c研究了调优α的影响。从结果来看,α = 0.5是最好的,即相同TS对的相似度应该严格大于其他对,但相差不大。

软实例CL的距离度量。表6d比较了Eq. 1中距离度量D的不同选择:余弦距离(COS)、欧氏距离(EUC)、动态时间翘曲(DTW)和时间对齐测量(TAM) (Folgado等人,2018)在128个UCR数据集上,其中基线为TS2Vec,同时应用硬或最佳软时间CL。结果表明,基于实例的软CL改进对距离度量的选择具有鲁棒性。我们在所有其他实验中都使用DTW,因为DTW得到了很好的研究,在文献中常用,并且可以使用快速算法(如FastDTW)。

4.6分析

与软CL方法在计算机视觉中的比较。虽然在其他领域已经提出了软CL方法,但由于难以测量数据空间上的相似性,特别是在计算机视觉中,它们在嵌入空间上计算软赋值。然而,我们认为数据空间上的相似性确实是一个强大的自我监督,导致更好的表示学习。为了证实这一点,我们将SoftCLT与在嵌入空间工作的其他领域提出的软CL方法进行了比较:在UCR数据集上的NNCLR (Dwibedi等人,2021)和ASCL (Feng & Patras, 2022)。为了公平的比较,我们在相同的设置下,将所有的比较方法应用于TS2Vec。如表7所示,与提出的方法不同,NNCLR和ASCL使TS2Vec的性能变差,这意味着在数据空间上测量的相似度是强自监督的,而在可学习嵌入空间上测量的相似度在某些领域可能没有作用。为了进一步研究以往方法的失效模式,我们按照表7中200的TS平均长度对数据集进行分类,并观察到以往的方法未能捕捉到长TS数据的相似性。

对季节性的稳健性。所提出的软时间间隔CL背后的一个假设是,相邻时间戳中的值是相似的,这可能会引起人们对TS中的季节性可能无法捕获的担忧。为了解决这个问题,我们通过ADF检验(Sims et al., 1990)在p = 0.05的显著性水平上根据季节性对UCR数据集进行分类。如表8所示,无论季节性如何,SoftCLT的性能增益是一致的。我们的猜想是,现实世界中的TS通常不表现出完美的季节性,正如ADF测试结果所表明的那样,因此SoftCLT利用了非季节性部分。与此同时,之前的研究试图在TS中分解趋势和季节性来进行表征学习(Wang et al., 2022;Woo et al., 2022)。然而,对于既不是同时自回归也不是平稳的TS来说,这可能不现实(Shen et al., 2022)。综上所述,我们在TS中没有直接考虑季节性,因为不仅提取具有挑战性,而且在实践中不考虑季节性,我们仍然可以获得良好的性能。

对季节性的稳健性。所提出的软时间间隔CL背后的一个假设是,相邻时间戳中的值是相似的,这可能会引起人们对TS中的季节性可能无法捕获的担忧。为了解决这个问题,我们通过ADF检验(Sims et al., 1990)在p = 0.05的显著性水平上根据季节性对UCR数据集进行分类。如表8所示,无论季节性如何,SoftCLT的性能增益是一致的。我们的猜想是,现实世界中的TS通常不表现出完美的季节性,正如ADF测试结果所表明的那样,因此SoftCLT利用了非季节性部分。与此同时,之前的研究试图在TS中分解趋势和季节性来进行表征学习(Wang et al., 2022;Woo et al., 2022)。然而,对于既不是同时自回归也不是平稳的TS来说,这可能不现实(Shen et al., 2022)。综上所述,我们在TS中没有直接考虑季节性,因为不仅提取具有挑战性,而且在实践中不考虑季节性,我们仍然可以获得良好的性能。

实例关系。为了查看编码器中是否保留了实例关系,我们可视化了从每层提取的UCR存档(Dau等人,2019)的昆虫pgregulartrain数据集上表示的成对实例距离矩阵,其中较亮的颜色表示实例之间的距离较低。图4的上、下两个面板分别显示了采用硬CL和软CL时,表示的两两距离矩阵随深度的变化情况。结果表明,SoftCLT在编码过程中保留了TS实例之间的关系,而标准的硬CL不能保留它们。

时间关系。为了评估SoftCLT捕获的时间关系的质量,我们应用t-SNE (Van der Maaten & Hinton, 2008)来可视化时间表征,这些表征是单个TS中每个时间戳的表征。图5比较了在不同训练时期使用硬CL和软CL学习的表征的t-SNE。随着时间的推移,这些点变得越来越暗。硬CL发现粗粒度的邻域关系,因此它无法区分深红色的延迟时间戳,而软CL发现更细粒度的关系。

五、结论

在本文中,我们提出了一个时间序列的软对比学习框架。与之前对样本对进行硬分配的方法不同,我们的方法基于数据空间上的实例和时间关系进行软分配。我们在一系列任务中证明了我们的方法的有效性,从而显著提高了性能。我们希望我们的工作能够从数据空间启发自我监督的有效性,并激励未来在各个领域的对比表征学习工作中考虑到这一点。

道德声明

本文提出的时间序列软对比学习算法在时间序列数据表示学习领域具有重要的应用前景。将该算法应用于各种任务和解决时间序列表示学习的一般问题的能力是有希望的。特别是,该算法可以应用于迁移学习,这在下游任务的小数据集场景中可能很有用。此外,我们期望利用来自数据空间的自我监督进行对比表征学习的想法激励未来在各个领域的工作。然而,与任何算法一样,需要考虑伦理问题。一个潜在的伦理问题是,该算法可能会使用于预训练的数据集中可能存在的偏见永久化。例如,如果预训练数据集在某些人口统计属性方面是不平衡的,那么这种偏差可能会转移到微调中,从而可能导致有偏差的预测。在实际场景中使用该算法之前,评估和解决预训练数据集中潜在的偏差是至关重要的。为了确保负责任地使用算法,我们将公开数据集和代码。数据集和代码的公开可用性允许透明度和可重复性,允许其他研究人员评估和解决潜在的偏见和滥用。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?