系列文章目录

MODERNTCN:用于一般时间序列分析的现代纯卷积结构 ICLR2024

摘要

近年来,基于 Transformer 和 MLP 的模型迅速崛起,并在时间序列分析中占据主导地位。 相比之下,卷积现在由于性能较差而在时间序列任务中失去动力。 本文研究了如何在时间序列分析中更好地使用卷积这一悬而未决的问题,并努力将卷积带回时间序列分析的舞台。 为此,我们对传统的TCN进行现代化改造,并进行时间序列相关的修改,使其更适合时间序列任务。 作为结果,我们提出了 ModernTCN,并通过时间序列社区中很少探索的方式成功解决了这个悬而未决的问题。 作为纯卷积结构,ModernTCN 在五个主流时间序列分析任务上仍然实现了一致的 state-of-the-art 性能,同时保持了基于卷积的模型的效率优势,因此提供了比 state-of 更好的效率和性能平衡 -最先进的基于 Transformer 和 MLP 的模型。 我们的研究进一步表明,与之前基于卷积的模型相比,我们的 ModernTCN 具有更大的有效感受野(ERF),因此可以更好地释放卷积在时间序列分析中的潜力。 代码可在此存储库中找到:https://github.com/luodhhh/ModernTCN。

提示:以下是本篇文章正文内容

一、引言

时间序列分析广泛应用于工业预测(Zhou et al., 2021)、缺失值插补(Friedman, 1962)、动作识别(Ye & Keogh, 2009)和异常检测(Xu et al., 2021)等领域。 ,2021)。 由于巨大的实用价值,时间序列分析在过去几年中得到了快速发展(Wen et al., 2022; Lim & Zohren, 2021)。 其中,基于 Transformer 的方法和基于 MLP 的模型的兴起尤其引人注目(Nie 等,2023;Zhang & Yan,2023;Zhou 等,2022;Cirstea 等,2022;Wu 等,2022)。 ,2021;Li 等人,2019b;Vaswani 等人,2017)(Li 等人,2023b;Zeng 等人,2022) ,2022)。 但大约在同一时间,基于卷积的模型长期以来受到的关注较少。

在时间序列分析中使用卷积并不简单,因为它提供了效率和性能的更好平衡。 早在 2010 年代,TCN 及其变体(Bai et al., 2018; Sen et al., 2019)就被广泛应用于许多时间序列任务中。 但到了 2020 年代,情况发生了变化。 近年来,基于 Transformer 的模型和基于 MLP 的模型迅速兴起并取得了令人印象深刻的性能。 由于其全局有效感受野(ERF),它们可以更好地捕获长期时间(跨时间)依赖性,从而显着优于传统 TCN。 结果,基于卷积的模型由于其有限的 ERF 而正在失去动力。

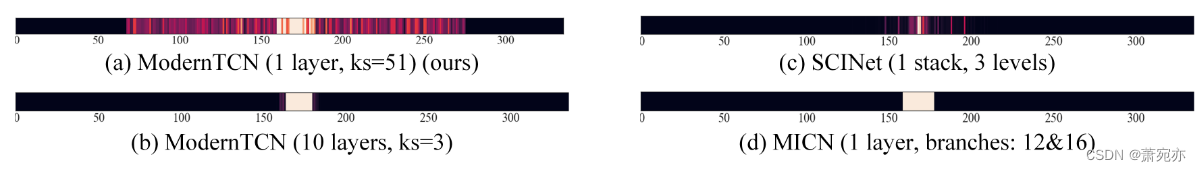

之前的一些基于卷积的模型(Wang et al., 2023; Liu et al., 2022a)试图将卷积带回时间序列分析的领域。 但他们主要关注于设计额外复杂的结构来与传统卷积一起工作,而忽略了更新卷积本身的重要性。 而且它们仍然无法达到与最先进的基于 Transformer 和基于 MLP 的模型相当的性能。 其背后的原因可以通过图 1 来解释。增加 ERF 是将卷积带回时间序列分析的关键。 但之前基于卷积的模型仍然具有有限的 ERF,这阻碍了其进一步的性能改进。 如何在时间序列分析中更好地使用卷积仍然是一个不平凡且悬而未决的问题。

图 1:ModernTCN 和之前基于卷积的方法的有效感受野 (ERF)。 光区分布越广,ERF 越大。 我们的 ModernTCN 可以获得比以前基于卷积的方法大得多的 ERF。 同时,增大内核尺寸是比堆叠更多小内核更有效的获得大ERF的方法。

作为卷积广泛应用的另一个领域,计算机视觉(CV)采取了截然不同的路径来探索卷积。 与时间序列领域的最新研究不同,CV 领域的最新研究侧重于优化卷积本身并提出现代卷积(Liu et al., 2022d; Ding et al., 2022; Liu et al., 2022b)。 现代卷积是受 Transformer 启发的一种新的卷积范式。 具体来说,现代卷积块结合了 Transformer 中的一些架构设计,因此具有与 Transformer 块类似的结构(图 2(a)和(b))。 同时,为了赶上 Transformer 中的全局 ERF,现代卷积通常采用大内核,因为它可以有效提高 ERF(图 1)。 尽管现代卷积的有效性已经在 CV 中得到了证明,但它仍然很少受到时间序列社区的关注。 基于以上发现,我们打算首先对时间序列分析中的卷积进行现代化改造,看看它是否可以增加ERF并带来性能提升。

此外,卷积也是捕获跨变量依赖性的潜在有效方法。 跨变量依赖性是时间序列中除跨时间依赖性之外的另一种关键依赖性。 它是指多元时间序列中变量之间的依赖关系。 早期的研究(Lai et al., 2018b)已经尝试使用可变维度的卷积来捕获跨变量依赖性。 尽管它的性能现在没有那么有竞争力,但它仍然证明了卷积在捕获交叉变量依赖性方面的可行性。 因此,有理由相信,经过适当的修改和优化,卷积可以成为一种高效且有效的捕获跨变量依赖关系的方法。

基于上述动机,我们采取了时间序列界很少探索的方法,成功地将基于卷积的模型带回到时间序列分析中。 具体来说,我们对传统的TCN进行现代化改造,并进行一些时间序列相关的修改,使其更适合时间序列任务。 作为结果,我们提出了一种现代纯卷积结构,即 ModernTCN,以有效利用跨时间和跨变量依赖性进行一般时间序列分析。 我们在五个主流分析任务上评估 ModernTCN,包括长期和短期预测、插补、分类和异常检测。 令人惊讶的是,作为一个纯粹的基于卷积的模型,ModernTCN 在这些任务上仍然实现了一致的最先进的性能。 同时,ModernTCN还保持了基于卷积的模型的效率优势,从而提供了效率和性能的更好平衡。 我们的贡献如下:

• 我们深入研究了如何在时间序列中更好地使用卷积的问题,并提出了一种新颖的解决方案。 实验结果表明,与其他现有的基于卷积的模型相比,我们的方法可以更好地释放卷积在时间序列分析中的潜力。

• ModernTCN 在多个主流时间序列分析任务上实现了一致的state-of-the-art 性能,展示了出色的任务泛化能力。

• ModernTCN 提供了效率和性能的更好平衡。 它保持了基于卷积的模型的效率优势,同时在性能方面与最先进的基于 Transformer 的模型竞争甚至更好。

二、 相关工作

2.1 CONVOLUTION IN TIME SERIES ANALYSIS

卷积在 2010 年代的时间序列分析中曾很流行。 例如,TCN 及其变体(Bai et al., 2018; Sen et al., 2019; Franceschi et al., 2019)采用因果卷积来建模时间因果关系。 但他们受到有限的 ERF 的困扰。 随着基于 Transformer 和基于 MLP 的模型的快速发展,近年来卷积受到的关注较少。 一些研究试图将卷积带回时间序列社区。 MICN(Wang et al., 2023)超越了因果卷积,提出了一种多尺度卷积结构,以结合时间序列中的局部特征和全局相关性。 SCINet(Liu et al., 2022a)消除了因果卷积的概念,并引入了递归下采样-卷积-交互架构来对具有复杂时间动态的时间序列进行建模。 但由于 ERF 有限,他们仍然难以对长期依赖性进行建模。 TimesNet(Wu et al., 2023)在基于卷积的模型家族中很特殊。 与其他主要使用 1D 卷积的模型不同,它将 1D 时间序列转换为 2D 变化,并在 CV 中使用 2D 卷积主干来获得信息表示。

图 2:ModernTCN 模块设计。 M、N、D 是可变维度、时间维度和特征维度的大小。 DWConv 和 PWConv 是深度卷积和逐点卷积的缩写(2017)。 Groups 是组卷积中的组号(2018)。 我们的设计中采用了BN和GeLU(2015;2016)。

2.2 MODERN CONVOLUTION IN COMPUTER VISION

卷积神经网络(ConvNets)(Krizhevsky et al., 2017; Simonyan & Zisserman, 2014; He et al., 2015; Xie et al., 2017; Huang et al., 2017)曾经是 CV 中的主要骨干架构 。 但在 2020 年代,视觉变换器(ViTs)(Dosovitskiy 等人,2020;Liu 等人,2021b)被提出,并且优于之前的标准 ConvNet。 为了赶上 ViT 的性能,引入了 2020 年代的现代卷积。 受到 Transformer 中架构设计的启发,ConvNeXt(Liu et al., 2022d) 重新设计了卷积块,使其与 Transformer 块更加相似。 为了进一步赶上 Transformers 的全局 ERF,RepLKNet (Ding et al., 2022) 借助结构重参数技术将内核大小缩放到 31×31。 此外,SLaK(Liu et al., 2022b)通过将大内核分解为两个矩形平行内核并使用动态稀疏性,将内核大小扩大到 51×51。 受上述研究的启发,我们对时间序列社区中的一维卷积进行了现代化和修改,使其更适合时间序列分析任务。

三、 MODERNTCN

在本节中,我们首先提供 ModernTCN 模块的设计路线图,以介绍我们如何对时间序列社区中的传统一维卷积模块进行现代化和优化。 然后我们介绍了ModernTCN的整体结构。 更多相关细节参见附录 G。

3.1 MODERNIZE THE 1D CONVOLUTION BLOCK

遵循(Liu et al., 2022d)的想法,我们首先重新设计一维卷积块,如图 2 (b) 所示。 DWConv 负责基于每个特征学习 token 之间的时间信息,其作用与 Transformer 中的自注意力模块相同。 ConvFFN类似于Transformer中的FFN模块。 它由两个 PWConv 组成,采用倒置瓶颈结构,其中 ConvFFN 块的隐藏通道比输入通道宽 r 倍。 该模块是独立学习每个token的新特征表示。

上述设计导致时间信息和特征信息混合的分离。 DWConv 和 ConvFFN 均仅混合时间或特征维度之一的信息,这与联合混合两个维度上的信息的传统卷积不同。 这种解耦设计可以使对象任务更容易学习并降低计算复杂度。

基于以上设计,我们借鉴CV的成功,对一维卷积进行现代化改造。 但我们发现,简单地以与 CV 相同的方式对卷积进行现代化改造,在时间序列任务中几乎没有带来任何性能提升。 事实上,上述设计并没有考虑到时间序列的特点。 时间序列除了特征维度和时间维度外,还有可变维度。 但是图 2 (b) 中设计的由卷积块堆叠的主干网无法正确处理可变维度。 由于跨变量信息在多元时间序列中也至关重要(Zhang & Yan, 2023; Li et al., 2023b),因此仍需要更多与时间序列相关的修改,以使现代一维卷积更适合时间序列分析。

3.2 TIME SERIES RELATED MODIFICATIONS

Maintaining the Variable Dimension在 CV 中,在主干之前,我们将每个像素的 3 通道 RGB 特征嵌入到 D 维向量中,以通过嵌入层混合来自 RGB 通道的信息。 但类似的变量混合嵌入(例如,每个时间步简单地将 M 个变量嵌入到 D 维向量中)并不适合时间序列。 首先,时间序列中变量之间的差异远大于图片中 RGB 通道之间的差异(Cirstea et al., 2022)。 仅嵌入层无法学习变量之间复杂的依赖关系,甚至由于没有考虑变量的不同行为而失去变量的独立特征。 其次,这种嵌入设计导致变量维度的丢弃,使得无法进一步研究跨变量的依赖关系。 针对这个问题,我们提出 patchify 变量无关嵌入。

我们将 X i n ∈ R M × L \mathbf{X}_{in}\in\mathbb{R}^{M\times L} Xin∈RM×L 表示为长度为 L 的 M 个变量输入时间序列,并在适当填充后将其进一步划分为块大小为 P 的 N 个块(填充详细信息参见附录 B)。 修补过程中的步长为S,它也用作两个连续修补程序之间的非重叠区域的长度。 然后这些补丁将被嵌入到 D 维嵌入向量中:

X

e

m

b

∈

R

M

×

D

×

N

\mathbf{X}_{emb}\in\mathbb{R}^{M\times D\times N}

Xemb∈RM×D×N 是输入嵌入。 与之前的研究不同(Nie et al., 2023;Zhang & Yan, 2023),我们以等效的全卷积方式进行这种补丁嵌入,以实现更简单的实现。 将形状解压缩为

X

i

n

∈

R

M

×

1

×

L

\mathbf{X}_{in}\in\mathbb{R}^{M\times1\times L}

Xin∈RM×1×L 后,我们将填充的

X

i

n

X_{in}

Xin 输入到内核大小为 P 、步幅为 S 的一维卷积干层。该干层将 1 个输入通道映射到 D 个输出通道。 在上述过程中,M个单变量时间序列中的每一个都是独立嵌入的。 因此,我们可以保持变量维度。 以下是使我们的结构能够从附加变量维度捕获信息的修改。

DWConv DWConv 最初是为学习时间信息而设计的。 由于仅通过 DWConv 联合学习跨时间和跨变量的依赖关系更加困难,因此让 DWConv 也负责跨变量维度的信息混合是不合适的。 因此,我们将原始的DWConv从仅特征独立修改为特征和变量独立,使其独立学习每个单变量时间序列的时间依赖性。 我们在DWConv中采用大内核来增加ERF并提高时间建模能力。

ConvFFN 由于 DWConv 与特征和变量无关,因此 ConvFFN 应混合特征和变量维度的信息作为补充。 一种简单的方法是通过单个 ConvFFN 共同学习特征和变量之间的依赖关系。 但这种方法导致计算复杂度较高,性能较差。 因此,我们通过用分组的PWConv替换PWConv并设置不同的组编号,将单个ConvFFN进一步解耦为ConvFFN1和ConvFFN2。 ConvFFN1 负责学习每个变量的新特征表示,ConvFFN2 负责捕获每个特征的跨变量依赖性。

经过上述修改后,我们得到了最终的 ModernTCN 块,如图 2(d)所示。 并且DWConv、ConvFFN1和ConvFFN2中的每一个都只混合时间、特征或变量维度之一的信息,这保持了现代卷积中解耦设计的思想。

3.3 总体结构

嵌入后, X e m b \mathrm{X}_{emb} Xemb被输入主干网络以捕获跨时间和跨变量的依赖性,并学习信息表示 Z ∈ R M × D × N \mathbf{Z}\in\mathbb{R}^{M\times D\times N} Z∈RM×D×N :

Backbone(·) 是堆叠的 ModernTCN 块。 每个 ModernTCN 块都以残差方式组织(He et al., 2015)。 第 i 个 ModernTCN 块中的前向过程为:

其中

Z

i

∈

R

M

×

D

×

N

,

i

∈

{

1

,

.

.

.

,

K

}

\mathbf{Z}_i\in\mathbb{R}^{M\times D\times N},i\in\{1,...,K\}

Zi∈RM×D×N,i∈{1,...,K} 是第 i 个块的输入,

Block(·)表示ModernTCN块。 然后最终的表示 Z = B l o c k ( Z K ) + Z K \mathbf{Z}=\mathrm{Block}(\mathbf{Z}_K)+\mathbf{Z}_K Z=Block(ZK)+ZK 将进一步用于多个时间序列分析任务。 有关每个任务的管道,请参阅附录 B。

四、 实验

我们在五个主流分析任务上对 ModernTCN 进行评估,包括长期和短期预测、插补、分类和异常检测,以验证 ModernTCN 的通用性。

基线由于我们试图提出时间序列分析的基础模型,因此我们广泛采用时间序列社区中最新和先进的模型作为基本基线,其中包括基于 Transformer 的模型:PatchTST (2023)、Crossformer (2023) 和 FEDformer ( 2022); 基于 MLP 的模型:MTS-Mixer (2023b)、LightTS (2022)、DLinear (2022)、RLinear 和 RMLP (2023a); 基于卷积的模型:TimesNet (2023)、MICN (2023) 和 SCINet (2022a)。 我们还在每个特定任务中包含最先进的模型,作为全面比较的额外基线。

主要结果 如图 3 所示,ModernTCN 在 5 个主流分析任务上以更高的效率实现了一致的最先进的性能。 关于实验结果的详细讨论见 5.1 节。 我们在以下小节中提供每个任务的实验细节和结果。 在每个表中,最好的结果以粗体显示,次好的结果以下划线显示。

图 3:模型性能比较(左)和效率比较(右)。

4.1 LONG-TERM FORECASTING

设置我们对 9 个流行的现实世界基准进行了长期预测实验,包括天气 (Wetterstation)、交通 (PeMS)、电力 (UCI)、交易所 (Lai et al., 2018a)、ILI (CDC) 和 4 个 ETT 数据集 (周等人,2021)。 接下来(Nie et al., 2023;Zhang & Yan, 2023),我们重新运行具有不同输入长度的所有基线,并选择最佳结果,以避免低估基线并提供更公平的比较。 我们计算多元时间序列预测的 MSE 和 MAE 作为指标。

结果表1显示了ModernTCN在长期预测方面的优异表现。 具体而言,ModernTCN 在上述 9 个案例中获得了大部分最佳性能,超越了广泛的基于 MLP 和 Transformer 的最先进模型。 它在性能方面与基于 Transformer 的最佳模型 PatchTST 不相上下,同时具有更快的速度和更少的内存使用量(图 3 右),因此提供了性能和效率的更好平衡。 值得注意的是,ModernTCN 大幅超越了现有的基于卷积的模型(MSE 降低了 27.4%,MAE 降低了 15.3%),这表明我们的设计可以更好地释放卷积在时间序列预测中的潜力。

表 1:长期预测任务。 所有结果均根据 4 个不同的预测长度进行平均,即 ILI 为 {24, 36, 48, 60},其他预测长度为 {96, 192, 336, 720}。 MSE 或 MAE 越低表示性能越好。 有关包含更多基线的完整结果,请参阅附录中的表 27。

表 2:短期预测任务。 结果是不同样本间隔下的多个数据集的加权平均。 指标越低表示性能越好。 完整结果请参见表 28。

4.2 SHORT-TERM FORECASTING

设置我们采用 M4 数据集(Makridakis 等,2018)作为短期预测基准。 按照(Wu et al., 2023),我们将输入长度固定为预测长度的 2 倍,并计算对称平均绝对百分比误差(SMAPE)、平均绝对比例误差(MASE)和总体加权平均值(OWA)作为指标。 我们为此特定任务添加了其他基线,例如 CARD (2023)、N-BEATS (2019) 和 N-HiTS (2023)。 由于M4数据集仅包含单变量时间序列,因此我们删除了ModernTCN和Crossformer中的交叉变量组件。

结果 结果总结在表 2 中。M4 数据集中的短期预测是一项更具挑战性的任务,因为时间序列样本是从不同的来源收集的,并且具有完全不同的时间属性。 我们的 ModernTCN 在这项艰巨的任务中仍然达到了一致的最先进水平,展示了其出色的时间建模能力。

4.3 IMPUTATION

设置插补任务旨在根据部分观察的时间序列插补缺失值。 由于设备故障或通信错误等意外事故,时间序列中的缺失值非常常见。 由于缺失值可能会损害下游分析的性能,因此插补任务具有很高的实用价值。 接下来(Wu et al., 2023),我们主要关注数据丢失问题经常发生的电力和天气场景。 我们从这些场景中选择数据集作为基准,包括 ETT (Zhou et al., 2021)、电力 (UCI) 和天气 (Wetterstation)。 我们以{12.5%,25%,37.5%,50%}的比例随机屏蔽时间点,以比较不同比例缺失数据下的模型容量。

结果表 3 显示了 ModernTCN 在插补任务中令人信服的性能。 与之前最先进的基线 TimesNet (2023) 相比,ModernTCN 在 MSE 上降低了 22.5%,在 MAE 上降低了 12.9%。 由于缺失值,剩余的观察时间序列是不规则的,使得捕获跨时间依赖性变得更加困难。 我们的 ModernTCN 在这项具有挑战性的任务中仍然取得了最佳性能,验证了模型在极其复杂的情况下捕获时间依赖性的能力。

表 3:插补任务。 我们随机屏蔽长度为 96 的时间序列中的 {12.5%, 25%, 37.5%, 50%} 时间点。 结果是 4 个不同掩模比率的平均值。 MSE 或 MAE 越低表示性能越好。 有关包含更多基线的完整结果,请参阅附录中的表 29。

还值得注意的是,跨变量依赖性在插补任务中起着至关重要的作用。 由于在某些时间步长中,只有部分变量缺失,而其他变量仍然存在,因此利用缺失变量和剩余变量之间的跨变量依赖关系可以帮助有效地估算缺失值。 因此,一些与变量无关的方法,如 PatchTST (2023) 和 DLinear (2022),由于没有考虑跨变量依赖性而在此任务中失败。

4.4 CLASSIFICATION AND ANOMALY DETECTION

图 4:分类和异常检测的结果。 结果是多个数据集的平均值。 准确率和 F1 分数越高,表明性能越好。 *。 基于 Transformer 的模型中表示 ∗former 的名称。 完整结果请参见附录中的表 30 和 31。

设置 对于分类,我们从 UEA 时间序列分类档案(Bagnall 等人,2018)中选择 10 个多元数据集进行基准测试并预处理以下数据集(Wu 等人,2023)。 我们纳入了一些特定于任务的最先进方法,例如 LSTNet (2018b)、Rocket (2020) 和 Flowformer (2022) 作为附加基线。

对于异常检测,我们比较了五个广泛使用的基准上的模型:SMD(Su 等人,2019)、SWaT(Mathur 和 Tippenhauer,2016)、PSM(Abdulaal 等人,2021)、MSL 和 SMAP(Hundman 等人) .,2018)。 我们将 Anomaly Transformer (2021) 作为附加基线。 接下来,我们采用经典的重建任务并选择重建误差作为异常标准。

结果时间序列分类是时间序列领域的经典任务,反映了模型的高级表示能力。 如图4所示,ModernTCN取得了最好的性能,平均准确率为74.2%。 值得注意的是,一些基于 MLP 的模型在分类任务中失败了。 这是因为基于MLP的模型更愿意丢弃特征维度来获得轻量级的主干网,从而导致表示能力不足和分类性能较差。 异常检测结果如图 4 所示。ModernTCN 的性能与之前最先进的基线 TimesNet (2023) 相比具有竞争力。 同时,与 TimesNet 相比,ModernTCN 在分类任务中平均每 epoch 训练时间节省了 55.1%(3.19s vs 7.10s),在异常检测任务中节省了 57.3% 每 epoch 平均训练时间(132.65s vs 310.62s),提供了更好的平衡 这两项任务的效率和绩效。

五、 MODEL ANALYSIS

5.1 COMPREHENSIVE COMPARISON OF PERFORMANCE AND EFFICIENCY

实验结果总结 与其他特定任务模型或之前的最先进基线相比,ModernTCN 在五个主流分析任务上实现了一致的最先进性能,展示了其出色的任务通用性,并突显了卷积在时间上的潜力 系列分析(图3左)。 ModernTCN在效率上也更具优势,因此提供了效率和性能的更好平衡(图3右)。 值得注意的是,我们的方法大幅超越了现有的基于卷积的模型,这表明我们的设计可以为如何在时间序列分析中更好地使用卷积的问题提供更好的解决方案。

与基于 Transformer 和基于 MLP 的模型相比与之前基于卷积的模型不同,ModernTCN 在性能方面可以与最先进的基于 Transformer 的模型相媲美甚至更好。 同时,作为纯卷积模型,ModernTCN比基于Transformer的模型具有更高的效率。 如图3右所示,ModernTCN具有更快的训练速度和更少的内存使用,这证明了我们模型的效率优势。

由于 ModernTCN 模块具有更好的表示能力,ModernTCN 在所有五项任务中都优于所有基于 MLP 的基线。 相比之下,基于 MLP 的模型更喜欢采用轻量级骨干网来减少内存使用。 但基于 MLP 的模型的这种设计也导致了表示能力不足和性能较差。 尽管 ModernTCN 在内存使用方面稍逊一筹,但由于卷积中快速的浮点运算速度,它仍然具有与一些基于 MLP 的基线几乎相同的运行时间效率。 从性能和效率两方面考虑,ModernTCN在一般时间序列分析方面更有优势。

与 TimesNet (2023) 相比,除了 ModernTCN 之外,TimesNet 在 5 个主流任务中也表现出了出色的通用性。 值得注意的是,这两个模型都是基于卷积的模型,这进一步揭示了卷积在时间序列分析方面具有更好的综合能力。 同时,这两种方法都受到了CV的启发,旨在使时间序列分析能够利用CV社区的发展。 但这两种方法采用不同的路径来实现这一目标。 TimesNet致力于将一维时间序列转换为二维空间,使得时间序列可以通过CV社区中的2D ConvNets进行建模。 但额外的数据转换和聚合模块也带来了额外的内存使用和较慢的训练速度。 与TimesNet不同,我们的ModernTCN维护了一维时间序列,并转向对时间序列社区中的一维卷积进行现代化和优化。 因此,我们设计了一种现代的纯卷积结构,没有任何额外的模块。 我们设计中的全卷积特性带来了更高的效率,并且实现起来极其简单,因此比 TimesNet 具有性能和效率优势(图 3 左右)。

5.2 有效感受野(ERF)分析

扩大 ERF 是将卷积带回时间序列分析的关键。 在本节中,我们将从 ERF 的角度讨论为什么 ModernTCN 能够提供比之前基于卷积的模型更好的性能。 首先,ModernTCN 没有像其他传统 TCN(2018)那样堆叠更多层,而是通过扩大内核大小来增加 ERF。 在纯卷积结构中,增大内核大小是提高 ERF 的更有效方法。 根据纯卷积模型中的ERF理论(Luo et al., 2016),ERF与O(ks×√nl)成正比,其中ks和nl分别指内核大小和层数。 ERF 随内核大小线性增长,而随层数次线性增长。 因此,通过加大内核尺寸,ModernTCN可以轻松获得更大的ERF,进一步带来性能提升。

除了扩大内核大小和堆叠更多层之外,时间序列社区中一些先前基于卷积的方法(MICN(2023)和SCINet(2022a))更喜欢采用一些复杂的结构与传统卷积配合,旨在扩大其ERF 。 由于它们不是纯卷积结构,因此很难从理论上分析它们的ERF。 因此,我们将这些方法的 ERF 可视化以进行直观比较。 接下来(Kim 等人,2023),我们从 ETTh1 中的验证集中采样了 50 个长度为 336 的输入时间序列以进行可视化。 背后的想法是可视化输入序列中有多少点可以对最终特征图的中间点做出贡献。 如图 1 所示,我们的方法可以获得比之前基于卷积的方法大得多的 ERF。 因此,我们的方法可以更好地释放时间序列中卷积的潜力,并成功地在多个时间序列分析任务中带来性能提升。

5.3 消融研究

ModernTCN 模块设计的消融为了验证我们在 ModernTCN 模块中设计的有效性,我们在长期预测任务中进行了消融研究。 结果如表4所示。丢弃变量维度不能提供理想的性能,这证实了我们的论点,即简单地以与CV相同的方式对卷积进行现代化改造并不能因为忽略变量维度的重要性而带来性能提升。 为了更好地处理可变维度,我们在设计中将单个 ConvFFN 解耦为 ConvFFN1 和 ConvFFN2。 如表4所示,未解耦的ConvFFN提供了最差的性能,而我们解耦的两个ConvFFN(ConvFFN1+ConvFFN2)的组合实现了最好的性能,这证明了我们对ConvFFN模块进行解耦修改的必要性和有效性。 更多详情请参阅附录 H。

表 4:ModernTCN 块的消融。 我们列出了不同预测长度的平均 MSE/MAE。

跨变量组件的消融作为我们设计中与时间序列相关的重要修改,我们将 ConvFFN2 设计为跨变量组件来捕获跨变量依赖性。 我们在插补任务和异常检测任务中进行消融研究。 如表5所示,没有ConvFFN2将导致这两个任务的性能严重下降,这强调了时间序列分析中跨变量依赖性的重要性。

表 5:交叉变量分量的消融。

六、 结论和未来工作

在本文中,我们采用时间序列界很少探索的方法来解决如何在时间序列分析中更好地使用卷积的问题。 通过对传统 TCN 模块进行现代化和与时间序列相关的修改,我们提出了 ModernTCN 并成功地将卷积带回时间序列分析的舞台。 实验结果表明ModernTCN具有良好的任务通用性。 ModernTCN 在性能方面与最先进的基于 Transformer 的模型相当或更好,同时保持了基于卷积的模型的效率优势,从而提供了性能和效率的更好平衡。 由于基于卷积的模型长期以来在时间序列分析中受到的关注较少,我们希望本研究报告的新结果能为时间序列界带来一些新鲜的视角,并促使人们重新思考卷积在时间序列分析中的重要性 。

2492

2492

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?