Kafka

Kafka是由Apache软件基金会开发的一个开源流处理平台,由Scala和Java编写。Kafka是一种高吞吐量的分布式发布订阅消息系统,它可以处理消费者在网站中的所有动作流数据。 这种动作(网页浏览,搜索和其他用户的行动)是在现代网络上的许多社会功能的一个关键因素。 这些数据通常是由于吞吐量的要求而通过处理日志和日志聚合来解决。 对于像Hadoop一样的日志数据和离线分析系统,但又要求实时处理的限制,这是一个可行的解决方案。Kafka的目的是通过Hadoop的并行加载机制来统一线上和离线的消息处理,也是为了通过集群来提供实时的消息。

名字的由来

kafka的架构师jay kreps对于kafka的名称由来是这样讲的,由于jay kreps非常喜欢franz kafka,并且觉得kafka这个名字很酷,因此取了个和消息传递系统完全不相干的名称kafka,该名字并没有特别的含义。

kafka的诞生

kafka的诞生,是为了解决linkedin的数据管道问题,起初linkedin采用了ActiveMQ来进行数据交换,大约是在2010年前后,那时的ActiveMQ还远远无法满足linkedin对数据传递系统的要求,经常由于各种缺陷而导致消息阻塞或者服务无法正常访问,为了能够解决这个问题,linkedin决定研发自己的消息传递系统,当时linkedin的首席架构师jay kreps便开始组织团队进行消息传递系统的研发;

特性

Kafka 是一种高吞吐量的分布式发布订阅消息系统,有如下特性:

- 加粗样式通过O(1)的磁盘数据结构提供消息的持久化,这种结构对于即使数以TB的消息存储也能够保持长时间的稳定性能。

- 高吞吐量 :即使是非常普通的硬件Kafka也可以支持每秒数百万 的消息。

- 支持通过Kafka服务器和消费机集群来分区消息。

- 支持Hadoop并行数据加载。

- Kafka通过官网发布了最新版本2.5.0 。

相关术语介绍

Broker:

Kafka集群包含一个或多个服务器,这种服务器被称为broker

Topic:

每条发布到Kafka集群的消息都有一个类别,这个类别被称为Topic。(物理上不同Topic的消息分开存储,逻辑上一个Topic的消息虽然保存于一个或多个broker上但用户只需指定消息的Topic即可生产或消费数据而不必关心数据存于何处)

Partition:

Partition是物理上的概念,每个Topic包含一个或多个Partition.

Producer:

负责发布消息到Kafka broker

Consumer:

消息消费者,向Kafka broker读取消息的客户端。

Consumer Group:

每个Consumer属于一个特定的Consumer Group(可为每个Consumer指定group name,若不指定group name则属于默认的group)。

安装

前提:安装docker和docker-compose(如未安装请详见我的其他文章)

镜像选择

Zookeeper和Kafka集群分别运行在不同的容器中

zookeeper官方镜像,版本3.4 (zookeeper:3.4)

kafka采用wurstmeister/kafka镜像

kafka-manager采用sheepkiller/kafka-manager:latest镜像

实现目标

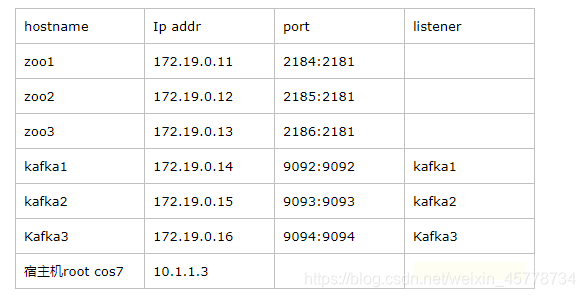

kafka集群在docker网络中可用,和zookeeper处于同一网络

宿主机可以访问zookeeper集群和kafka的broker list

docker重启时集群自动重启

集群的数据文件映射到宿主机器目录中

使用yml文件和$ docker-compose up -d命令创建或重建集群

拉取镜像

docker pull zookeeper:3.4

docker pull wurstmeister/kafka

docker pull sheepkiller/kafka-manager:latest

创建集群网络

docker network create --driver bridge --subnet 172.19.0.0/16 --gateway 172.19.0.1 kafka

查看网络

docker network ls

zk集群的docker-compose.yml(任意目录下创建docker-compose.yml文件)

version: '3.4'

services:

zoo1:

image: zookeeper:3.4

restart: always

hostname: zoo1

container_name: zoo1

ports:

- 2184:2181

volumes:

- "/liushuo/volume/zkcluster/zoo1/data:/data"

- "/liushuo/volume/zkcluster/zoo1/datalog:/datalog"

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

877

877

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?