kafka概述

定义

传统定义:

kafka是一个分布式的基于发布/订阅模式的消息队列(Message Queue),主要应用于大数据实时处理领域。

最新定义:

kafka是一个开源的分布式事件流平台(Event Streaming Platform),被数千家公司用于高性能数据管道、流分析、数据集成和关键任务应用。

应用场景

缓冲/削峰:有助于控制和优化数据流经过系统的速度,解决生产消息和消费消息的处理速度不一致的情况。

解耦:允许你独立的扩展或修改两边的处理过程,只要确保它们遵守同样的接口约束。

异步通信:允许用户把一个消息放入队列,但并不立即处理它,然后在需要的时候再去处理它们。

架构

- Producer:消息生产者,就是向 Kafka broker 发消息的客户端。

- Consumer:消息消费者,向 Kafka broker 取消息的客户端。

- Consumer Group(CG):消费者组,由多个 consumer 组成。消费者组内每个消费者负责消费不同分区的数据,一个分区只能由一个组内消费者消费;消费者组之间互不影响。所有的消费者都属于某个消费者组,即消费者组是逻辑上的一个订阅者。

- Broker:一台 Kafka 服务器就是一个 broker。一个集群由多个 broker 组成。一个broker 可以容纳多个 topic。

- Topic:可以理解为一个队列,生产者和消费者面向的都是一个 topic。

- Partition:为了实现扩展性,一个非常大的 topic 可以分布到多个 broker(即服务器)上,一个 topic 可以分为多个 partition,每个 partition 是一个有序的队列。

- Replica:副本。一个 topic 的每个分区都有若干个副本,一个 Leader 和若干个Follower。

- Leader:每个分区多个副本的“主”,生产者发送数据的对象,以及消费者消费数据的对象都是 Leader。

- Follower:每个分区多个副本中的“从”,实时从 Leader 中同步数据,保持和

Leader 数据的同步。Leader 发生故障时,某个 Follower 会成为新的 Leader。

两种模式

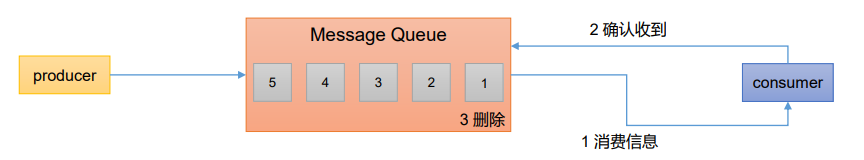

点对点模式

消费者主动拉取数据,消息收到后清除消息

发布/订阅模式

可以有多个topic主题(浏览、点赞、收藏、评论等)

消费者消费数据之后,不删除数据

每个消费者相互独立,都可以消费到数据

集群安装部署

集群规划

| 主机名 | 角色 |

|---|---|

| s1 | zk、kafka |

| s2 | zk、kafka |

| s3 | zk、kafka |

集群部署

安装JDK

卸载自带openjdk:

yum remove java-* -y

到官网下载jdk,下载好后上传到各节点(使用tar包安装需要配置环境变量)。官网地址:https://www.oracle.com/java/technologies/downloads/

安装jdk:

rpm -ivh jdk-18_linux-x64_bin.rpm

安装zookeeper

参考之前文章:zookeeper安装

安装kafka

到官网下载安装包:kafka官方网站

将安装包上传到各节点并解压

tar -zxvf kafka_2.12-3.0.0.tgz -C /opt/

cd /opt

mv kafka_2.12-3.0.0 kafka # 重命名文件夹

修改配置文件:

# broker 的全局唯一编号,不能重复,只能是数字。

broker.id=0

# kafka 运行日志(数据)存放的路径,路径不需要提前创建,kafka 自动帮你创建,可以配置多个磁盘路径,路径与路径之间可以用","分隔

log.dirs=/opt/kafka/datas

# 配置连接 Zookeeper 集群地址(在 zk 根目录下创建/kafka,方便管理)

zookeeper.connect=s1:2181,s2:2181,s3:2181/kafka

配置环境变量:

创建文件 /etc/profile.d/my_env.sh 并在文件中添加如下内容:

# KAFKA_HOME

export KAFKA_HOME=/opt/kafka

export PATH=$PATH:$KAFKA_HOME/bin

source /etc/profile # 刷新环境变量

其他两个节点操作相同,broker.id不同即可

kafka命令行操作

集群操作

bin/kafka-server-start.sh -daemon config/server.properties # 启动集群

bin/kafka-server-stop.sh # 停止集群

停止 Kafka 集群时,一定要等 Kafka 所有节点进程全部停止后再停止 Zookeeper集群。因为 Zookeeper 集群当中记录着 Kafka 集群相关信息,Zookeeper 集群一旦先停止,Kafka 集群就没有办法再获取停止进程的信息,只能手动杀死 Kafka 进程了。

主题操作

| 参数 | 描述 |

|---|---|

| –bootstrap-server <String: server toconnect to> | 连接的 Kafka Broker 主机名称和端口号。 |

| –topic <String: topic> | 操作的 topic 名称。 |

| –create | 创建主题。 |

| –delete | 删除主题。 |

| –alter | 修改主题。 |

| –list | 查看所有主题。 |

| –describe | 查看主题详细描述。 |

| –partitions <Integer: # of partitions> | 设置分区数。 |

| –replication-factor<Integer: replication factor> | 设置分区副本。 |

| –config <String: name=value> | 更新系统默认的配置。 |

查看当前服务器中所有topic

bin/kafka-topics.sh --bootstrap-server s1:9092 --list

创建一个名为first的主题,分区数为1,副本数为3。

bin/kafka-topics.sh --bootstrap-server s1:9092 --create --partitions 1 --replication-factor 3 --topic first

查看first主题的详细信息

bin/kafka-topics.sh --bootstrap-server s1:9092 --describe --topic first

修改分区数(只能增加)

bin/kafka-topics.sh --bootstrap-server s1:9092 --alter --topic first --partitions 3

删除 topic(一般不要操作)

bin/kafka-topics.sh --bootstrap-server s1:9092 --delete --topic first

生产者操作

连接到集群中的first主题

bin/kafka-console-producer.sh --bootstrap-server s1:9092 --topic first

消费者操作

消费first主题中的数据

bin/kafka-console-consumer.sh --bootstrap-server s1:9092 --topic first

从头消费first主题中的数据

bin/kafka-console-consumer.sh --bootstrap-server s1:9092 --topic first --from-beginning

本文总结自尚硅谷视频:kafka,仅作个人学习笔记使用。

3158

3158

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?