Enhanced Super-Resolution Generative Adversarial Networks https://arxiv.org/pdf/1809.00219.pdf code: https://github.com/xinntao/ESRGAN ECCV2018

在SRGAN的升级之处:

3、improved perceptual loss:VGG在激活前的feature

4、further:网络权重的插值

补充:什么是Relativistic average GAN (RaGAN):https://zhuanlan.zhihu.com/p/40403886

percpecture index是什么 和percpecture loss的关系:![]() ,percpecture是第三部分的VGG

,percpecture是第三部分的VGG

1、Residual-in-Residual Dense Block (RDDB)

文章用了两套生成器,第一套是16 residual blocks

第二套是23 RRDB blocks

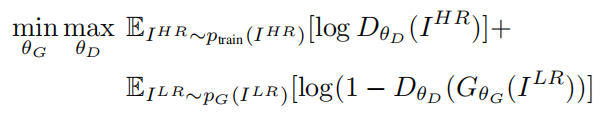

2、 Relativistic Discriminator

Ld=

Lg=

3、improved perceptual loss

激活后太稀疏,大多数都没有被激活。

VGG采用的是ReLU激活函数,说明特征图里面很多是负的。

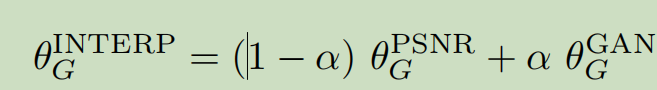

4、Network Interpolation

融合PSNR-oriented 的fidelity 和 GAN的perceptual quality。

α设置为0.2

注意,是网络参数的reweight,而不是两个网络最后结果的图像进行像素的reweight,实验表明 效果⑧行

code: 后期手动进行调整测试

net_PSNR = torch.load(net_PSNR_path)

net_ESRGAN = torch.load(net_ESRGAN_path)

net_interp = OrderedDict()

print('Interpolating with alpha = ', alpha)

for k, v_PSNR in net_PSNR.items():

v_ESRGAN = net_ESRGAN[k]

net_interp[k] = (1 - alpha) * v_PSNR + alpha * v_ESRGAN

torch.save(net_interp, net_interp_path)

5、训练过程:只做了x4

①cropped HR patch is 128 × 128:大图语义信息丰富

②训练PSNR-oriented model: L1loss, lr=2*10^-4, 200000 iter 减半 ?没说总共多少epoch

③训练GAN lr=1×10−4 and halved at [50k, 100k, 200k, 300k] iter

6822

6822

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?