第一次接触BERT,在实现其样例的过程中走了很多弯路。

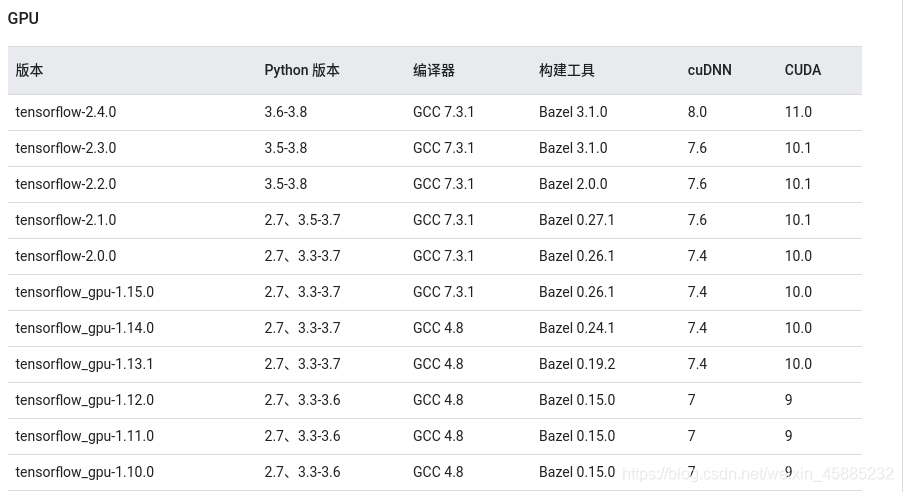

首先是tensorflow-gpu版本要在1.10.0-1.15.0之间,否则会有很多的不兼容问题。

为此,创建了新的虚拟环境:

conda create TF python=3.7

-

在这个TF环境下安装Tensorflow:

tensorflow-gpu 1.15.0与cuda及cudnn对应版本号关系:

-

1)安装cuda10.0

下载地址:https://developer.nvidia.com/cuda-10.0-download-archive -

2)安装cudnn7.4

下载地址:https://developer.nvidia.com/rdp/cudnn-archive

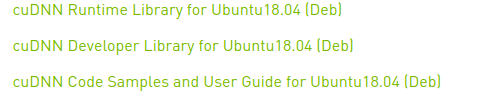

选择以下几个:

之后使用命令按顺序安装:

sudo dpkg -i libcudnn7_7.4.2.24-1+cuda10.0_amd64.deb

sudo dpkg -i libcudnn7-dev_7.4.2.24-1+cuda10.0_amd64.deb

sudo dpkg -i libcudnn7-doc_7.4.2.24-1+cuda10.0_amd64.deb

- 3)安装tensorflow-gpu版:(使用conda环境安装,不要使用pip)

conda install -c databricks tensorflow-gpu

- 环境配置好之后,修改参数:

--task_name=MRPC

--do_train=true

--do_eval=true

--data_dir=/home/xxx/pythonProject/Tensor/BERT/GLUE/glue_data/MRPC

--vocab_file=/home/xxx/pythonProject/Tensor/BERT/GLUE/BERT_BASE_DIR/uncased_L-12_H-768_A-12/vocab.txt

--bert_config_file=/home/xxx/pythonProject/Tensor/BERT/GLUE/BERT_BASE_DIR/uncased_L-12_H-768_A-12/bert_config.json

--init_checkpoint=/home/xxx/pythonProject/Tensor/BERT/GLUE/BERT_BASE_DIR/uncased_L-12_H-768_A-12/bert_model.ckpt

--max_seq_length=128

--train_batch_size=32

--learning_rate=2e-5

--num_train_epochs=3.0

--output_dir=/home/xxx/pythonProject/Tensor/GLUE/output/

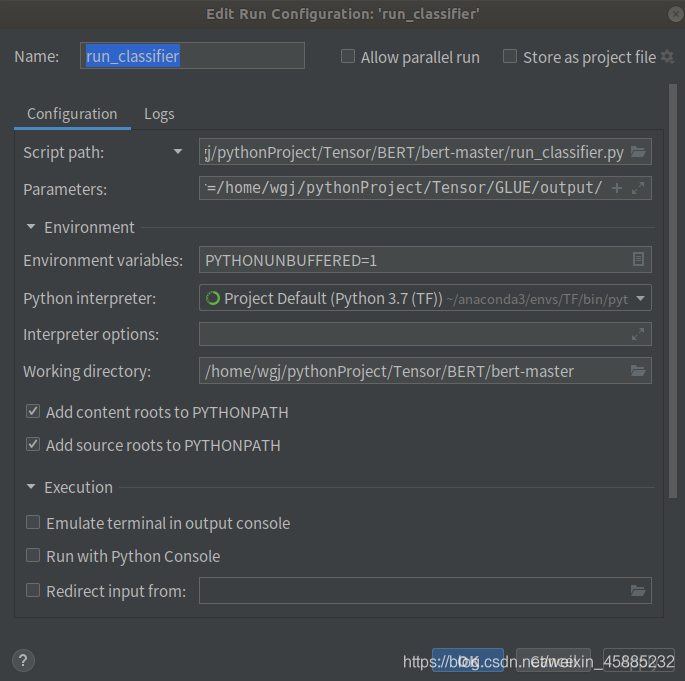

在pycharm中设置:

选中run_classifier.py,之后右键选中modify run configation,将上述参数复制到parameters中:

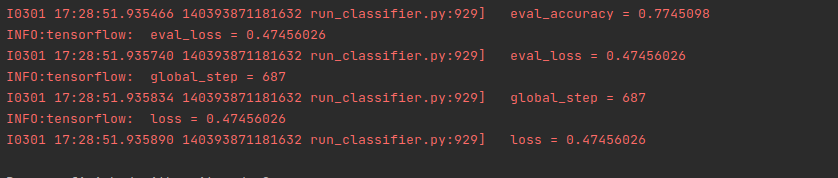

- 运行,等待结果。

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?