cuda环境配置(anaconda虚拟环境版,含pytorch-gpu安装)

一、背景

cuda可以直接装到电脑上,但是安装步骤复杂,且失败率较高。选择anaconda虚拟环境安装,操作简单,且可以结合pytorch、tensorflow等深度学习框架的不同版本,安装不同的版本的cuda,各个虚拟环境互不干扰,也可以一键删除。

二、anaconda虚拟环境创建

anaconda安装配置十分简单可自行查找教程,包括环境变量和镜像源配置。

打开cmd命令行(anaconda已放到环境变量)或者Anaconda PowershellPrompt(如下图):

输入 conda create -n test python=3.8

‘’test‘’为虚拟环境名词,可以自动定义。python版本可以结合自己的环境需求,自行修改,这里用python3.8。

输入y回车,等到运行完毕。输入conda env list,我们可以看到虚拟环境tese已创建完毕,环境名称后面是所在的路径,便于在pycharm等IDE中导入。

环境创建好后,需要进入虚拟环境,输入conda activate test回车:

可以看到环境由base变为test,表示已经进入test虚拟环境。下一步就是安装cuda和cudnn。

三、cuda+cudnn安装

1.cuda版本查询

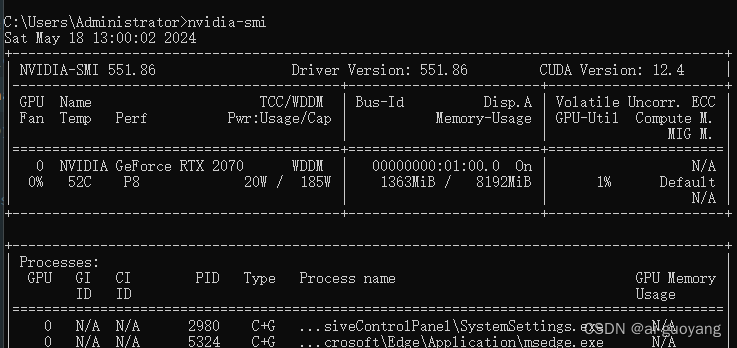

打开命令行,输入nvidia-smi

如图,CUDA Version后面的就是电脑显卡可支持的cuda版本,所以我们要装的cuda版本需要<=12.4(可向下兼容)。如果输入nvidia-smi,表示命令不存在,则说明电脑没有安装显卡驱动,显卡驱动安装可参考如何在windows上 安装&更新 显卡的驱动

2.cudatoolkit安装

在Anaconda虚拟环境安装cuda就是通过conda命令安装cudatoolkit来实现,可以将cudatoolkit看成conda版的cuda,想具体了解cuda和cudatoolkit直接的区别,请参考一文讲清楚CUDA、CUDA toolkit、CUDNN、NVCC关系。

打开Anaconda命令行,进入我们创建好的虚拟环境(一定要进入虚拟环境!!!),输入conda search cudatoolkit --info,查看cudatoolkit已有的安装包版本。

我们可以看到各种版本的cudatoolkit,最高版本为11.8.0,因为我的最高支持12.4,所以我们安装11.8.0,安装命令为conda install cudatoolkit=11.8.0(这里用conda命令安装),回车,运行成功之后,再安装cudnn,直接使用conda install cudnn回车。这样我们的cuda环境就配置完毕了。

四、pytorch-gpu安装

1.安装

进入pytorch官网安装页面,

选择和你环境相配的选项,复制conda命令到anaconda虚拟环境的命令行页面,回车即可。如果你所要运行的项目对pytorch版本有严格要求,可以点击如图所示的地方:

进入如下页面,选择你所装的cuda版本下的和你想要的pytorch版本,进行命令安装。(一定要对应你的cuda的版本!!!,可适当向下兼容,但不要相差太大)

2.验证pytorch-gpu是否安装成功

在虚拟环境下,输入python,进入python命令行,

先导入torch库,import torch,再输入torch.cuda.is_available()

如图返回True,证明你的pytorch-gpu版本安装成功了。

1094

1094

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?