数据存储

一、介绍

在前面己经提到,容器的生命周期可能很短,会被频繁地创建和销毁。那么容器在销毁时,保存在容器中的数 据也会被清除。这种结果对用户来说,在某些情况下是不乐意看到的。为了持久化保存容器的数据,kubernetes 引入 Volume的概念。

Volume是Pod中能够被多个容器访问的共享目录,它被定义在Pod上,然后被一个Pod里的多个容器挂载到具 体的文件目录下,Ikubernetes通过Volume实现同一个Pod中不同容器之间的数据共享以及数据的持久化存储。 Volume的生命容器不与Pod中单个容器的生命周期相关,当容器终止或者重启时,Volume中的数据也不会丢失 kubernetes的Volume支持多种类型,比较常见的有下面几个:

- 简单存储:EmptyDir、HostPath、NFS

- 高级存储:PV、PVC

- 配置存储:ConfigMap、Secret

二、基本存储

EmptyDir

EmptyDir是最基础的Volume类型, 一个EmptyDir就是Host上的一个空目录。 EmptyDir是在Pod被分配到Node时创建的,它的初始内容为空,并且无须指定省主机上对成的目录文件,因为 kubernetes会自动分配一个目录,当Pod销毁时,EmptyDir中的数据也会被永久别除。EmptyDir用途如下:

- 临时空间,例如用于某些应用程序运行时所需的临时目灵,旦无须永久保留

- 同一个pod中一个容品需要从另一个容器中获取数据的目录(多容器共享目录)

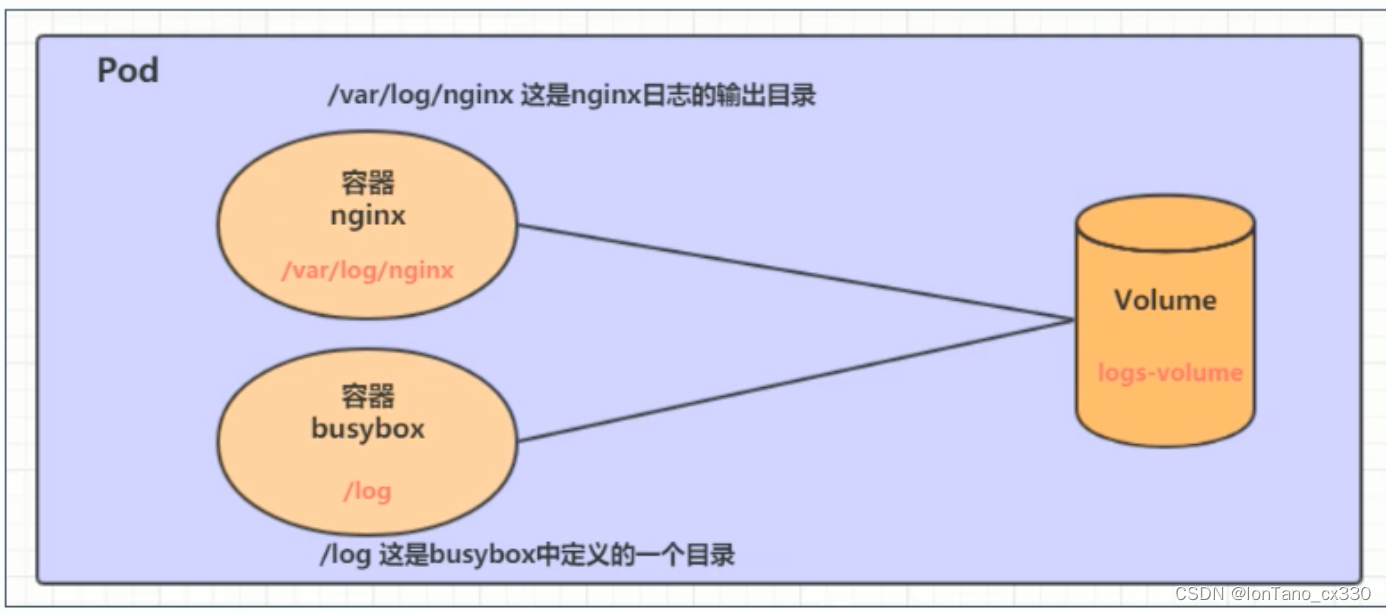

接下来,通过一个容品之间文件共享的案例来使用一下EmptyDir。

在 一个Pod中准备两个容器nginx和busybox,然后声明一个Volume分别挂在到两个容器的目录中,然后nginx 容器负责向Volume中写日志,busybox中通过命令将日志内容读到控制台。

创建volume-emptydir.yml

apiVersion: v1

kind: Pod

metadata:

name: volume-emptydir

namespace: test-dev

spec:

containers:

- name: nginx

image: nginx:1.17.1

ports:

- containerPort: 80

volumeMounts: # 将 Logs-volume挂载到nginx容器中,对应的目录为 /var/log/nginx

- name: logs-volume

mountPath: /var/log/nginx

- name: busybox

image: busybox:1.30

command: ["/bin/sh","-c”,“tail -f /logs/access.log"] # 初始命令,动态读取指定文件中内容

volumeMounts: #将1ogs-volume 挂在到busybox容器中,对应的目录为 /logs

- name: logs-volume

mountPath: /logs

volumes: # 声明volume, name为1ogs-volume,类型为emptyDir

- name: logs-volume

emptyDir: {}

创建pod

kubectl create -f volume-emptydir.yml

HostPath

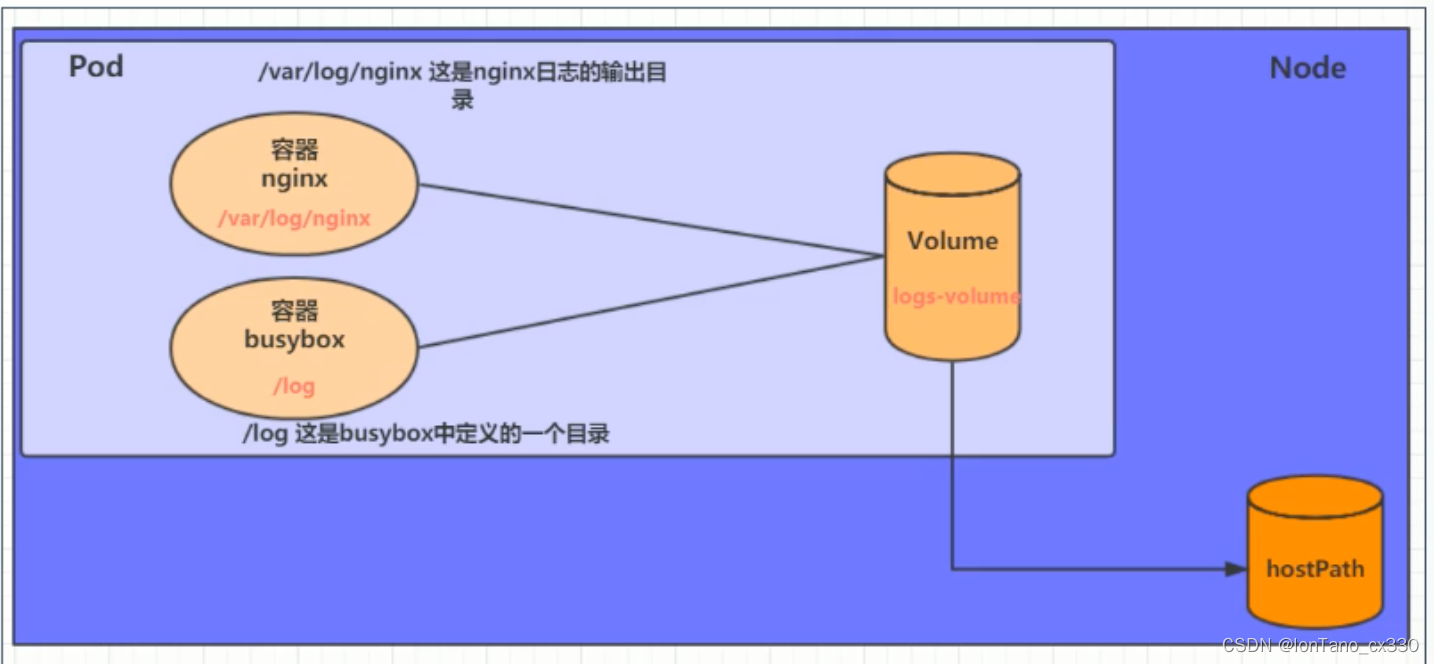

EmptyDir中数据不会被持久化,它会随着Pod的结束而销毁,如果想简单的将数据持久化到主机中,可以选择HostPath。 HostPath就是将Node主机中一个实际目录挂在到Pod中,以供容器使用,这样的设计就可以保证Pod销毁了, 但是数据依据可以存在于Node主机上。

创建volume-hostpath.yml

apiVersion: v1

kind: Pod

metadata:

name: volume-hostpath

namespace: test-dev

spec:

containers:

- name: nginx

image: nginx:1.17.1

ports:

- containerPort: 80

volumeMounts: # 将 Logs-volume挂载到nginx容器中,对应的目录为 /var/log/nginx

- name: logs-volume

mountPath: /var/log/nginx

- name: busybox

image: busybox:1.30

command: ["/bin/sh","-c”,“tail -f /logs/access.log"] # 初始命令,动态读取指定文件中内容

volumeMounts: #将1ogs-volume 挂在到busybox容器中,对应的目录为 /logs

- name: logs-volume

mountPath: /logs

volumes: # 声明volume, name为1ogs-volume,类型为emptyDir

- name: logs-volume

hostPath:

path: /root/logs

type: DirectorOrCreate # 目录存在就使用,不存在就先创建后使用

关于type的值的一点说明:

DirectoryOrCreate 目录存在就使用;不存在就先创建后使用

Directory 目录必须存在

FileOrCreate 文件存在就使用,不存在就先创建后使用

File 文件必须存在

Socket unix套接字必须存在

CharDevice 宇符设备必须存在

BlockDevice 块设备必须存在

NFS

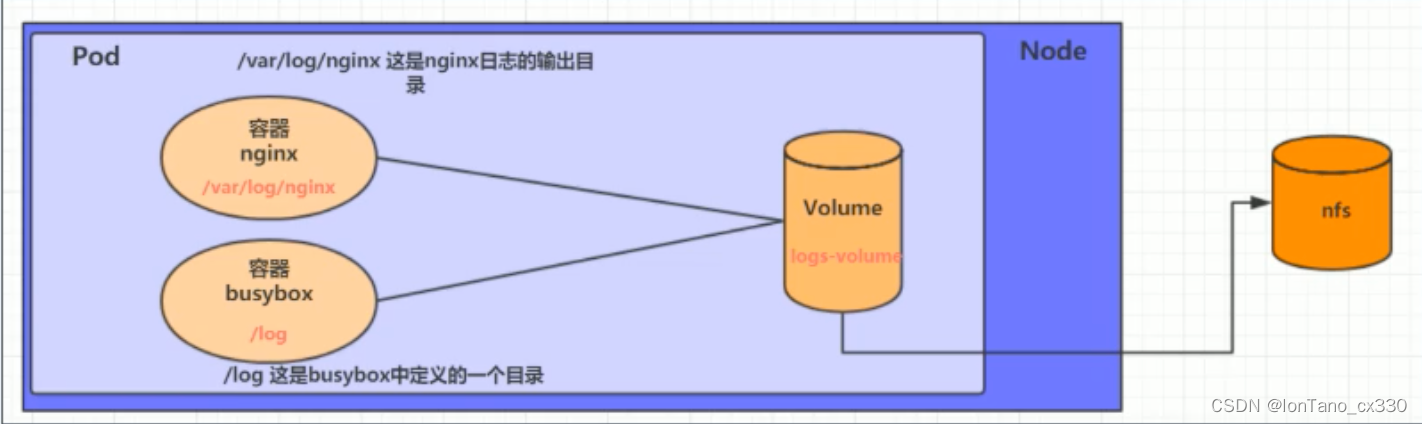

HostPath可以解决数据持久化的问题,但是一旦Node节点故障了,Pod如果转移到了别的节点,又会出现问题 了,此时需要准备单独的网络存储系统,比较常用的用NFS、CIFS。

NFS是 一个网络文件存储系统,可以搭建 一台NFS服务器,然后将Pod中的存储直接连接到NFS系统上,这样的 话,无论Pod在节点上怎么转移,只要Node跟NFS的对接没问题,数据就可以成功访问。(NFS一般都是要做备份 做高可用的 所以不用担心NFS挂了)

1) 首先要准备nfs的服务器,这里为了简单,直接是master节点做nfs服务器

# 在master上安装nfs服务

[rootemaster ~]# yum install nfs-utils -y

# 准备一个共享目录

[root@master ~]# mkdir /root/data/nfs -pv

# 将共享目录以读写权限暴露给192.168.109.0/24网段中的所有主机 ,也就是集群内的主机所在的网段

[root@master ~J# vim /etclexports

/root/data/nfs 192.168.109.0/24(rw,no_root_squash)

# 启动服务

[root@master ~J# systemctl start nfs

- 接下来,要在每个node节点上都安装下nfs,这样的目的是为了node节点可以驱动nfs设备

#在node节点上安装nfs服务,注意不要启动,一旦启动就会变成nfs服务器

[rootemaster ~]# yum install nfs-utils -y

3)接下来,可以创建volume-nfs.yml

apiVersion: v1

kind: Pod

metadata:

name: volume-hostpath

namespace: test-dev

spec:

containers:

- name: nginx

image: nginx:1.17.1

ports:

- containerPort: 80

volumeMounts: # 将 Logs-volume挂载到nginx容器中,对应的目录为 /var/log/nginx

- name: logs-volume

mountPath: /var/log/nginx

- name: busybox

image: busybox:1.30

command: ["/bin/sh","-c”,“tail -f /logs/access.log"] # 初始命令,动态读取指定文件中内容

volumeMounts: #将1ogs-volume 挂在到busybox容器中,对应的目录为 /logs

- name: logs-volume

mountPath: /logs

volumes: # 声明volume, name为1ogs-volume,类型为emptyDir

- name: logs-volume

nfs:

server: 192.168.xxxxx # nfs服务器地址

path: /root/data/nfs # 共享文件路径

高级存储:PV & PVC

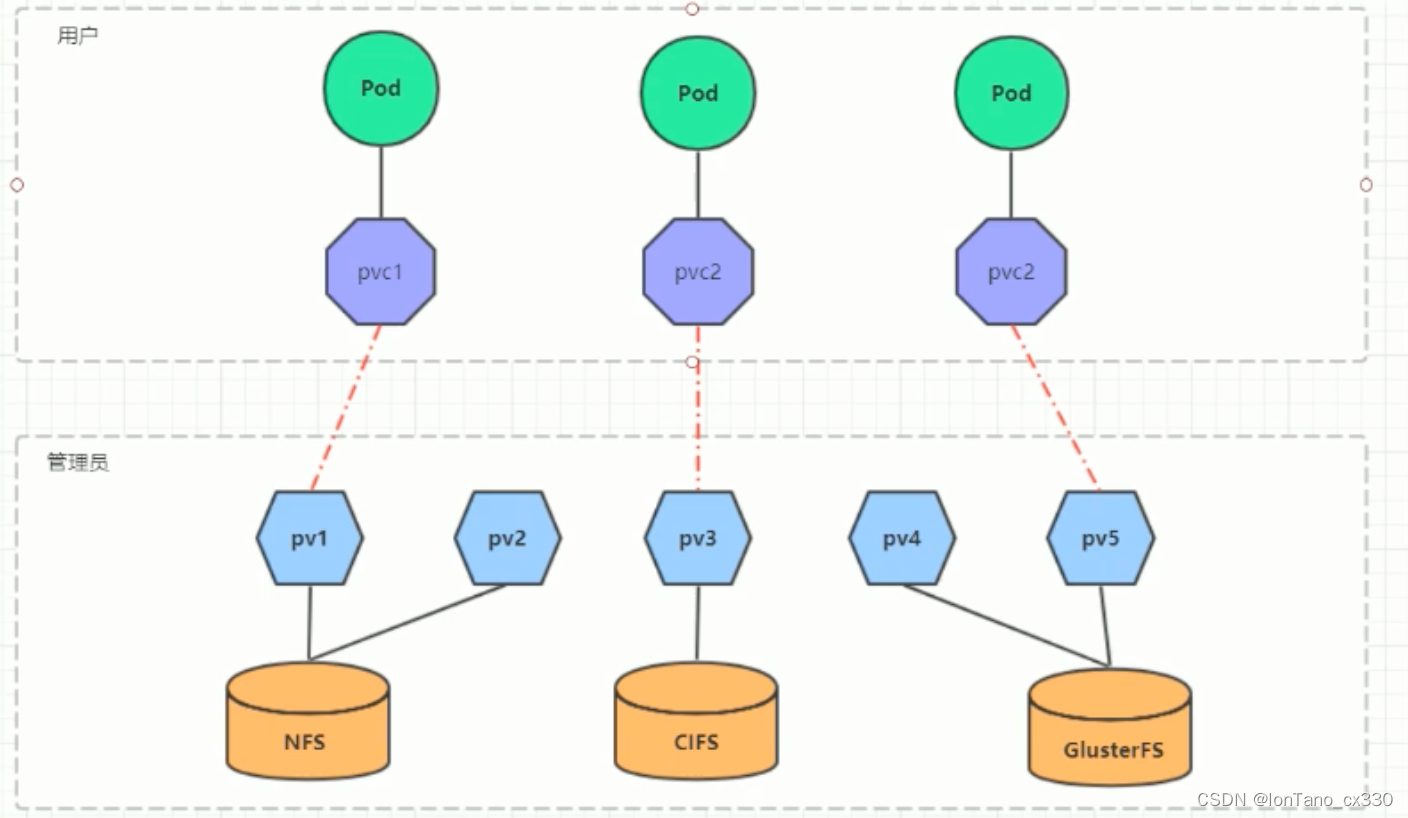

前面己经学习了使用NFS提供存储,此时就要求用户会搭建NFS系统,并且会在yaml配置nfs。由于kubernetes 支持的存储系統有很多,要求客户全都禁握,显然不现实。为了能够屏蔽底层存储实现的细节,方便用户使用, kubernetes引了入PV和PVC两种资源对象。

PV (Persistent

Volume)是持久化卷的意思,是对底层的共享存储的一种抽象。 一般情况下PV由kubernetes管理员进行创建和配置,它与底层具体的共享存储技术有关,并通过插件完成与共享存储的对控。

PVC (Persistent Volume

Claim)是持久卷声明的意思,是用户对于存储需求的一种声明。换句话说,PVC其 实就是用户向kubernetes系统发出的一种资源需求申请

PV

PV是存储资源的抽象,下面是资源清单文件

apiVersion: v1

kind: PersistentVolume

metadata:

name: pv2

spec:

nfs:#存储类型,与底层真正存储戏

capacity:#存储能力,目前只支持存储空间的设置

storage:2Gi

accessModes:#访问模式

storageClassName:# 存储类别

persistentVolumeReclaimPolicy:#回收策略

PV的关键配置参数说明

- 存储类型

底层实际存储的类型,kubernetes 支持多种存储类型,每种存储类型的配置都有所差异 - 存储能力 (capacity)

目前只支持存储空间的设置(storage=1Gi),不过未来可能会加入1OPS、吞吐量等指标的配置 - 访问模式 (access Modes)

用于描述用户应用对存储资源的访问权限,访问权限包括下面几种方式:

- ReadWrite Once (RWO):读写权限,但是只能被单个节点挂载 。

- ReadOnlyMany (ROX):只读权限,可以被多个节点挂载 。

- ReadWriteMany (RWX):读写权限,可以被多个节点挂载

需要注意的是,底层不同的存储类型可能支持的访问模式不同

- 回收策路 (persistentVvolumeReclaimPolicy)

当PV不再被使用了之后,对其的处理方式。目前支持三种策路:

- Retain(保留) 保留数据,需要管理员手工清理数据

- Recycle (回收)清除PV 中的数据,效果相当于执行 rm -rf /thevolume/*

- Delete (删除) 与PV 相连的后端存储完成 volume 的删除操作,当然这常见于云服务商的存储服务

需要注意的是,底层不同的存储类型可能支持的回收策略不同

- 存储类别

PV可以通过storageClassName参数指定一个存储类別

- 具有特定类别的PV只能与请求了该类别的PVC进行绑定

- 未设定类别的PV则只能与不请求任何类别的PVC进行绑定

- 状态 (status)

PV 的生命周期中,可能会处于4中不同的阶段:

- Available(可用) 表示可用状态,还未被任何 PVC 绑定

- Bound(己绑定): 表示 PV已经被 PVC绑定 。

- Released (己释放):表示 PVC 被删除,但是资源还未被集群重新 。

- Failed(失败): 表示该 PV 的自动回收失败

实验

使用NFS作为存储,来演示PV的使用,创建3个PV,对应NFS中的3个暴露的路径

# 创建目录

[root@master ~]# mkdir /root/data/(pv1, pv2, pv3) -pv

#暴露服务

[root@master ~]# more /etc/exports oot/data/pv1 192.168.109.0/24(rw,no_root_squash) root/data/pv2 192.168.109.0/24(rw,no_root_squash) root/data/pv3 192.168.109.0/24(rw,no_root_squash)

# 重启服务

[root@master ~]# systemctl restart nfs

创建pv.yml

apiversion: v1

kind: PersistentVolume

metadata:

name: pv1

spec:

capacity:

storage: 1Gi

accessModes:

- ReadWriteMany

persistentVolumeReclaimPolicy: Retain

nfs:

path: /root/data/pv1

server: 1927168.109.100

---

apiversion: v1

kind: PersistentVolume

metadata:

name: pv2

spec:

capacity:

storage: 2Gi

accessModes:

- ReadWriteMany

persistentVolumeReclaimPolicy: Retain

nfs:

path: /root/data/pv2

server: 1927168.109.100

---

apiversion: v1

kind: PersistentVolume

metadata:

name: pv3

spec:

capacity:

storage: 3Gi

accessModes:

- ReadWriteMany

persistentVolumeReclaimPolicy: Retain

nfs:

path: /root/data/pv3

server: 1927168.109.100

#创建pv

kubectl create -f pv.yml

# 查看pv

kubectl get pv -o wide

PVC

PVC是资源的申请,用来声明对存储空间、访问模式、存储类别需求信息。 资源清单如下:

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: pvc

namespace: test-dev

spec:

accessModes :# 访问模式

selector:#采用标签对PV选择

stordgeClassName: # 存储类别

resources:# 请求空间

requests:

storage:5Gi

PVC 的关键配置参数说明:

- 访问模式 (accessModes)

用描述用户应用对存储资源的访问权限 - 选择条件 (selector)

通过Label Selector的设置,可使PVC对于系统中己存在的PV进行筛选 - 存储类別 (storageClassName)

PVC在定义时可以设定需要的后端存储的类别,只有设置了该class的ov才能被景 - 资源请求 (Resources)

描述对存储资源的请求

实验:

1)创建pvc.yml,申请pv

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: pvc1

namespace: test-dev

spec:

accessModes:

- ReadWriteMany

resources:

requests:

storage: 1Gi

---

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: pvc2

namespace: test-dev

spec:

accessModes:

- ReadWriteMany

resources:

requests:

storage: 1Gi

---

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: pvc3

namespace: test-dev

spec:

accessModes:

- ReadWriteMany

resources:

requests:

storage: 5Gi

# 创建pvc

kubectl create -f pvc.yml

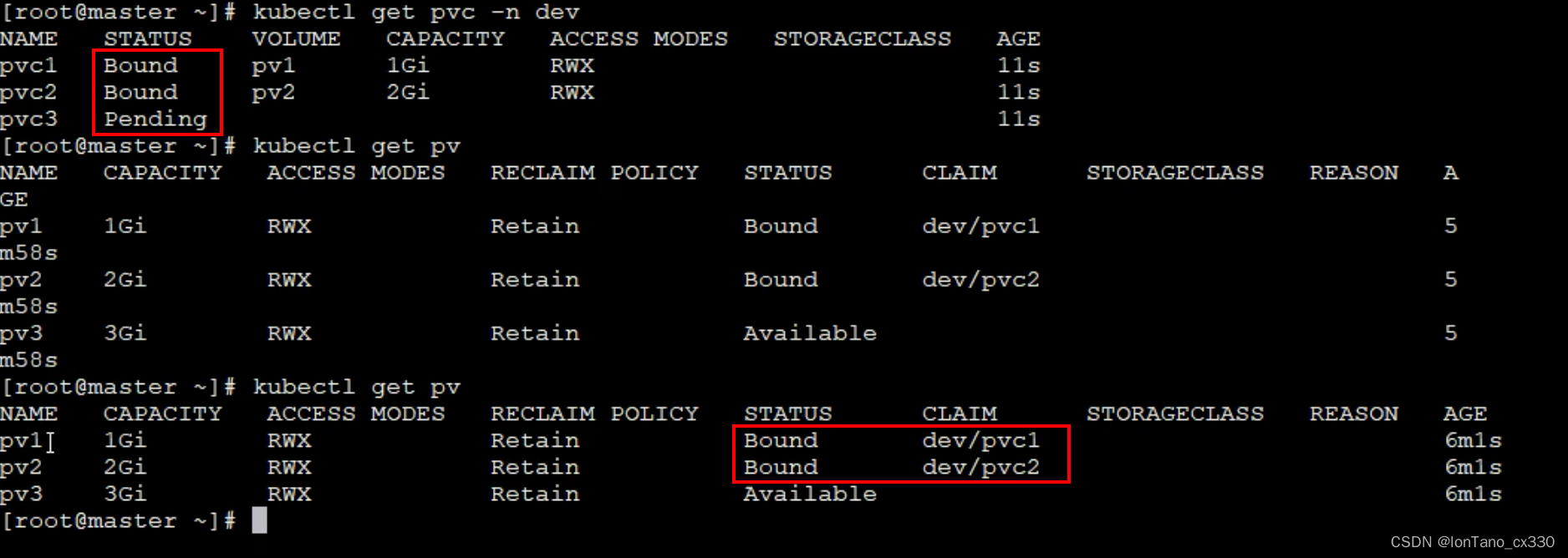

# 查看pvc,会发现只成功了两个pvc 因为pvc3要5Gi,没有适合的pv可以用

kubectl get pvc -n test-dev

2)创建pods.yml,使用pv

apiVersion: v1

kind: Pod

metadata:

name: pod1

namespace: test-dev

spec:

containers:

- name: busybox

image: busybox:1.30

command: ["/bin/sh","-c", "while true;do echo pod1 >> /root/out.txt; sleep 18; done;"]

volumeMounts:

- name: volume

mountPath: /root/

volumes:

- name: volume

persistentVolumeClaim:

claimName: pvc1

readOnly: false

---

apiVersion: v1

kind: Pod

metadata:

name: pod2

namespace: test-dev

spec:

containers:

- name: busybox

image: busybox:1.30

command: ["/bin/sh","-c", "while true;do echo pod1 >> /root/out.txt; sleep 18; done;"]

volumeMounts:

- name: volume

mountPath: /root/

volumes:

- name: volume

persistentVolumeClaim:

claimName: pvc2

readOnly: false

# 创建pod

kubectl create -t pods.yml

# 然后查看节点上/root/data/pv1 /root/data/pv2 就可以查看到目录下有out.txt文件

ls /root/data/pv1

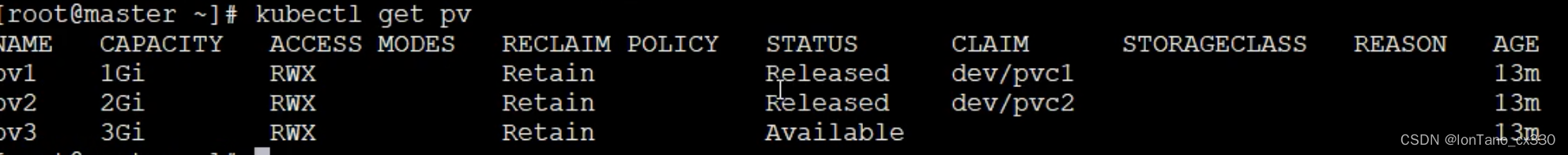

停掉pod 和pvc,查看pv就会发现状态变为release

生命周期

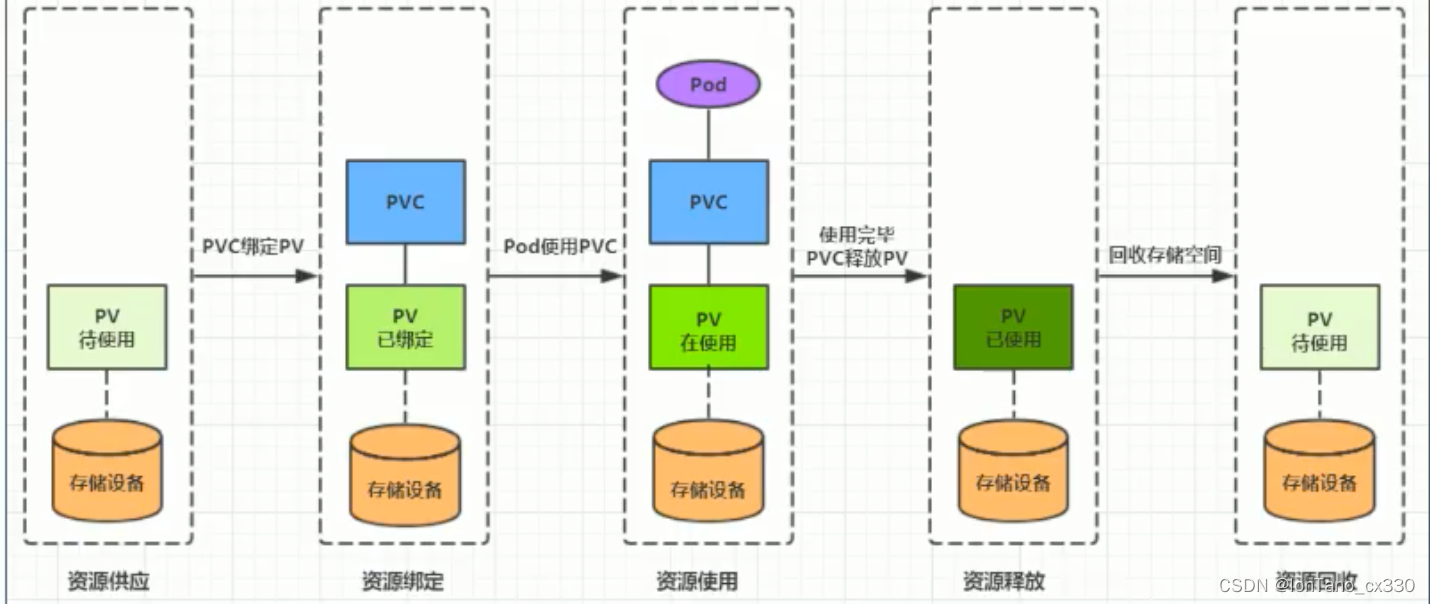

- 资源绑定:用户创建PVC, kubernetes负责根据PVC的声明去寻找PV,并绑定在用户定义好PVC之后,系统将根据PVC对存储资源的请求在己存在的PV中选择一个满足条件的

- 一旦找到,就将该PV与用户定义的PVC进行鄉定,用户的应用就可以使用这个PVC了

- 如果找不到,PVC则会无限期处于Pending状态,直到等到系统管理员创建了一个符合其要求的PV

- PV一旦鄉定到某个PVC上,就会被这个PVC独占,不能再与其他PVC进行绑定了

- 资源使用:用户可在pod中像volume一样使用PVC

Pod使用Volume的定义,将PVC挂载到容器内的某个路径进行使用 - 资源释放:用户删除PVC来释放PV

当存储资源使用完毕后,用户可以删除除PVC,与该PVC绑定的PV将会被标记为 “已释放”,但还不能立刻与其他 PVC进行绑定。通过之前PVC写入的数据可能还被留在存储设备上,只有在清除之后该PV才能再次使用。 - 资源回收:kubernetes根据pv设置的回收策略进行资源的回收

对于PV,管理员可以设定回收策路,用于设置与之绑定的PVC释放资源之后如何处理遗留数据的问题,只有 PV的存储空间完成回收,才能供新的PVC绑定和使用

配置存储

ConfigMap(cm)

ConfigMap是一种比较特殊的存储卷,它的主要作用是用来存储配置信息的。

创建configmap.yaml, 内容如下:

apiVersion: v1

kind: ConfigMap

metadata:

name: configmap

namespace: test-dev

data:

info:

username: admin

password:123456

# 创建configmap

kubectl create -f configmap.yaml

# 查看详细信息

kubectl describe cm configmap -n test-dev

接下来创建一个pod-configmap.yml,将上面创建的configmap挂载进去

apiVersion: v1

kind: Pod

metadata:

name: pod-configmap

namespace: test-dev

spec:

containers:

- name: nginx

image : nginx:1.17.1

volumeMounts: # 将configmap挂戟到目录

- name: config

mountPath: /configmap/config

volumes: # 引用configmap

- name: config

configMap:

name: configmap

# 创建pod

kubectl create -f pod-configmap.yml

# 查看pod

kubectl get pod pod-configmap -n test-dev

# 进入容器

kubectl exec -it pod-configmap -n dev /bin/sh

# cd /configmap/config

#ls

info

# more info

username: admin

password:123456

# 可以看到映射已经成功,每个configmap都映射了一个目录

#key--->文件。 value----->文件中的内容

#此时如果更新configmap的内容,容器中的值也会动态更新

kubectl edit cm configmap -n test-dev

sceret

在kubernetes中,还存在一种和ConfigMap非常类似的对象,称为Secret对象。它主要用于存储敏感信息,例 如密码、秘钥、证书等等。

1) 首先使用base64对数据进行编码

echo -n "admin" | base64 # 准备username

#YMRtaW4=

echo -n "123456" | base64 # 准备password

# MTIzNDU2

2)编写secret.yml,并创建Screte

apiVersion: v1

kind: Secret

metadata:

name: secret

namespace: test-dev

type: Opaque

data:

username: YWRtaM4=

password: MTIzNDU2

kubectl create -f secret.yml

kubectl describe secret secret -n test-dev

- 创建pod-secret.yml,将上面的secret挂载进去

apiVersion: v1

kind: Pod

metadata:

name: pod-secret

namespace: test-dev

spec:

containers:

- name: nginx

image : nginx:1.17.1

volumeMounts: # 将secret挂戟到目录

- name: config

mountPath: /secret/config

volumes: # 引用secret

- name: config

secret:

secretName: secret

# 创建pod,进入pod,就可以看到被引用过来了

cd /secret/config

ls # username 、password

718

718

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?