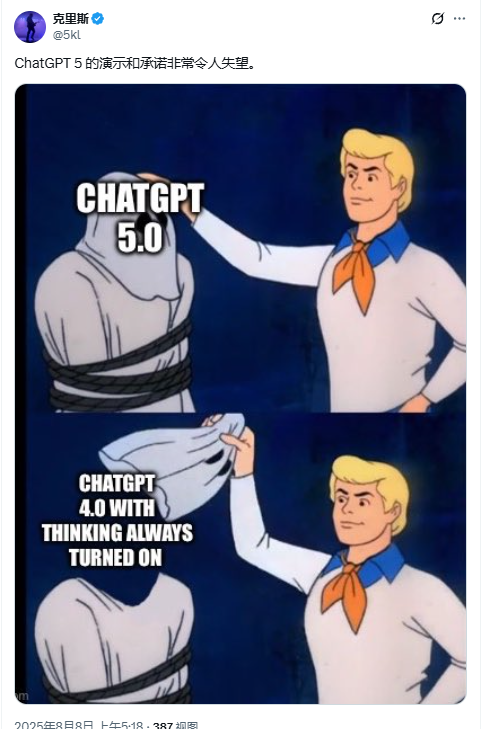

这是一次“唱反调”的冷静首发测评。从OpenAI起步的chat3.5到现在的5.0,走过了两年半的迭代,但却越来越让人失望。我们系统的梳理首日/首周的负面评论、实测反馈与公开数据,结论很直接:GPT-5 在许多关键维度没有达到“颠覆级”预期,更像是一次“更安全、更贵、更不透明”的常规升级。

先抛出结论

- 能力提升不均衡:对编码/数学有进步,但相对 o3 的幅度有限,远未到“代际碾压”。(The Register)

- “聚合式系统”体验不稳:GPT-5 本质是“一个统一系统 + 实时路由器”,会在不同子路径/推理强度间自动切换,带来不一致与不可控的体验。(The Verge, OpenAI)

- 发布会可信度翻车:官方直播图表错误(“chart crime”)被当场抓包,公信力受损。(The Verge, 金融时报)

- 安全策略更“保守”:新引入的 Safe-completions 降低了风险,但也被不少开发者吐槽更绕、更慢、更像“打太极”。(OpenAI, arXiv)

- 组织与愿景摇摆:从 Ilya Sutskever、Jan Leike 等核心安全/科研人离开开始,“产品>安全”的质疑持续发酵。(TIME, AP News)

核心证据与负面舆情

1)进步“窄”,不像宣传的那样“断层领先”

- 数学与编码:媒体与技术媒体给出的对比显示,GPT-5 对 o3 的提升多为个位数到十位数点,并非跨代飞跃;The Register 对多个数学基准的报道也是“小幅领先”。(The Register)

- 预测市场与观察者:首发当天,押注“最强模型”的市场转向了 Google;一线观察者也直言“失望或‘需要更长时间判断’”。(Platformer)

2)“统一系统 + 路由器”= 体验不稳定

- OpenAI 官方口径:GPT-5 是一个统一系统,包含快速回答模型 + 深度推理模型,由实时路由器自动决定用哪个、思考多久。(OpenAI)

- 现实吐槽:路由让普通用户“看不见也管不了”,输出同一个问题多次提交结果不同;发布会演示中也出现多次重试才出理想答案的场面。(The Verge, Tom’s Guide)

3)发布会“图表事故”,信任感受重创

- The Verge 直接点名:直播中的多张图表数值与柱状比例不一致,夸大对比效果;随后 Altman 也承认“大翻车”。金融时报专栏更将其戏称为“ChartCrimeGPT”。(The Verge, 金融时报)

4)安全机制换代= 更稳但更“缠”

- GPT-5 引入 Safe-completions(输出中心的安全训练):少“硬性拒绝”,多“边界内尽量回答”。这降低了风险,但也带来更多提示语、更多免责声明,不少专业用户并不买账——研究显示,用户对“伦理型拒答/克制”的满意度普遍更低。(OpenAI, arXiv)

5)组织层面的“信号”:从科研到商业的偏移

- 首席科学家 Ilya Sutskever 离职,其后 Jan Leike 直言“安全已让位于亮眼产品”;AGI 准备/超对齐团队的调整亦引发外界担忧。(TIME, AP News, Bloomberg.com)

- 连官方也承认:GPT-5 依然不是 AGI,离“自我学习/持续学习”还差一截。(Business Insider)

实测/口碑里的“槽点摘录”(首发阶段)

- 指令遵循变差(部分场景):一线测评者称 GPT-5 在精准听令上不如预期,“得非常小心写提示”。(X (formerly Twitter))

- 前端/UI 工作流并非唯一最强:开发者社区反馈,近期 Claude Opus 4.1 在 UI/UX 与前端上更稳定;GPT-5 倾向“过度思考、写多余脚本”。(Reddit)

- 写作/风格:有资深用户称 4.5/其他家在语气、幽默与说服力上依然更好。(X (formerly Twitter))

注:上面均为公开首发体验,长期表现仍待观察,但“首日口碑”本就决定了这代是否“惊艳”。目前看,不惊艳。

为什么说 GPT-5 不及格

| 维度 | 现象 | 影响 | 依据/来源 |

|---|---|---|---|

| 可信度 | 发布会图表错误、叙事夸张 | 高 | The Verge、FT 报道与更正。(The Verge, 金融时报) |

| 代际跃迁 | 对 o3 的增益多为小幅领先,并非断层 | 高 | The Register 基准解读、市场/观察者“失望”。(The Register, Platformer) |

| 一致性 | 路由/聚合导致同题多解、用户不可控 | 高 | 官方“统一系统+实时路由”与现场多次重试。(OpenAI, Tom’s Guide) |

| 可用性 | Safe-completions 更稳但更绕、满意度受损 | 中 | OpenAI 论文与用户偏好研究。(OpenAI, arXiv) |

| 组织与战略 | 核心科学/安全人离职,外界质疑“产品压倒安全” | 中 | Ilya/Leike 离职与言论、团队调整。(TIME, AP News, Bloomberg.com) |

| 透明度/成本 | 训练数据仍不透明;Pro 200 美元/月门槛高;API 单价不低 | 中 | 不披露训练数据、Pro 定价与 API 定价页。(The Verge, OpenAI) |

综上:不及格点在“信任+一致性+真实跃迁幅度”,这三项决定了“颠覆感”的强弱。

开发者怎么自救:用“多云/多模型路由”替代“单押 GPT-5”

对于国内团队,最稳妥的做法是:A/B 对比 + 自动降级。把 GPT-5 与 Claude Opus 4.1、Gemini 2.5 Pro、Qwen3 系放在同一套路由中,同一提示词跑多家,谁稳用谁,并在超时/异常时自动切换。这比把生产全押在“统一系统 + 黑箱路由”的 GPT-5 上要可靠得多。

使用 胜算云 API 网关 聚合全球主流大模型(无需折腾外币与合规接入),同一 API 调用即可一键切换/并发对比,并能按价格/延迟/成功率设置权重与并发上限,生产更稳。

示例

POST https://api.shengsuanyun.com/v1/chat/completions

{

"model": "auto", // 由网关按权重选择:gpt-5 / claude-opus-4.1 / gemini-2.5-pro / qwen3

"fallbacks": ["claude-opus-4.1", "gemini-2.5-pro", "gpt-5"],

"routing": { "max_latency_ms": 2000, "prefer_reasoning": true },

"messages": [{ "role": "user", "content": "用 React 写一个带登录表单的前端并解释关键安全点" }]

}

落地建议(极简版)

- 先做你们自己的 SWE-bench/前端样例集,同题跑 3–4 家,记录正确率、迭代步数、总代价。

- 线上启用灰度路由:新需求先交给成本最低且近 7 天稳定的模型,难题再切 GPT-5/Reasoning。

- 把“可解释性”作为 SLO:记录每次失败的原因与重试路径(是模型拒答?路由误判?提示不稳?)。

OpenAI 还强,但“颠覆”不再只靠它

连官方都承认 GPT-5 不是 AGI;市场不再把“最强模型”的位置自动留给 OpenAI;发布会“图表事故”也伤了元气。今天的 GPT-5,确实更快、更稳、也更保守,但离“颠覆时代”那口气还差很多。(Business Insider, Platformer, The Verge)

1479

1479

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?