此文章是本人结合课程内容和网上资料整理,难免有误差,请给参考。

另外我发现两个规律:

1、课后题的关键字在课件里面都找不到,或者课件的叫法和题目叫法不一致。因此看会了课件不一定会这些题

2、课后题和考试题差异很大,会了课后题考试也一样蒙。大家有什么好的办法,请留言分析一下。

下面是第七章我整理的复习资料。

1、C4.5算法在构造决策树时使用的分裂属性是( )。

A信息增益

B信息增益率

C基尼指数

D不纯度降低值

2、下两种描述分别对应的分类算法的评价标准是( )。

(a)警察抓小偷,描述警察抓的人中有多少个是小偷的标准。

(b)描述有多少比例的小偷给警察抓了的标准。

APrecision, Recall

BRecall, Precision

CPrecision, ROC

DRecall, ROC

3、决策树中不包含的下列结点是( )。

A根结点(root node)

B内部结点(internal node)

C外部结点(external node)

D叶结点(leaf node)

4、以下算法属于基于规则的分类器的是( )。

AC4.5

BKNN

CNaive Bayes

DANN

5、以下关于随机森林算法的分析中错误的是( )

A随机森林算法的基本思想是构造多棵决策树,共同决策输出类别

B随机森林算法是单一决策树算法的延伸和改进

C在构建决策树的过程中需要剪枝

D整个森林的树的数量和每棵树的特征需要人为进行设定

6、下列哪些是分类与预测的不同之处( )。

A分类的作用是构造一系列能描述和区分数据类型或概念的模型

B分类被用作预测目标数据的类的标签

C预测是建立一个模型去预测缺失的或无效的并且通常是数字的数据值

D预测典型的应用是预测缺失的数字型数据的值

7、冗余属性的问题会影响决策树的准确率。 错

8、当一个数据对象同时属于多个类时,很难评估分类的准确率。通常在这种情况下,我们选择的分类器一般趋向于含有这样的特征:最小化计算开销,即使给予噪声数据或不完整数据也能准确预测,在大规模数据下仍然有效工作,提供简明易懂的结果。 正确

9、分类规则的挖掘方法通常有:决策树法、贝叶斯法、人工神经网络法、粗糙集法和遗传算法。正确

10、决策树是用样本的属性作为树的结构,用样本属性的取值作为树分支的结点。 错误

11、ID3算法无法避免过拟合问题,而C4.5算法则可以避免。错误

12、ID3算法在分裂节点处将信息增益作为分裂准则进行特征选择,递归地构建决策树。正确

13、为了避免决策树的欠拟合现象,提出随机森林算法。错误

14、下列是有关于是否投保的数据集,第二列至第四列为特征,表中最后一列类别代表是否投保,按照“年薪”进行划分的信息增益率为( )

AA.0.061; BB.0.327;CC.0.485; DD.0;

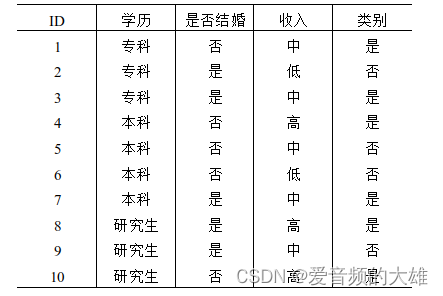

14、考虑下表中的数据集,使用贝叶斯分类预测记录X=(有房=否,婚姻状况=已婚,年收入=120k)的类标号( )

AYes; BB. No;C Yes or No; D 不确定;

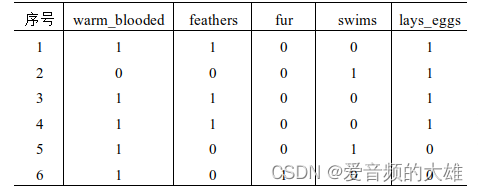

15、下表给出了一个关于动物类别的训练数据。数据集包含5个属性:warm_blooded、feathers、fur、swims、lays_eggs。 若样本按warm_blooded划分,对应的熵为( )

AA.0.809; B 0.819; C 0.609;D 0.619;

备注:这个题目我没算明白,网上很多出处都是A,我也裂成了A,我计算数值应该是0.65

16、下列是有关于是否购买电脑的数据集,其中学历,是否结婚,收入为特征,表中最后一列类别代表是否购买电脑,则数据集的信息熵为( )

A. 0.254; B. 0.376;C. 0.971;D 0.865;

17、决策树分类的主要包括( )

A对数据源进行OLAP, 得到训练集和测试集

B对训练集进行训练;

C对初始决策树进行树剪枝;

D由所得到的决策树提取分类规则;

E使用测试数据集进行预测,评估决策树模型;

18、下列哪些是朴素贝叶斯分类的优缺点( )

A朴素贝叶斯分类做了类条件独立假设,大幅降低了计算开销;

B需要大量训练数据以覆盖类条件概率空间,引入了很大开销;

C容易实现并在大多数情况下可以取得较好的结果;

D类条件独立在实际应用中缺乏准确性,因为变量之间经常存在依赖关系,这种依赖关系影响了朴素贝叶斯分类器的准确性;

19、贝叶斯信念网络(BBN)有哪些特点( )

A构造网络费时费力;

B对模型的过分问题非常鲁棒;

C有效地避免过拟合;

D 最小化计算开销;

20、给定决策树,选项有:(1)将决策树转换成规则,然后对结果规则剪枝;(2)对决策树剪枝,然后将剪枝后的树转换成规则。相对于选项(1),选择(2)的优点是更能泛化规则。 错

21、给定数据集 D,具有 m 个属性和 |D| 个训练记录,决策树生长的计算时间最多为m×D ×log(|D|)。 正确

22、朴素贝叶斯假设属性之间是相互独立的。 正确

23、随机森林算法过程中只有一个随机过程,即每棵决策树的构建所需的特征是从整体特征集中随机选取的。 错误

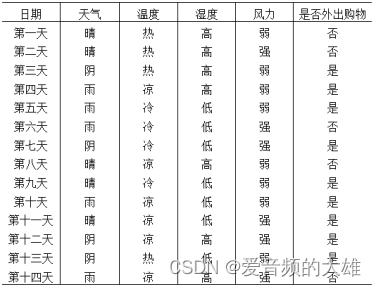

24、下表为两周内天气与外出购物的数据集,利用朴素贝叶斯分类预测天气情况为(天气=晴,温度=冷,湿度=高,风力=强)时的结果为不会外出购物。 正确

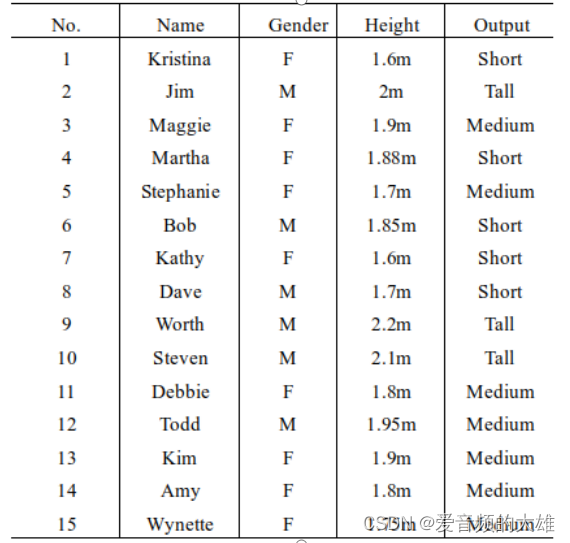

25、下面的例子被分为3类:{Short,Tall,Medium},Height属性被划分为(0,1.6),(1.6,1.7),(1.7,1.8),(1.8,1.9),(1.9,2.0),(2.0,∞),根据下表,对于t=<Adam,M,1.95m>用贝叶斯分类方法进行分类,则最终结果为( )

AA. Short;

BB. Tall;

CC. Medium;

DD. None;

26、分类模型的误差包括( )。

A聚集误差

B泛化误差

C数值误差

D集成误差

27、下面的数据集包含两个属性X和Y,两个类标号"+"和"-"。每个属性取三个不同的值: 0, 1或2。"+"类的概念是Y=1, "-"类的概念是X=0或X=2。则由表构建的决策树的F1值(对"+"类定义)是( )。

| X | Y | 实例数 | |

| + | - | ||

| 0 | 0 | 0 | 100 |

| 1 | 0 | 0 | 0 |

| 2 | 0 | 0 | 100 |

| 0 | 1 | 10 | 100 |

| 1 | 1 | 10 | 0 |

| 2 | 1 | 10 | 100 |

| 0 | 2 | 0 | 100 |

| 1 | 2 | 0 | 0 |

| 2 | 2 | 0 | 100 |

A0.33

B0.5

C0.97

D1

28、支持向量机模型包括

A线性可分支持向量机

B线性支持向量机

C非线性可分支持向量机

D非线性支持向量机

29、贝叶斯信念网络(BBN)有哪些特点( )

A构造网络费时费力

B对模型的过分问题非常鲁棒

C有效地避免过拟合

D最小化计算开销

30、 当一个数据对象同时属于多个类时,很难评估分类的准确率。通常在这种情况下,我们选择的分类器一般趋向于含有这样的特征:最小化计算开销,即使给予噪声数据或不完整数据也能准确预测,在大规模数据下仍然有效工作,提供简明易懂的结果。正确

32、用于分类的离散化方法之间的根本区别在于是否使用类信息。正确

33、对于SVM分类算法,待分样本集中的大部分样本不是支持向量,移去或者减少这些样本对分类结果没有影响。正确

34、分类和回归都可用于预测,两者的区别在于分类的输出是离散的类别值,而回归的输出是连续数值.正确

35、逻辑回归算法属于回归算法。错误

36、随机森林算法过程中只有一个随机过程,即每棵决策树的构建所需的特征是从整体特征集中随机选取的。错误

37、某苹果数据集如下所示, K近邻分类法(K取3)对(色度=8.8,高度=7.1,宽度=7.0)的苹果进行分类的结果为( )

AA.绿苹果;

BB.布瑞本;

CC.金冠苹果;

DD.绿苹果或布瑞本;

38、考虑下表中的一维数据集,根据 1-最近邻、3-最近邻、5-最近邻、9-最近邻,对数据点 x=5.0分类,使用多数表决( )

![]()

AA. -、+、-、+;

BB. +、+、-、-;

CC. -、-、+、+;

DD. +、-、+、-;

解析:

1-最近邻:+

3-最近邻:-

5-最近邻:+

9-最近邻:-

39、下面的例子被分为3类:{Short,Tall,Medium},Height属性被划分为(0,1.6),(1.6,1.7),(1.7,1.8),(1.8,1.9),(1.9,2.0),(2.0,∞),根据下表,对于t=<Adam,M,1.95m>用贝叶斯分类方法进行分类,则最终结果为( )

AA. Short;

BB. Tall;

CC. Medium;

DD. None;

解析:

标号类属性Output具有3个不同值{short,Tall,Medium}。设C1对应于类Output=“short”,C2对应于类Output=“Medium”,C3对应于类Output=“Tall”。希望分类的未知样本t=<Adam,M,1.95m>,因此需要最大化P(X|Ci)P(Ci),i=1,2,3。

每个类的先验概率P(Ci)可以根据训练样本计算:

P(Output=“short”)=4/15=0.267

P(Output=“Medium”)=8/15=0.533

P(Output=“Tall”)=3/15=0.200

为计算P(X|Ci),i=1,2,3,计算下面的条件概率:

P(Gender=“M”| Output=“short”)=1/4=0.25

P(Gender=“M”| Output=“Medium”)=2/8=0.25

P(Gender=“M”| Output=“Tall”)=3/3=1

P(Height=(1.9,2.0]| Output=“short”)=0/4=0

P(Height=(1.9,2.0]| Output=“Medium”)=1/8=0.125

P(Height=(1.9,2.0]| Output=“Tall”)=1/3=0.33

假设条件独立性,使用以上概率,得到:

P(X| Output=“short”)=0.25×0=0

P(X| Output=“Medium”)=0.125×0.125=0.0313

P(X| Output=“Tall”)=1×0.33=0.33

P(X| Output=“short”)P(Output=“short”)=0×0.267=0

P(X| Output=“Medium”)P(Output=“Medium”)=0.0313×0.533=0.0167

P(X| Output=“Tall”)P(Output=“Tall”)=0.33×0.2=0.066

因此,对于样本t=<Adam,M,1.95m),朴素贝叶斯分类预测Output=“Tall”。

40、某二分类问题的训练样本如下表所示,由此计算得的属性类别的Gini指标值为( )。

| ID | 学历 | 是否结婚 | 收入 | 类别 |

| 1 | 专科 | 否 | 中 | 是 |

| 2 | 专科 | 是 | 低 | 否 |

| 3 | 专科 | 是 | 中 | 是 |

| 4 | 本科 | 否 | 高 | 是 |

| 5 | 本科 | 否 | 中 | 否 |

| 6 | 本科 | 否 | 低 | 否 |

| 7 | 本科 | 是 | 中 | 是 |

| 8 | 研究生 | 是 | 高 | 是 |

| 9 | 研究生 | 是 | 中 | 否 |

| 10 | 研究生 | 否 | 高 | 是 |

A0.3

B0.48

C0.5

D0.7

解析:混淆矩阵为

准确率:(10+600)/(10+20+600)=0.9683

精度:10/10=1

召回率:10/(10+20)=0.3333

F1值:(2*0.3333*1)/(1+0.3333)=0.5

41、以下关于随机森林算法的分析中错误的是( )。

A随机森林算法的基本思想是构造多棵决策树,共同决策输出类别

B随机森林算法是单一决策树算法的延伸和改进

C在构建决策树的过程中需要剪枝

D整个森林的树的数量和每棵树的特征需要人为进行设定

42\KNN的主要思想是计算每个训练数据(每个训练数据都有一个唯一的类别标识)到待分类元祖的距离,取和待分类元祖距离最近的k个训练数据集,k个数据中哪个类别的训练数据占多数,则待分类元祖就属于那个类别。正确。

43、用于分类的离散化方法之间的根本区别在于是否使用类信息。正确

44、对于SVM分类算法,待分样本集中的大部分样本不是支持向量,移去或者减少这些样本对分类结果没有影响。正确

45、分类和回归都可用于预测,两者的区别在于分类的输出是离散的类别值,而回归的输出是连续数值.正确

46、惰性学习法的“惰性”体现在它不急于在收到测试对象之前构造分类模型。

正确

47、K近邻算法中K的取值对结果不会产生较大的影响。错误

48、随着训练对象数量趋向无穷,如果K同时也趋向无穷,K近邻分类器的错误率会渐进收敛到贝叶斯错误率。正确

3330

3330

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?