大数据平台搭建(技能竞赛)

安装JDK

解决基础命令无法使用

export PATH=/bin:/usr/local/sbin:/usr/local/bin:/sbin:/bin:/usr/sbin:/usr/bi

将jdk的安装包解压到某路径

tar -zxvf jdk安装包 -C 路径

修改jdk环境变量

vi /root/.bash_profile

export JAVA_HOME=jdk安装路径

export CLASSPATH=JAVA_HOME/lib/

export PATH=$PATH:$JAVA_HOME/bin

生效环境变量

source /root/.bash_profile

将jdk分发给slave1,slave2

scp -r jdk root@主机名:/路径

将环境变量分发给slave1,slave2

配置免密

master: ssh-keygen -t rsa

master: ssh-copy-id 主机名

HADOOP(完全分布式)

解压hadoop包到某路径

tar -zxvf hadoop~ -C 解压路径

编辑环境变量

vi /root/.bash_profile

修改配置文件(hadoop-env.sh)

export JAVA_HOME=jdk安装路径

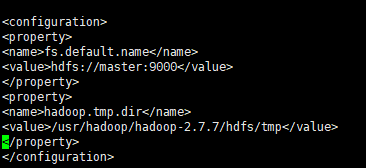

修改配置文件(core-site.xml)

修改配置文件(hdfs-site.xml)

修改配置文件(yarn-env.sh)

export JAVA_HOME=jdk安装路径

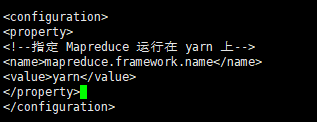

修改配置文件(mapred-site.xml)

修改配置文件(yarn-site.xml)

编辑master和slaves文件

echo master >> master

echo slave1 >> slaves

exho slave2 >> slaves

格式化namenode(master)

hadoop namenode -format

ZOOKEEPER

解压zookeeper安装包

tar -zxvf zookeeper~ 路径

修改环境变量

export ZOOKEEPER_HOME=路径

export PATH=$PATH:$ZOOKEEPER_HOME/bin

修改zookeeper文件

进入zookeeper/conf下

将zoo.sample.cfg复制为zoo.cfg

vi zoo.cfg

在zookeeper下创建zkdata,zkdatalog

创建myid文件

进入zkdata分别在不同主机的myid文件中写入1,2,3

启动/查看/关闭zookeeper节点

zkServer.sh start

zkServer.sh status

zkServer.sh stop

Flink on Yarn

解压flink安装包

tar -zxvf flink~ -C 解压路径

配置环境变量

export FLINK_HOME=解压路径

export PATH=$PATH:$FLINK_HOME/bin

配置conf文件

在slaves中写入从节点的主机名

编辑flink-conf.yaml

vi conf/flink-conf.yaml

设置jobmanager.rpc.address 配置项为该节点的IP 或者主机名

jobmanager.rpc.address: 10.108.4.202

启动flink集群:

./bin/start-cluster.sh

启动节点

start-cluster.sh

Spark 集群搭建

解压spark

tar -zxvf spark~ 路径

修改环境变量

export SPARK_HOME=路径

export PATH=$PATH:$SPARK_HOME/bin

配置spark文件

修改spark-env.sh

export SCALA_HOME=spark路径

export JAVA_HOME=jdk路径

export HADOOP_HOME=hadoop路径

export HADOOP_CONF_DIR=Hadoop—conf路径

SPARK_MASTER_IP=主机名

SPARK_HOME=spark路径

SPARK_DIRVER_MEMORY=运行内存

将spark分发至其他节点

scp -r spark路径 root@主机名:/路径

scp -r spark路径 root@主机名:/路径

kafka集群搭建

解压kafka操作

tar -zxvf kafka~ 路径

修改环境变量

export KAFKA_HOME=路径

export PATH=$PATH:$FLINK_HOME/bin

修改配置文件

进入config中,修改配置文件

vim server.properties

broker.id=0(三台虚拟机不想同)

zookeeper.connect=master:2181,slave1:2181,slave2:2181

delete.topic.enable=true

host.name=master(改成对应节点)

启动/关闭节点(先启动zookeeper节点):

bin/kafka-server-start/stop.sh -daemon config/server.properties(静默启动)

Flume集群搭建

解压flume

tar -zxvf flume~ 路径

配置flume环境变量

export FLUME_HOME=路径

export PATH=$PATH:$FLUME_HOME/bin

修改配置文件

修改flume-env.sh

将flume-env.sh.template修改为flume-env.sh

写入export JAVA_HOME=路径

编辑slave.conf文件(master,slave1,slave2)

#主要作用是监听目录中的新增数据,采集到数据之后,输出到avro (输出到agent)

#注意:Flume agent的运行,主要就是配置source channel sink

#下面的a1就是agent的代号,source叫r1 channel叫c1 sink叫k1

a1.sources = r1

a1.sinks = k1

a1.channels = c1

#具体定义source

a1.sources.r1.type = spooldir

#先创建此目录,保证里面空的

a1.sources.r1.spoolDir = /logs

#对于sink的配置描述 使用avro日志做数据的消费

a1.sinks.k1.type = avro

#hostname是最终传给的主机名称或者ip地址

a1.sinks.k1.hostname = master

a1.sinks.k1.port = 44444

#对于channel的配置描述 使用文件做数据的临时缓存 这种的安全性要高

a1.channels.c1.type = file

a1.channels.c1.checkpointDir = /home/uplooking/data/flume/checkpoint

a1.channels.c1.dataDirs = /home/uplooking/data/flume/data

#通过channel c1将source r1和sink k1关联起来

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1

bin/flume-ng agent --conf conf/ --name a1 --conf-file job/flume-telnet-logger.conf -Dflume.root.logger=INFO,console

编辑master.sh文件(master)

#获取slave1,2上的数据,聚合起来,传到hdfs上面

#注意:Flume agent的运行,主要就是配置source channel sink

#下面的a1就是agent的代号,source叫r1 channel叫c1 sink叫k1

a1.sources = r1

a1.sinks = k1

a1.channels = c1

#对于source的配置描述 监听avro

a1.sources.r1.type = avro

#hostname是最终传给的主机名称或者ip地址

a1.sources.r1.bind = master

a1.sources.r1.port = 44444

#定义拦截器,为消息添加时间戳

a1.sources.r1.interceptors = i1

a1.sources.r1.interceptors.i1.type = org.apache.flume.interceptor.TimestampInterceptor$Builder

#对于sink的配置描述 传递到hdfs上面

a1.sinks.k1.type = hdfs

#集群的nameservers名字

#单节点的直接写:hdfs://主机名(ip):9000/xxx

#ns是hadoop集群名称

a1.sinks.k1.hdfs.path = hdfs://ns/flume/%Y%m%d

a1.sinks.k1.hdfs.filePrefix = events-

a1.sinks.k1.hdfs.fileType = DataStream

#不按照条数生成文件

a1.sinks.k1.hdfs.rollCount = 0

#HDFS上的文件达到128M时生成一个文件

a1.sinks.k1.hdfs.rollSize = 134217728

#HDFS上的文件达到60秒生成一个文件

a1.sinks.k1.hdfs.rollInterval = 60

#对于channel的配置描述 使用内存缓冲区域做数据的临时缓存

a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000

a1.channels.c1.transactionCapacity = 100

#通过channel c1将source r1和sink k1关联起来

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1

启动测试(关闭防火墙)

bin/flume-ng agent -n a1 -c conf -f conf/master.conf -Dflume.root.logger=INFO,console

1051

1051

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?