第一步,新建maven工程,配置pom.xml(配置依赖时,要注意spark版本的对应,在最后说明)

<dependencies>

<!-- https://mvnrepository.com/artifact/org.scala-lang/scala-library -->

<dependency>

<groupId>org.scala-lang</groupId>

<artifactId>scala-library</artifactId>

<version>2.12.4</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_2.12</artifactId>

<version>2.4.4</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-streaming_2.12</artifactId>

<version>2.4.4</version>

</dependency>

<dependency>

<groupId>com.github.scopt</groupId>

<artifactId>scopt_2.12</artifactId>

<version>3.5.0</version>

</dependency>

</dependencies>

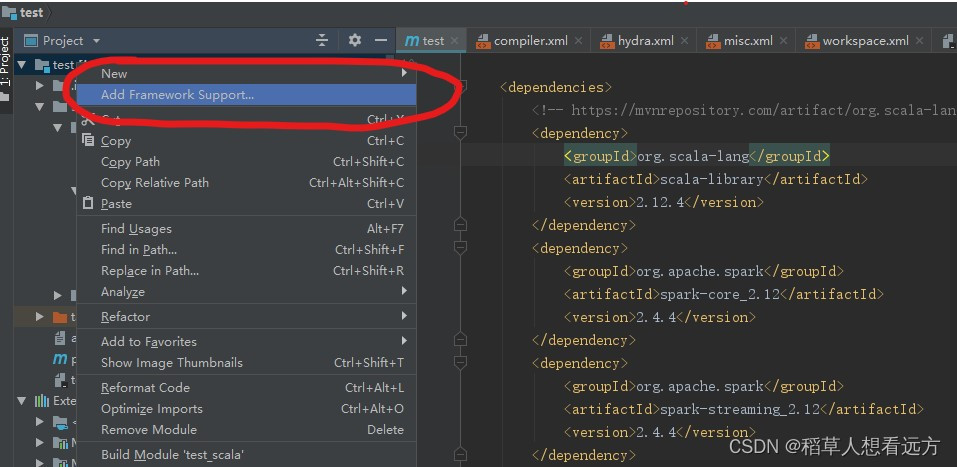

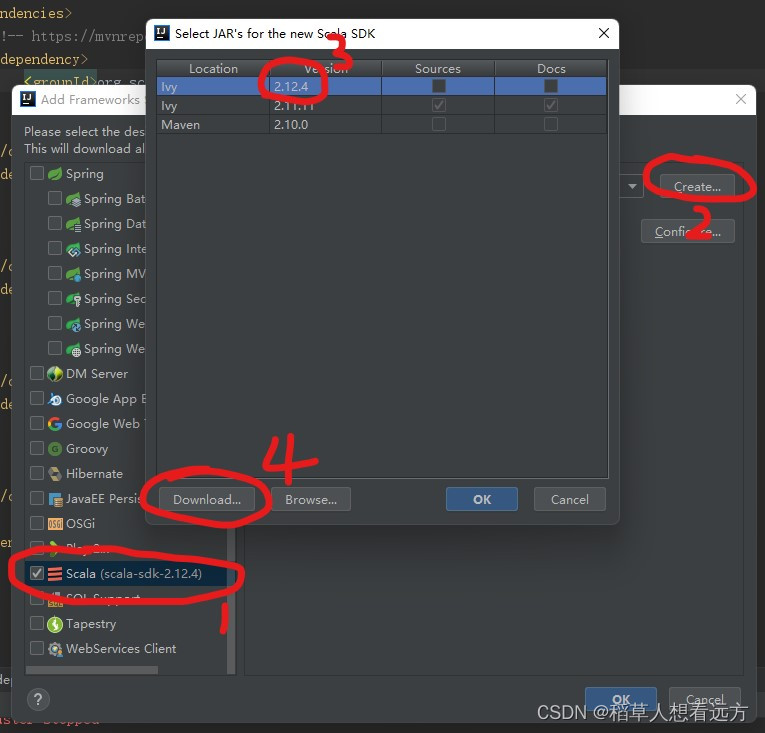

第二步,在idea上下载scala-sdk。(2.12.4)(如果已经添加了就不用再添加)

点击 Add Framework Support

选择Scala,点击Create,选择2.12.4版本,最后点击DownLoad下载

第三步,开启spark

首先cd命令进入spark所在的目录。

然后启动spark,命令为

bin/spark-shell图示即为启动成功

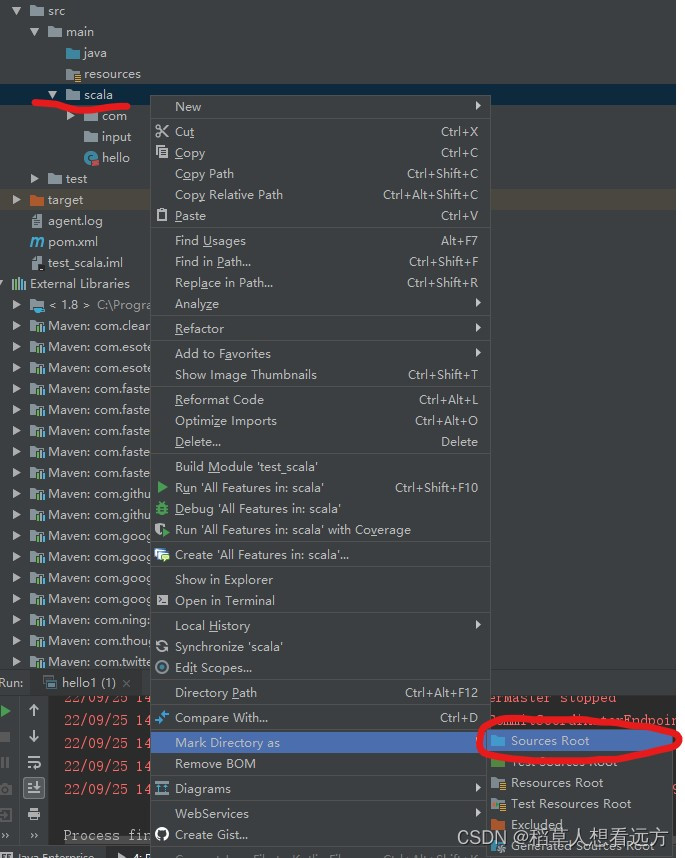

第四步,在main下新建scala文件夹,并设置成为Source Root

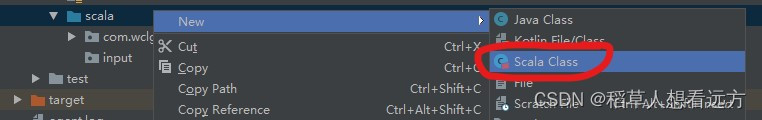

第五步,新建scala文件

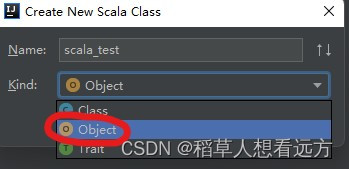

右键scala文件夹,new中找到Scala Class并点击

随便取一个名称,Kind里面选择Object,然后ok即创建成功

第六步,创建启动环境

在刚刚新建的scala文件中输入代码:(注意 object 后面的对象名字,和scala的文件名称保持一致)

import org.apache.spark.{SparkConf, SparkContext} //import spark包

object scala_test {

def main(args: Array[String]): Unit = {

//1.初始化spark配置信息并建立与spark的连接

val sparkConf = new SparkConf().setMaster("local[*]").setAppName("bigdata01")

val sc = new SparkContext(sparkConf)

val rdd = sc.parallelize(Array(1,2,3)) //创建rdd

rdd.collect().foreach(println) //输出rdd

sc.stop() //关闭与spark的连接,必须关闭,否则无输出结果

}

}运行此代码,会自动创建一个启动环境。

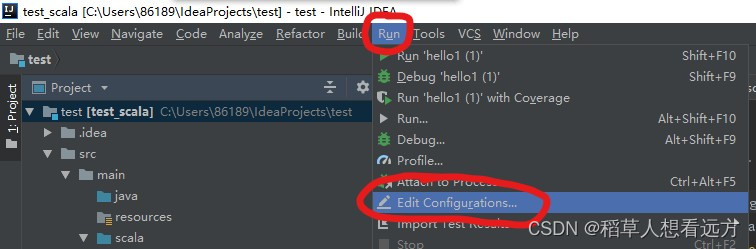

第七步,在idea中添加连接spark的启动环境

选择Run,点击 Edit Configurations

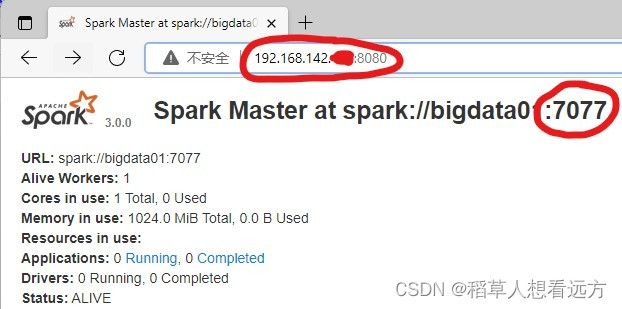

在Vm options里添加-Dspark.master=spark://spark所在的电脑ip地址:端口号 ,这里的IP地址和端口可以在启动spark后,通过浏览器访问spark界面得到,一般访问spark页面的路径为 ip:8080 或者 ip:8081

可以从spark的页面中得到连接端口,我的为7077端口

得到端口便在VM options中输入 -Dspark.master=spark://spark所在的电脑ip地址:端口号

设置完成后点击 Apply 即可(若在web端页面找不到端口,直接填写4040端口)

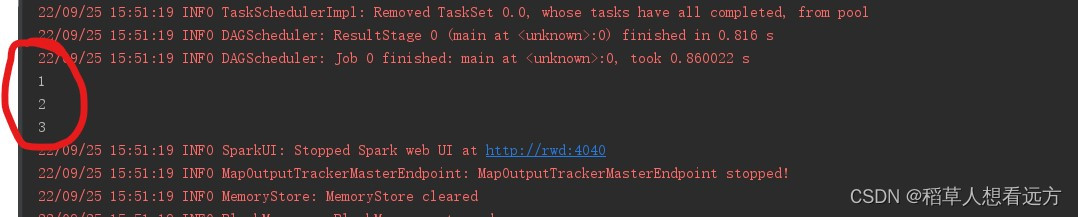

第八步,测试scala是否搭建成功

在刚刚新建的scala文件中输入代码:(注意 object 后面的对象名字,和scala的文件名称保持一致)

如果输出了1,2,3,那就代表连接spark成功,也可以在此文件中进行rdd编程

851

851

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?