0.引言

Ollama是一个支持在本地快速部署大模型服务的解决方案。

Ollama的核心能力主要包括两个,可以让用户轻松在本地部署大模型服务,目前已经支持了很多开源的大模型,下面介绍一下Ollama的安装使用教程。

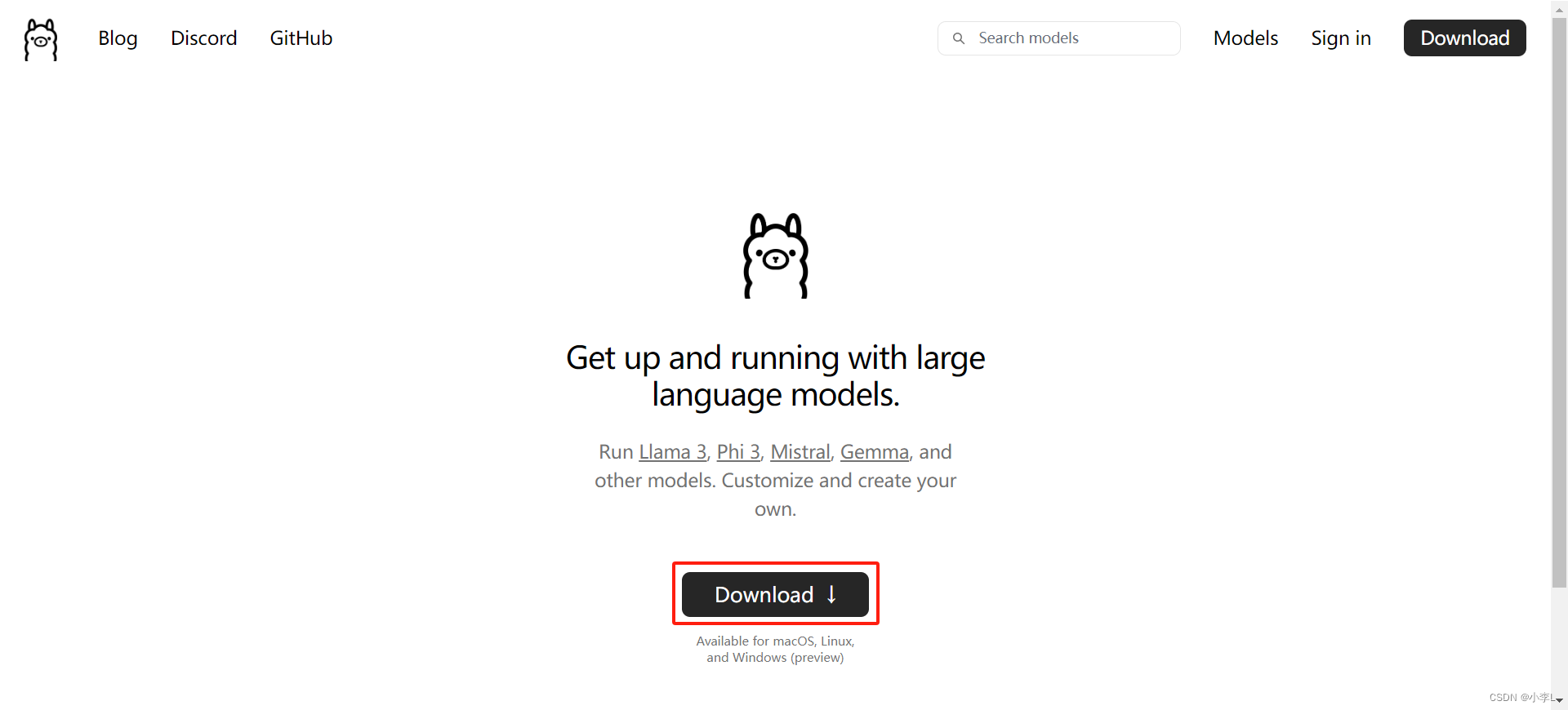

1.下载安装Ollama

访问Ollama官网进行下载:Ollama

安装过程不在赘述了,很简单的。

2.配置环境变量

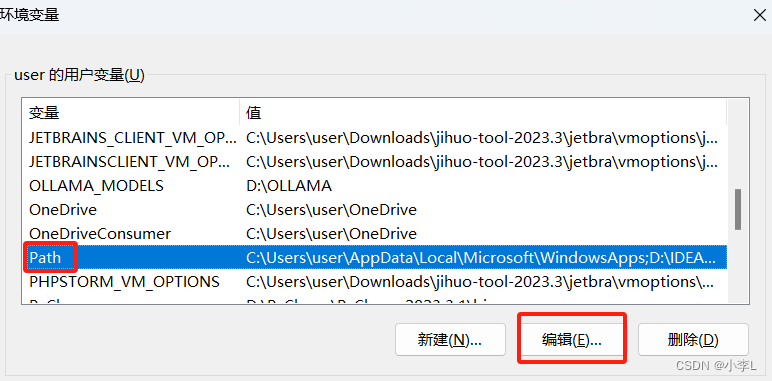

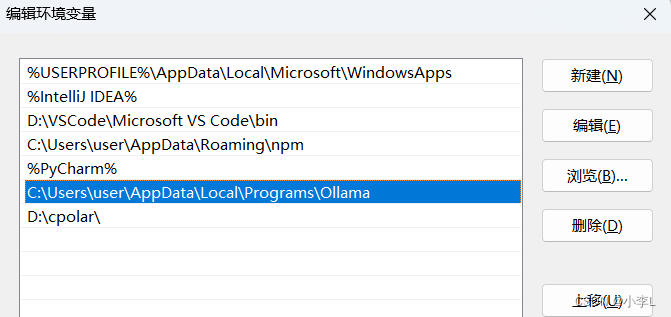

在用户环境变量的Path下,看一下有没有Ollama的安装位置的环境变量,没有新建一个,有就不用管了,我忘记了这个环境变量是不是自动添加的了。

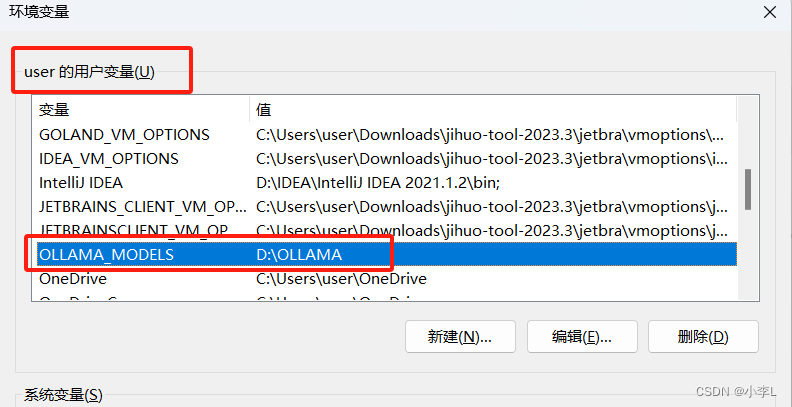

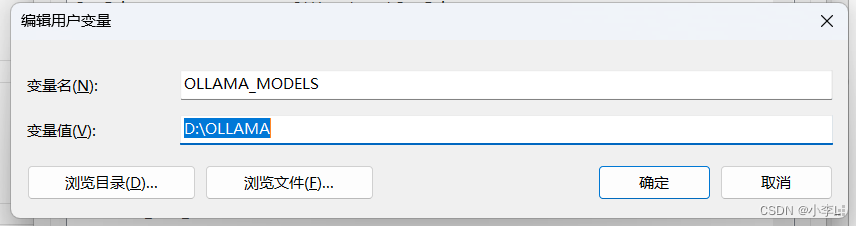

OLLAMA_MODELS:这个变量指定了模型镜像的存储路径。通过设置OLLAMA_MODELS=D:\OLLAMA,我们可以将模型镜像存储在D盘,避免C盘空间不足的问题。

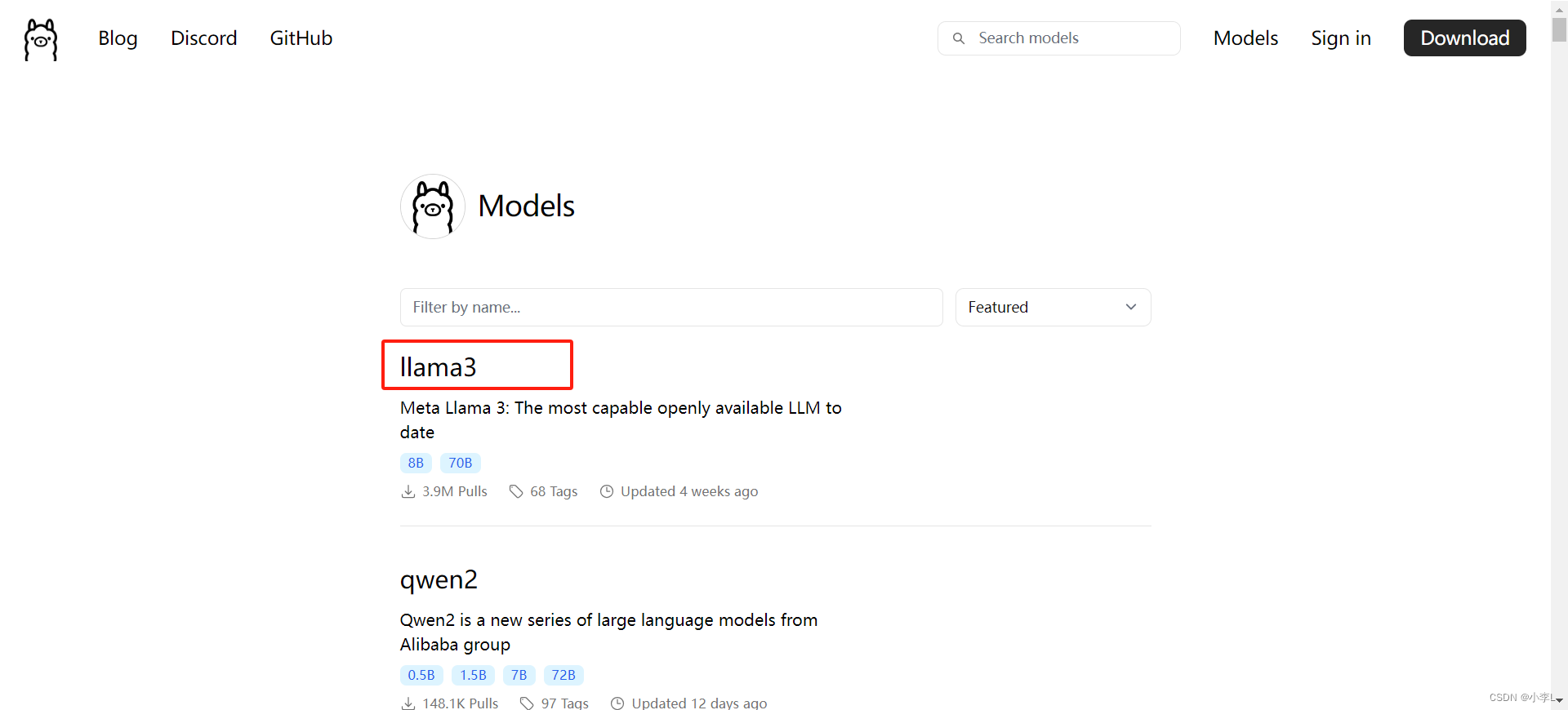

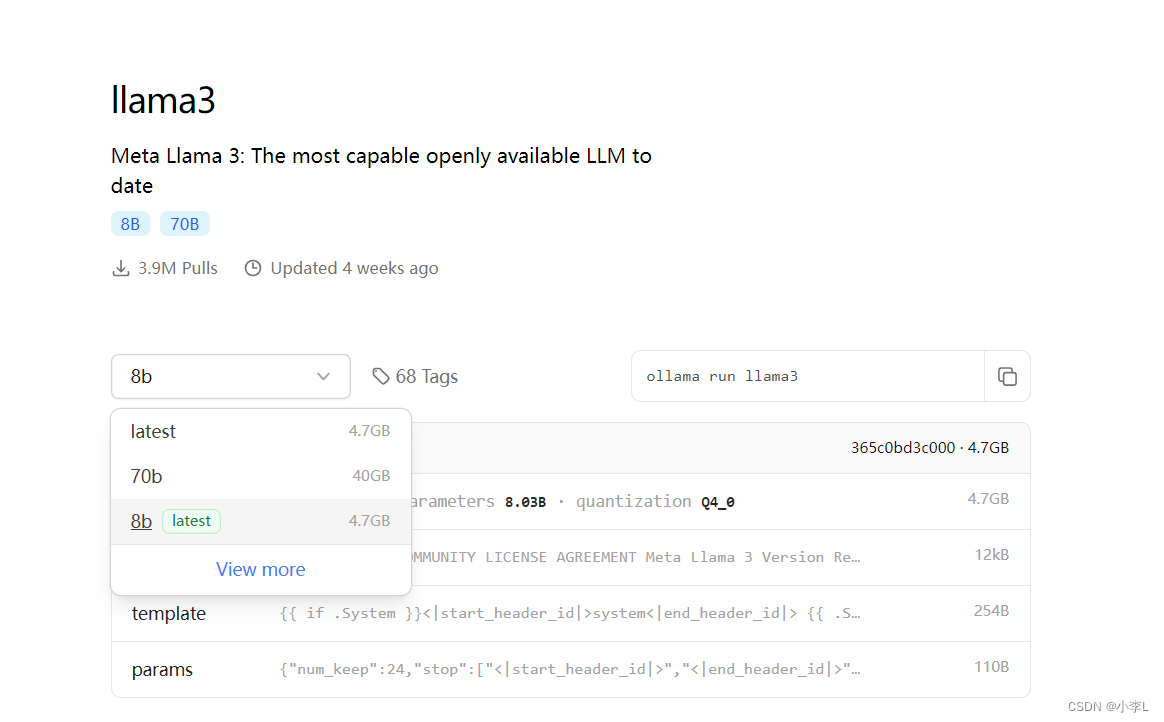

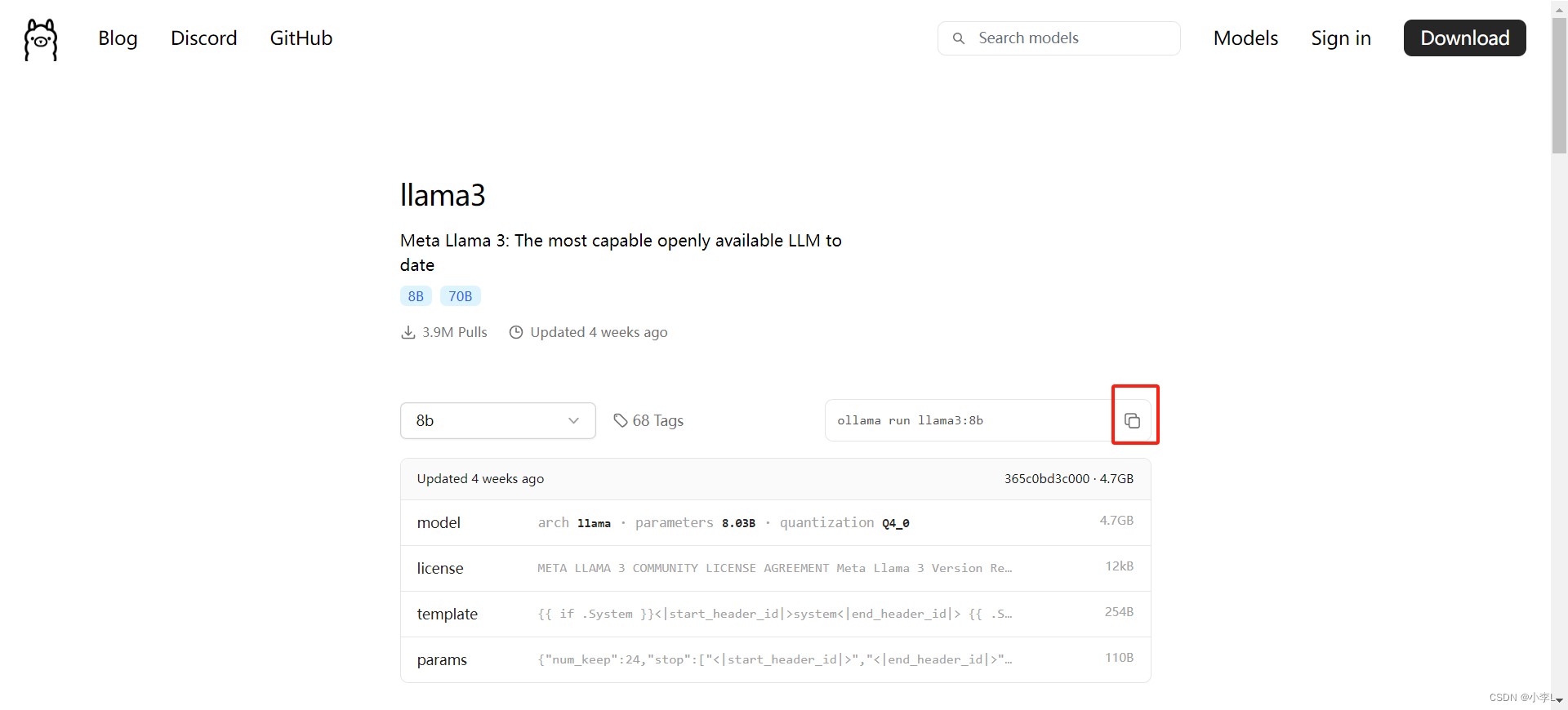

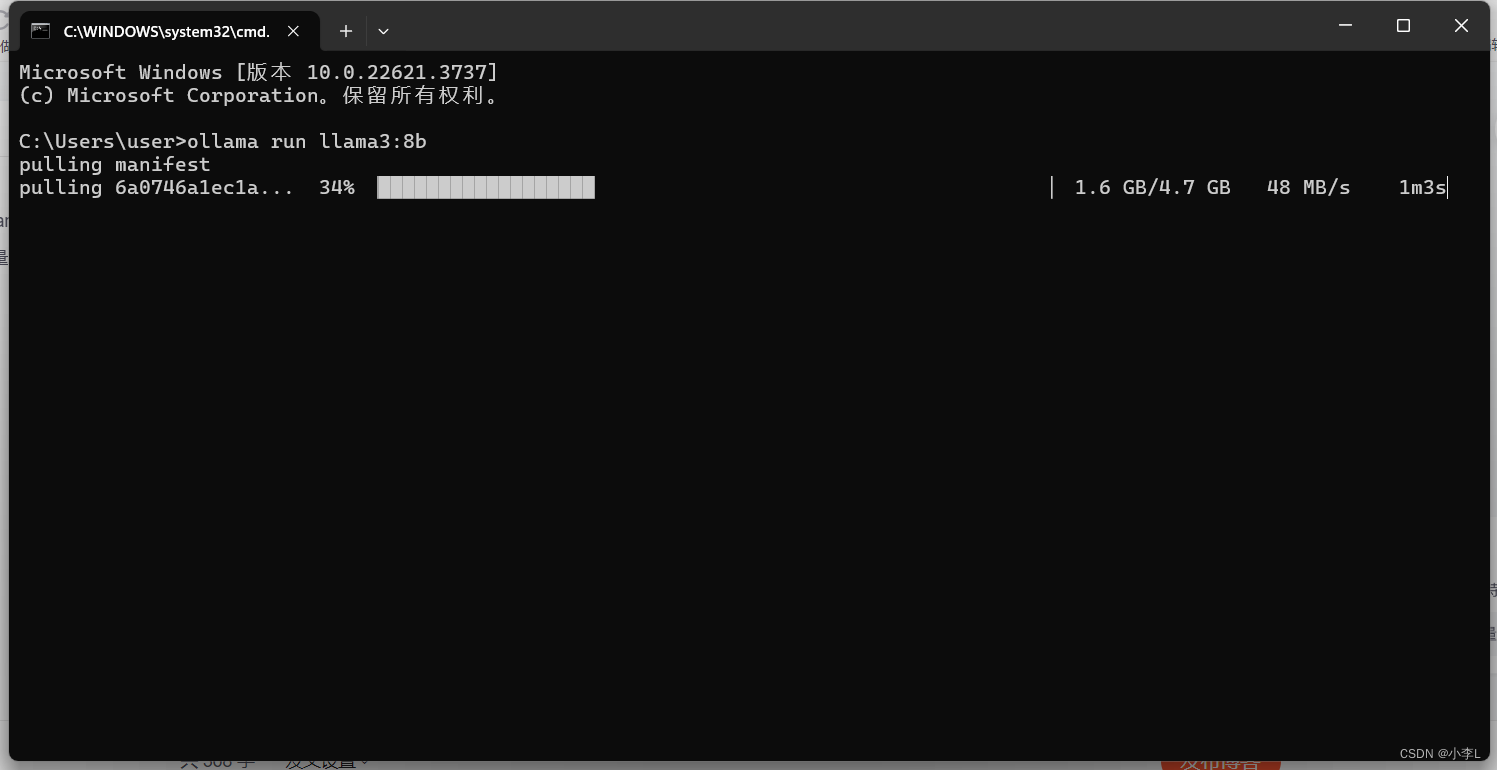

3.拉取模型

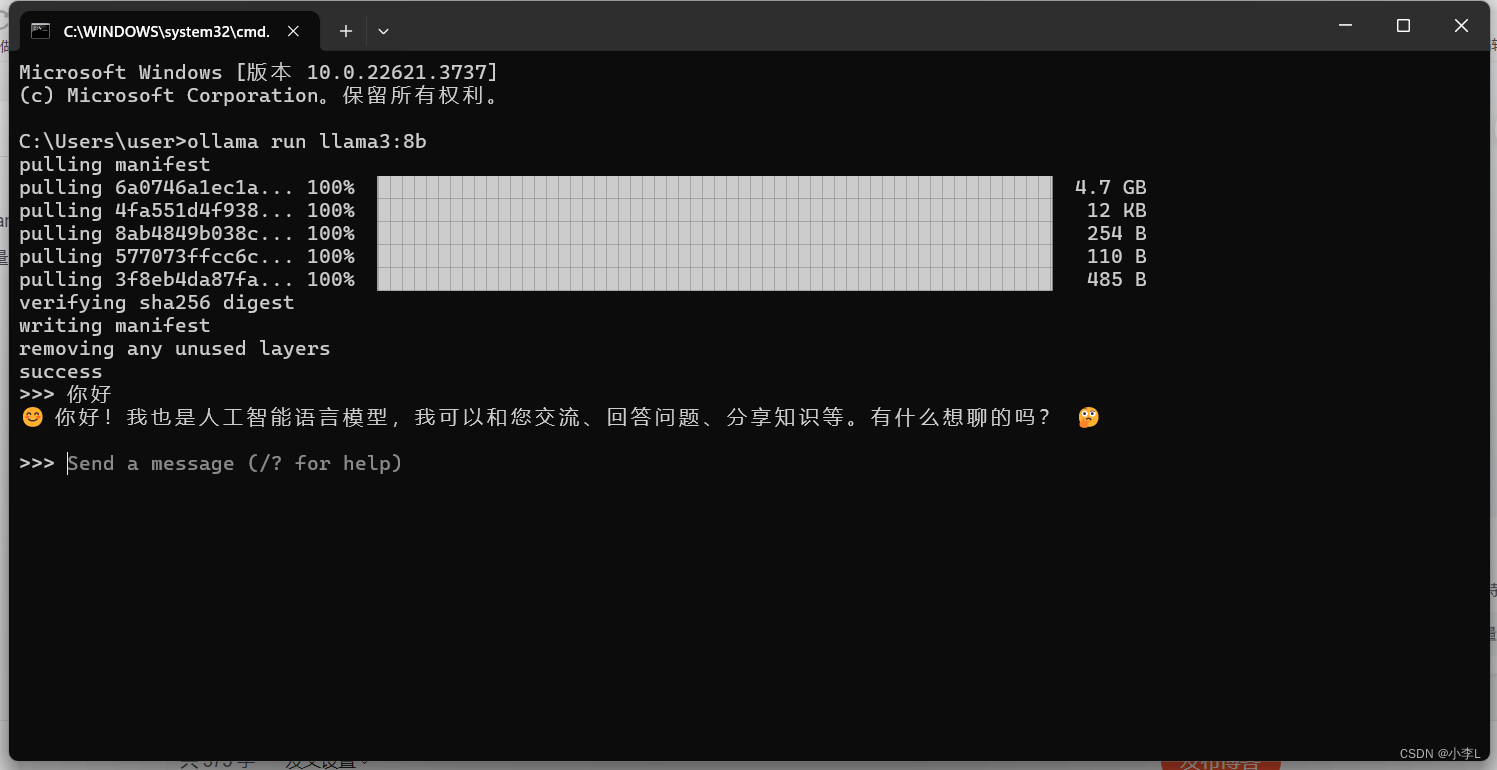

下载完毕就可以使用啦。

也可以在python中调用本地的Ollama中的模型。

1937

1937

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?