本篇博客介绍一篇发表在2024 NAACL上的文章:《Generating Uncontextualized and Contextualized Questions for Document-Level Event Argument Extraction》

方向:大模型事件抽取

本篇博客为个人阅读论文的总结与笔记,在这里进行简单的分享

摘要

本文提出了多个文档级事件参数抽取问题生成策略。这些策略不需要人工参与,既可以生成非语境化问题,也可以生成基于感兴趣事件和文档的语境化问题。实验结果表明,将非语境化问题和语境化问题相结合是有益的,特别是当事件触发语和参数出现在不同的句子中时。我们的方法没有特定于语料库的组件,特别是,问题生成策略跨语料库迁移。我们还提出了一个定性分析的最佳模型的最常见的错误。

一、简介

事件参数抽取是关于识别参与事件的实体并指定其角色将自然语言转换为结构化的事件知识有利于许多下游任务,例如机器阅读理解,新闻摘要,共指消解和对话系统。

传统上,语料库仅限于事件所属句子内的参数,而插入式参数更具有挑战性,受到的关注较少。图1显示了RAMS的一个示例,最大的语料库注释多句事件-参数结构。四分之二的事件-参数关系跨越句子边界。

当前的参数抽取领域主要是基于主题的方法和问答技术。然而,这些方法严重依赖于僵化的模板,忽视了文档提供的有价值的上下文。另一个改进的途径涉及整合外部知识,但挑战在于寻找相关外部知识的试错过程,在本文中,我们通过生成基于感兴趣事件的语境化问题来解决这些问题。我们的方法从文档中捕获不同事件参数和非事件参数实体的语义相关性。

如图1所示,对于事件触发词导入的工件角色,我们生成了五个问题,并使用transformer来识别答案,以确定参数(即,oil),或者指示没有答案。前三个问题是脱离语境的(即不理会该文件;它们只考虑事件和参数角色)另一方面,后两个问题是语境化的(即,基于事件触发词和文档)。情境化问题由使用弱监督训练的T5模型生成。正如我们将看到的,即使它们是嘈杂的,它们也会产生实质性的改进(例如,Q4的答案不是oil)。

图1:RAMS的示例(顶部,事件触发词导入及其参数)。在本文中,我们尝试了几种策略来生成用于事件参数抽取的问题。导入工件的问题显示在虚线框中。Q1是根据特定于角色的模板生成的,Q2和Q3是提示GPT-4生成的,Q4和Q5是由弱监督的T5模型生成的。

本文的主要贡献是:

1、生成非情境化和情境化问题的几种策略,包括弱监督模型,这些模型除了定义提示之外不需要手动操作。

2、实验结果表明,结合非情境化和情境化问题对RAMS是有益的。

3、实验结果表明,我们的方法是有效的域外语料库,事件触发词和角色。特别是,问题生成组件无缝地转移到其他语料库(WikiEvents)。

我们的方法的一个关键好处是,它可以很容易地适应任何事件参数抽取基准-我们没有任何基准特定的组件。唯一的要求是事件可能具有的参数角色列表。大多数事件参数注释工作都满足此要求,包括PropBank,NomBank,FrameNet),RAMS,ACE和WikiEvents。本文中的所有示例都来自RAMS,但我们也将我们的最佳问答策略应用于WikiEvents,以证明其适应性。

二、先前工作

事件参数抽取在该领域有着悠久的历史。最初,数据集侧重于抽取同一句话中的参数,而不是事件。也有语料库集中于插入式参数。与大多数NLP任务一样,事件参数抽取的模型经历了基于词嵌入、RNN和CNN的转换。

基于transformer的方法是目前性能最好的方法,一些研究假设事件触发词和参数跨度是输入和呈现分类器的一部分,以识别参数角色。与他们不同的是,就像下面讨论的其他先前的工作一样,我们只假设事件触发词。在高层次上,识别参数跨度及其作用的努力可以分为序列标签、将问题转换为问答任务和使用生成模型。序列标签分类器使用传统的BIO编码来解决问题。根据问题和答案来构建问题很受欢迎。零样本少样本预测,利用生成语言模型。语言生成通过生成参数而不是识别输入文档中的跨度来促进更灵活的抽取。迁移学习也被探索,包括角色重叠知识,语义角色,抽象意义表示和框架感知知识蒸馏。

我们通过查询一个Transformer模型来处理这个问题,作为一个问答任务。与以前的工作不同,我们探索了基于事件和感兴趣的文档的非上下文化和上下文化问题。后者的问题是用弱监督模型生成的。这允许我们用一个语料库(RAMS)训练模型,该语料库可以转移到其他语料库(WikiEvents)。

三、生成事件参数抽取的问题

我们将RAMS事件-参数结构转换为问题和答案。虽然gold事件参数注解包括gold答案(即参数),但没有gold问题要求填充事件触发词的角色的参数。因此,我们提出了五种问题生成策略,分为两类:非语境化问题和语境化问题,与非语境化问题不同,语境化问题基于感兴趣的事件和文档。

3.1 非语境化问题

无上下文的问题只能访问事件触发词(例如,图1中的导入)和角色(例如,工件)。它们忽略感兴趣的文档,并且总是为事件触发词和角色生成相同的问题。

基于模板的问题。受以前工作的启发,我们根据事件本体为事件可能具有的每个参数角色生成wh-question。我们使用一个简单的模板来生成问题:wh-word是事件[事件触发词]的[参数角色]?,其中wh-word选自以下内容:what、where、who和how。唯一的要求是先验地知道事件可能具有的参数角色的名称,这是我们与以前的工作共享的假设。无论参数是否存在于输入文档中,都会生成问题。如果参数不存在,则答案为No answer。例如,在图1中,“Q1:事件导入的工件是什么?”是事件触发词导入工件角色的基于模板的问题。

基于提示的问题。基于模板的问题,基于模板的问题依赖于人类定义的模板。当为新的参数角色生成问题时,这是次优的。我们采用大型语言模型来绕过这一限制。具体来说,我们使用零样本和少样本提示(详情请参阅附录C)与GPT-4模型,以生成事件可能具有的所有角色的wh-questions。少样本提示包括10个随机选择的示例,并支持上下文学习。这些问题旨在询问特定角色,而不与任何特定事件文档绑定。我们将这些问题称为零样本和少样本提示-图1中的Q2和Q3是为导入工件生成的基于零次和少量事件的问题:什么工件与事件导入相关?

脱离语境的问题有时会导致不自然或不合语法的问题,如下所示(X是事件触发词的占位符):

• Where is the place of event [X]? (template) 事件[X]的地点在哪里?(模板)

• Zero Prompt: Where did the event [X] take place? (zero-shot prompt) 零提示:事件[X]发生在哪里?(零次提示)

• Few Prompt: What is the place or location related to the event [X]? (few-shot prompt) 少量提示:与事件[X]相关的地点或位置是什么?(少量提示)

与其定义复杂的规则来解释正确的动词时态并制定更好的措辞,我们使用上下文化的问题。

3.2 语境化问题

非情境化问题缺乏事件触发词所属文档中包含的任何信息,包括其他参数以及文档的其余部分。情境化问题解决了这一弱点。我们提出了一种弱监督方法来基于感兴趣的事件和文档生成情境化问题。我们探索了两种策略来收集数据以训练问题生成模型:(a)利用SQuAD,一个与事件参数抽取无关的问答数据集,以及(b)通过提示LLM自动获得的问题的弱监督。

基于SQuAD的问题。我们使用(文档、问题和答案)作为问题生成的训练数据。训练过程涉及向模型提供文档-答案对,以便它学会生成问题。尽管SQuAD不是为事件参数抽取而设计的,这个模型可以产生一个(有时是嘈杂的)问题。值得注意的是,这个模型需要答案来生成问题。因此,基于SQuAD的问题只能在训练时使用。

虽然这些问题是有背景的,而且我们将看到用它们进行训练是有益的,但我们发现它们往往不是基于感兴趣的事件或包含误解。例如,图1中Q4的答案(What did Russia destroy 500 trucks with?) is not oil (oil is the artifact of importing)。

来自LLM的弱监督。为了产生更多合理的情境化问题,我们采用了有针对性的方法。我们利用了RAMS的一个子集(500个随机样本,来自训练分割的7%)提示(详见附录C)GPT-4,带有文档、事件触发词和相应的参数角色。我们指示GPT-4根据输入提示生成5个wh-问句,得到近9000个问题询问事件的参数。

然后,我们训练一个T5模型,使用弱监督和9000个问题(输出)与文档、事件触发词及其角色(输入)配对来生成问题。该模型不仅为RAMS生成特定于角色的问题,但是,正如我们将看到的,也适用于其他语料库,如WikiEvents。例如,在图1中,为导入事件的工件角色生成了Q5:What is being imported from ISIS-held territory in Syria and Iraq?请注意,这些问题包含导入的其他参数g (Syria and Iraq: origin)以及文件中的其他信息t(ISI-held territory)。此外,这个问题没有明确提到利息的作用,这些问题从文档中捕获参数和非参数线索,促进了细微差别和语义多样性问题的生成。此外,使用参数角色作为输入,而不是参数跨度,有助于将基于事件的知识转移到其他数据集。

四、实验

我们制定的问题的事件参数抽取作为一个问答任务,实证评估所提出的问题生成策略。我们的实验旨在确定最佳策略以及非语境化和语境化问题的最佳组合。此外,我们在RAMS上进行零样本和少样本推理,以测试GPT-3模型,这是我们最简单的问题生成方法。

模型。基于模板的非语境化问题不需要模型。我们使用GPT-4模型来生成基于模板的非语境化问题。对于语境化问题,我们微调T5使用SQuAD或通过提示GPT-4获得的弱监督数据(LLM的监督较弱)。无论问题是如何产生的,我们都会微调BART(基础版和大型版)来回答这些问题(即,为事件触发词的给定角色查找参数)。使用 pytorch 和HuggingFace transformers。唯一的例外是GPT-3和GPT-4,它们有自己的API。

结合非语境化和语境化问题。除了使用单一策略外,我们还在训练期间结合非语境化和语境化问题。在测试时,我们仅根据我们最初的经验发现使用非语境化问题(表1)。

表1:使用每种策略生成问题,通过RAMS的测试分割获得的结果(F1,五次运行的平均值和标准差)。对于非情境化问题,零样本提示优于少样本提示,但情境化问题则相反。情境化问题产生的结果远低于非情境化问题,尽管两者结合是最佳策略(表2)。

表2:结果(F1,五次运行的平均值和标准差),使用非情境化和情境化问题的组合,通过RAMS的测试分割获得。(非情境化)和LLM弱监管(情境化)问题。我们表明统计上显著更好的结果关于带星号的基于模板的问题()(McNemar检验,p < 0.01)。

数据集。我们使用两个数据集:RAMS和WikiEvents。RAMS中的事件和参数基于AIDA-12本体进行注释。文档来源于新闻文章,产生139个事件类型和65个参数角色。RAMS中的事件-参数结构在5句窗口内注释;每个文档有一个事件触发词注释。

WikiEvents与RAMS有很大的不同。它采用KAIROS 3本体,从维基百科获取文章,并包含50种事件类型和59种参数角色。WikiEvents通过在整个文档(远长于五句话)中注释事件参数结构提供更详细的视角,便于识别共指提及,并允许在同一文档中注释多个事件。

附录B中的表8显示了RAMS和WikiEvents数据集的基本统计数据

4.1 用GPT-3进行零次和少次推理

大型语言模型被认为具有涌现能力。它们也能够进行上下文学习,这意味着它们可以(大概)在给定指令时用一小部分数据样本解决下游任务。我们的方法使用它们来生成问题;这些问题被用于(a)微调T5用于问题生成,(b)BART用于事件参数抽取。为了测试上述能力,当涉及到跨句子抽取事件参数结构时,我们使用GPT-3进行实验,使用零次和少量提示:

Zero-Shot。我们用输入文档(五句话)和基于模板的方法生成的问题提示GPT-3(第3.1节)。

Few-Shot。我们用相同的zero-shot提示,但前面有两个例子,从训练分裂随机选择(并使用与预期答案相同的格式)。这些例子也包括没有答案的问题。

我们在附录D中提供了提示的细节和示例。我们在这里不详细说明它们,因为它们的结果很差(第5.1节)。

4.2 评价

我们所有微调的BART模型都使用官方评估脚本进行评估。也就是说,我们比较(精确匹配)预测和基于标记跨度(即,第一个和最后一个标记的索引,而不是标记跨度中的文本)的基础事实之后使用P、R和F1。我们的理由是,这是与以前的工作进行比较的唯一方法。

对于GPT-3的零次和少次推理,我们使用更宽松的评估。如果生成的文本包括预期答案的文本,则我们认为预测正确,而不是检查跨度。由于文档中可能有多个跨度匹配GPT-3的输出,因此这种评估更宽松,更好地适应生成模型。尽管更宽松,GPT-3获得的结果显著较低。

五、定量结果与分析

5.1 RAMS结果

表1列出了我们的BART模型(基础模型和大模型)与RAMS的结果(F1),并使用来自单一策略的问题。对于非情境化的问题,基于零样本的问题在基础模型中表现最好(F1: 48.8 vs45.2-48.5),而少样本的问题,以大模型为基础(F1:53.1 vs. 46.5- 52.3).弱监督问题对表现有负面影响(F1:45.2(base)和46.5(large)),这可能是由于高度的变化和解决多个上下文线索的要求。这导致我们在使用生成问题的单一策略时推荐非情境化问题。

我们在表2中报告了用未情境化和情境化问题微调的BART模型的结果RAMS的弱监督问题对基础模型和大型模型都产生了最佳结果,显示出3.0的F1改进(48.5 vs.51.5)的基础模型和2.2 F1的改进(52.3 vs. 54.5)大模型。这种方法稍微超过了大变量的最新模型。我们假设(即,基于事件和相关文件的问题)迫使模型学习事件参数和上下文线索之间的语义交互,这是由于问题的框架。此外,结合SQuAD的问题(也在上下文中)在训练时也有利于全面的结果。这是真的,尽管他们固有的噪音和措辞差异有关的事件以外的事件,但情况确实如此。表1中的结果证实了提出非语境化问题的优势,表2显示了将非语境化问题和语境化问题结合起来的一致优势。

与以前的RAMS工作的比较。我们的最佳模型略优于RAMS的最佳公布结果(表2,底部),APE,其实现了54.3的F1(我们的:54.5)APE依赖于来自多个事件参数抽取语料库(ACE05,RAMS和WikiEvents)的重叠角色注释。值得注意的是,当APE只使用RAMS训练时,它达到了51.7 F1(我们的:54.5),这表明与其他模型相比,性能显着下降。Nguyen et al(2023)提出生成用于事件参数抽取的上下文化软提示。生成软提示依赖于一组相关文档和手动初始化的提示,而我们的基于事件的问题生成方法从RAMS文档的一小部分学习,正如我们将看到的,它转移到其他域(WikiEvents,第5.2节)。

句间参数更难吗?表3详细列出了我们最佳模型的结果(结合基于模板的和来自LLM的弱监督,表2中黑体)(句子的数量)之间的事件触发词和参数。相对于最简单的问答方法的改进(% F1)(仅限基于模板的问题;表2中的第一系统)是实质性的,而不管事件触发词和自变量之间的距离。对于基本模型,我们观察到,当参数出现在事件触发词之后的两个句子中时,有37.2%的显著改善。值得注意的是,对于出现在事件触发词之前的句子中的参数,改善仍然相当可观。对于大型模型,当参数在事件触发词之前的句子中时,最显著的改善为19.1%F1,其次是这两个句子(12.6%F1)。来自其他句子的参数也受益(6.8%F1和3.5%F1)。从本质上讲,我们的方法在抽取eventargument结构时表现出了鲁棒性,而不管参数和事件触发词之间的距离如何。然而,当参数与事件触发词不在同一个句子中时,好处最明显。

表3:RAMS和我们的最佳模型(表2中的黑体)的结果按参数和事件之间的距离(#句子)细分。% F1表示仅使用基于模板的问题(表2中的第一个监督系统)进行训练的相对改进。我们的方法使所有参数受益,特别是那些与事件不在同一句话中的参数。

频繁的参数更简单吗?人们普遍认为,训练数据越多,就越容易学习。图2提供的经验证据表明,在预测RAMS中的事件-参数结构时,情况并非如此。我们观察到,每个参数的F1得分范围从0.33到0.70,但没有模式表明频率与F1得分相关。例如,不常见的事件,如雇员和乘客(2%)获得的结果与传播者(6%)和受害者(5%)获得的结果一样高。

图2:我们最好的系统的每个参数的F1(表2中的黑体)。训练中的频率(括号之间)只是F1的一个弱指标,从而得出结论,有些参数更容易学习(e.g., passenger比participant的频率低70%,但前者获得的F1是前者的两倍(0.70 vs. 0.33)

频繁事件更容易发生吗?不,不是。令人惊讶的是,事件的更多训练数据并不总是带来更好的结果。图3显示了15个最常见事件的平均F1分数。该图显示了训练中事件频率和F1分数之间没有明确的模式。事实上,频率为2%的事件参数获得的F1分数范围为0.33和0.60,与更频繁事件的F1分数重叠的大范围。

、

图3:我们最好的系统的每个事件(前15个最频繁的事件)的平均F1(表2中的黑体)。训练中的事件频率(括号之间)和F1之间没有明确的关系,从而得出结论,某些事件的参数更容易学习(e.g.,selfdirectedbattle vs. payforservice)

哪些参数被贴错了标签?我们最好的模型获得54.5 F1。这个数字很低,但评估是严格的,因为它得到:它期望预测与确切的参数范围和参数角色匹配。图4比较了gold(行)和预测(列)参数角色,(表2中黑体)预测了正确的参数跨度。我们观察到两个主要趋势。首先,模型错误地给参数贴上标签,(原则上)在给定输入文档的情况下看似合理但错误的。例如,接收者、受益者和给予者通常是人,但在给定事件触发词的情况下它们具有不同的语义。其次,我们的模型错误地标记了那些可以被认为是正确的但不遵循RAMS注释的参数。例如,运输的运输者事件(即移动某物的人)可能是起源或事件,但RAMS保留了运输开始的位置的参数角色。我们假设我们的模型利用了在我们使用RAMS培训之前获得的关于运输者和起源的知识(并且它在训练期间从未克服过这些知识)。

图4:混淆矩阵比较gold(行)和预测(列)参数角色,以正确预测参数跨度(前15个最常见的类型)。大多数错误都是似是而非的(从表面上看),但在语义上是错误的参数角色(例如,将受益人错误地标记为收件人;请注意,两者通常都是人)。

与GPT-3比较。GPT-3的零样本和少样本提示在我们的问答方法的性能方面有所不足。表4中的结果表明,与零样本设置相比,GPT-3在少样本上下文学习设置中获得了更好的结果。然而,性能落后于我们基于模板的问答模型。重要的是要认识到提示工程的潜力以提高性能。我们为未来的工作保留了快速工程的途径。

表4:使用我们最简单的问题生成策略(基于模板)和GPT-3(textdavinci-003)以及零次和少量提示获得的结果

5.2 WikiEvents的结果

我们还评估了我们提出的问题生成策略的有效性(RAMS的最佳执行方法,在表2中以粗体显示)。为了表达非上下文化问题,我们采用了一种基于模板的方法,该方法利用了数据集提供的事件本体。我们重用了RAMS使用的问题生成模型,包括使用通过文档提示获得的问题训练的弱监督模型,事件触发词和RAMS中的参数。换句话说,没有WikiEvents特定的组件或微调。

结果(表5)表明,我们的方法可以跨语料库迁移--表现了WikiEvents包含的文档与RAMS不同,也包含不同的事件和论证角色。事实上,非语境化和语境化问题的最佳策略在统计学上产生了显著更高的结果。虽然我们的性能并不优于所有最先进的模型,尤其是对于较大的模型,但我们的结果仍然具有竞争力,尽管问题生成组件是使用RAMS进行培训的。

表5:使用基于模板的问题和RAMS的最佳策略的WikiEvents结果(F1,五次运行的平均值和标准差)(表2中以粗体显示)。我们重复使用在RAMS样本上训练的弱监督问题生成模型。结果在统计学上显著更好(McNemar检验,p < 0.01,用表示)。

六、定性错误分析

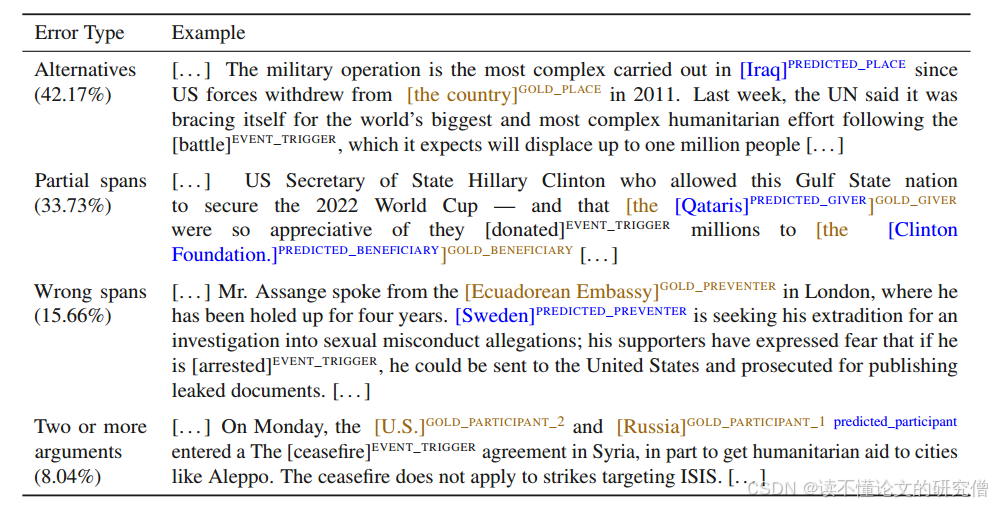

我们通过检查最佳模型的误差来结束我们的分析(表2中的黑体)。我们讨论了输入文档或模型预测中的语言共性,这些共性是在对100个文档中的83个错误进行手动分析时观察到的。(42.17%,表6)是预测替代跨度。在这个例子中,我们的模型预测了一个被视为错误的共指提及。这使我们能够提出重新思考事件参数抽取的评估问题;只有一个gold跨度匹配可能并不理想。第二个最常见的错误类型(33.73%,表6)是预测部分跨度(比gold跨度短或长)。差异包括文章,连词,数字和补充实体的详细描述。完全错误的跨度的可能性要小得多(15.66%)。我们的模型仅限于预测每个参数角色的一个跨度,因此对于具有两个相同参数角色实例的事件,它总是会出错(8.04%的误差)。Zhang et al(2020)先前报道,我们发现一些模型误差(7.3%)似乎是由于注释错误-没有注释是完美的,RAMS也不例外。例如,测试集包括以下内容: he raised the [funds]RECIPIENT privately and [reimbursed]EVENT_TRIGGER the city [. . . ].

表6:我们在RAMS上表现最好的模型所犯的最常见错误(将基于模板的问题与弱监督模型获得的问题相结合,表2中的黑体字)。

七、弱生成问题分析

我们在两个语料库中对事件参数抽取的实证评估表明,弱监督问题的训练产生了积极的结果,通过弱监督模型。该分析评估了生成的问题与文档中详细描述的事件和参数角色的相关性和准确性。总体而言,我们在分析了100个问题后发现了三个不同的类别。第一类问题既针对事件又针对参数角色,第二类问句只关注事件,第三类问题与事件和论证角色都缺乏相关性。图5使用弱监督T5模型的输出对这3个类别进行了说明。我们观察到,生成的问题中有73%是基于事件和参数角色的(第一类)。另外23%的问题是基于感兴趣的事件(第二类),但目的是抽取与感兴趣的角色不同的信息,只有4%问题既不基于事件,也不基于兴趣的参数角色(第三类)。

图5:由弱监督T5模型生成的三类问题的示例。以绿色突出显示的文本表示事件,而红色文本表示RAMS文档中的参数。参数角色在括号中提到,关于事件和参数角色的问题是基于事件和参数角色的,而关于事件的问题只基于事件。关于事件和参数角色的问题与事件和参数角色无关,生成的问题是由弱监督模型生成的输出;预期问题是指我们想要生成的完美问题(假设)的人类书面问题

八、结论

我们已经提出了几个问题生成策略,用于询问关于事件的参数的问题。我们的方法可以无缝地用于任何语料库;唯一的要求是事件和它们可能采用的参数的列表,结合非语境化问题和语境化问题可以获得最好的结果。语境化问题包含了关于事件的其他参数的线索、兴趣以及文档的其他部分,为我们基于BART的模型提供了其他方式无法获得的信息。至关重要的是,我们生成问题的策略不需要人工干预。此外,生成问题的弱监督模型可以跨语料库传输(从RAMS到WikiEvents;不同的语料库,事件和参数角色)。

局限性

提出的这项工作有几个局限性。我们的弱监督方法在事件参数抽取方面带来了一定的优势。这已经通过实证分析进行了评估。虽然我们已经观察到在训练阶段引入问题的有效性,但我们还没有报告深入分析为什么这种方法在所有样本中都是成功的。目前还不清楚添加所有情境化问题是否普遍有益。为了解决这个问题,采用自适应选择策略可以证明在确定结合问题最有利的情况中是有价值的。

我们的模型预测每个事件触发词最多只有一个参数。因此,任何具有两个相同角色参数的事件触发词都肯定会产生错误(第6节)。解决这个限制需要进一步的研究,特别是在多轮问答的背景下,以增强模型的能力。

我们比较了我们的微调模型和基于模板的GPT-3问题。可以认为,可能有更好的替代方式来促进GPT-3模型。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?