Midjourney可以生成非常惊艳的产品摄影图片,但如果我们想要生成基于自己产品的场景图,就需要进行一些额外的处理。今天,我将分享如何通过Midjourney和我开发的ComfyUI工作流来生成更加贴合自己产品的场景图。

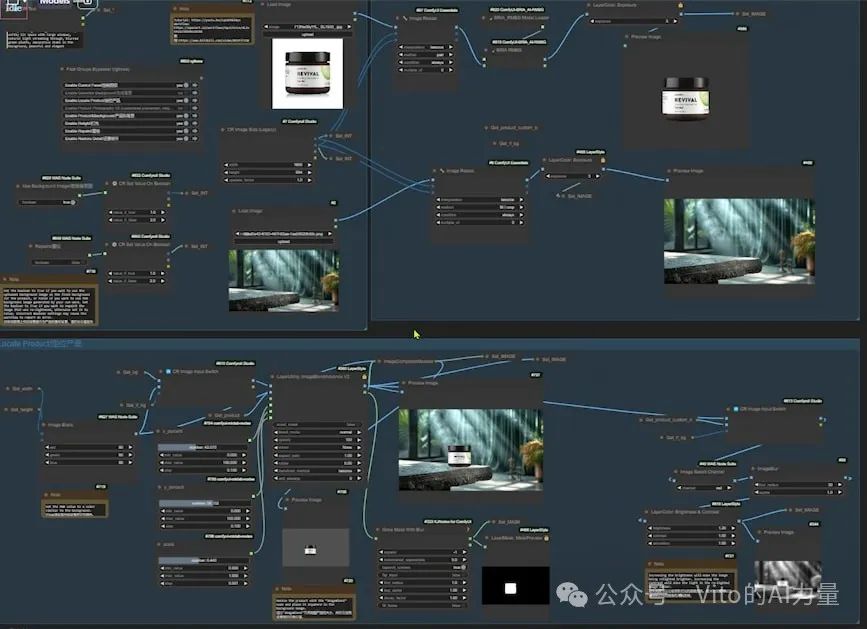

# Midjourney+我的ComfyUI工作流

我们都知道Midjourney可以生成非常惊艳的产品摄影图片。比如,这张美容产品的图片就是Midjourney生成的。它的光线效果确实很棒。

但我们要的是基于自己产品的场景图,比如说,这是我们的产品,一款眼霜。

我们可以通过Midjouney的图像参考功能,尽可能地让图片里的产品接近我们的产品。

虽然完全再现我们产品的细节并不可能,但我还是通过Midjourney和我开发的ComfyUI工作流做出了这张图。

Midjourney为我生成了产品的场景,我的ComfyUI工作流帮我把产品完美地融入了场景。

它改变了产品的光影,但保留了所有产品上的细节,包括文字。

# 如何用Midjourney生成产品背景

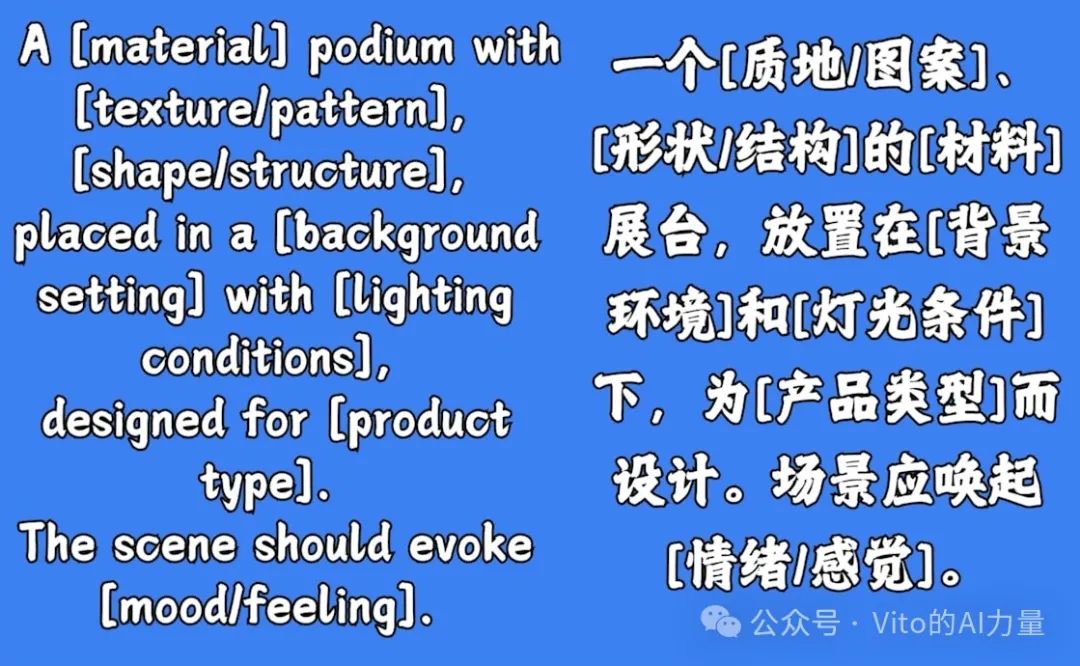

在创建产品摄影图时,一个好的背景能够有效地突出产品并提升其质感。我们可以通过Midjourney或Stable Diffusion生成符合自己需求的产品背景图。以下是具体步骤和提示词公式的介绍。

1. 提示词公式:创建多样化的展台

要生成多种类型的展台背景,可以使用以下提示词公式。你只需替换公式中的“材料”、“质地/图案”、“形状/结构”和其他括号里的内容,就能生成适合不同产品的展台。

-

公式示例:

A [material] podium with [texture/pattern], [shape/structure], placed in a [background setting] with [lighting conditions], designed for [product type]. The scene should evoke [mood/feeling].

-

展台作用:展台不仅能引导观众的视线集中到产品上,还能提升产品的档次感。

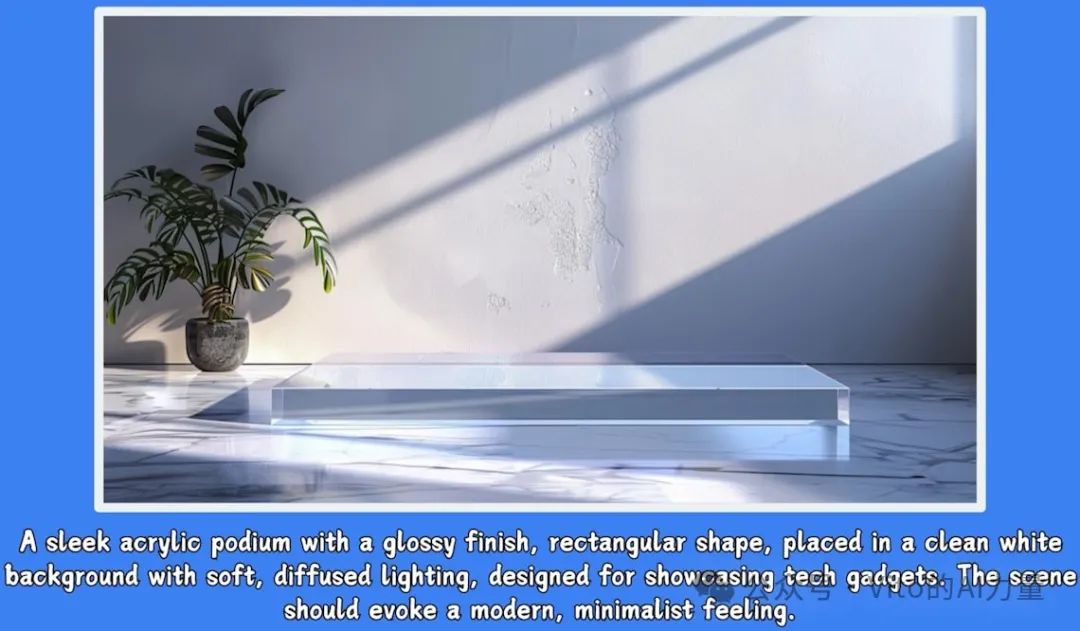

2. 示例1:现代简约的科技产品背景

- 背景描述:

展台材料为亚克力,质地光洁,形状为长方形。背景采用白色,周围配有柔和的散射光,营造出现代简约的氛围。

- 效果:

生成这个背景后,可以通过我设计的ComfyUI工作流将产品融入其中,最终图像会显得非常高级且专业。

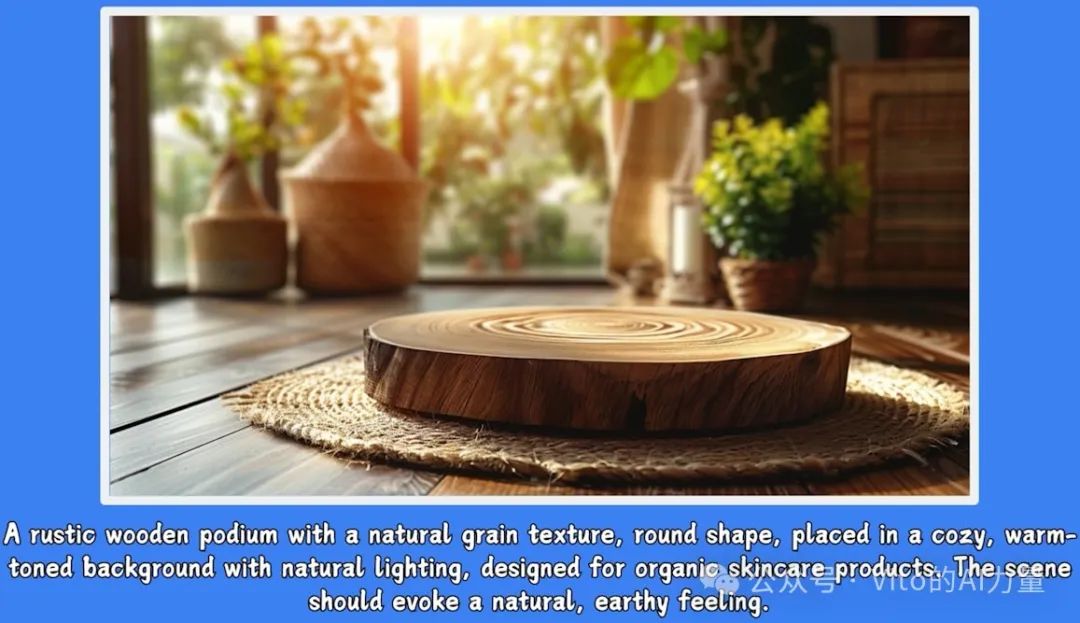

3. 示例2:乡村风格的有机护肤品背景

- 背景描述:

展台使用天然纹理的圆形木质材质,搭配舒适的暖色调背景和自然光,特别适合有机护肤品的展示。场景应唤起自然、朴实的感觉。

- 效果:

使用ComfyUI工作流将产品融合进这个背景,能够呈现出一个温馨自然的产品展示图。

4. 不使用展台的背景生成

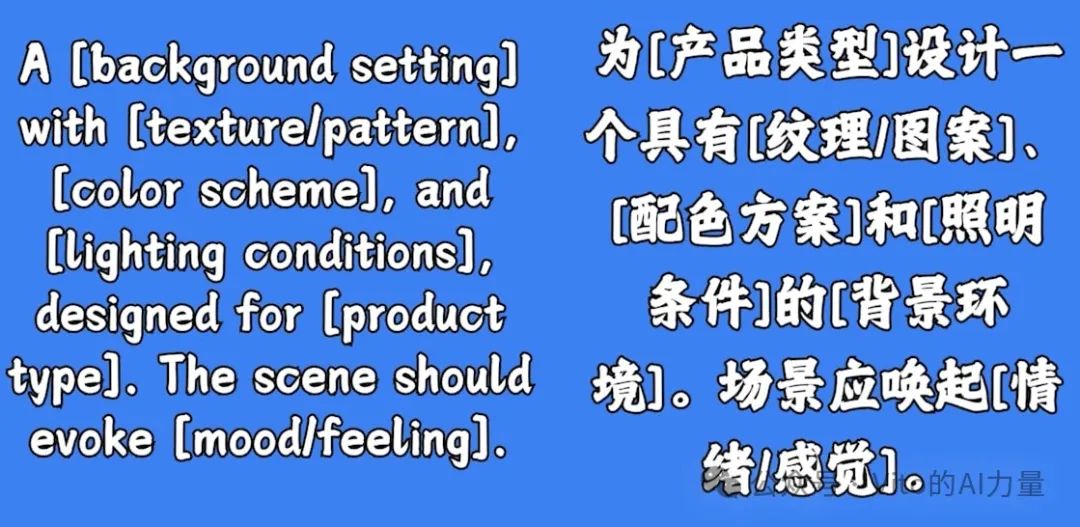

如果你不希望在背景中包含展台,也可以直接使用以下提示词公式生成背景:

-

公式示例:

A [background setting] with [texture/pattern], [color scheme], and [lighting conditions], designed for [product type]. The scene should evoke [mood/feeling].

或者,你也可以将你的产品图上传到Midjourney作为参考,直接生成一个与产品相似的图片。然后手动抹掉产品部分,留下背景,这样的图像也可以作为出色的产品背景。

例如,我在文中提到的背景图原本包含产品。

但我手动抹去了产品,只保留了背景,效果非常不错。

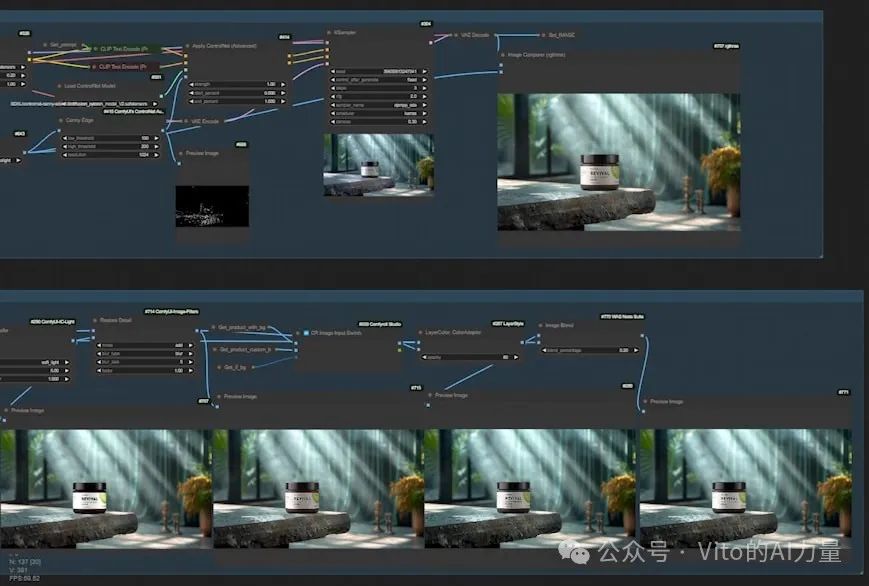

# ComfyUI工作流V2版本更新内容

在V2版本的ComfyUI工作流中,我根据大家的反馈和建议,进行了多项改进和功能更新。以下是具体的更新内容:

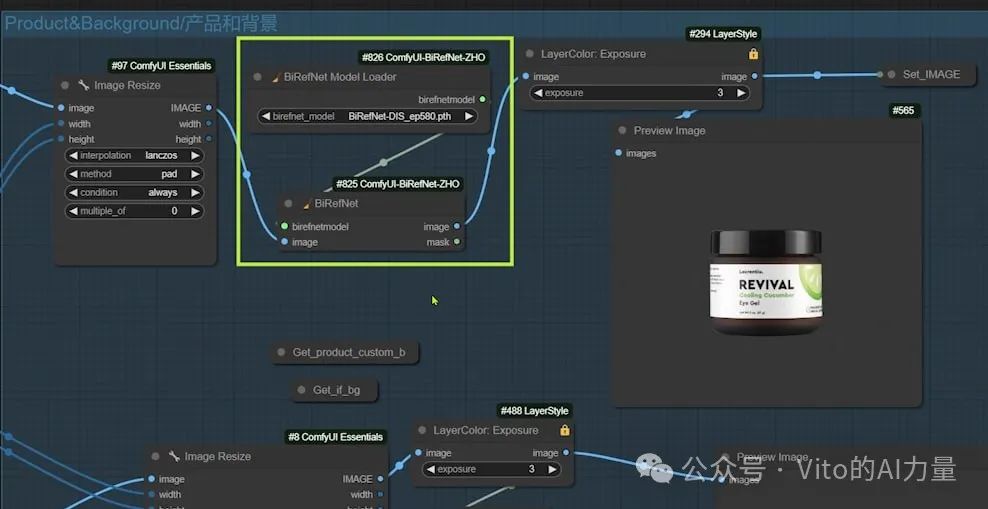

1. 精准抠图:从“Image Remove Bg”到“BiRefNet”

第一个重要更新是将原先用于抠图的“Image Remove Bg”节点替换为精度更高的“BiRefNet”节点。这一更新大幅提升了抠图的精确度,使得产品图与背景的融合更加自然。

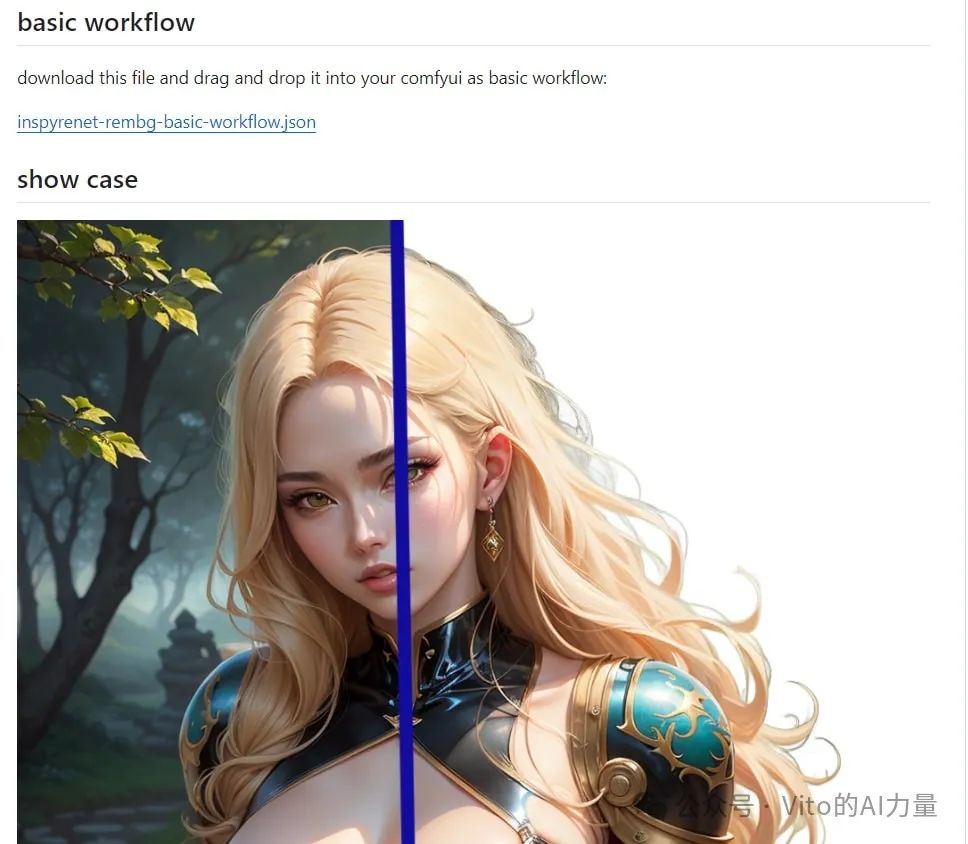

- 替代方案:如果您对精度有更高要求,可以尝试使用“Inspyrnet”节点。它在抠图方面表现出色,特别是在处理复杂的背景(如头发)时效果显著。

- 注意事项:Inspyrnet的首次抠图速度较慢,这也是我未默认使用它的原因之一,但其高精度表现值得一试。Github主页上的Demo可以让您了解更多细节。

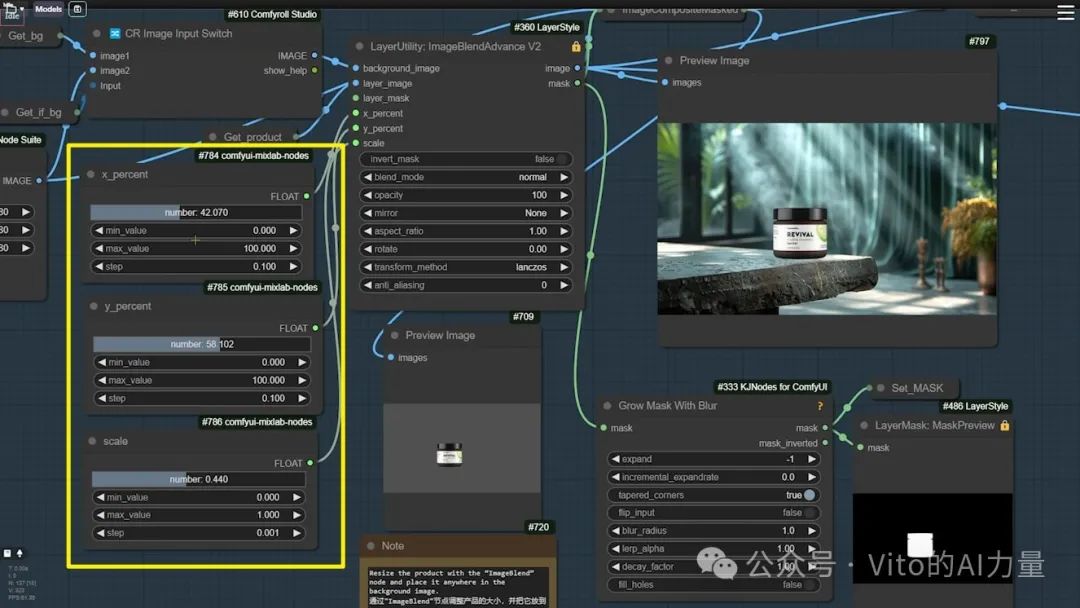

2. 更便捷的图像调整:新增浮点滑动条

第二个更新是为“ImageBlend”节点增加了三个浮点滑动条,使您在调整产品位置和大小时更加方便。只需拖动滑条即可完成调整,无需再手动输入具体数值。

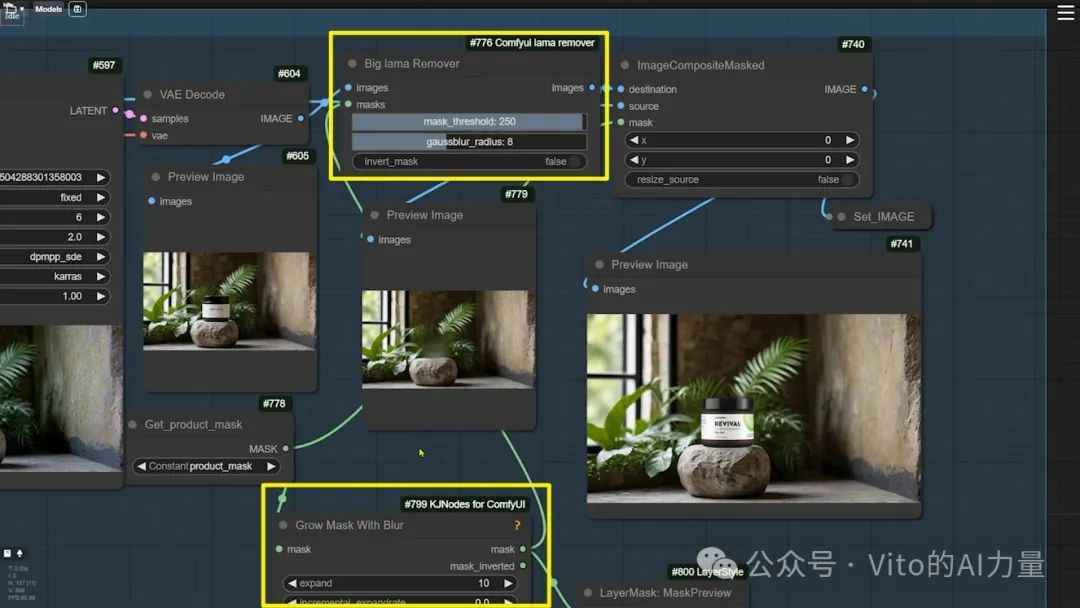

3. 优化产品边缘:新增“Lama Remover”节点

在“生成背景”组中,我新增了“Lama Remover”节点,用于解决产品边缘可能出现的多余像素问题。

- 工作原理:Lama Remover首先消除产品边缘的多余像素,然后再将产品图贴到背景上,从而避免了多余像素的产生。

- 补充操作:如果多余像素仍存在,可以通过“Grow Mask With Blur”节点扩大蒙版,然后重新执行消除操作。

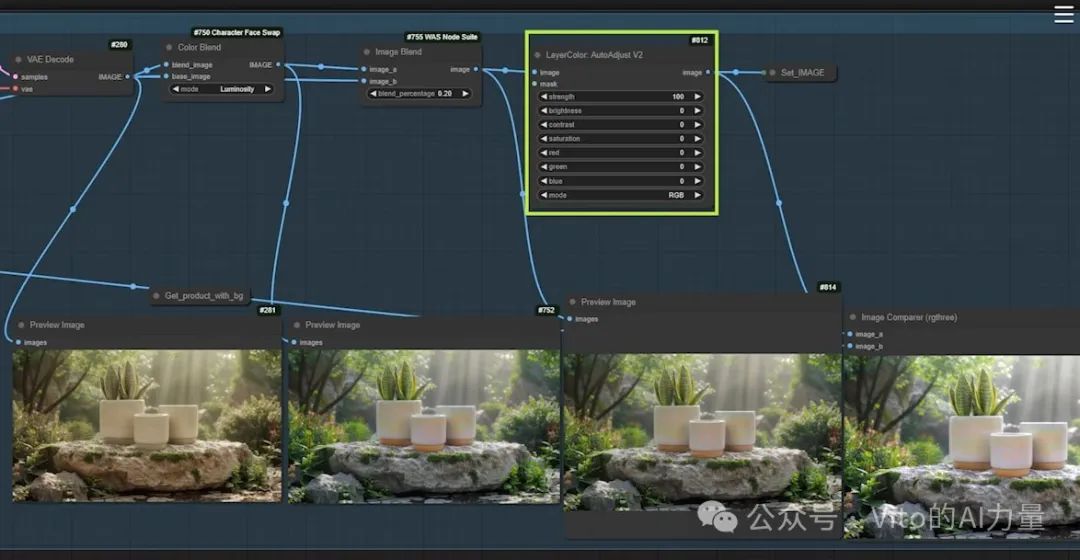

4. 自动调整打光效果:新增“AutoAdjust”节点

在“打光”组中,新增了“AutoAdjust”节点,它能够自动调整图像的色彩和对比度,以解决打光过程中可能出现的偏色问题。

- 实用场景:例如,在打光后的图像中,如果色彩问题特别严重,使用“AutoAdjust”节点可以自动优化这些色彩问题。在设置强度为100的情况下,图像的色彩对比度将得到自动调整,显著提升最终效果。

小结与提醒

以上就是V2版本工作流的全部更新内容。这些更新都旨在提高图像处理的精确度和操作的便利性。

- 升级提示:在使用最新的V2工作流之前,请确保将ComfyUI升级到最新版本,并安装所有缺失的节点,以确保新功能能够正常运行。

关于AI绘画技术储备

学好 AI绘画 不论是就业还是做副业赚钱都不错,但要学会 AI绘画 还是要有一个学习规划。最后大家分享一份全套的 AI绘画 学习资料,给那些想学习 AI绘画 的小伙伴们一点帮助!

感兴趣的小伙伴,赠送全套AIGC学习资料和安装工具,包含AI绘画、AI人工智能等前沿科技教程,模型插件,具体看下方。

需要的可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、AIGC所有方向的学习路线

AIGC所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

二、AIGC必备工具

工具都帮大家整理好了,安装就可直接上手!

三、最新AIGC学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

这份完整版的学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

443

443

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?