1 HIVE基础概念

1.1 什么是hive

Hive:由Facebook开源用于解决海量结构化日志的数据统计问题所提出来的。

Hive是基于Hadoop的一个数据仓库工具,用来进行数据提取、转化、加载,这是一种可以存储、查询和分析存储在Hadoop中的大规模数据的机制。hive数据仓库工具能将结构化的数据文件映射为一张数据库表,并提供SQL查询功能,能将SQL语句转变成MapReduce任务来执行。其中hive的数据是存储在hdfs上的.hive的作业是跑在yarn上的.hive的作业可以在mapreduce上运行的

hadoop:是一个分布式文件存储系统系统,其中hdfs负责数据存储(命令行操作,api操作),yarn负责资源的分配(提交作业) 作业的调度,mapreduce负责数据计算。但是mapreduce有很多弊端例如:1.开发起来麻烦 2.代码不好维护 3.对于传统的dba RDBMS是极度的不友好的 4.开发复杂 5.mapreduce适用与批处理/离线计算 实时计算是处理不了的但是hive恰巧解决了mapreduce处理离线计算开发慢的问题.

1.2HIVE官网

hive官网:hive.apache.org

hadoop:hadoop.apache.org

2 jdk安装部署

2.2 前提条件

由于HIVE是运行在hadoop之上的所以要求系统中包含hadoop和jdk环境和mysql环境.

2,3jdk安装

1.首先在jdk官网上找到适合自己的jdk版本卸载现有的jdk版本

rpm -qa | grep -i java | xargs -n1 sudo rpm -e –nodeps

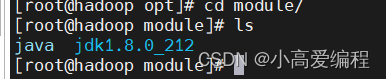

2.在/opt目录下创建文件夹

mkdir module

mkdir software

3.用工具将文件导入opt目录下的software文件夹下

4.解压JDK到/opt/module目录下

tar -zxvf jdk-8u212-linux-x64.tar.gz -C /opt/module/

5.配置JDK环境变量

新建/etc/profile.d/my_env.sh文件

vim /etc/profile.d/my_env.sh

添加如下内容

#JAVA_HOME

export JAVA_HOME=/opt/module/jdk1.8.0_212

export PATH=$PATH:$JAVA_HOME/bin

输入 :wq 保存后退出

6.测试JDK是否安装成功

java -version

如果出现以下结果说明java安装成功,如果未成功可以重新启动虚拟机尝试

java version "1.8.0_212"

3.安装HADOOP

1.首先创建一个新的用户

useradd hadoop

2.创建新用户的密码,并按照要求输入密码

passwd hadoop

3.在新用户的家目录下创建文件夹便于之后的文件管理,并将hadoop安装包拖入到software文件夹中

app ===> 框架解压目录

software ===》 存储安装包

data ==》 数据目录

project ===》作业 目录

tmp ==》 存放临时文件的目录

mkdir app software data project tmp

4.将hadoop安装包解压到app文件中,解压代码同上jdk安装.

tar -zxvf hadoop-3.3.4.tar.gz -C ~/app

5.创建hadoop软链接

ln -s hadoop-3.3.4/ hadoop

6.配置环境变量

vim ~/.bashrc

#HADOOP_HOME

export HADOOP_HOME=/home/hadoop/app/hadoop

export PATH=${HADOOP_HOME}/bin:${HADOOP_HOME}/sbin:$PATH

source ~/.bashrc

7.配置hadoop 分别在core-site.xml和hdfs-site.xml文件中写入

<property>

<name>fs.defaultFS</name>

<value>hdfs://bigdata31:9000</value>

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

8.ssh免密登录配置,最好配置,可以选择不配置,将一下代码分别输入到控制台

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

chmod 0600 ~/.ssh/authorized_keys

验证一下

ssh localhost

Last login: Mon Jun 5 03:16:56 2023 //出现此代码,表明ssh免密登录成功

9.hdfs格式化操作并启动

hdfs namenode -format //格式化操作

start-dfs.sh //启动hdfs

10.yarn的配置与启动

mapred-site.xml: mapreduce作业 以 yarn的方式去运行

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.application.classpath</name>

<value>$HADOOP_MAPRED_HOME/share/hadoop/mapreduce/*:$HADOOP_MAPRED_HOME/share/hadoop/mapreduce/lib/*</value>

</property>

```

yarn-site.xml:

``

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.env-whitelist</name>

<value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_HOME,PATH,LANG,TZ,HADOOP_MAPRED_HOME</value>

</property>

11.启动yarn

start-yarn.sh

12.在浏览器上运行查看

yarn的web ui:

http://hadoop:8088/

namenode web ui:

http://hadoop:9870/ ==> hostname

http://192.168.41.31:9870/ ==> ip

4 hive的安装部署

1.在hive官网上下载自己所需的hive文件,并拖入进software文件夹中

2.解压hive

tar -zxvf tar -zxvf apache-hive-3.1.3-bin.tar.gz -C ~/app/.tar.gz -C ~/app/

3.创建hive软链接

ln -s tar -zxvf apache-hive-3.1.3-bin hive

4.配置环境变量

全局环境变量 :

/etc/profile

个人环境变量

~/.bash_rc

~/.bash_profile

vim ~/.bashrc

#HIVE_HOME

export HIVE_HOME=/home/hadoop/app/hive

export PATH=${HIVE_HOME}/bin:$PATH

5.启动资源

source ~/.bashrc

6.启动hive

出现报错

hive> show databases;

FAILED: HiveException java.lang.RuntimeException: Unable to instantiate org.apache.hadoop.hive.ql.metadata.SessionHiveMetaStoreClient

原因需要初始化metastore,注意不是所有的hive版本都需要初始化metastore从2,0开始启动hive需要初始化元数据库

配置hive metastore的存储库

在hive的conf中创建一个hive-site.xml文件夹写入文件

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://hadoop:3525/hive_308?createDatabaseIfNotExist=true&useSSL=false</value>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>123456</value>

</property>

</configuration>

7.初始化元数据库

schematool -dbType mysql -initSchema

创建完成

8.查看运行结果

出现ok即为成功.

1570

1570

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?