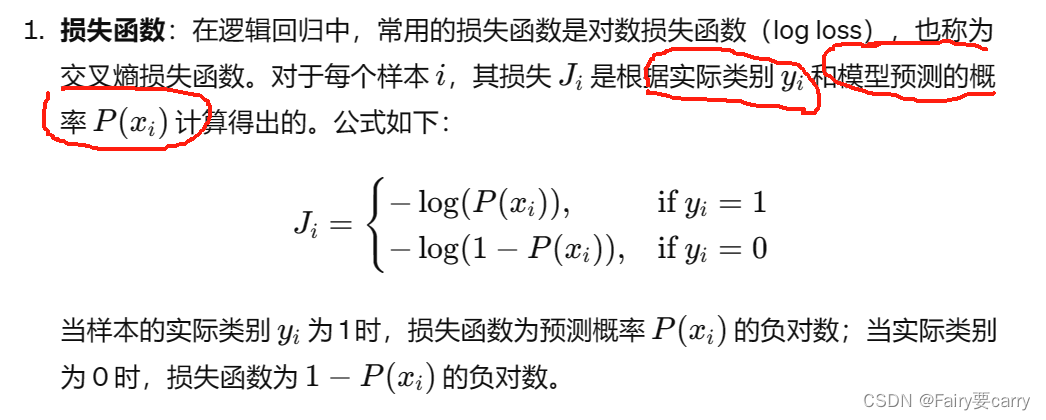

1.逻辑回归的损失函数(交叉熵)

因为MSE均方差适合线性回归,因为逻辑回归的点是散落分布的,另外逻辑回归适合处理分类任务。

**p(xi)**就是xi输入经过我们的sigmod函数输出概率。

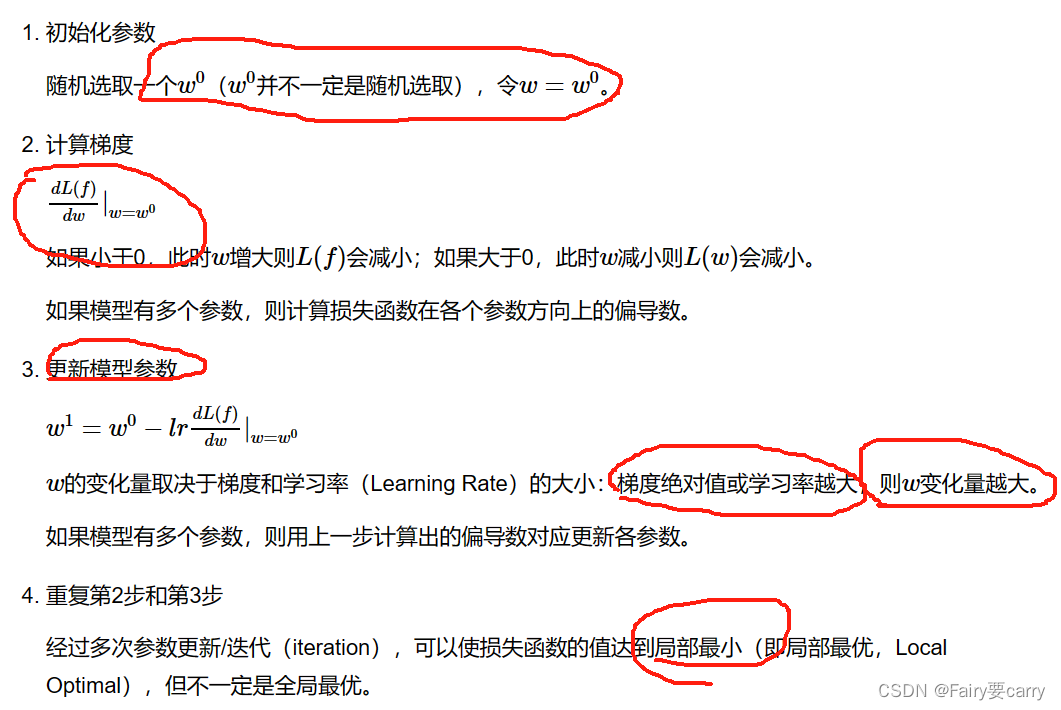

2.逻辑回归方程的梯度下降

1.梯度下降: 本质和线性回归一样,梯度指的就是损失函数 J 在当前权重下w的变化率,如果变化较慢,我们就需要调整我们的学习率 α ,使损失函数达到局部最优。——>比如梯度变化较慢,我们就降低学习率,说明参数已经接近最优值了;反之如果梯度变化较大,说明离最优值还差比较远,需要加大我们的学习率。

其实很简单理解,我们需要求解最优的参数比如w,那么损失函数需要最小,我们dL/dw求解损失函数对w权重的局部梯度,当梯度变化较大时,说明w变化剧烈,离最优值比较远,需要加大我们的学习率lr(自适应学习率,参考之前的梯度大小),梯度变化大说明损失函数在当前参数值w附近对参数的变化非常敏感

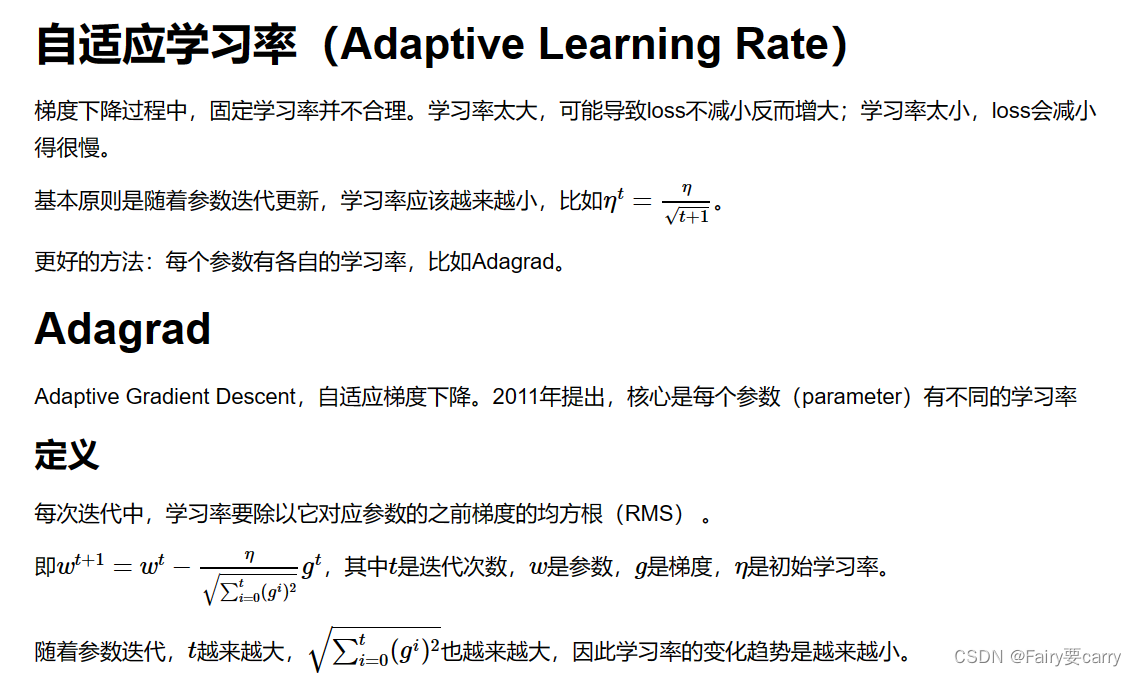

2.学习率: 固定的学习率不太现实,我们需要灵活调整学习率——>(自适应学习率【Adaptive Learning Rate】)

3.梯度爆炸: 在梯度较大时,如果直接采用常规的梯度下降步骤,可能会导致参数更新过头,即所谓的**“梯度爆炸”,这会使得模型无法收敛到最优解**——>我们的目标是梯度变化较慢直至趋于收敛得到最优解参数。解决这种问题的方法包括调整学习率、使用梯度裁剪或采用自适应学习率优化算法(如Adam、RMSprop等)。

3.逻辑回归于线性回归的差别

除了以上的损失函数不一样外(线性回归是MSE均方差,逻辑回归是我们的交叉熵函数)

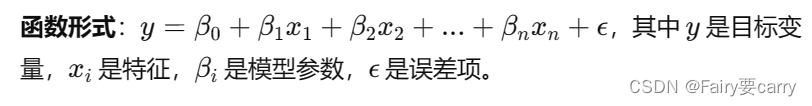

线性回归

目标: 线性回归是预测连续的数值输出。

应用: 预测房价,股票加个,温度变化等。

函数形式:

逻辑回归

目标: 预测一个离散的分类输出,通常是二分类(是/否)

应用: 广泛用于二分类问题,如垃圾邮件识别、疾病诊断、客户流失预测等。

4.梯度下降和反向传播算法

梯度下降:

梯度下降是一种基于当前点梯度方向的局部优化方法,旨在不断更新参数以减小损失函数值。其基本原理是沿着损失函数对参数的梯度方向(损失函数L对参数求偏导),即负梯度方向(减去),逐步调整参数值。然而,尽管梯度下降在理论上可以收敛到全局最优解,但实际应用中存在一些问题:

1、**局部最小值:**在非凸损失函数中,存在多个局部最小值,这是损失函数在一定区域内的最小值。梯度下降可能会陷入局部最小值,并无法继续向全局最优解移动。

2、**鞍点:**鞍点是损失函数在某些方向上是局部最小值,但在其他方向上是局部最大值或平坦区域的点。在鞍点处,梯度为零,导致梯度下降停滞。

反向传播算法:

是什么?

通过计算损失函数对网络中所有参数的梯度,然后沿着梯度的反方向更新参数,以最小化损失函数。

为什么不直接一趟梯度下降计算得到参数值:

梯度计算效率:

1、使用梯度下降算法时,需要手动计算损失函数对每个参数的偏导数,然后将这些偏导数组合成梯度向量。对于大规模的神经网络,这个过程非常繁琐且容易出错。

2、反向传播算法通过自动求导的方式,可以高效地计算损失函数对网络中所有参数的梯度,无需手动计算每个参数的偏导数,大大提高了梯度计算的效率。

网络结构灵活性:

1、在梯度下降算法中,需要手动调整学习率等超参数,以确保训练过程的稳定性和效率。

2、反向传播算法结合了优化算法(如Adam、SGD等)的特性,可以自适应地调整学习率和其他超参数,根据训练过程的表现实时调整参数更新策略,提高了网络训练的灵活性和效率。

5.局部极值和激活函数求导为0的区别:

局部最小值: 这是指损失函数在某个点的所有方向上的导数都为零。此时,梯度为零意味着在该点附近的损失函数值不能通过微小的参数调整而进一步减小,因此可能是一个局部最小值。

ReLU的零导数: ReLU(Rectified Linear Unit)函数定义为 f(x)= max(0,x)。当输入必小于零时,ReLU的输出为零,且导数也为零。此时,这个零导数只是在这一方向上为零,并不意味着损失函数在这个点是一个局部最小值。相反,这只是说明当前这个神经元在反向传播中不会对梯度有贡献。

但是,神经网络是由许多神经元和层组成的,仅仅一个神经元的导数为零并不影响其他神经元和层的梯度计算和参数更新。其他神经元可能有非零的输出和导数,这意味着整个网络的参数仍然可以通过其他神经元的梯度进行更新。

6.梯度变化很小和梯度值很小

3341

3341

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?