引言

人工智能和机器学习的出现彻底改变了我们与信息交互的方式,使其更容易检索、理解和利用。在本实践指南中,我们将探索如何创建由 LLamA2 和 LLamAIndex 提供支持的复杂问答助手,利用最先进的语言模型和索引框架轻松浏览 PDF 文档的海洋。本教程旨在为开发人员、数据科学家和技术爱好者提供工具和知识,以构建站在 NLP 领域巨头肩膀上的检索增强生成 (RAG) 系统。

在我们寻求揭开 AI 驱动的问答助手创建的神秘面纱的过程中,本指南是复杂的理论概念与其在现实世界场景中的实际应用之间的桥梁。通过将 LLamA2 的高级语言理解与 LLamAIndex 的高效信息检索能力相结合,我们旨在构建一个精确回答问题的系统,并加深我们对 NLP 领域潜力和挑战的理解。本文为爱好者和专业人士提供了全面的路线图,重点介绍了尖端模型与信息技术不断变化的需求之间的协同作用。

学习目标

-

使用 Hugging Face 的 LLamA2 模型开发 RAG 系统。

-

集成多个 PDF 文档。

-

索引文档以实现高效检索

-

制作查询系统

-

创建一个能够回答各种问题的强大助手

-

注重实际实施,而不仅仅是理论方面

-

参与动手编码和实际应用

-

让复杂的 NLP 世界变得易于访问和引人入胜

LLamA2 模型

LLamA2 是自然语言处理领域的创新灯塔,它突破了语言模型的极限。它的架构专为效率和有效性而设计,允许前所未有的理解和生成类似人类的文本。与 BERT 和 GPT 等前辈不同,LLamA2 提供了一种更细致入微的语言处理方法,使其特别擅长需要深度理解的任务,例如问答。它在各种NLP任务中的实用性,从摘要到翻译,展示了它在应对复杂语言挑战方面的多功能性和能力。

了解 LLamAIndex

索引是任何高效信息检索系统的支柱。LLamAIndex 是一个专为文档索引和查询而设计的框架,它通过提供一种无缝的方式来管理大量文档集合而脱颖而出。这不仅仅是存储信息;这是关于在眨眼间使其可访问和检索。

LLamAIndex 的重要性怎么强调都不为过,因为它支持跨大量数据库的实时查询处理,确保我们的问答助手能够从全面的知识库中提供及时准确的响应。

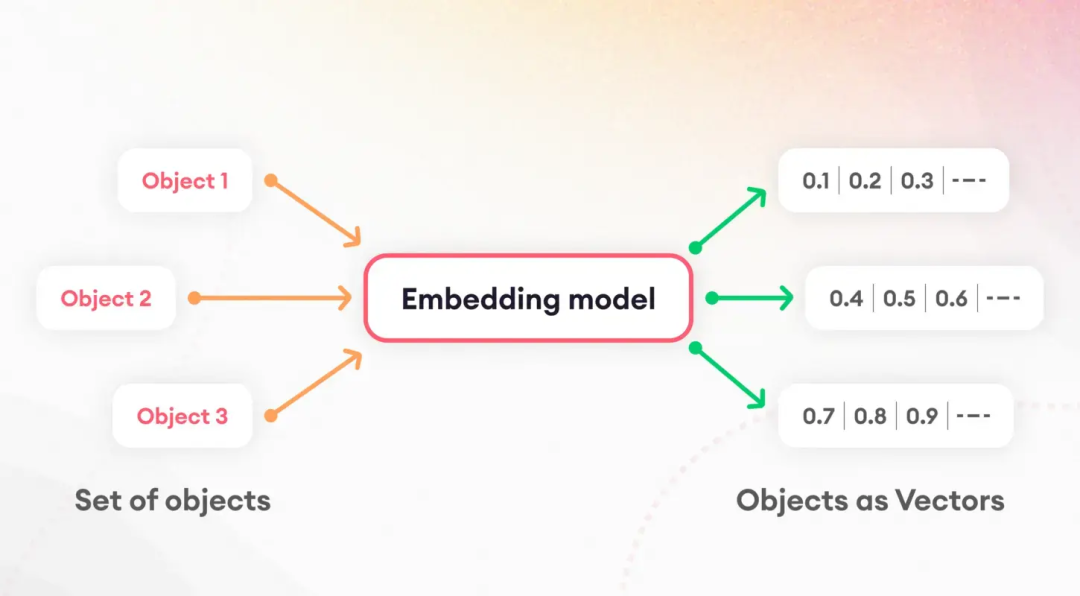

标记化和嵌入

理解语言模型的第一步涉及将文本分解为可管理的部分,这一过程称为标记化。这项基本任务对于准备数据以进行进一步处理至关重要。在标记化之后,嵌入的概念开始发挥作用,将单词和句子翻译成数字向量。

这些嵌入捕获了语言特征的本质,使模型能够辨别和利用文本的底层语义属性。特别是,句子嵌入在文档相似性和检索等任务中起着关键作用,构成了我们索引策略的基础。

模型量化

模型量化提供了一种策略,可以提高我们的问答助手的性能和效率。通过降低模型数值计算的精度,我们可以显著减小其大小并加快推理时间。在精度和效率之间进行权衡的同时,此过程在资源受限的环境中(如移动设备或 Web 应用程序)中特别有价值。通过仔细应用,量化使我们能够保持高水平的准确性,同时受益于减少的延迟和存储要求。

ServiceContext 和查询引擎

LLamAIndex 中的 ServiceContext 是管理资源和配置的中心枢纽,确保我们的系统平稳高效地运行。这种胶水将我们的应用程序结合在一起,使 LLamA2 模型、嵌入过程和索引文档之间实现了无缝集成。另一方面,查询引擎是处理用户查询的主力,利用索引数据快速获取相关信息。这种双重设置确保我们的问答助手可以轻松处理复杂的查询,为用户提供快速准确的答案。

实现

让我们深入了解实现。请注意,我使用 Google Colab 创建了这个项目。

!pip install pypdf``!pip install -q transformers einops accelerate langchain bitsandbytes``!pip install sentence_transformers``!pip install llama_index

这些命令通过安装必要的库(包括用于模型交互的转换器和用于嵌入的sentence_transformers)来设置阶段。llama_index 的安装对于我们的索引框架至关重要。

接下来,我们初始化我们的组件(确保在 Google Colab 的“文件”部分创建一个名为“data”的文件夹,然后将 PDF 上传到该文件夹中):

from llama_index.core import VectorStoreIndex, SimpleDirectoryReader, ServiceContext``from llama_index.llms.huggingface import HuggingFaceLLM``from llama_index.core.prompts.prompts import SimpleInputPrompt`` ``# Reading documents and setting up the system prompt``documents = SimpleDirectoryReader("/content/data").load_data()``system_prompt = """``You are a Q&A assistant. Your goal is to answer questions based on the given documents.``"""``query_wrapper_prompt = SimpleInputPrompt

在设置环境并阅读文档后,我们制作了一个系统提示来指导 LLamA2 模型的响应。此模板有助于确保模型的输出符合我们对准确性和相关性的期望。

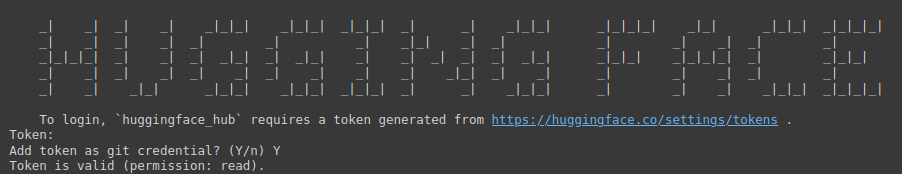

!huggingface-cli login

上面的命令是访问 Hugging Face 庞大的模型存储库的网关。它需要令牌进行身份验证。

您需要访问以下链接:Hugging Face(确保首先登录 Hugging Face),然后创建一个新令牌,为项目提供名称,选择“类型为读取”,然后单击“生成令牌”。

此步骤强调了保护和个性化开发环境的重要性。

import torch``llm = HuggingFaceLLM(` `context_window=4096,` `max_new_tokens=256,` `generate_kwargs={"temperature": 0.0, "do_sample": False},` `system_prompt=system_prompt,` `query_wrapper_prompt=query_wrapper_prompt,` `tokenizer_name="meta-llama/Llama-2-7b-chat-hf",` `model_name="meta-llama/Llama-2-7b-chat-hf",` `device_map="auto",` `model_kwargs={"torch_dtype": torch.float16, "load_in_8bit":True}``)

在这里,我们使用为我们的问答系统量身定制的特定参数初始化 LLamA2 模型。这种设置突出了模型的多功能性和适应不同环境和应用的能力。

from langchain.embeddings.huggingface import HuggingFaceEmbeddings``from llama_index.embeddings.langchain import LangchainEmbedding`` ``embed_model = LangchainEmbedding(` `HuggingFaceEmbeddings(model_name="sentence-transformers/all-mpnet-base-v2"))

嵌入模型的选择对于捕获文档的语义本质至关重要。通过使用句子转换器,我们确保我们的系统能够准确地衡量文本内容的相似性和相关性,从而提高索引过程的有效性。

service_context = ServiceContext.from_defaults(` `chunk_size=1024,` `llm=llm,` `embed_model=embed_model``)

ServiceContext 使用默认设置实例化,链接我们的 LLamA2 模型并将模型嵌入到一个有凝聚力的框架中。此步骤可确保所有系统组件都已协调一致,并已准备好进行索引和查询操作。

index = VectorStoreIndex.from_documents(documents, service_context=service_context)``query_engine = index.as_query_engine()

这些行标志着我们设置过程的高潮,我们在其中为文档编制索引并准备查询引擎。此设置对于将数据准备过渡到可操作的见解至关重要,使我们的问答助手能够根据索引内容响应查询。

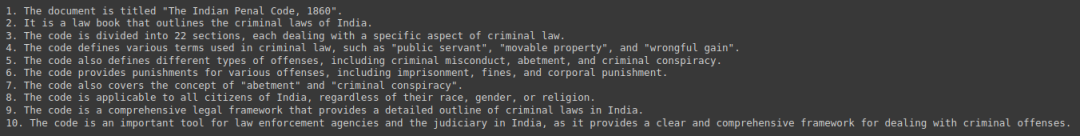

response = query_engine.query("Give me a Summary of the PDF in 10 pointers.")``print(response)

最后,我们通过查询从我们的文档集合中得出的摘要和见解来测试我们的系统。这种互动展示了我们的问答助手的实际实用性,并展示了 LLamA2、LLamAIndex 和底层 NLP 技术的无缝集成,使之成为可能。

输出:

伦理和法律影响

开发人工智能驱动的问答系统将一些道德和法律考虑因素带到了最前沿。解决训练数据中的潜在偏差以及确保响应的公平性和中立性至关重要。此外,遵守数据隐私法规至关重要,因为这些系统经常处理敏感信息。开发人员必须以勤勉和诚信的态度应对这些挑战,并致力于保护用户和所提供信息完整性的道德原则。

未来的方向和挑战

问答系统领域充满了创新机会,从多模态交互到特定领域的应用。然而,这些进步也带来了自己的挑战,包括扩展以适应庞大的文档集合,以及确保用户查询的多样性。LLamA2 等模型和 LLamAIndex 等索引框架的持续开发和完善对于克服这些障碍和突破 NLP 可能性的界限至关重要。

案例研究和示例

问答系统的实际实施,如客户服务机器人和教育工具,强调了 LLamA2 和 LLamAIndex 等技术的多功能性和影响力。这些案例研究展示了人工智能在不同行业的实际应用,并突出了成功案例和经验教训,为未来的发展提供了宝贵的见解。

结论

本指南介绍了创建基于 PDF 的问答助手,从 LLamA2 和 LLamAIndex 的基本概念到实际实施步骤。随着我们继续探索和扩展人工智能在信息检索和处理方面的能力,改变我们与知识互动的潜力是无限的。有了这些工具和见解,迈向更智能、响应更灵敏的系统的旅程才刚刚开始。

关键要点:

-

彻底改变信息交互:以 LLamA2 和 LLamAIndex 为例,人工智能和机器学习的集成改变了我们访问和利用信息的方式,为能够轻松浏览大量 PDF 文档的复杂问答助手铺平了道路。

-

理论与应用之间的实用桥梁:本指南弥合了理论概念和实际实现之间的差距,使开发人员和技术爱好者能够利用最先进的 NLP 模型和索引框架构建检索增强生成 (RAG) 系统。

-

高效索引的重要性:LLamAIndex 通过索引大量文档集合,在高效信息检索中发挥着至关重要的作用。这确保了对用户查询的及时和准确的响应,并增强了问答助手的整体功能。

-

性能和效率优化:模型量化等技术可提高问答助手的性能和效率,从而在不影响准确性的情况下减少延迟和存储要求。

-

道德考量和未来方向:开发人工智能驱动的问答系统需要解决道德和法律问题,包括减少偏见和数据隐私。展望未来,问答系统的进步为创新提供了机会,同时也对用户查询的可扩展性和多样性提出了挑战

那么,如何系统的去学习大模型LLM?

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

作为一名热心肠的互联网老兵,我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。

但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

所有资料 ⚡️ ,朋友们如果有需要全套 《LLM大模型入门+进阶学习资源包》,扫码获取~

篇幅有限,部分资料如下:

👉LLM大模型学习指南+路线汇总👈

💥大模型入门要点,扫盲必看!

💥既然要系统的学习大模型,那么学习路线是必不可少的,这份路线能帮助你快速梳理知识,形成自己的体系。

路线图很大就不一一展示了 (文末领取)

👉大模型入门实战训练👈

💥光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉国内企业大模型落地应用案例👈

💥两本《中国大模型落地应用案例集》 收录了近两年151个优秀的大模型落地应用案例,这些案例覆盖了金融、医疗、教育、交通、制造等众多领域,无论是对于大模型技术的研究者,还是对于希望了解大模型技术在实际业务中如何应用的业内人士,都具有很高的参考价值。 (文末领取)

👉GitHub海量高星开源项目👈

💥收集整理了海量的开源项目,地址、代码、文档等等全都下载共享给大家一起学习!

👉LLM大模型学习视频👈

💥观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。 (文末领取)

👉640份大模型行业报告(持续更新)👈

💥包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

👉获取方式:

这份完整版的大模型 LLM 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

😝有需要的小伙伴,可以Vx扫描下方二维码免费领取🆓

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?