医学视网膜分割是一项重要的医学图像分析任务,它可以帮助医生快速准确地诊断疾病。U-Net是一种经典的深度学习模型,被广泛应用于医学图像分割任务中。下面是一个基于Keras框架的U-Net模型训练示例:

1. 准备数据集

首先需要准备医学视网膜图像数据集。可以从公开数据集中获取或者自己收集。需要注意的是,医学图像数据量通常比较小,需要做好数据增强,如旋转、翻转、缩放等操作,以增加数据量和模型的泛化能力。

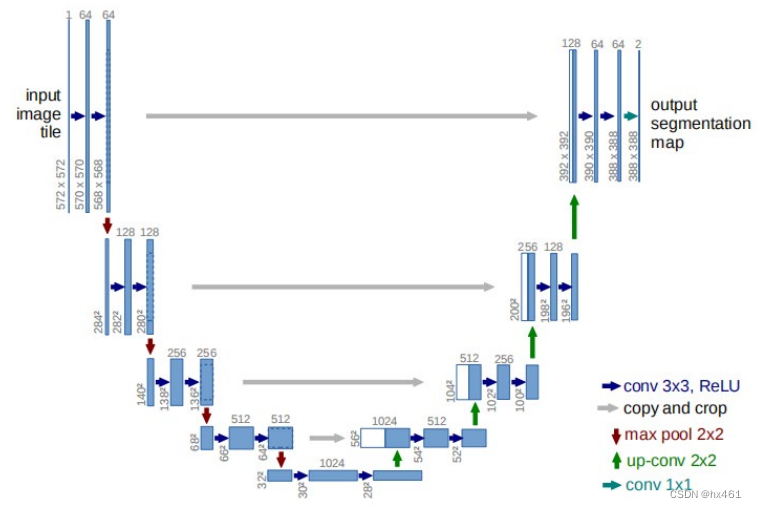

2. 构建U-Net模型

U-Net模型由编码器和解码器两部分组成。编码器用于提取图像特征,解码器则用于还原分割结果。下面是一个简单的U-Net模型:

```python

from keras.layers import Input, Conv2D, MaxPooling2D, Dropout, UpSampling2D, concatenate

from keras.models import Model

def unet(input_size=(256, 256, 1)):

inputs = Input(input_size)

conv1 = Conv2D(64, 3, activation='relu', padding='same', kernel_initializer='he_normal')(inputs)

conv1 = Conv2D(64, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv1)

pool1 = MaxPooling2D(pool_size=(2, 2))(conv1)

conv2 = Conv2D(128, 3, activation='relu', padding='same', kernel_initializer='he_normal')(pool1)

conv2 = Conv2D(128, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv2)

pool2 = MaxPooling2D(pool_size=(2, 2))(conv2)

conv3 = Conv2D(256, 3, activation='relu', padding='same', kernel_initializer='he_normal')(pool2)

conv3 = Conv2D(256, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv3)

pool3 = MaxPooling2D(pool_size=(2, 2))(conv3)

conv4 = Conv2D(512, 3, activation='relu', padding='same', kernel_initializer='he_normal')(pool3)

conv4 = Conv2D(512, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv4)

drop4 = Dropout(0.5)(conv4)

pool4 = MaxPooling2D(pool_size=(2, 2))(drop4)

conv5 = Conv2D(1024, 3, activation='relu', padding='same', kernel_initializer='he_normal')(pool4)

conv5 = Conv2D(1024, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv5)

drop5 = Dropout(0.5)(conv5)

up6 = Conv2D(512, 2, activation='relu', padding='same', kernel_initializer='he_normal')(

UpSampling2D(size=(2, 2))(drop5))

merge6 = concatenate([drop4, up6], axis=3)

conv6 = Conv2D(512, 3, activation='relu', padding='same', kernel_initializer='he_normal')(merge6)

conv6 = Conv2D(512, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv6)

up7 = Conv2D(256, 2, activation='relu', padding='same', kernel_initializer='he_normal')(

UpSampling2D(size=(2, 2))(conv6))

merge7 = concatenate([conv3, up7], axis=3)

conv7 = Conv2D(256, 3, activation='relu', padding='same', kernel_initializer='he_normal')(merge7)

conv7 = Conv2D(256, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv7)

up8 = Conv2D(128, 2, activation='relu', padding='same', kernel_initializer='he_normal')(

UpSampling2D(size=(2, 2))(conv7))

merge8 = concatenate([conv2, up8], axis=3)

conv8 = Conv2D(128, 3, activation='relu', padding='same', kernel_initializer='he_normal')(merge8)

conv8 = Conv2D(128, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv8)

up9 = Conv2D(64, 2, activation='relu', padding='same', kernel_initializer='he_normal')(

UpSampling2D(size=(2, 2))(conv8))

merge9 = concatenate([conv1, up9], axis=3)

conv9 = Conv2D(64, 3, activation='relu', padding='same', kernel_initializer='he_normal')(merge9)

conv9 = Conv2D(64, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv9)

conv9 = Conv2D(2, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv9)

outputs = Conv2D(1, 1, activation='sigmoid')(conv9)

model = Model(inputs=inputs, outputs=outputs)

return model

```

3. 编译模型

在训练模型之前,需要编译模型并指定损失函数、优化器和评价指标:

```python

from keras.optimizers import Adam

model = unet()

model.compile(optimizer=Adam(lr=1e-4), loss='binary_crossentropy', metrics=['accuracy'])

```

4. 训练模型

将准备好的数据集分为训练集和验证集,然后使用Keras提供的fit方法训练模型:

```python

model.fit(x_train, y_train, batch_size=16, epochs=50, validation_data=(x_val, y_val))

```

5. 评估模型

训练完成后,可以使用测试集来评估模型的性能:

```python

score = model.evaluate(x_test, y_test, verbose=0)

print('Test loss:', score[0])

print('Test accuracy:', score[1])

```

6. 使用模型进行预测

训练完成后,可以使用训练好的模型来对新的医学视网膜图像进行分割:

```python

y_pred = model.predict(x_test)

```

以上就是基于Keras框架的U-Net模型训练示例。当然,在实际应用中,还需要进行一些优化和调参,以达到更好的性能和精度。

1899

1899

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?