一、基础作业

参考以下链接:零编程玩转大模型,学习茴香豆部署群聊助手_哔哩哔哩_bilibili

1.1笔记:

茴香豆其实就是一个基于LLM的领域知识助手,借用的是RAG(检索增强生成)的思想,通俗来讲,其实就是他就是一个搜索引擎,将用户输入的内容作为索引,在外部的知识库中进行检索并结合LLM进行生成回答(关键就是可以外接一个实时更新的网络信息世界,实现外部记忆,不需要训练过程,直接搜索外面的玩意就行了,成本很低。

而茴香豆的主要应用目前是部署在微信群和飞书群中,用于解答群聊中的问题,并且可以根据群聊的记录自动分析哪些是闲聊哪些是真正的技术问题并解答。

下面就是茴香豆的web端,我们可以打开之后,输入自己的账户以及密码,并上传自己想要的知识库,后面便可以带着知识库聊天了! 关于拒答流程,茴香豆会自动根据设置好的拒答流程,对群聊消息进行筛选拒答或者回答。

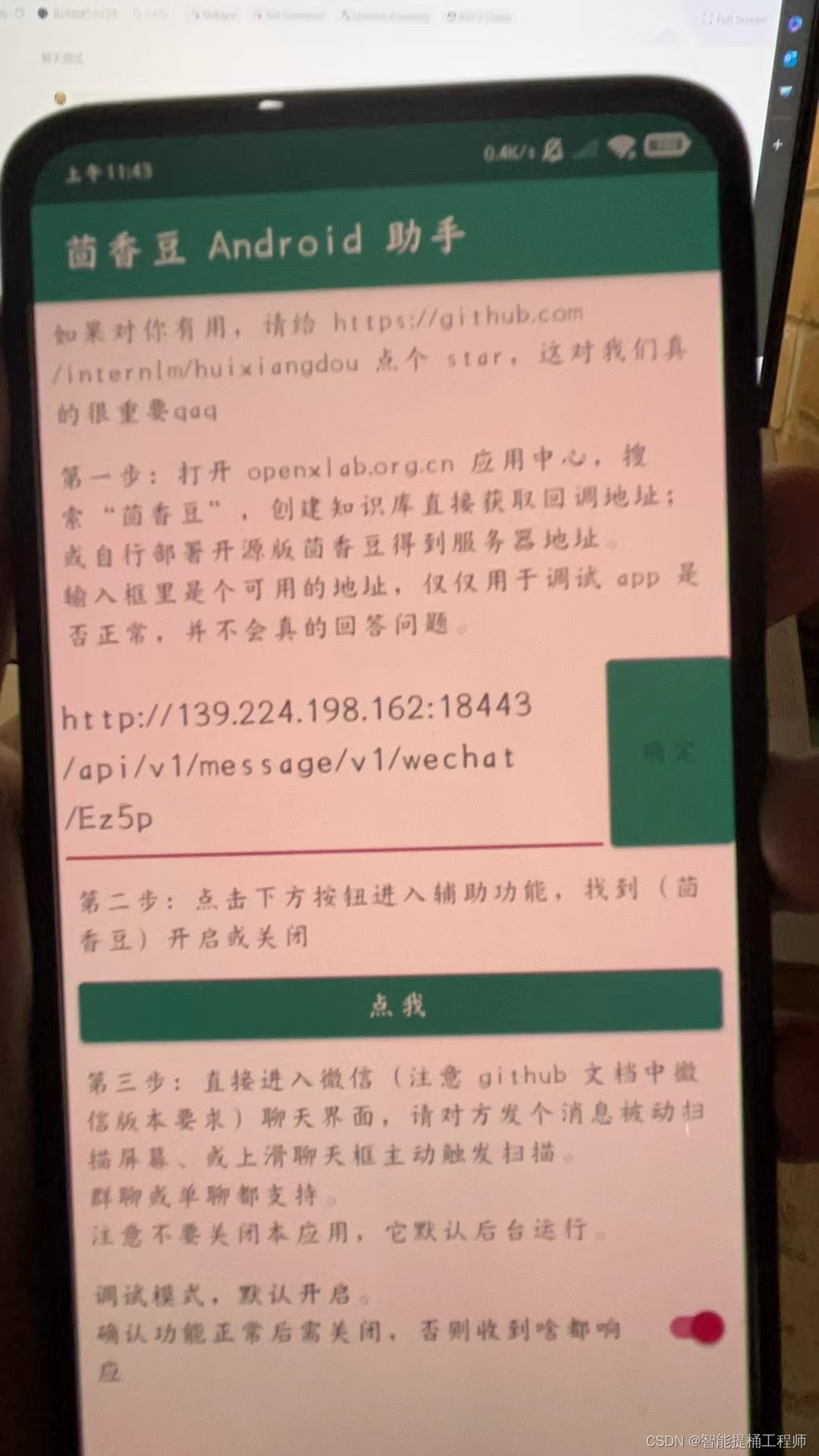

并且可以下载本地APP自动扫描群聊信息,来自动选择回答或者拒答。

1.2线上部署的茴香豆助手对话:不少于5轮

1.2线上部署的茴香豆助手对话:不少于5轮

1.3 参考视频零编程玩转大模型,学习茴香豆部署群聊助手

其实上面这些截图都是我自己在微信上部署的茴香豆助手啦哈哈哈哈

下面就拿自己的知识库再部署一遍吧,会跟进阶作业有一些重复!

按照教程先进入茴香豆web端,登录自己的账号

添加文档 我这里加的是建筑设计规范:

然后复制一下链接,在手机里面部署一下

然后就可以部署成功了:

2.1在 InternLM Studio 上部署茴香豆技术助手

我是在autodl是租用的服务器来运行这次demo的,实在是一波三折啊,太难了,后续还是对操作文档的一句一句细致的精读,慢慢的理解思考,才最后解决了问题,成功部署!

下面简单的介绍一下部署流程吧:原始操作文档为Tutorial/huixiangdou/readme.md at camp2 · InternLM/Tutorial (github.com)

A:环境配置

conda创建一个新的虚拟环境Huixiangdou

conda create -n Huixiangdou python=3.10.14运行conda命令,激活 Huixiangdou虚拟环境

conda activate Huixiangdou

运行requirements.txt文件,安装相应版本的库

pip install -r requirements.txt

#具体的库以及版本如下

'''

protobuf==4.25.3

accelerate==0.28.0

aiohttp==3.9.3

auto-gptq==0.7.1

bcembedding==0.1.3

beautifulsoup4==4.8.2

einops==0.7.0

faiss-gpu==1.7.2

langchain==0.1.14

loguru==0.7.2

lxml_html_clean==0.1.0

openai==1.16.1

openpyxl==3.1.2

pandas==2.2.1

pydantic==2.6.4

pymupdf==1.24.1

python-docx==1.1.0

pytoml==0.1.21

readability-lxml==0.8.1

redis==5.0.3

requests==2.31.0

scikit-learn==1.4.1.post1

sentence_transformers==2.2.2

textract==1.6.5

tiktoken==0.6.0

transformers==4.39.3

transformers_stream_generator==0.0.5

unstructured==0.11.2

'''然后自己先建一个code目录放代码(我的是/root/autodl-tmp/RAG/code/)

建一个model目录放模型 (我的是/root/autodl-tmp/RAG/model/

B:模型下载

此demo需要用到以下三个模型,下载方式如下代码注释:

#bce-embedding-base_v1

建议直接去huggingface网站下载然后拉过去服务器:

https://huggingface.co/maidalun1020/bce-embedding-base_v1/tree/main

#bce-reranker-base_v1

建议直接去huggingface网站下载然后拉过去服务器:

https://huggingface.co/maidalun1020/bce-reranker-base_v1/tree/main

#InternLM2-Chat-7B

使用model-scope下载

import os

from modelscope.hub.snapshot_download import snapshot_download

# save_dir是模型保存到本地的目录

save_dir="/root/autodl-tmp/RAG/model"

# 下载InternLM2-Chat-7B

snapshot_download('Shanghai_AI_Laboratory/InternLM2-Chat-7B',

cache_dir=save_dir,

revision='v1.1.0')C:代码下载

从github中clone茴香豆的源码(路径要清晰一些)

#下载茴香豆代码

cd /root/autodl-tmp/RAG/code/ #cd 打开目录

# 下载 repo

git clone https://github.com/internlm/huixiangdou && cd huixiangdou #cd 打开目录 没有就自动创建

git checkout 447c6f7e68a1657fce1c4f7c740ea1700bde0440

下完代码,记得用已下载模型的路径替换 /root/huixiangdou/config.ini 文件中的默认模型,需要修改 3 处模型地址,分别是:

修改用于向量数据库和词嵌入的模型bce-embedding-base_v1

以及用于检索的重排序模型bce-reranker-base_v1

和本次选用的大模型InternLM2-Chat-7B

D:茴香豆的知识库创建

然后下载茴香豆的基本语料到/root/autodl-tmp/RAG/code/huixiangdou/repodir下面,创建本地的知识库。repodir就是茴香豆的本地语料库(还没有转换成向量数据库workdir)。

本示例中,使用 InternLM 的 Huixiangdou 文档还有mmpose和testdata作为新增知识数据检索来源,在不重新训练的情况下,打造一个 Huixiangdou 技术问答助手。

所谓的语料也就是新增知识数据,也就是这个小逼崽子的饲料,拿这些语料去数据去喂它它才能知道这么回答你问题(本地的语料数据库)----(后面会教你接通互联网,就可以直接用外界互联网的数据库来补充茴香豆的知识库)下面源码中带有解释自行查看吧

#首先,下载 Huixiangdou 语料

cd /root/autodl-tmp/RAG/code/huixiangdou && mkdir repodir

git clone https://github.com/internlm/huixiangdou --depth=1 repodir/huixiangdou

git clone https://github.com/open-mmlab/mmpose --depth=1 repodir/mmpose

git clone https://github.com/tpoisonooo/huixiangdou-testdata --depth=1 repodir/testdata

#以上源码解释:(来自poe)

#--depth=1 repodir/huixiangdou:是 Git 命令中的一个选项,表示只克隆最近的一层提交历史。

#使用该选项可以将克隆的仓库历史限制为最近的一次提交,而不会包含完整的提交历史记录。这样可以减少克隆操作所需的时间和网络带宽。

#repodir/huixiangdou 是指定克隆操作的目标路径。在这个命令中,

#它表示将克隆的仓库存储在 repodir 目录下,并将其命名为 huixiangdou。(mmpose和testdata也是一样)

除了以上语料知识的向量数据库,茴香豆建立接受和拒答两个向量数据库,用来在检索的过程中更加精确的判断提问的相关性(大概意思就是,其实茴香豆的应用是基于微信群聊以及飞书群聊中的智能助手,在群聊中大部分群友的对话其实是闲聊,不需要茴香豆回答,所以为了避免误触发茴香豆,设置这个打分相关性机制来判断茴香豆是否需要回答该问题。

这里的话,具体的理论详见我的前几篇博客:书生·浦语大模型实战训练营第二期第三节:RAG基础理论与茴香豆部署--notebook-CSDN博客)

这两个数据库的来源分别是:

- 接受问题列表,希望茴香豆助手回答的示例问题

- 存储在

huixiangdou/resource/good_questions.json中

- 存储在

- 拒绝问题列表,希望茴香豆助手拒答的示例问题

- 存储在

huixiangdou/resource/bad_questions.json中 - 其中多为技术无关的主题或闲聊

- 如:"nihui 是谁", "具体在哪些位置进行修改?", "你是谁?", "1+1"

- 存储在

运行下面的命令,增加茴香豆相关的问题到接受问题示例(good_questions.json)中:

#运行下面的命令,增加茴香豆相关的问题到接受问题示例中

cd /root/autodl-tmp/RAG/code/huixiangdou

mv resource/good_questions.json resource/good_questions_bk.json

#这个命令的作用是将名为 good_questions.json 的文件移动到名为 good_questions_bk.json 的文件。

#mv 是一个命令,用于移动文件或重命名文件,这样,原始文件被备份为 good_questions_bk.json。

echo '[

"mmpose中怎么调用mmyolo接口",

"mmpose实现姿态估计后怎么实现行为识别",

"mmpose执行提取关键点命令不是分为两步吗,一步是目标检测,另一步是关键点提取,我现在目标检测这部分的代码是demo/topdown_demo_with_mmdet.py demo/mmdetection_cfg/faster_rcnn_r50_fpn_coco.py checkpoints/faster_rcnn_r50_fpn_1x_coco_20200130-047c8118.pth 现在我想把这个mmdet的checkpoints换位yolo的,那么应该怎么操作",

"在mmdetection中,如何同时加载两个数据集,两个dataloader",

"如何将mmdetection2.28.2的retinanet配置文件改为单尺度的呢?",

"1.MMPose_Tutorial.ipynb、inferencer_demo.py、image_demo.py、bottomup_demo.py、body3d_pose_lifter_demo.py这几个文件和topdown_demo_with_mmdet.py的区别是什么,\n2.我如果要使用mmdet是不是就只能使用topdown_demo_with_mmdet.py文件,",

"mmpose 测试 map 一直是 0 怎么办?",

"如何使用mmpose检测人体关键点?",

"我使用的数据集是labelme标注的,我想知道mmpose的数据集都是什么样式的,全都是单目标的数据集标注,还是里边也有多目标然后进行标注",

"如何生成openmmpose的c++推理脚本",

"mmpose",

"mmpose的目标检测阶段调用的模型,一定要是demo文件夹下的文件吗,有没有其他路径下的文件",

"mmpose可以实现行为识别吗,如果要实现的话应该怎么做",

"我在mmyolo的v0.6.0 (15/8/2023)更新日志里看到了他新增了支持基于 MMPose 的 YOLOX-Pose,我现在是不是只需要在mmpose/project/yolox-Pose内做出一些设置就可以,换掉demo/mmdetection_cfg/faster_rcnn_r50_fpn_coco.py 改用mmyolo来进行目标检测了",

"mac m1从源码安装的mmpose是x86_64的",

"想请教一下mmpose有没有提供可以读取外接摄像头,做3d姿态并达到实时的项目呀?",

"huixiangdou 是什么?",

"使用科研仪器需要注意什么?",

"huixiangdou 是什么?",

"茴香豆 是什么?",

"茴香豆 能部署到微信吗?",

"茴香豆 怎么应用到飞书",

"茴香豆 能部署到微信群吗?",

"茴香豆 怎么应用到飞书群",

"huixiangdou 能部署到微信吗?",

"huixiangdou 怎么应用到飞书",

"huixiangdou 能部署到微信群吗?",

"huixiangdou 怎么应用到飞书群",

"huixiangdou",

"茴香豆",

"茴香豆 有哪些应用场景",

"huixiangdou 有什么用",

"huixiangdou 的优势有哪些?",

"茴香豆 已经应用的场景",

"huixiangdou 已经应用的场景",

"huixiangdou 怎么安装",

"茴香豆 怎么安装",

"茴香豆 最新版本是什么",

"茴香豆 支持哪些大模型",

"茴香豆 支持哪些通讯软件",

"config.ini 文件怎么配置",

"remote_llm_model 可以填哪些模型?"

]' > /root/autodl-tmp/RAG/code/huixiangdou/resource/good_questions.json

#这就是添加上面的echo进入到good_questions.json文件

在完成上面的步骤后,茴香豆的基本语料就已经确定了并保存在/root/autodltmp/RAG/code/huixiangdou/repodir下。

然而,我们的知识库却没有搭建完成,因为目前我们“喂”给茴香豆的是基本语料也就是原始文件,比如“机器学习书籍/Intermlm技术报告”等我们人类看的懂的东西;但是大模型是看不懂的,我们需要将这些基本语料通过huixiangdou中的代码huixiangdou/service/feature_store.py转换为向量数据库workdir!

所以,运行下面的命令,创建 RAG 检索过程中使用的向量数据库workdir

# 在huixiangdou目录下创建向量数据库存储目录workdir,用此命令"&& mkdir workdir"

cd /root/autodl-tmp/RAG/code/huixiangdou && mkdir workdir

# 分别向量化知识语料、接受问题和拒绝问题中后保存到 workdir

python3 -m huixiangdou.service.feature_store好的,至此,我们的茴香豆RAG助手就基本创建完啦!(真的吗真的吗真的吗?手动狗头)

E:运行茴香豆知识助手

# 填入问题

sed -i '74s/.*/ queries = ["huixiangdou 是什么?", "茴香豆怎么部署到微信群", "今天天气怎么样?"]/' /root/autodl-tmp/RAG/code/huixiangdou/huixiangdou/main.py

# 运行茴香豆

cd /root/autodl-tmp/RAG/code/huixiangdou/

python3 -m huixiangdou.main --standalone

# 代码解释

'''

这个命令使用 sed 工具来编辑 /root/autodl-tmp/RAG/code/huixiangdou/huixiangdou/main.py 文件。下面是对命令的解释:

sed: 是一个流式文本编辑器,用于对文本进行处理和编辑。

-i: 是 sed 命令的选项,表示直接在原始文件上进行编辑,而不是输出到标准输出。

'74s/.*/ queries = ["huixiangdou 是什么?", "茴香豆怎么部署到微信群", "今天天气怎么样?"]/': 这是 sed 命令的编辑操作部分。其中的 74 表示替换文件中的第 74 行,s 表示替换操作,.* 表示匹配任意字符(即原来的内容),然后将其替换为 queries = ["huixiangdou 是什么?", "茴香豆怎么部署到微信群", "今天天气怎么样?"]。

/root/autodl-tmp/RAG/code/huixiangdou/huixiangdou/main.py: 是要进行编辑的文件路径。

'''好滴,一般情况下,大家都能顺利跑出来结果的哈:大概就是下面这个样子:

大家可以看到圈红的地方,其实就是茴香豆的回答啦,前面是“ErrorCode:SUCCESS”就说明检索到了与问题“huixiangdou是什么”相关的回答,而且打分高于你设置的拒答阈值,就能顺利回答啦

下面是我自己的运行结果,问了三个问题:

要回答的问题:"huixiangdou 是什么?", "茴香豆怎么部署到微信群"(技术问题)

下面回答的很好

不应该回答的问题:"今天天气怎么样?"(闲聊话题)

然后它直接不鸟你“ErrorCode:UNRELATED”,说不相关,拒答!

好问题!当茴香豆检索到问题并进行打分之后,可回答性的评分高于你设置的拒答阈值,那就可以回答并输出相关性最高的回答。那要是回答不了(也就是拒答),只在那分析打分,那就是拒答阈值太高了,哪个问题它都觉得不是问题直接不回了,自己调小一点就好。

修改下面这个huixiangdou/config.ini的[feature_store]下的reject_throttle就行,降低点就好。

解释如下:reject_throttle: 拒答阈值,0-1,数值越大,回答的问题相关性越高。拒答分数在检索过程中通过与示例问题的相似性检索得出,高质量的问题得分高,无关、低质量的问题得分低。只有得分数大于拒答阈值的才会被视为相关问题,用于回答的生成。当闲聊或无关问题较多的环境可以适当调高。

F:加入网络搜索(让你的茴香豆接入互联网!让互联网成为你的知识库!)

茴香豆除了可以从本地向量数据库中检索内容进行回答,也可以加入网络的搜索结果,生成回答。开启网络搜索功能需要用到 Serper 提供的 API:(自己去Serper - API key搞一个就行)

然后把/huixiangdou/config.ini中的代码改一下:

替换 /huixiangdou/config.ini 中的 ${YOUR-API-KEY} 为自己的API-key

然后就OK啦,下面用的茴香豆就会接入互联网,利用互联网的信息结合LLM来回答你的问题啦!

G:利用gradio搭建网页版茴香豆demo

先安装组件

pip install gradio==4.25.0 redis==5.0.3 flask==3.0.2 lark_oapi==1.2.4再直接运行huixiangdou中的已经写好的gradio代码文件就好了

cd /root/autodl-tmp/RAG/code/huixiangdou/

python3 -m tests.test_query_gradio

此时服务器端接口已开启。如果在本地服务器使用,直接在浏览器中输入 127.0.0.1:7860 ,即可进入茴香豆对话 Demo 界面。

运行成功!!!

H:补充一下对整个huixiangdou代码文件的解读:

通过了解主要文件的位置和作用,可以更好的理解茴香豆的工作原理。

.

├── LICENSE

├── README.md

├── README_zh.md

├── android

├── app.py

├── config-2G.ini

├── config-advanced.ini

├── config-experience.ini

├── config.ini # 配置文件

├── docs # 教学文档

├── huixiangdou # 存放茴香豆主要代码,重点学习

├── huixiangdou-inside.md

├── logs

├── repodir # 默认存放个人数据库原始文件,用户建立

├── requirements-lark-group.txt

├── requirements.txt

├── resource

├── setup.py

├── tests # 单元测试

├── web # 存放茴香豆 Web 版代码

└── web.log

└── workdir # 默认存放茴香豆本地向量数据库,用户建立./huixiangdou

├── __init__.py

├── frontend # 存放茴香豆前端与用户端和通讯软件交互代码

│ ├── __init__.py

│ ├── lark.py

│ └── lark_group.py

├── main.py # 运行主贷

├── service # 存放茴香豆后端工作流代码

│ ├── __init__.py

│ ├── config.py #

│ ├── feature_store.py # 数据嵌入、特征提取代码

│ ├── file_operation.py

│ ├── helper.py

│ ├── llm_client.py

│ ├── llm_server_hybrid.py # 混合模型代码

│ ├── retriever.py # 检索模块代码

│ ├── sg_search.py # 增强搜索,图检索代码

│ ├── web_search.py # 网页搜索代码

│ └── worker.py # 主流程代码

└── version.py茴香豆工作流中用到的 Prompt 位于 huixiangdou/service/worker.py 中。可以根据业务需求尝试调整 Prompt,打造你独有的茴香豆知识助手。(也就是茴香豆的整个应答流程是在worker.py中编制的,我也就是看了这个玩意,才懂为啥我一直跑不出来回答www)

...

# Switch languages according to the scenario.

if self.language == 'zh':

self.TOPIC_TEMPLATE = '告诉我这句话的主题,直接说主题不要解释:“{}”'

self.SCORING_QUESTION_TEMPLTE = '“{}”\n请仔细阅读以上内容,判断句子是否是个有主题的疑问句,结果用 0~10 表示。直接提供得分不要解释。\n判断标准:有主语谓语宾语并且是疑问句得 10 分;缺少主谓宾扣分;陈述句直接得 0 分;不是疑问句直接得 0 分。直接提供得分不要解释。' # noqa E501

self.SCORING_RELAVANCE_TEMPLATE = '问题:“{}”\n材料:“{}”\n请仔细阅读以上内容,判断问题和材料的关联度,用0~10表示。判断标准:非常相关得 10 分;完全没关联得 0 分。直接提供得分不要解释。\n' # noqa E501

self.KEYWORDS_TEMPLATE = '谷歌搜索是一个通用搜索引擎,可用于访问互联网、查询百科知识、了解时事新闻等。搜索参数类型 string, 内容是短语或关键字,以空格分隔。\n你现在是{}交流群里的技术助手,用户问“{}”,你打算通过谷歌搜索查询相关资料,请提供用于搜索的关键字或短语,不要解释直接给出关键字或短语。' # noqa E501

self.SECURITY_TEMAPLTE = '判断以下句子是否涉及政治、辱骂、色情、恐暴、宗教、网络暴力、种族歧视等违禁内容,结果用 0~10 表示,不要解释直接给出得分。判断标准:涉其中任一问题直接得 10 分;完全不涉及得 0 分。直接给得分不要解释:“{}”' # noqa E501

self.PERPLESITY_TEMPLATE = '“question:{} answer:{}”\n阅读以上对话,answer 是否在表达自己不知道,回答越全面得分越少,用0~10表示,不要解释直接给出得分。\n判断标准:准确回答问题得 0 分;答案详尽得 1 分;知道部分答案但有不确定信息得 8 分;知道小部分答案但推荐求助其他人得 9 分;不知道任何答案直接推荐求助别人得 10 分。直接打分不要解释。' # noqa E501

self.SUMMARIZE_TEMPLATE = '{} \n 仔细阅读以上内容,总结得简短有力点' # noqa E501

# self.GENERATE_TEMPLATE = '材料:“{}”\n 问题:“{}” \n 请仔细阅读参考材料回答问题,材料可能和问题无关。如果材料和问题无关,尝试用你自己的理解来回答问题。如果无法确定答案,直接回答不知道。' # noqa E501

self.GENERATE_TEMPLATE = '材料:“{}”\n 问题:“{}” \n 请仔细阅读参考材料回答问题。' # noqa E501

...二、进阶作业

A.【应用方向】 结合自己擅长的领域知识(游戏、法律、电子等)、专业背景,搭建个人工作助手或者垂直领域问答助手,参考茴香豆官方文档,部署到下列任一平台。

1.我这里是使用了茴香豆Web版进行部署,后续会使用微信进行部署。

首先是打开Apps-OpenXLab

输入自己的账号和密码

然后在知识库文档处上传自己的知识库,这里我上传的是混凝土和建筑设计规范;

然后它就拥有了这些规范的知识了,在web端问一下它:

然后它就拥有了这些规范的知识了,在web端问一下它:

他就能根据自己上传的知识库进行解答了!

后续还可以继续补充完善自己的知识库,搭建一个基于建筑行业领域的问答助手!

2.部署在微信

他也能基本按照上传的规范进行答题!

他也能基本按照上传的规范进行答题!

665

665

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?