1.TD-LSTM与TC-LSTM

论文:Effective LSTMs for Target-Dependent Sentiment Classification

方法:

TD-LSTM 模型:

作者使用两个LSTM,一个从前到后输入左侧文本+target,另一个从后到前输入右侧文本+target。然后,作者将两个LSTM最后一个时间步的隐态向量拼接送入softmax进行分类。

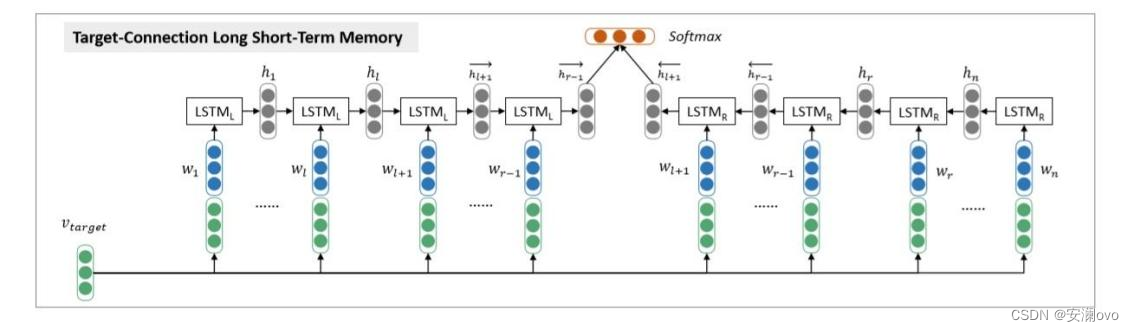

2.TC-LSTM

论文:Effective LSTMs for Target-Dependent Sentiment Classification

方法:TD-LSTM不能很好地捕捉到target和上下文之间相互关系,因此提出TC-LSTM。作者先得到target向量。如果target由多个词组成,则对多个词的向量取平均,得到target向量。然后,作者将target向量拼接在TD-LSTM输入的每个词向量上,作为TC-LSTM的输入。该模型可以更好地利用target及其上下文之间的关系。

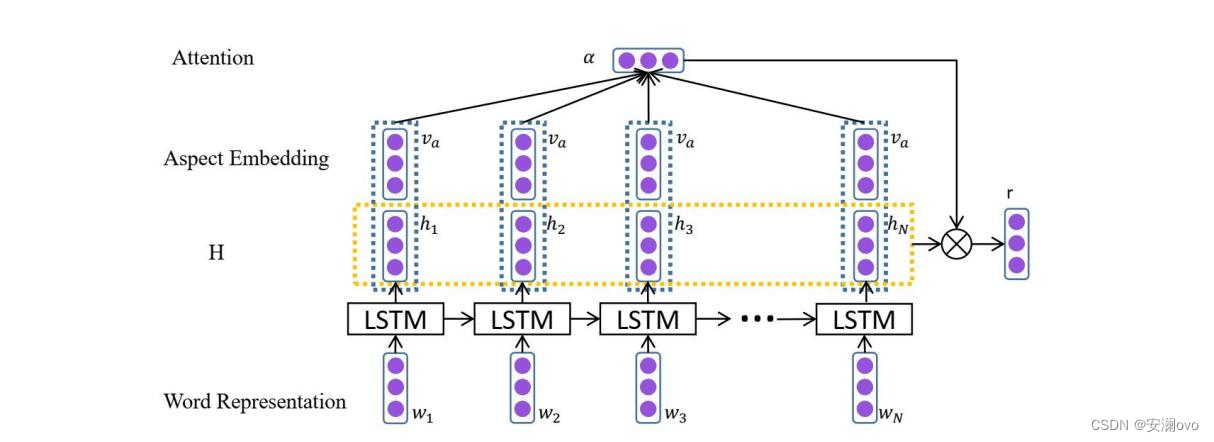

3.AT-LSTM

3.AT-LSTM

论文:Attention-based LSTM for Aspect-level Sentiment Classification

在AT-LSTM中,句子中的每个词首先被转换成词向量表示,使用LSTM编码得到隐层状态。使用一个可学习的参数向量作为query,aspect的embedding经过线性变换后的表示和隐层状态的拼接作为key,隐层状态作为value计算attention。输出的上下文向量和最后一个隐层状态拼接后做一次非线性变换得到最终的分类特征,再经过一个softmax分类器预测每个类别的概率分布。

ATAE-LSTM相比AT-LSTM,为了更好地利用aspect的信息,在embedding层将每个词的embedding和aspect的embedding进行拼接,得到aspect相关的词表示。后续的操作和AT-LSTM一样。

4.AA-LSTM

论文:Earlier Attention? Aspect-Aware LSTM for ABSA

方法:提出了一种LSTM变体,称为aspect敏感的LSTM (aspect-aware LSTM,AA-LSTM),它在attention机制之前的上下文建模阶段将aspect的关联信息合并到LSTM单元中。AA-LSTM可以动态地生成aspect敏感的上下文表示。

结构:传统的LSTM包含三个门(输入门、遗忘门和输出门)来控制信息流。本文将方面(aspect)信息融入到LSTM单元中以改进信息流,其中在集成到LSTM的三个门中的aspect的程度应该是不同的。本文设计了三个aspect门来控制有多少aspect向量分别导入到输入门、遗忘门和输出门中,利用隐状态和aspect本身来控制在LSTM的三个门中导入多少aspect。

原理:

Input gates

输入门It控制新信息进入细胞当前状态的总量,方面输入门(aspect-input gates)ai控制aspect被传输到细胞状态的比重。AA-LSTM与普通LSTM的区别在于It中方面向量(aspect vector)的引入。方面向量ai的输入权重计算来源于ht-1和A。ht-1可以看作是在过去的时间步骤中处理过的部分的句子语义表示。因此,It中方面信息的引入决定于上一步的语义表征和方面A。

forget gates

遗忘门ft舍弃冗余信息并保留来自上一个细胞状态的重要信息Ct-1., 方面输入门(aspect-foget gates)af 控制aspect被传输到遗忘门ft的比重。ft中AA-LSTM与普通LSTM的区别在于ft中方面向量(aspect vector)的引入。方面向量af的权重计算来源于ht-1和A。

Candidate Cell and Current Cell

表示单元的候选输入内容。Ct表示当前单元状态,通过选择来自上一个单元状态Ct-1和更新。

取决于上一时间步的隐状态ht-1和输入嵌入xt。在传统的LSTM中,对整个句子语义更重要的信息更有可能被保存在后面的时间步的隐状态向量中。然而,对于一些由于对整个句子的语义有贡献而被保留下来的信息,当判断某个aspect的情绪极性时,它可能是有噪声。而对于分析某一aspect的情绪至关重要的信息可能会被忽略,因为它对整个句子的贡献较小。本文将这种现象定义为上下文建模过程中的一个aspect不敏感问题(aspect-unaware problem)。

AA-LSTM可以通过在建模上下文的过程中引入aspect来控制信息流来解决上述问题。在隐状态向量中,可以保留对预测给定aspect的情感极性很重要的信息,同时如公式6,候选的输入文本中不包含aspect信息。因此AA-LSTM只借助给定aspect来影响信息流,而非将aspect信息融入到隐向量中。

output Gates

输出门ot控制当前单元状态到隐向量的信息流。方面输出门(aspect-output gate)ao控制aspect对输出门ot的影响。Aspect的权重ao取决于ht-1和A。

5.RTE

论文:Target Embedding and Position Attention with LSTM for Aspect Based Sentiment Analysis

方法:

与传统情感分析相比,基于方面的情感分析(ABSA)提供了细粒度的情感信息。该任务有两种方法:方面术语情感分析 (ATSA) 和方面类别情感分析 (ACSA)。在本文中,我们提出了一种模型,即带有目标嵌入的循环神经网络(RTE),使用目标增强技术来提高两种方法的准确性。具体来说,RTE 涉及两个用于目标术语提取和情感分析的堆叠 LSTM,以及一个用于传播目标或方面信息的目标增强单元。在多个公共数据集上进行了实验,结果表明所提出的 RTE 优于几个最先进的模型。

8064

8064

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?