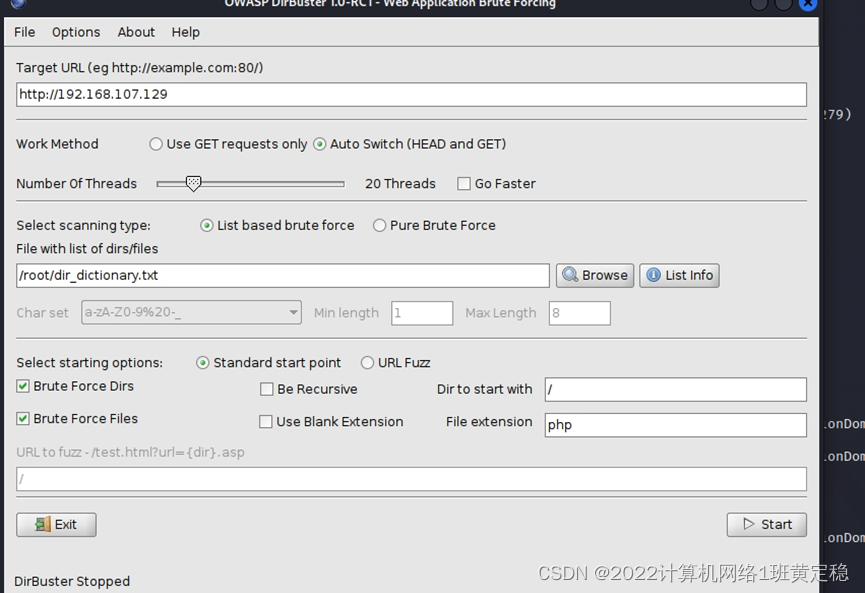

使用DirBuster寻找敏感文件和目录

DirBuster是一款安全工具,通过暴力或者表单进行来发现Web服务器中现有文件和目录。我们将在文中使用它来搜索特定的文件和目录列表。

准备:

我们要使用一个文本文件,其中包含我们要用DirBuster来查找的文件列表。创建一个包含以下

内容的文本文件 dir_dictionary.txt

info

server-status

server-info

cgi-bin

robots.txt

phpnyadn in

aduin

login

实战:

DirBuster是一款使用Java语言写的应用程序,它可以从 Kali的主菜单或在终端使用dirbuster命令来使用。以下是使用它所需的步骤:

1.找到Applications |03-Web Application Analysis|Web Crawlers&DirectoryBruteforcing|

Dirbuster。(注:按照这个路径在Kali可能无法找到,但是你可以在终端下输入dirbuster命令打开这个软件)

2.在DirBuster窗口中,将目标URL设置为靶机http://192.168.56.11/

3.将线程数设置为20,以获得不错的测试速度。

4.选择基于列表的暴力破解,然后单击“浏览”。

5.在浏览窗口中,选择我们刚刚创建的文件(dir_dictionary.txt)

6.取消选中 Be Recursive(递归)选项。

7.对于这个配置,我们将其余选项保留为默认值。

8.点击Start(开始)。

9.如果我们转到结果选项卡,我们将看到 DirBuster在我们的字典中找到了至少两个文件夹:

cgi-bin和gtd-php。响应码200表示文件或目录存在并且可以被读取。Phpmyadmin是一个基于Web

的mysql数据库,查找一个带有tis名称的目录告诉我们服务器中有一个数据库管理系统

(DBMS),它可能包含有关应用程序及其用户的相关信息。

10.搜索结果生成一份报告(Report),并将报告文件提交。

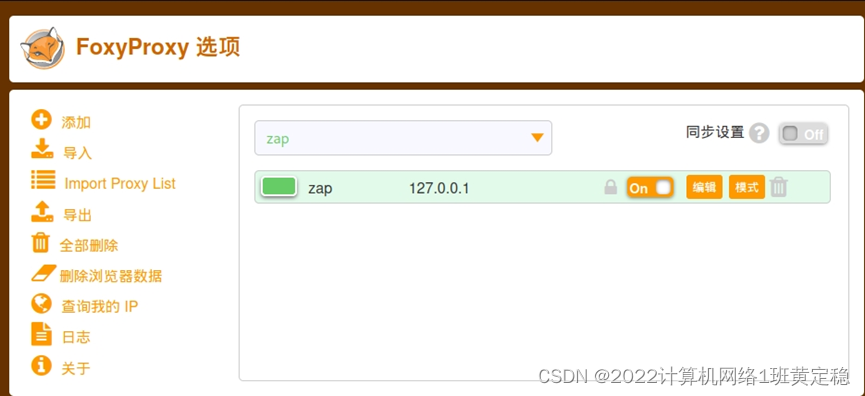

使用ZAP寻找敏感文件和目录

准备:

为了使这个程序工作,我们需要使用ZAP作为我们的Web浏览器的代理

1.从Kali Linux菜单启动OWASP ZAP,然后选择Applications|03-Web Application Analysis|owasp-zap或者打开终端并输入owasp-zap命令。

2.接下来,我们将更改ZAP的代理设置。默认情况下,它使用端口8080,这是可以的,但是如果我们让ZAP和Burp Suite同时运行,则会干扰Burp Suite等其他代理。在ZAP中,转到Tools|Options| Local Proxies并将端口更改为8088

3.现在,在Firefox中,转到主菜单并导航到Preferences| Advanced|Network;在Connection中,单击Settings。

4.选择手动代理配置,并将HTTP代理设置为127.0.0.1,将端口设置为8088。选中该选项以对所有协议使用相同的代理,然后单击OK:

5.我们还可以使用FoxyProxy插件设置多个代理设置,切换他们只需点击一下:

(注:各个工具使用不同代理端口,避免冲突。zap代理端口为8088,burp代理端口为8080,WebSca代理端口为8008)

实战:

1.正确配置代理后,浏览到http://192.168.xxx.xxx/WackoPicko/

2.我们将看到ZAP通过显示我们刚访问过的主机的树结构来对此操作做出反应。

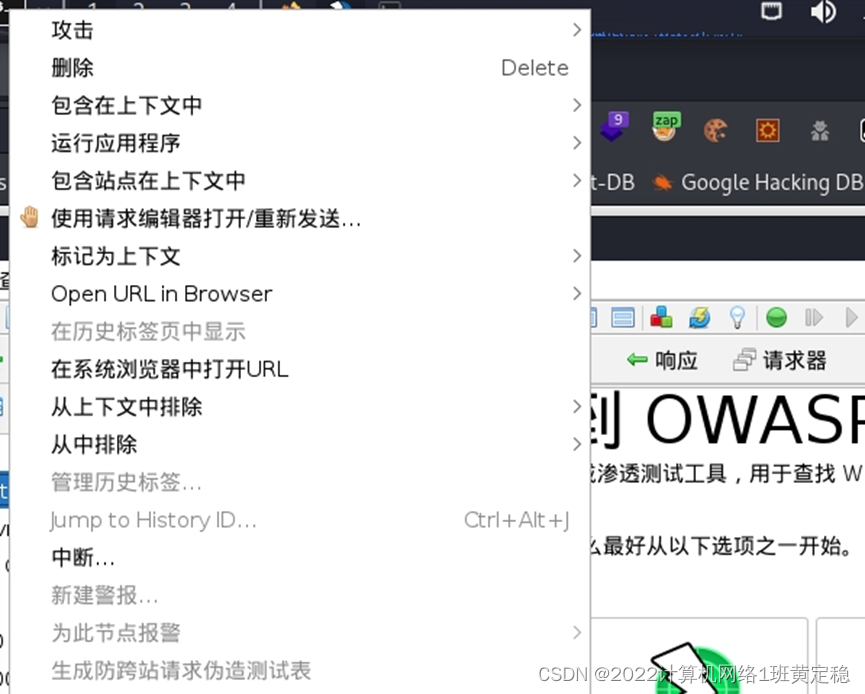

3.现在,在ZAP的左上角面板(“站点”选项卡)中,在http://192.168.xxx.xxx网站内右键单击WackoPicko文件夹。然后,在上下文菜单中,导航到Attack(攻击)|强制浏览目录(和子目录),这将进行递归扫描:

4.如果在底部面板中的list(列表)菜单没有选择列表文件,选择列表文件后再进行上述扫描。我们将看到Forced Browse(强制浏览)选项卡上显示的扫描进度及其结果:

使用Burp Suite 查看和修改请求

准备:

从应用程序菜单中启动Burp Suite,应用程序 |03-Web Application Analy|Burp Suite,或者在终端输入命令burpsuite来启动。启动后还要设置浏览器使用8080的代理端口。

实战:

现在让我们使用这种拦截/修改技术来绕过基本的保护机制。执行以下步骤:

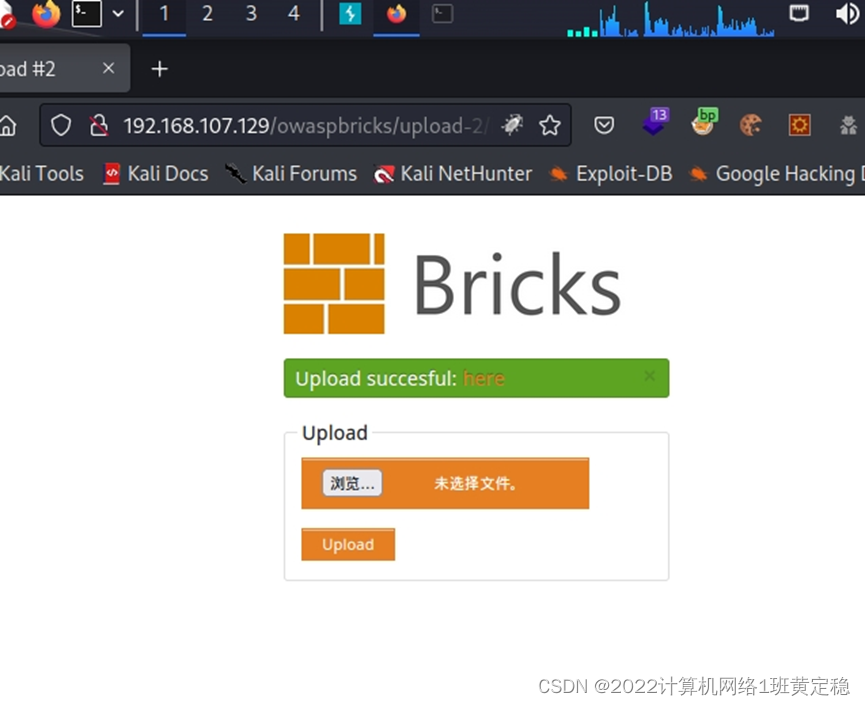

1.浏览OWASP板块,并练习 Upload 2

(http://192.168.xxx.xxx/owaspbricks/upload-2).

2.请求拦截功能在 Burp Suite 中默认启用,如果没有拦截,转到 Burp Suite | proxy|

Intercept on,点击下按钮,拦截打开:

3.这里我们有一个文件上传表单,应该只能上传图片。我们来试着上传一个。点击浏览并选择任何图像文件(PNG、JPG或BMP):

4.点击 Open后,再点Upload,验证文件上传:

5.现在我们看看如果我们上传不同类型的文件会发生什么,比如说,一个HTML文件:

4077

4077

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?