↵

1.sklearn数据集与估计器

1)数据集划分

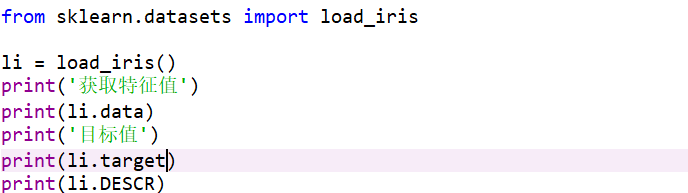

sklearn.datasets(scikit-lern数据集API),加载获取流行数据集;datasets.load_*():获取小规模数据集,数据包含在databases里;datasets.fetch_*(data_home=None):获取大规模数据集,需要从网络上下载,函数的第一个参数时data_home,表示数据集下载的目录,默认时~/scikit_learn_data/;

load*和fetch*返回的数据类型datasets.base.Bunch(字典格式)

- data:特征数据数组,时[n_sample*n_features]的二位numpy.ndarray数组;

- target:标签数组,是n_samples的一维numpy.ndarray数组;

- DESCR:数据描述;

- feature_names:特征名,新闻数据,手写数字、回归数据集

- target_names:标签名(目标值名称);

机器学习一般的数据集会划分为两个部分(sklearn.model_selection.train_test_split(*arrays, **options):

- 训练数据:用于训练,构建模型;

- 测试数据:再模型检验时使用,用于评估模型时否有效;

在对数据集进行分割时:

- x 数据集的特征值

- y 数据集的标签值

- test_size 测试集的大小,一般为float

- random_state 随机数种子,不同的种子会造成不同的随机采样结果。相同的种子采样结果相同

- return 训练集特征值,测试机特征值,训练标签,测试标签(默认随机取)

2)转换器与估计器

之前做的特征工程的步骤:1、实例化(实例化的时一个转换器类(Transformer));2、调用fit_transform(对于文档建立分类词频矩阵,不能同时调用);

- 转换器(是实现特征工程的API)

fit_transform()方法由两部分构成:1、fit();2、transform();

其中fit()方法仅保存传入的原始数据并保存经过计算的平均值、方差等计算值,而transform()方法会将传入的数据经过fit()方法保存的计算规则对transform中传入的数据进行转换;

- 估计器

在sklearn中,估计器(estimator)是一个重要的角色,时一类实现了算法的API:

(1)用于分类的估计器:

- sklearn.neighbora k-近邻算法

- sklearn.naive_bayes 贝叶斯

- sklearn.linear_model.LogisticRegeression 逻辑回归

- sklearn.tree 决策树与随机森林

(2)用于回归的估计器:

- sklearn.linear_model.LinearRegression 线性回归

- sklearn.linear_model.Ridge 岭回归

2.分类算法-k近邻算法

定义:如果一个样本空间中的k个最相似(即特征空间中最临近)的样本中的大多数属于某一个类别,则该样本也属于这个类别。(KNN算法最早时由Cover和Hart提出的一种分类算法1960Y)。

1)计算距离公式

两个样本的距离可以通过如下公式进行计算,又叫欧式距离;比如说:a(a1,a2,a3),b(b1,b2,b3)

![]()

由于数据的原因在计算欧氏距离以前我们会需要对特征值进行标准化处理;

2)k-近邻算法API(sklearn.neighbors.KNeighborsClassifier(n_neighbors=5, algorithm='auto'))

- n_neighbors:int,可选(默认= 5),k_neighbors查询默认使用的邻居数

- algorithm:{‘auto’,‘ball_tree’,‘kd_tree’,‘brute’},可选用于计算最近邻居的算法:‘ball_tree’将会使用 BallTree,‘kd_tree’将使用 KDTree。‘auto’将尝试根据传递给fit方法的值来决定最合适的算法。 (不同实现方式影响效率)

在使用K-近邻分类算法时我们还需要知道它存在的一些问题:

(1)k值取多大,有什么影响?

- k值取小时:容易受异常值的影响

- k值取大时:容易受k值数量波动的影响(由于判别归类为百分之五十)

(2)性能问题

k-近邻算法优缺点:

- 优点:简单,易于理解,易于实现,无需估计参数,无需训练

- 缺点:懒惰算法,对测试样本分类是的计算量大,内存开销大;必须指点k值,k值选择不当则分类精度不能保证

- 使用场景:小数据场景,几千~几万样本,具体场景具体业务去测试;

3)k-近邻案例分析

def knncls():

"""

K-近邻预测用户签到位置

:return:None

"""

# 读取数据

data = pd.read_csv("./data/FBlocation/train.csv")

# print(data.head(10))

# 处理数据

# 1、缩小数据,查询数据晒讯

data = data.query("x > 1.0 & x < 1.25 & y > 2.5 & y < 2.75")

# 处理时间的数据

time_value = pd.to_datetime(data['time'], unit='s')

print(time_value)

# 把日期格式转换成 字典格式

time_value = pd.DatetimeIndex(time_value)

# 构造一些特征

data['day'] = time_value.day

data['hour'] = time_value.hour

data['weekday'] = time_value.weekday

# 把时间戳特征删除

data = data.drop(['time'], axis=1)

print(data)

# 把签到数量少于n个目标位置删除

place_count = data.groupby('place_id').count()

tf = place_count[place_count.row_id > 3].reset_index()

data = data[data['place_id'].isin(tf.place_id)]

# 取出数据当中的特征值和目标值

y = data['place_id']

x = data.drop(['place_id'], axis=1)

# 进行数据的分割训练集合测试集

x_train, x_test, y_train, y_test = train_test_split(x, y, test_size=0.25)

# 特征工程(标准化)

std = StandardScaler()

# 对测试集和训练集的特征值进行标准化

x_train = std.fit_transform(x_train)

x_test = std.transform(x_test)

# 进行算法流程 # 超参数

knn = KNeighborsClassifier()

# # fit, predict,score

# knn.fit(x_train, y_train)

#

# # 得出预测结果

# y_predict = knn.predict(x_test)

#

# print("预测的目标签到位置为:", y_predict)

#

# # 得出准确率

# print("预测的准确率:", knn.score(x_test, y_test))

# 构造一些参数的值进行搜索

param = {"n_neighbors": [3, 5, 10]}

# 进行网格搜索

gc = GridSearchCV(knn, param_grid=param, cv=2)

gc.fit(x_train, y_train)

# 预测准确率

print("在测试集上准确率:", gc.score(x_test, y_test))

print("在交叉验证当中最好的结果:", gc.best_score_)

print("选择最好的模型是:", gc.best_estimator_)

print("每个超参数每次交叉验证的结果:", gc.cv_results_)

return None3.分类算法-朴素贝叶斯算法

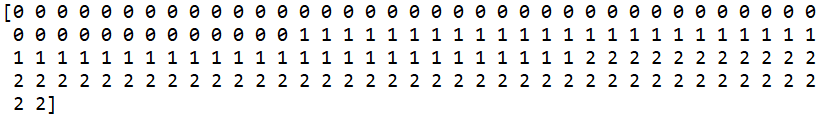

1)计算公式

注:w为给定文档的特征值(频数统计,预测文档提供),c为文档类别,公式可以理解为:![]() ,其中c可以是不同类别;使用场景:特征独立;

,其中c可以是不同类别;使用场景:特征独立;

2)概率基础

现有一篇被预测文档:出现了影院,支付宝,云计算,计算属于科技、娱乐的

类别概率?

科技:p(影院,支付宝,云计算|科技)*p(科技)= 8/100*20/100*63/100*(100/221)= 0.00456

娱乐:p(影院,支付宝,云计算|科技)*p(科技)= 56/121*15/121*0/121*(121/221)= 0

由于在文档分类过程中常常会出现概率为零的现象,如上所示;所以为了解决这种分类时出现计算概率的武断我们常常会使用拉普拉斯平滑解决:![]() ;𝛼为指定的系数α为指定的系数一般为1,m为训练文档中统计出的特征词个数;

;𝛼为指定的系数α为指定的系数一般为1,m为训练文档中统计出的特征词个数;

3)朴素贝叶斯算法API(sklearn.naive_bayes.MultinomialNB)

sklearn.naive_bayes.MultinomialNB(alpha = 1.0),其中alpha为拉普拉斯平滑系数;

4)朴素的优缺点

优点:

- 朴素贝叶斯模型发源于古典数学理论,有稳定的分类效率。

- 对缺失数据不太敏感,算法也比较简单,常用于文本分类。

- 分类准确度高,速度快

缺点:

- 需要知道先验概率P(F1,F2,…|C)(即文章中的词汇假设独立存在不存在关系),因此在某些时候会由于假设的先验模型的原因导致预测效果不佳。

- 分类精度很大程度上取决于训练集上的误差;

4.分类模型的评估

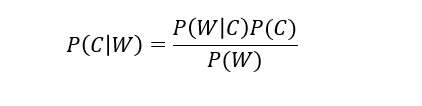

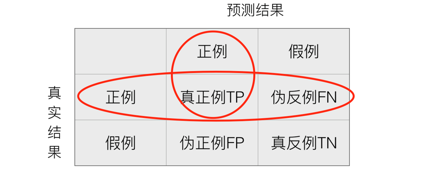

1)混淆矩阵

在分类任务下,预测结果(Predicted Condition)与正确标记(True Condition)之间存在四种不同的组合,构成混淆矩阵(适用于多分类)。

- 精确率:预测结果为正例样本中真实为正例的比例(查得准)

- 召回率:真实为正例的样本中预测结果为正例的比例(查的全,对正样本的区分能力)

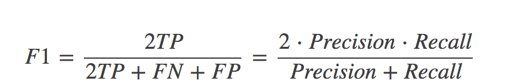

- 其它分类标准:F1-score,反映了模型的稳健型(在考虑召回率的情况下并计算伪正例的情况如何):

;

;

2)一般常用接口

(1)estimator.score():一般最常见使用的是准确率(正确分类的个数),即预测结果正确的百分比

(2)sklearn.metrics.classification_report(y_true, y_pred, target_names=None):

- y_true:真实目标值;

- y_pred:估计器预测目标值

- target_names:目标类别名称

- return:每个类别精确率与召回率

3)模型的选择与调优

(1)交叉验证:为了让被评估的模型更加准确可信;

交叉验证:将拿到的数据,分为训练和验证集。以下图为例:将数据分成5份,其中一份作为验证集。然后经过5次(组)的测试,每次都更换不同的验证集。即得到5组模型的结果,取平均值作为最终结果。又称5折交叉验证;

(2)超参数-网格搜索(sklearn.model_selection.GridSearchCV(estimator, param_grid=None,cv=None))

通常情况下,有很多参数是需要手动指定的(如k-近邻算法中的K值),这种叫超参数。但是手动过程繁杂,所以需要对模型预设几种超参数组合。每组超参数都采用交叉验证来进行评估。最后选出最优参数组合建立模型。

| K值 | K=3 | K=5 | K=7 |

| 模型 | 模型1 | 模型2 | 模型3 |

GridSearchCV:

4)朴素贝叶斯算法实例

def naviebayes():

"""

朴素贝叶斯进行文本分类

:return: None

"""

news = fetch_20newsgroups(subset='all')

# 进行数据分割

x_train, x_test, y_train, y_test = train_test_split(news.data, news.target, test_size=0.25)

# 对数据集进行特征抽取

tf = TfidfVectorizer()

# 以训练集当中的词的列表进行每篇文章重要性统计['a','b','c','d']

x_train = tf.fit_transform(x_train)

print(tf.get_feature_names())

x_test = tf.transform(x_test)

# 进行朴素贝叶斯算法的预测

mlt = MultinomialNB(alpha=1.0)

print(x_train.toarray())

mlt.fit(x_train, y_train)

y_predict = mlt.predict(x_test)

print("预测的文章类别为:", y_predict)

# 得出准确率

print("准确率为:", mlt.score(x_test, y_test))

print("每个类别的精确率和召回率:", classification_report(y_test, y_predict, target_names=news.target_names))

return None5.决策树

决策树思想的来源非常朴素,程序设计中的条件分支结构就是if-then结构,最早的决策树就是利用这类结构分割数据的一种分类学习方法。在讨论决策树的过程当中我们往往会考虑到结点的划分,也就是对结果输出做为判别的依据其中信息增益就是其中一个考虑的重点。

1)信息增益

特征A对训练数据集D的信息增益g(D,A),定义为集合D的信息熵H(D)与特征A给定条件下D的信息条件熵H(D|A)之差,

即公式为:![]() ,信息增益表示得知特征X的信息而使得类Y的信息的不确定性减少的程度;

,信息增益表示得知特征X的信息而使得类Y的信息的不确定性减少的程度;

信息熵的计算:![]() ,条件熵的计算:

,条件熵的计算:![]() ,𝐶𝑘表示属于某个类别的样本数

,𝐶𝑘表示属于某个类别的样本数

常见决策树使用的算法:

2)决策树API

•class sklearn.tree.DecisionTreeClassifier(criterion=’gini’, max_depth=None,random_state=None)

(1)sklearn.tree.export_graphviz() 该函数能够导出DOT格式

tree.export_graphviz(estimator,out_file='tree.dot’,feature_names=[‘’,’’])

(2)工具:(能够将dot文件转换为pdf、png)

安装graphviz

ubuntu:sudo apt-get install graphviz Mac:brew install graphviz

(3)运行命令然后我们运行这个命令

$ dot -Tpng tree.dot -o tree.png

3)决策树的优缺点

优点:

- 简单的理解和解释,树木可视化。

- 需要很少的数据准备,其他技术通常需要数据归一化

缺点:

- 决策树学习者可以创建不能很好地推广数据的过于复杂的树,这被称为过拟合。

- 决策树可能不稳定,因为数据的小变化可能会导致完全不同的树被生成。

改进:

- 减枝cart算法

- 随机森林

4)集成学习之随机森林

- 集成学习:集成学习通过建立几个模型组合的来解决单一预测问题。它的工作原理是生成多个分类器/模型,各自独立地学习和作出预测,这些预测最后结合成单预测,因此优于任何一个单分类的做出预测。

- 随机森林:在机器学习中,随机森林是一个包含多个决策树的分类器,并且其输出的类别是由个别树输出的类别的众数而定。

随机森林学习方式,根据下列算法而建造每棵树:

- 用N来表示训练用例(样本)的个数,M表示特征数目。

- 输入特征数目m,用于确定决策树上一个节点的决策结果,其中m应远小于M。

- 从N个训练用例(样本)中以有放回抽样的方式,取样N次,形成一个训练集(即bootstrap取样),并用未抽到的用例(样本)作预测,评估其误差。

集成学习-随机森林API:

•class sklearn.ensemble.RandomForestClassifier(n_estimators=10, criterion=’gini’,max_depth=None, bootstrap=True, random_state=None)

随机森林的优点:

- 在当前所有算法中,具有极好的准确率;

- 能够有效地运行在大数据集上;

- 能够处理具有高维特征的输入样本,而且不需要降维;

- 能够评估各个特征在分类问题上的重要性;

- 对于缺省值问题也能够获得很好得结果。

5)决策树案例

def decision():

"""

决策树对泰坦尼克号进行预测生死

:return: None

"""

# 获取数据

titan = pd.read_csv("http://biostat.mc.vanderbilt.edu/wiki/pub/Main/DataSets/titanic.txt")

# 处理数据,找出特征值和目标值

x = titan[['pclass', 'age', 'sex']]

y = titan['survived']

print(x)

# 缺失值处理

x['age'].fillna(x['age'].mean(), inplace=True)

# 分割数据集到训练集合测试集

x_train, x_test, y_train, y_test = train_test_split(x, y, test_size=0.25)

# 进行处理(特征工程)特征-》类别-》one_hot编码

dict = DictVectorizer(sparse=False)

x_train = dict.fit_transform(x_train.to_dict(orient="records"))

print(dict.get_feature_names())

x_test = dict.transform(x_test.to_dict(orient="records"))

# print(x_train)

# 用决策树进行预测

# dec = DecisionTreeClassifier()

#

# dec.fit(x_train, y_train)

#

# # 预测准确率

# print("预测的准确率:", dec.score(x_test, y_test))

#

# # 导出决策树的结构

# export_graphviz(dec, out_file="./tree.dot", feature_names=['年龄', 'pclass=1st', 'pclass=2nd', 'pclass=3rd', '女性', '男性'])

# 随机森林进行预测 (超参数调优)

rf = RandomForestClassifier()

param = {"n_estimators": [120, 200, 300, 500, 800, 1200], "max_depth": [5, 8, 15, 25, 30]}

# 网格搜索与交叉验证

gc = GridSearchCV(rf, param_grid=param, cv=2)

gc.fit(x_train, y_train)

print("准确率:", gc.score(x_test, y_test))

print("查看选择的参数模型:", gc.best_params_)

return None

331

331

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?