个人博客SkyAsh的小窝

JDK

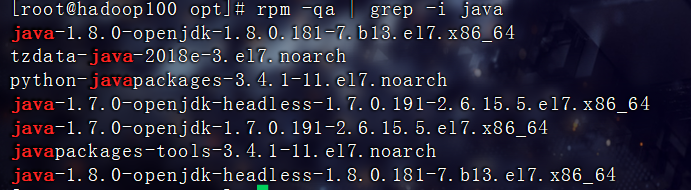

卸载原装JDK

此前的文章已经介绍了如何卸载原装的JDK

这里再写一遍

rpm -qa | grep -i java

JDK和hadoop不匹配的话是直接没法用的,所以要装配套的

如果是最小化的cdntos的话,是压根不带JDK的,也就不用这一步了

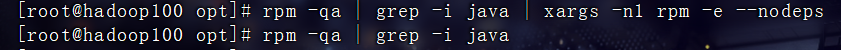

rpm -qa | grep -i java | xargs -n1 rpm -e --nodeps

- rpm -qa:查询所安装的所有 rpm 软件包

- grep -i:忽略大小写

- xargs -n1:表示每次只传递一个参数

- rpm -e –nodeps:强制卸载软件

再检验一下确实没有了

rpm -qa | grep -i java

JDK安装

软件包下载

百度云下载:

链接:百度网盘 请输入提取码

提取码:cbw4

安装过程

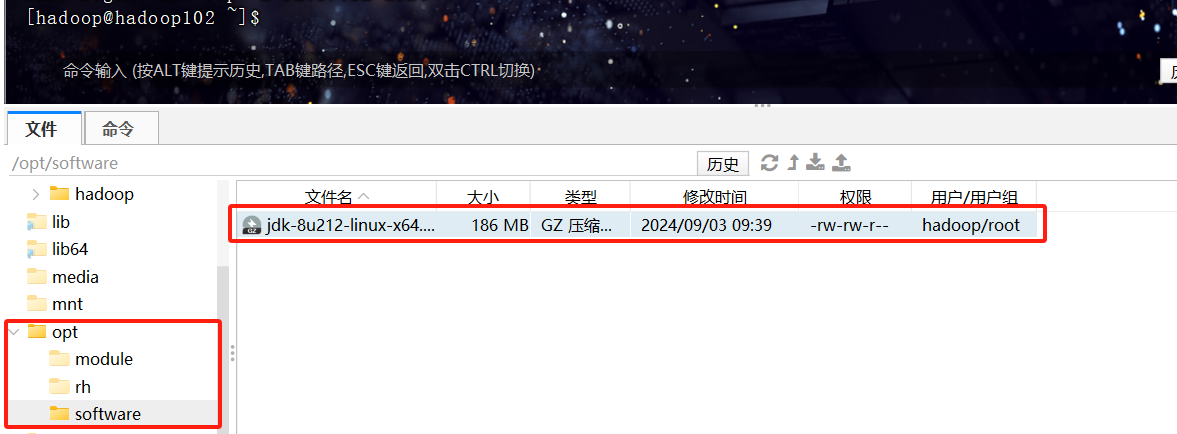

上传JDK到software目录

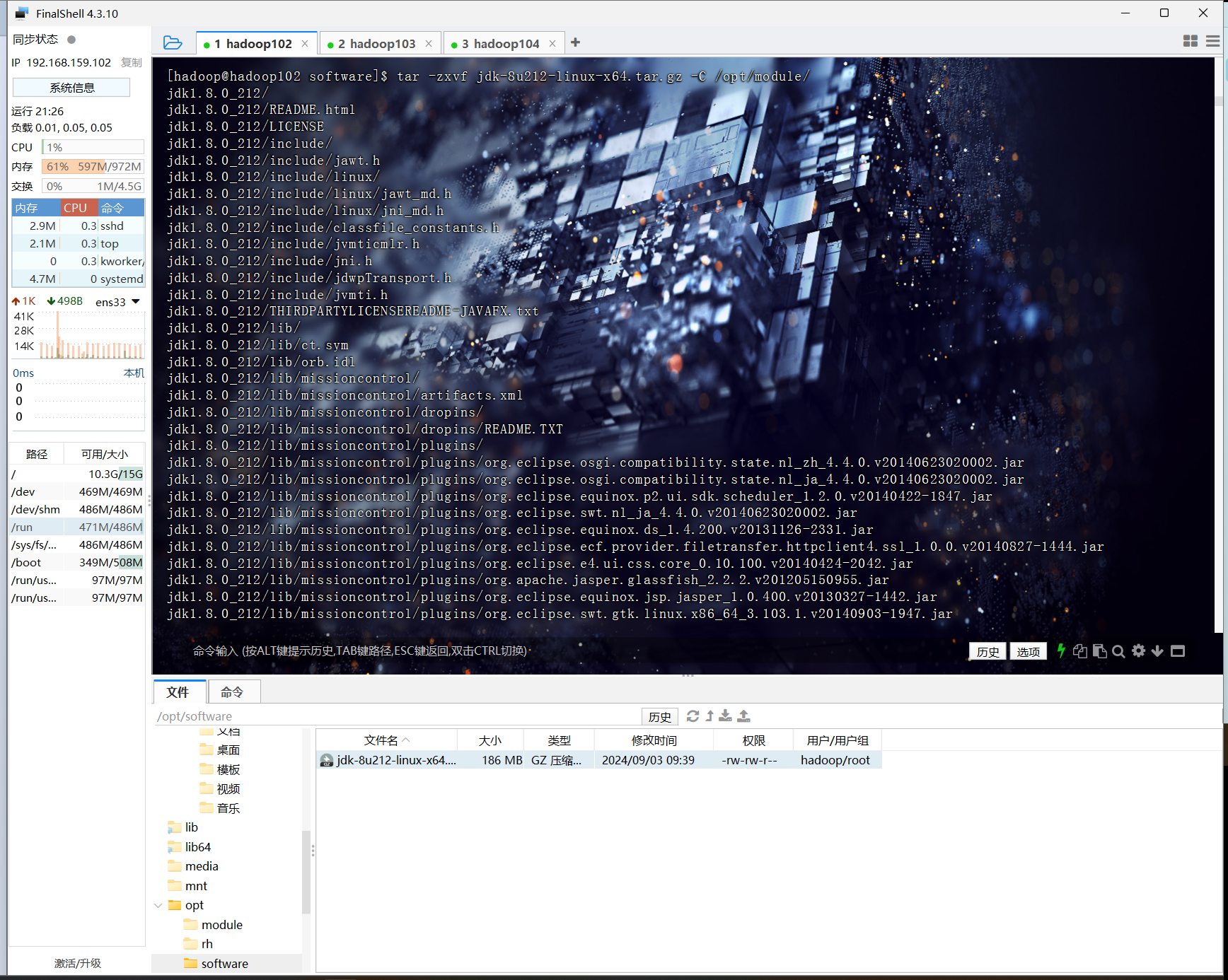

解压到module目录下

tar -zxvf jdk-8u212-linux-x64.tar.gz -C /opt/module/

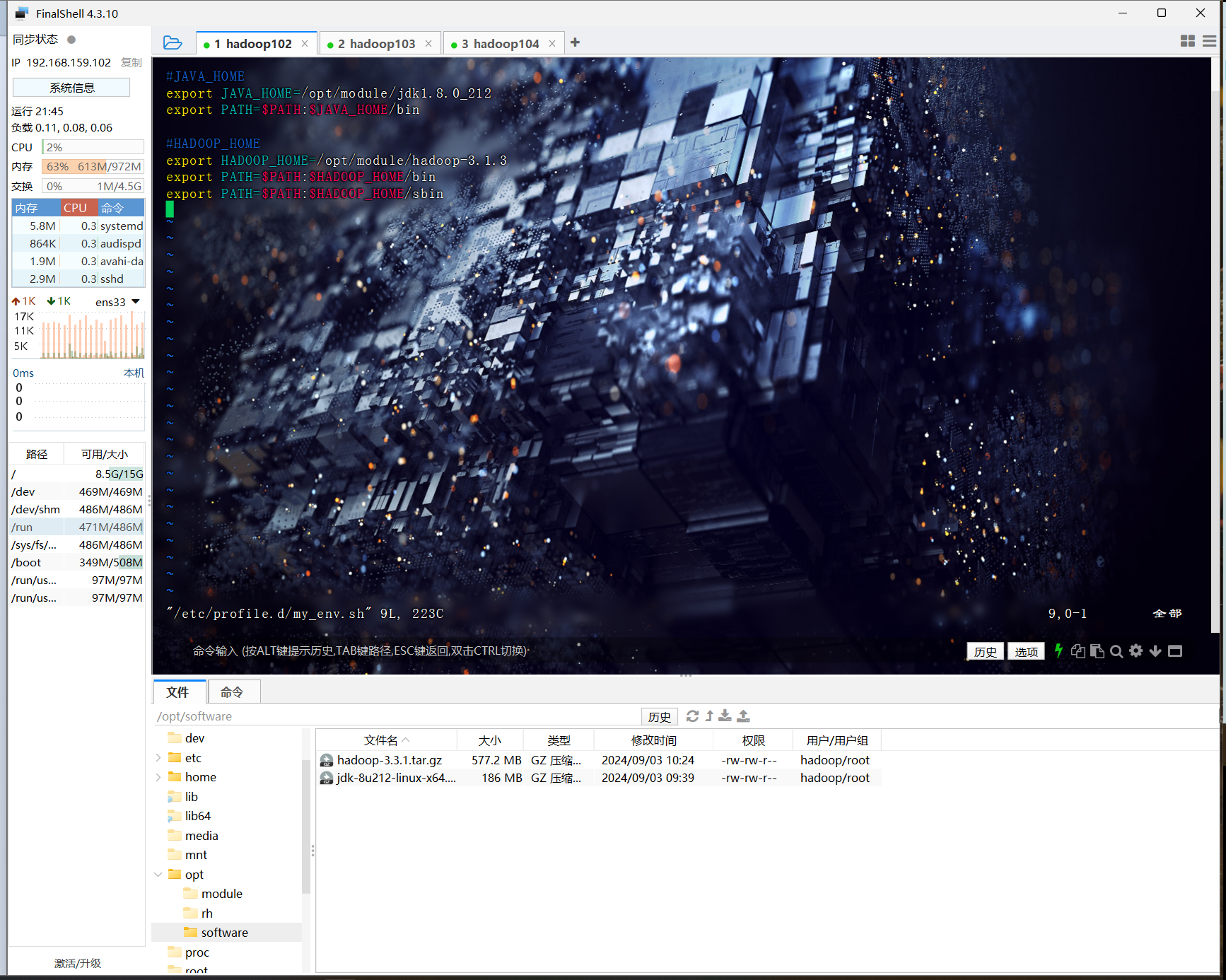

配置JDK环境变量

sudo vim /etc/profile.d/my_env.sh

加入以下内容

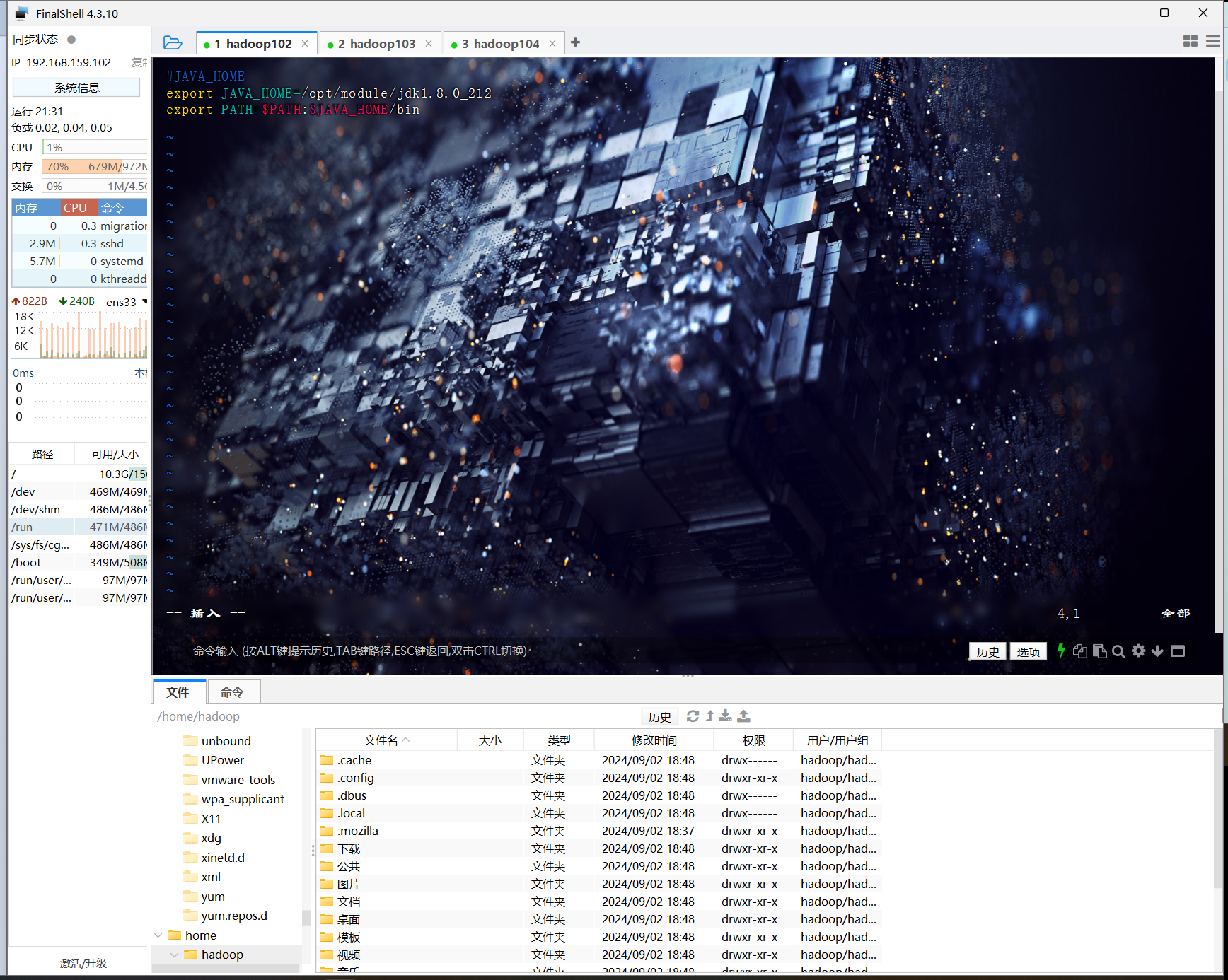

#JAVA_HOME

export JAVA_HOME=/opt/module/jdk1.8.0_212

export PATH=$PATH:$JAVA_HOME/bin

生效环境变量

source /etc/profile

![]()

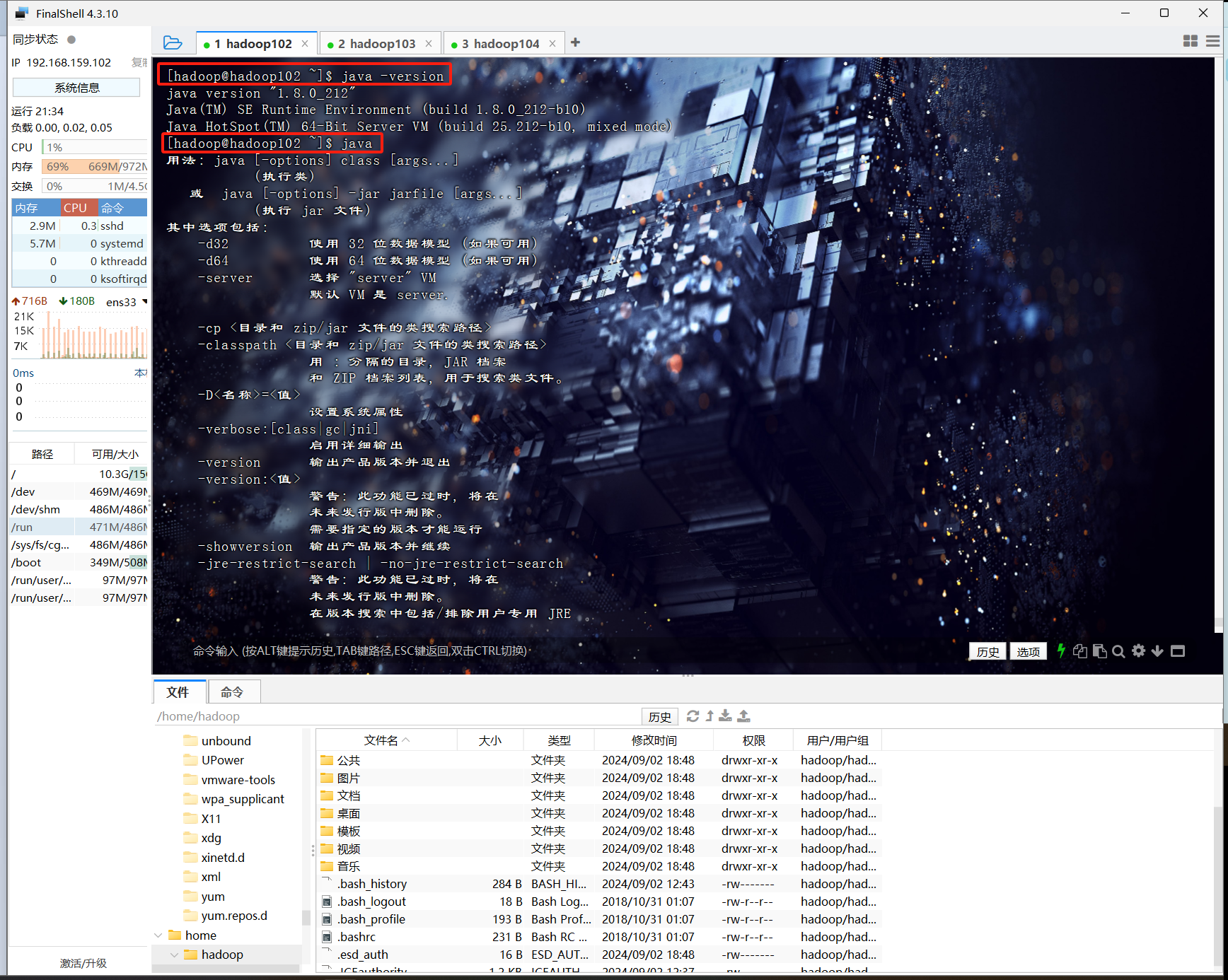

测试安装是否成功

java

或

java -version

JDK安装成功

Hadoop

软件包下载传送门

软件包安装

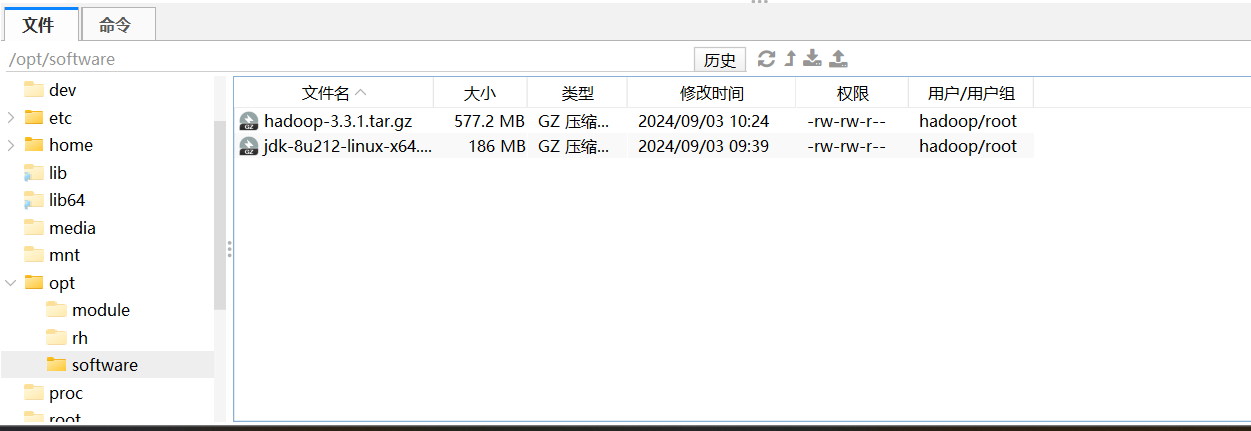

导入

把软件包导入到software目录下

解压

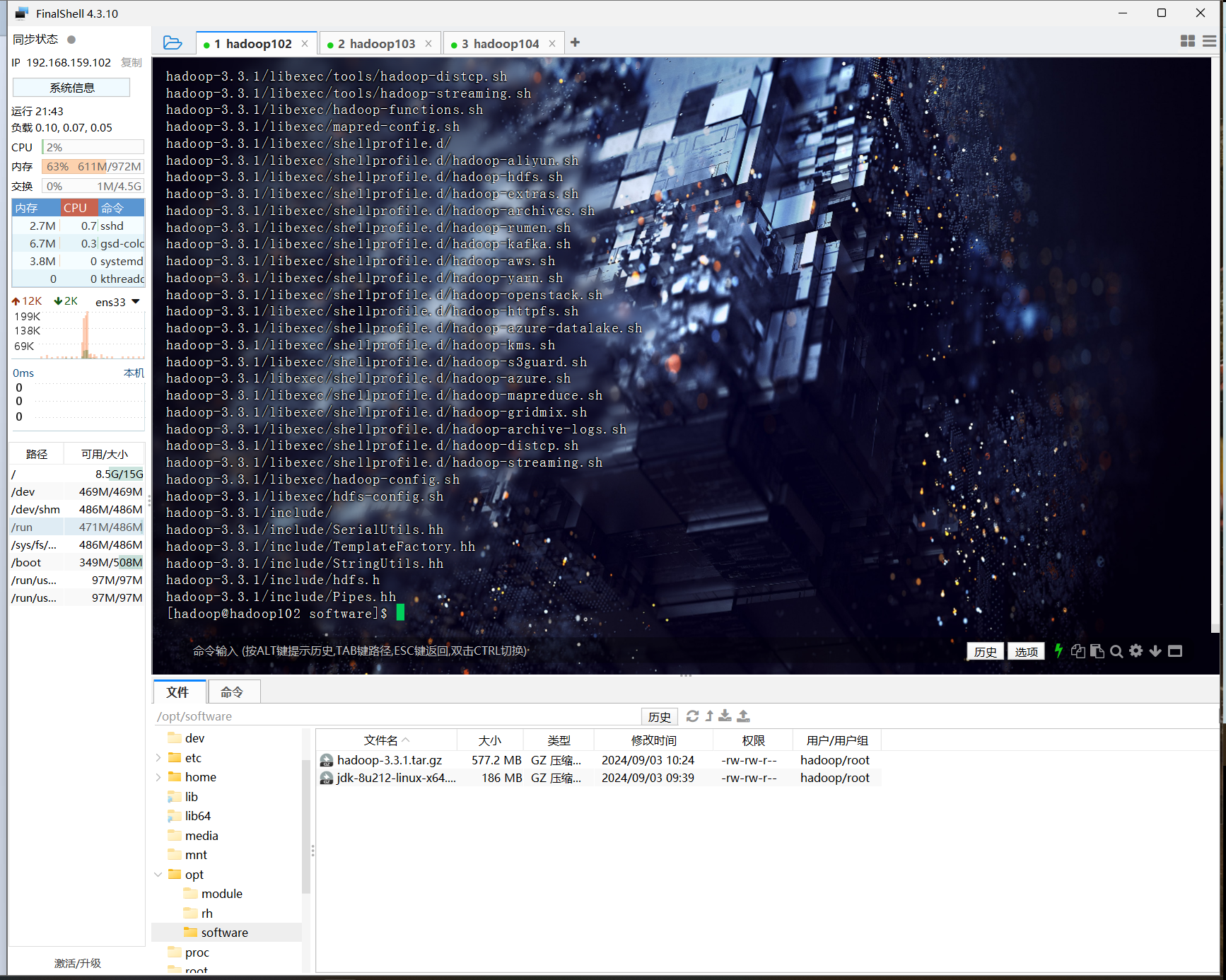

tar -zxvf hadoop-3.3.1.tar.gz -C /opt/module/

添加hadoop环境变量

sudo vim /etc/profile.d/my_env.sh

把下面的内容添加进去

#HADOOP_HOME

export HADOOP_HOME=/opt/module/hadoop-3.3.1

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

生效hadoop环境变量

source /etc/profile

![]()

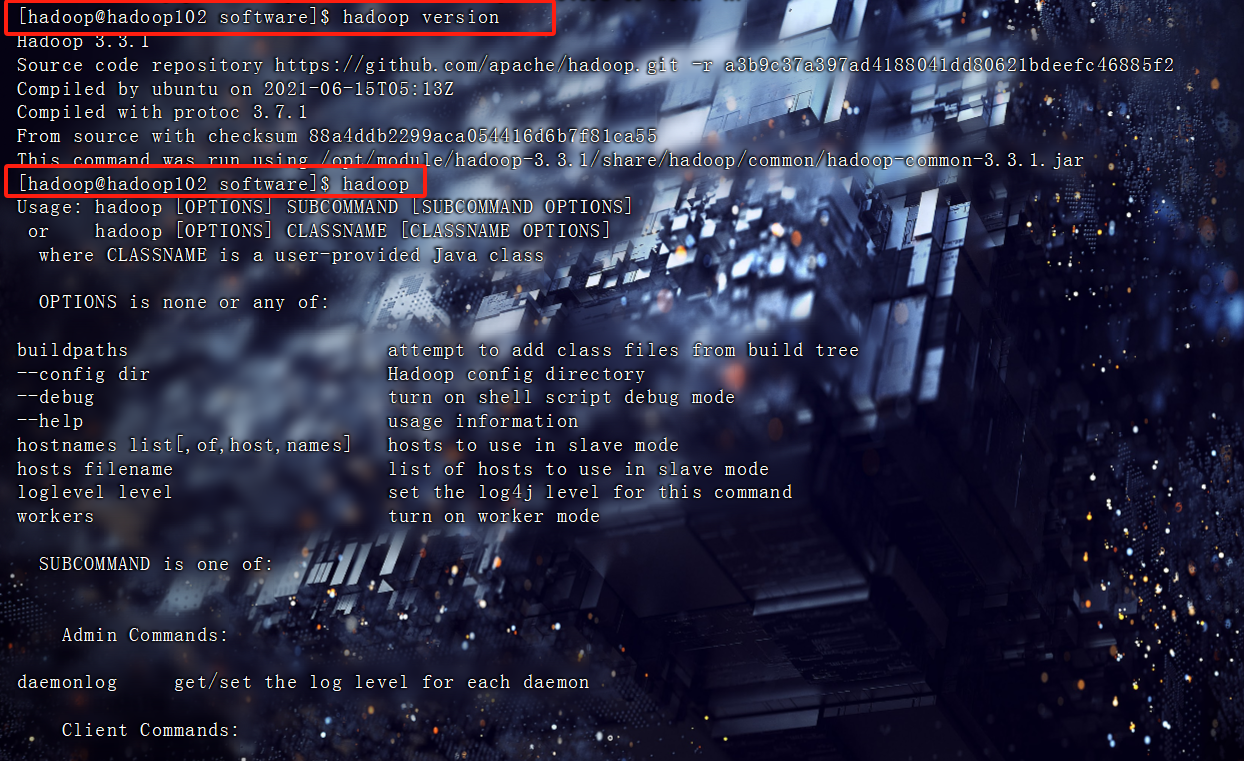

验证是否安装成功

hadoop

或

hadoop version

安装成功

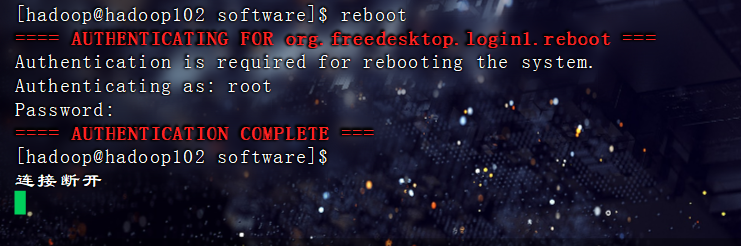

重启

reboot

或

sudo reboot

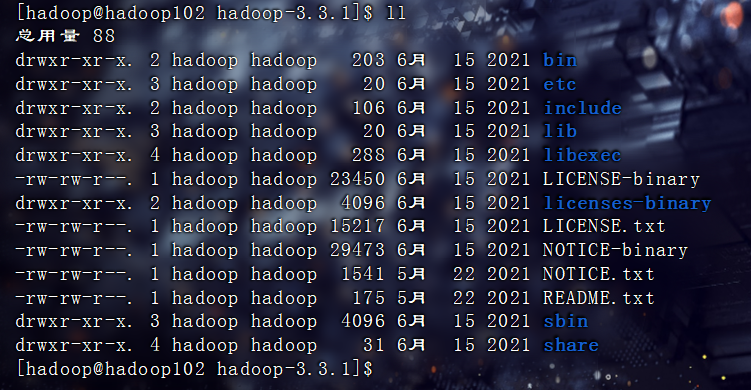

Hadoop目录结构

重要目录

- bin 目录:存放对 Hadoop 相关服务(hdfs,yarn,mapred)进行操作的脚本

- etc 目录:Hadoop 的配置文件目录,存放 Hadoop 的配置文件

- lib 目录:存放 Hadoop 的本地库(对数据进行压缩解压缩功能)

- sbin 目录:存放启动或停止 Hadoop 相关服务的脚本

- share 目录:存放 Hadoop 的依赖 jar 包、文档、和官方案例

986

986

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?