基于aDNN的静态字符环境中大曾根式指语实时识别方法的提案与实验结果

一、引言

在日本,《残疾人就业促进法》于2020年4月进行了修订。根据该法律,用人单位被要求雇佣残疾人。在各类残疾中,听力困难且无法说话的人通常被称为听障人士。

听障人士在工作场所通过口头交流进行沟通存在困难。因此,在各种工作场所中,有必要促进与听障人士的沟通和理解。然而,听障人士与非听障人士之间使用手语进行交流由于学习机会有限以及手语包含多种不同的表达方式而难以掌握。因此,日本企业需要提供更多促进手语理解的机会和方法。本文提出了一种支持学习用于日语表达的大曾根式指语的方法。通过实验对提出的方法在大曾根式指语部分字符识别中的性能进行了评估。

二、提出的方法

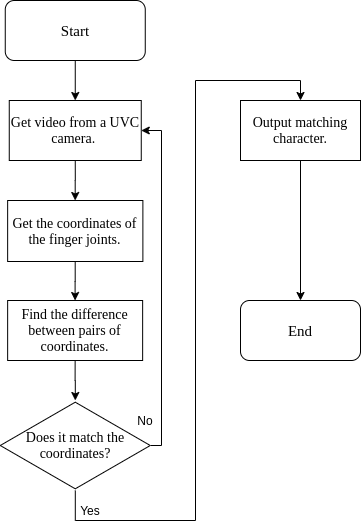

本节中,我们提出了一种方法。图1展示了该提出的方法的流程图。我们使用开源计算机视觉库(OpenCV)中的深度神经网络(DNN)模块,该模块是一种图像处理库,用于获取手指关节的关键点。为了识别大曾根式指语,提出的方法利用DNN获得的手指关节关键点进行识别。当手指关节相互接触时,将相互接触的手指关节关键点配对;否则,计算指尖与手指根部关节关键点之间的坐标差异以配对关键点。例如,如果DNN通过大曾根式指语识别出4个或5个手指,则对应有4组或5组关键点,此时计算这4组或5组关键点的坐标差异。此外,提出的方法允许摄像头与人之间的距离范围约为 0.2[m]到1.5[m],以便计算手指关节关键点的坐标差异。由于提出的方法能够利用UVC摄像头对视频流数据中的手指关节关键点识别进行实时处理,因此也适用于动态大曾根式指语的识别。

III. 实验结果

在本节中,我们描述了实验设置和实验结果。实验参数如表I所示。我们使用图2中所示的日文字符。通过 UVC摄像头捕捉日语平假名中的大曾根式指语,用于 5[sec],并利用提出的方法实时识别大曾根式指语。这些平假名在大曾根式中为静态字符。

| CPU | 英特尔酷睿 i5‐9400F |

|---|---|

| OS | Ubuntu 18.04.4 LTS |

| 编程语言 | Python 3.6.0 |

| 摄像头 | 罗技UVC摄像头c310h |

| CNN库 | OpenCV 3.2.0 |

| 实验次数 | 100[times] |

| 每次实验时间 | 5[sec] |

指语。针对每个大曾风格指语进行了实验 100[times]。

实验结果如图3所示。在实验结果中,使用提出的方法对大曾根式指语进行识别时,每个日语平假名的识别率为 95[%]到 100[%]。由于实验场景中使用的每个日语平假名具有不同的手指形状,因此识别率较高。

四、结论

本文提出了一种基于深度神经网络的实时大曾根式指语识别方法。根据实验结果,我们得出结论:所提出的系统能够识别大曾根式指语中的静态字符。未来,我们将试验其他场景中的使用所提出系统的全部大曾风格指语识别、日本手语识别、使用指语的句子的识别。

17

17

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?