明敏 发自 凹非寺

量子位 | 公众号 QbitAI

谷歌大模型,开源了!

一夜之间,Gemma系列正式上线,全面对外开放。

它采用Gemini同款技术架构,主打开源和轻量级,免费可用、模型权重开源、允许商用,同时笔记本可跑。

共有2B和7B两个版本,性能全面超越开源标杆Llama 2。

每种规模都有预训练和指令微调版本,可在Kaggle、Colab Notebook、Google Cloud中访问。

而且支持JAX、PyTorch和TensorFlow通过原生Keras 3.0进行推理和监督式微调(SFT),适应多种开发需求和环境。得益于对JAX的支持,它还能进行快速推理。

目前模型也同步上线Hugging Chat,可在线体验试玩。

发布几个小时里,Gemma火速成为圈内最热话题,成为议论焦点。

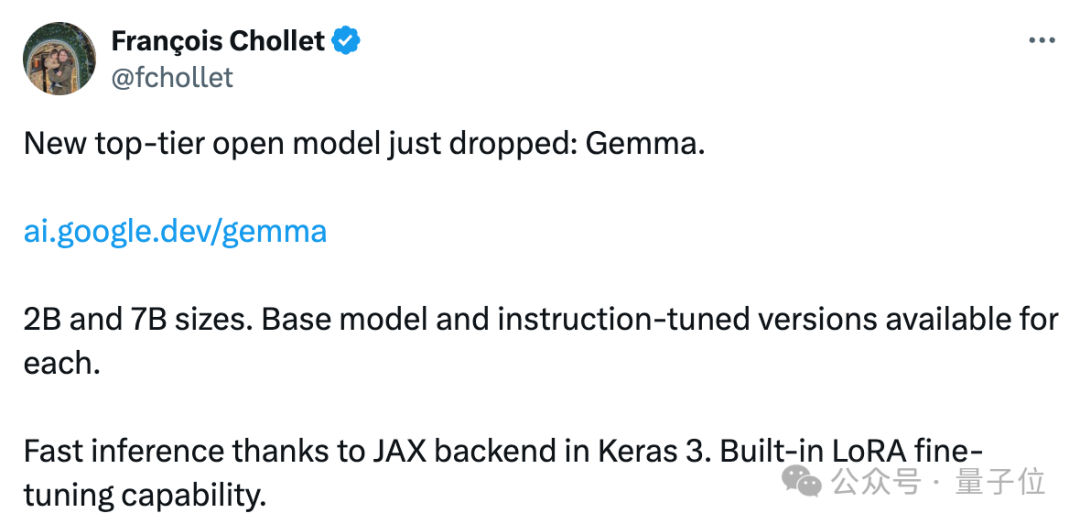

Keras作者François Chollet高呼:最强开源大模型,刚刚易主。

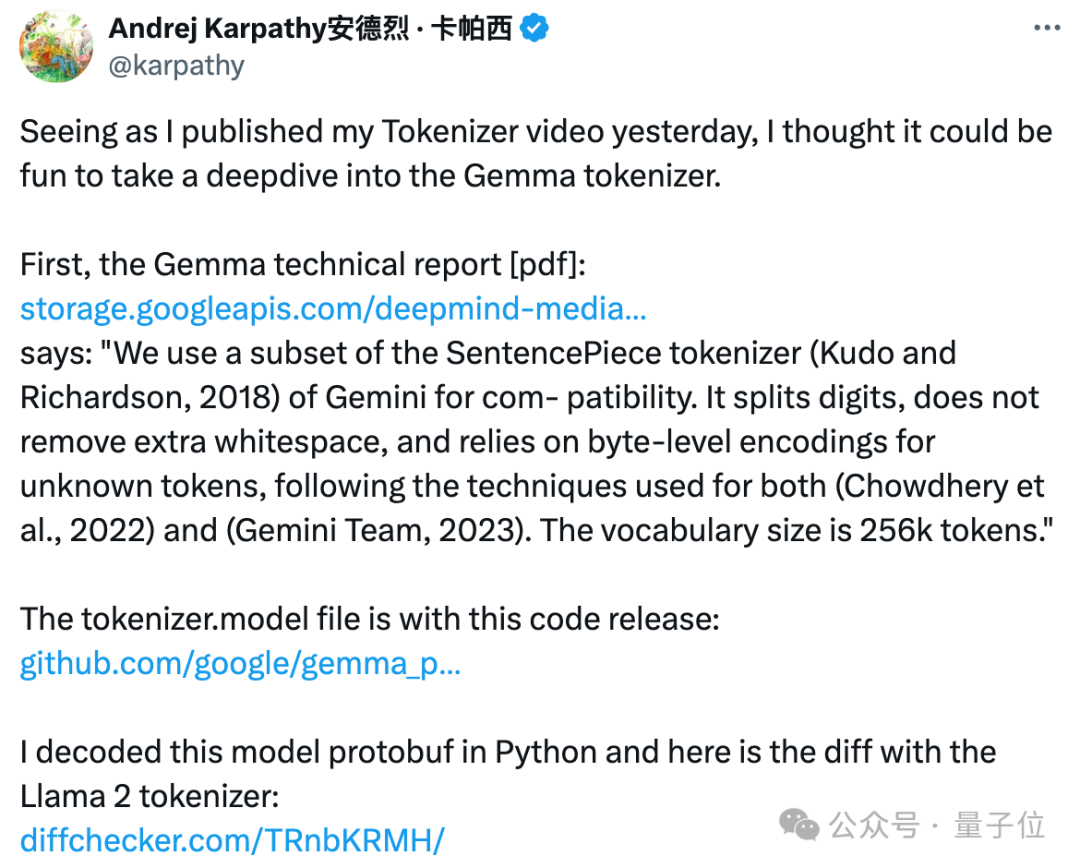

大神卡帕西第一时间赶来解析技术报告。

AI圈内大佬更是表示,谷歌做开源是明智之举啊。

网友们都很兴奋,已经有人开始问考虑推出更多语言版本吗?

还有人提出2B的规模,是不是意味着也能支持安卓/iOS本地推理?

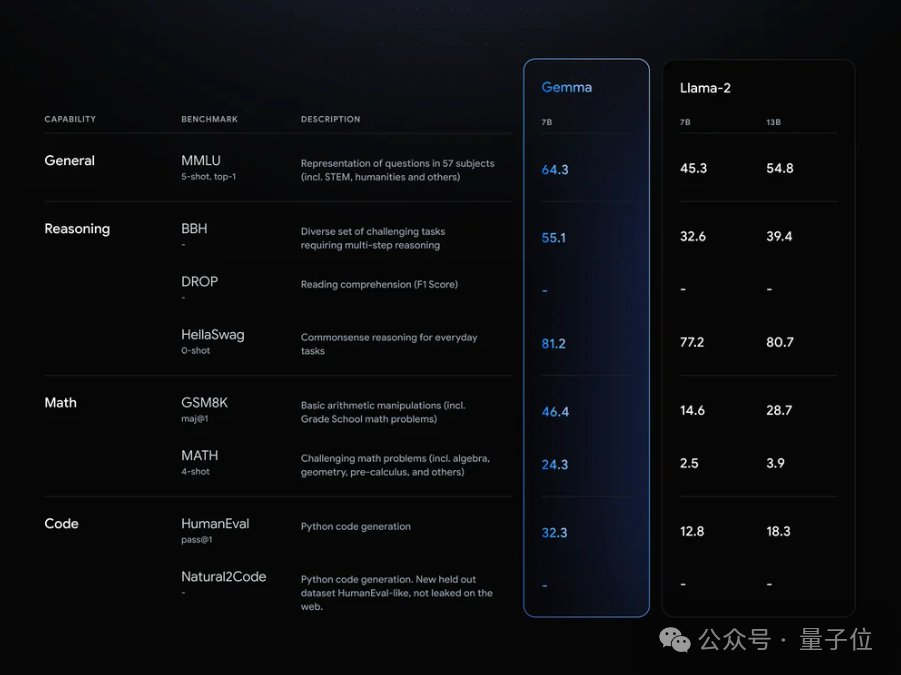

多性能超越同规模开源模型

具体来看Gemma的技术报告。

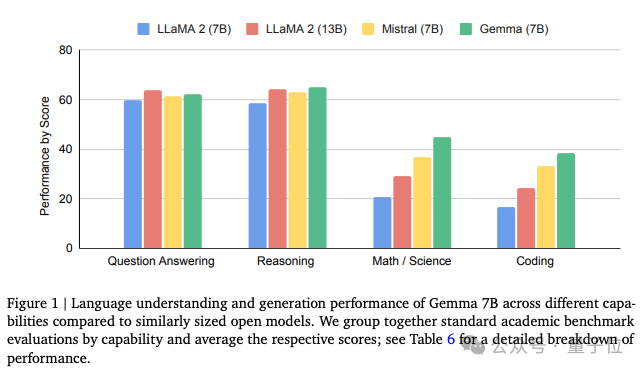

在18个任务中,Gemma在11个任务上表现优于同规模优质开源模型。

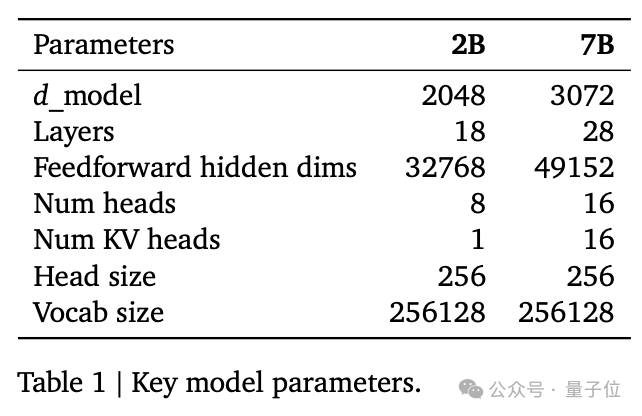

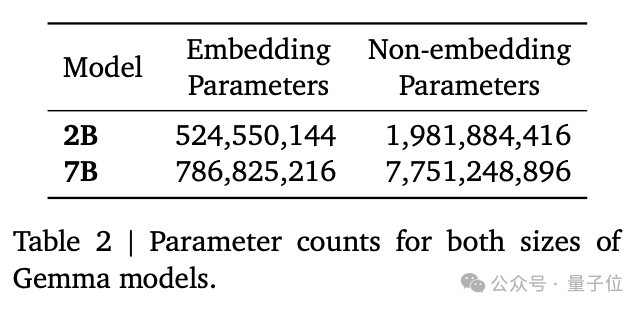

Gemma包含两种规格。

7B版本参数量约78亿,面向GPU和TPU上的高效部署和开发,2B版本参数量约25亿,用于CPU和端侧应用程序。

它基于Transformer解码器架构,关键模型参数如下。

相比于基础Transformer,Gemma进行了一些升级。

7B版本使用多头注意力机制,2B版本使用多查询注意力机制。

在每一层中使用旋转位置嵌入代替绝对位置嵌入;使用GeGLU激活函数替代标准ReLU非线性。

同时对每一个子层的输入和输出都进行归一化。

Gemma 2B/7B分别使用了2T和6T token进行训练,主要来自网络文档、数学和代码,不过这些数据不是多模态的。

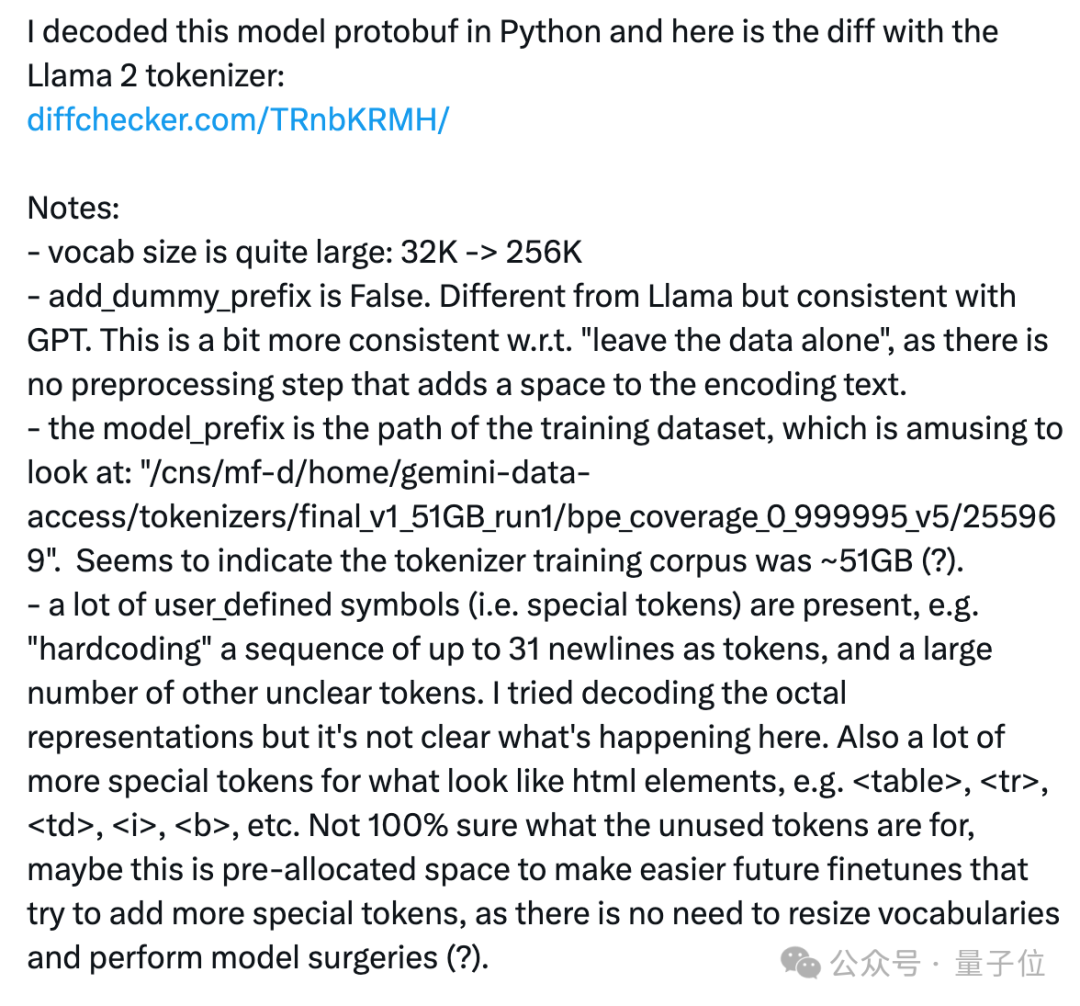

为了兼容,谷歌使用了Gemini的SentencePiece tokenizer子集,它可以分割数字,不删除额外的空格,并对未知token进行字节级编码。

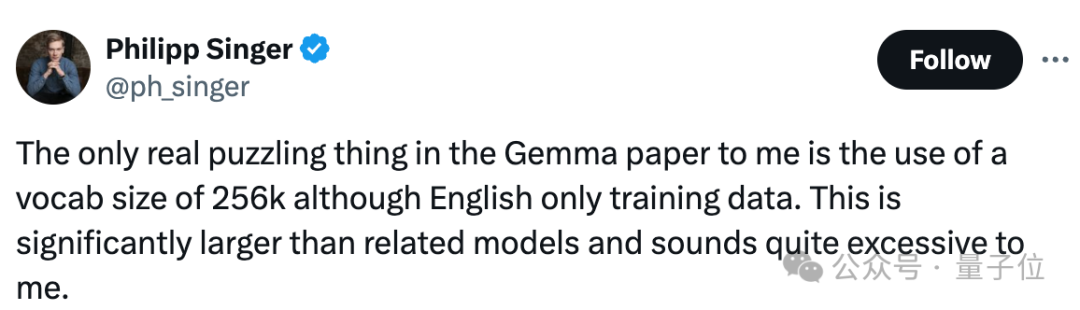

大神卡帕西关注了Tokenizer部分,他表示,Gemma的tokenizer和Llama 2的不同,但和GPT一致。

François Chollet认为Gemma最大的特点是谷歌拥有SOTA级测试集过滤机制,这意味着基准数据能相当准确地反映了模型在实际环境中的表现。

谷歌也报告了Gemma在MMLU等基准上的表现。

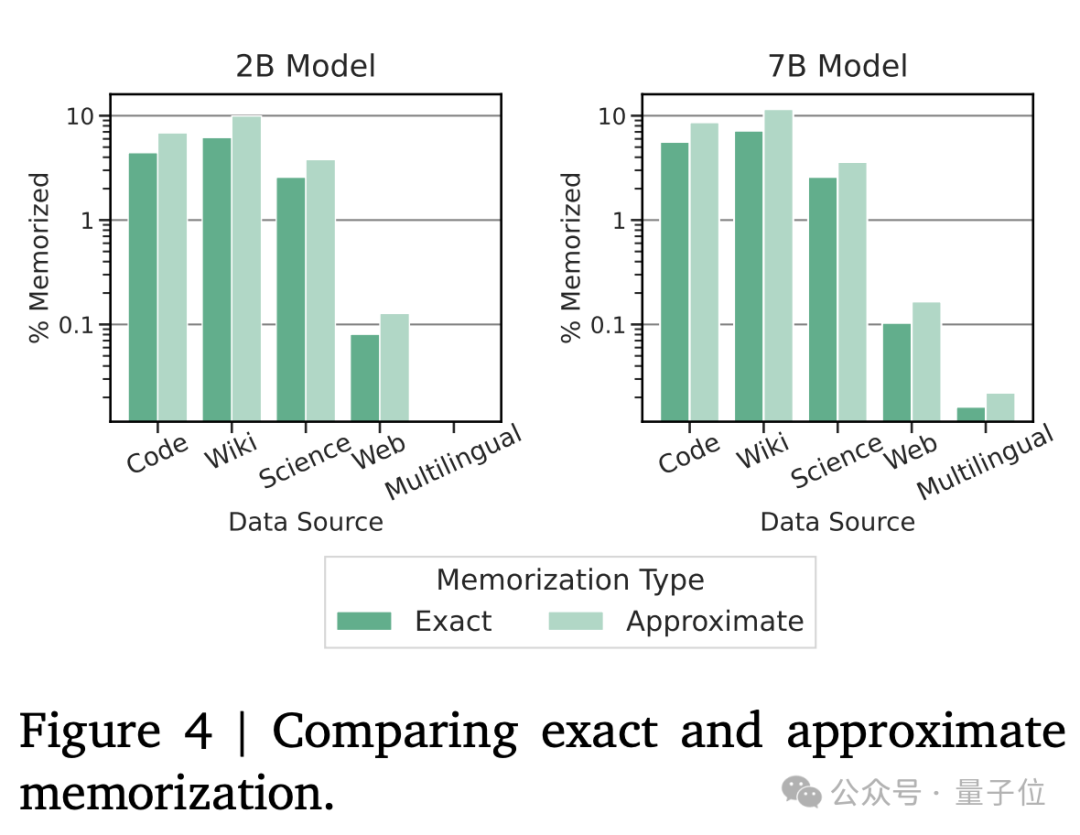

最后,谷歌还强调了Gemma的安全隐私性能。

实验数据显示Gemma不会存储敏感数据,但可能会记住一些潜在隐私数据。不过报告表示这个数据可能因为工具原因有所误报。

网友已开始实测

开放以后不少网友已经上手实测Gemma。

有人反馈写代码的速度非常快。

关于技术细节的讨论也很多。

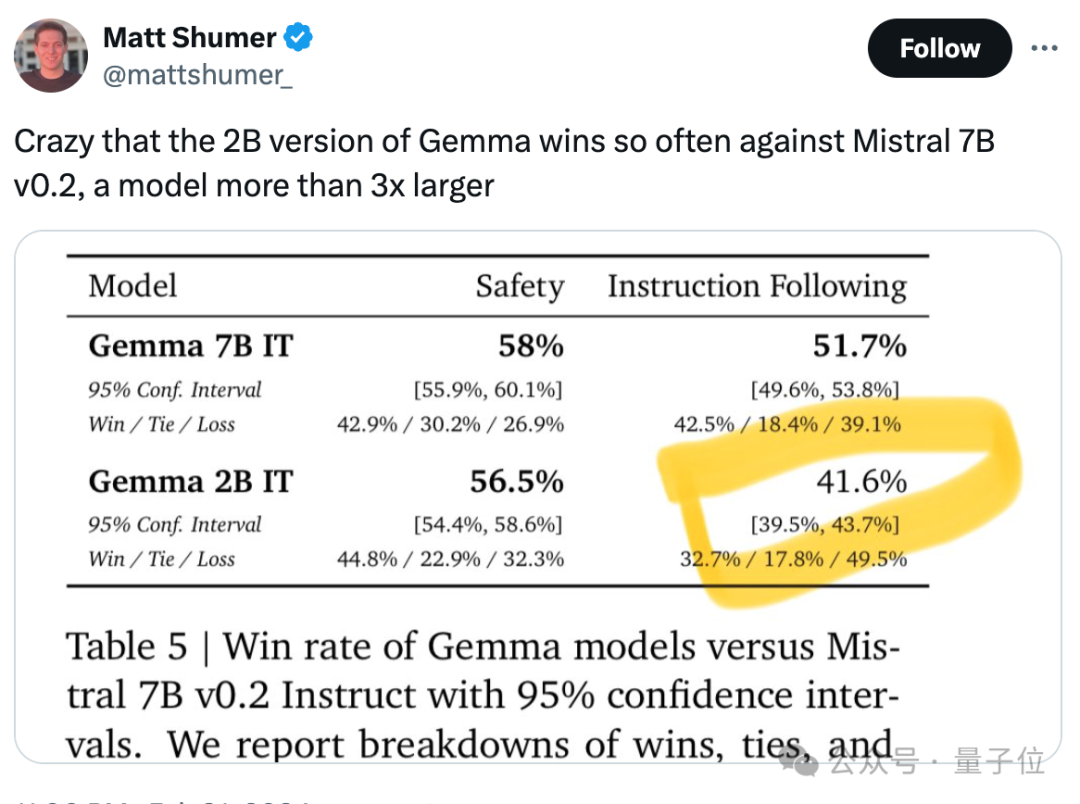

不少人关注到Gemma做到了“以小博大”,2B版本性能超越Mistral2 7B。

也有人觉得Gemma使用的数据量有点大……

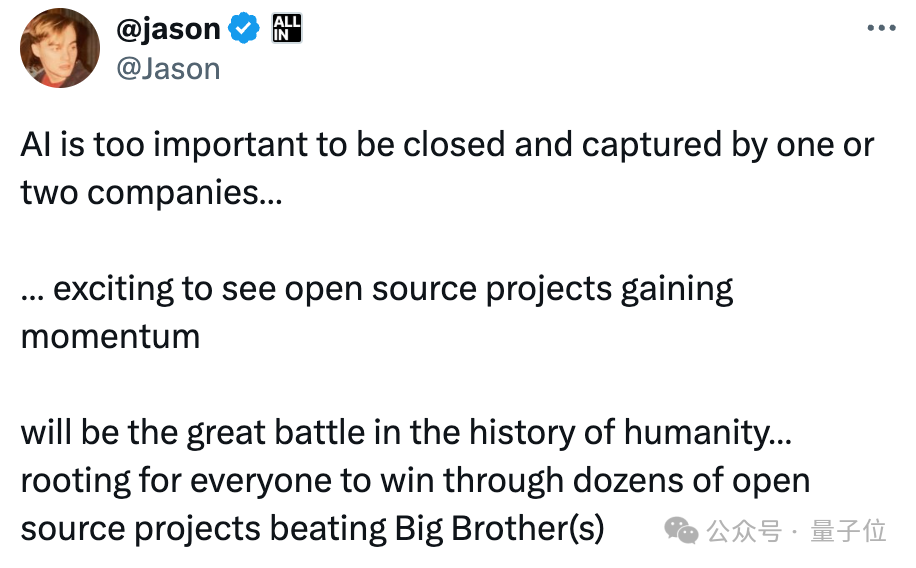

但对于谷歌开放模型的态度,大家是一律拍手称赞。

通过几十个开源项目,每个人都有机会打败巨头。

现在压力再次给到“CloseAI”……

也有人猜测,按照两大巨头互掐的规律,OpenAI新大招可能就在路上了。

599

599

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?