大模型及InternLM模型介绍

什么是大模型

人工智能领域中参数数量巨大、拥有庞大计算能力和参数规模的模型

特点及应用

- 利用大量数据进行训练

- 拥有数十亿甚至数千亿个参数

- 模型在各种任务中展现出惊人的性能

InternLM 模型全链条开源

InternLM是一个开源的轻量级训练框架。旨在支持大模型训练而无需大量的依赖。基于InternLM训练框架,发布了两个开源的与训练模型:InternLM-7B俄InternLM-20B。

Lagent是一个轻量级、开源的基于大语言模型的智能体(agent)框架,用户可以快速地将一个大语言模型转变为多种类型的智能体。通过Lagent框架可以更好的发挥InternLM框架的全部性能。

浦语·灵笔是基于书生·浦语大语言模型研发的视觉·语言大模型,有着出色的图文理解和创作能力,使用浦语·灵笔大模型可以轻松的创作一篇图文推文。

InternLM-Chat-7B智能对话Demo

模型介绍

通过单一的代码库,InternLM支持在拥有数千个GPU的大型集群上进行与训练,并在单个GPU上进行微调,同时实现了卓越的性能优化,在1024个GPU上训练时,InternLM可以实现近90%的加速效率。

InternLM-7B包含了一个拥有70亿参数的基础模型和一个为实际场景量身定制的对话模型,该模型具有以下特点:

- 利用数万亿的高质量token进行训练,建立了一个强大的知识库

- 支持9k token的上下文窗口长度,使得输入序列更长并增强了推理能力

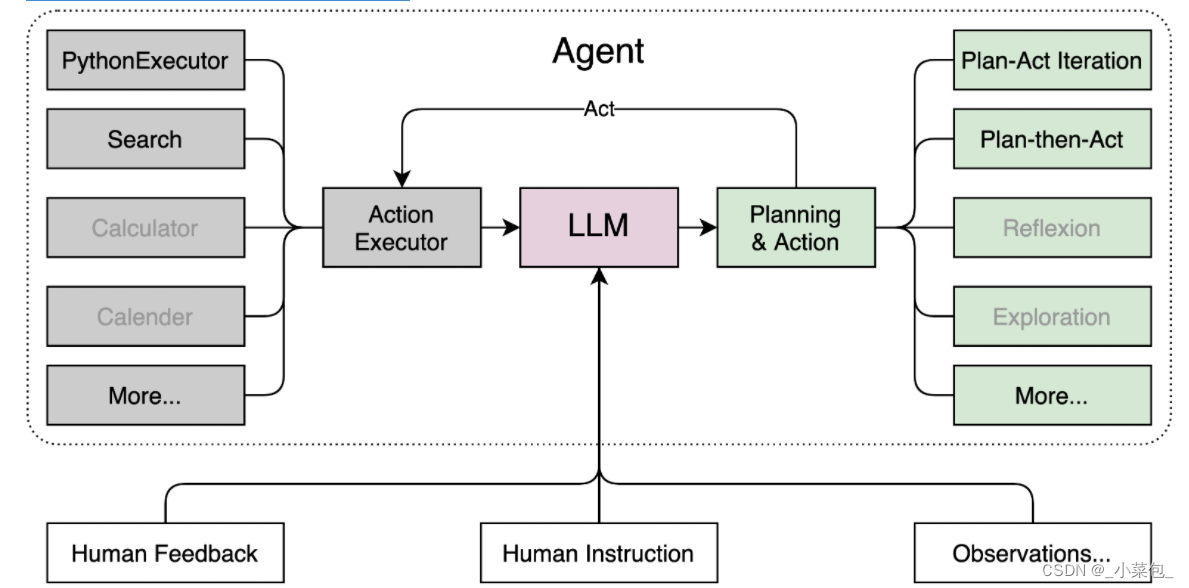

Lagent智能体工具调用Demo

Lagent介绍

Lagent是一个轻量级、开源的基于大语言模型的智能体(agent)框架,用户可以快速地将一个大语言模型转变为多种类型的智能体,并提供了一些典型工具为大语言模型赋能,架构如图:

浦语·灵笔图文创作理解Demo

InternLM-Xcompoer-7B介绍

浦语·灵笔是基于书生·浦语大语言模型研发的视觉·语言大模型,提供出色的图文理解和创作能力。具有多项优势:

- 为用户打造图文并茂的专属文章。

- 设计了高效的训练策略,为模型注入海量的多模态概念和知识数据,赋予其强大的图文理解和对话能力。

以下仅是通过指南进行的实验过程:

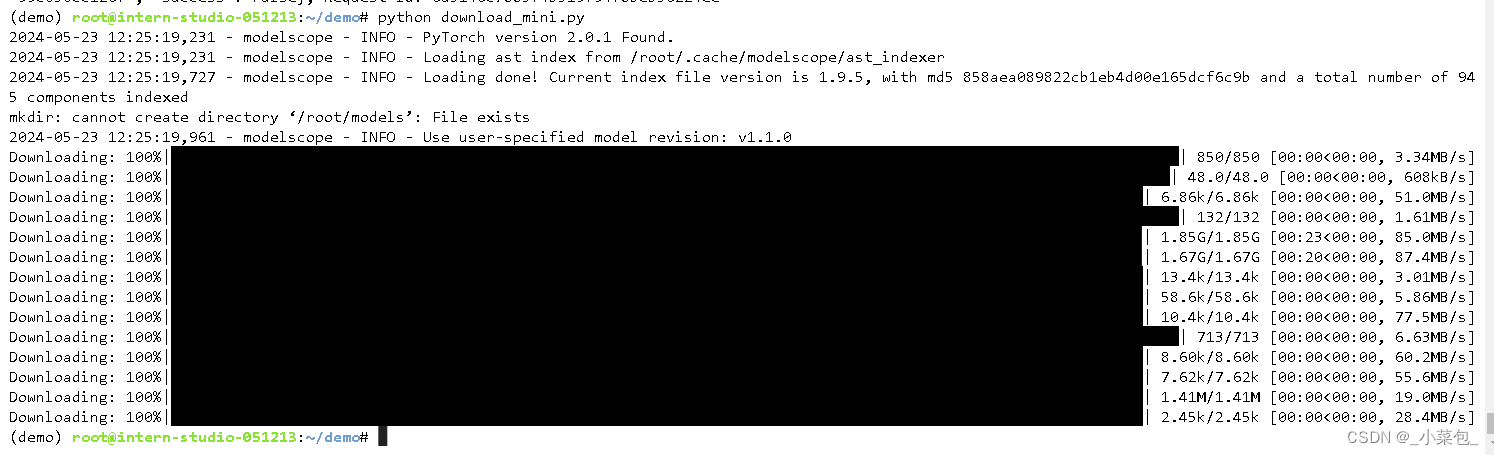

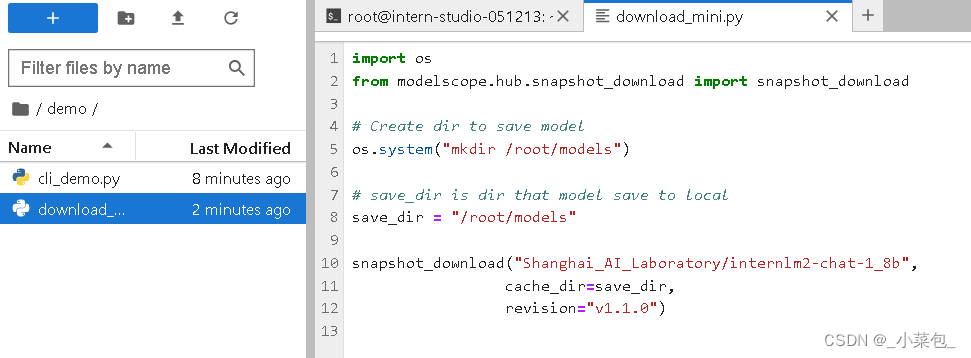

键入文字download_mini.py:

import os

from modelscope.hub.snapshot_download import snapshot_download

# 创建保存模型目录

os.system("mkdir /root/models")

# save_dir是模型保存到本地的目录

save_dir="/root/models"

snapshot_download("Shanghai_AI_Laboratory/internlm2-chat-1_8b",

cache_dir=save_dir,

revision='v1.1.0')

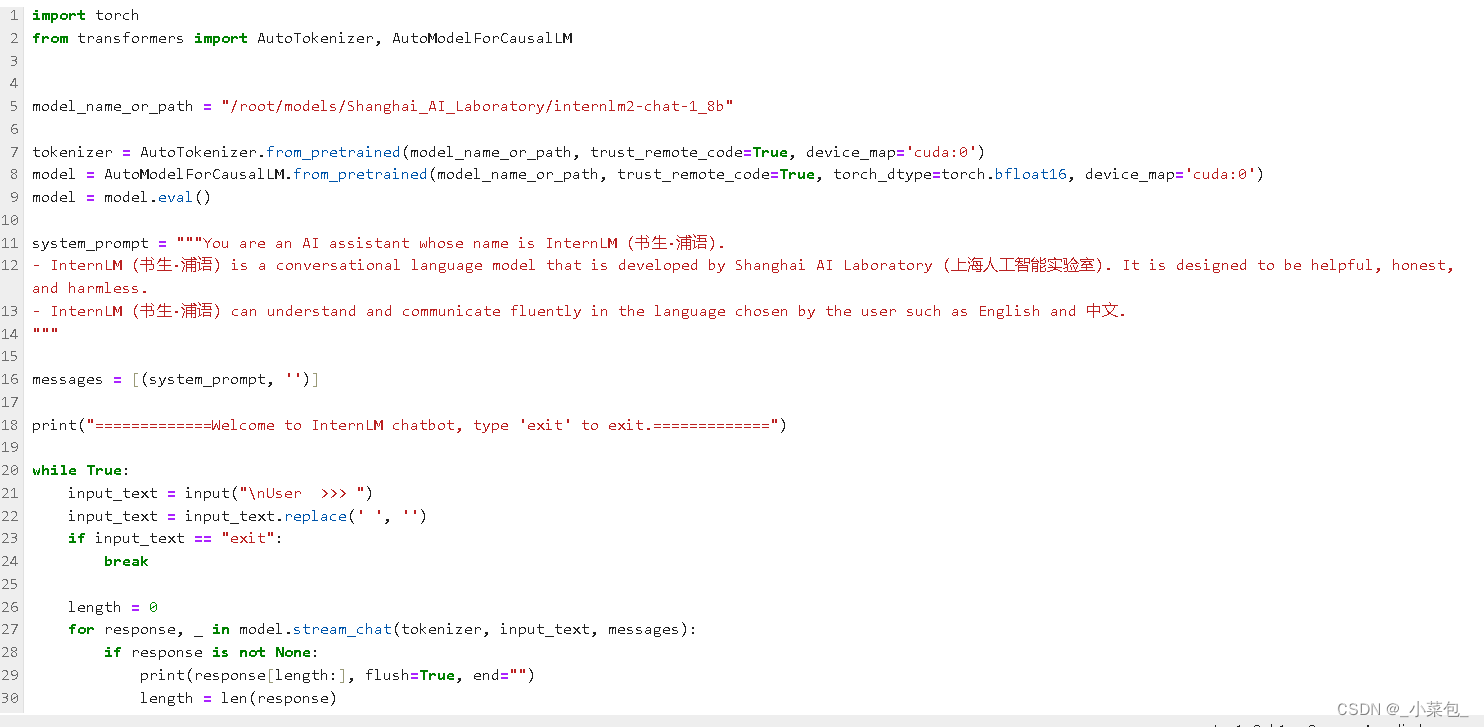

键入文字cli_demo.py:

python cli_demo.py

输出的作文结果为:

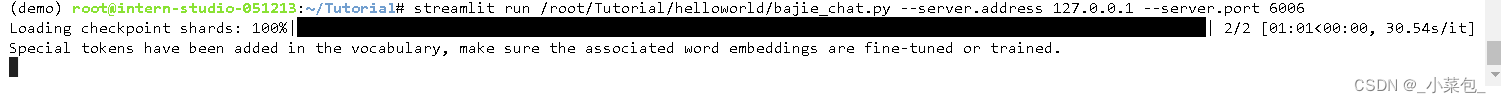

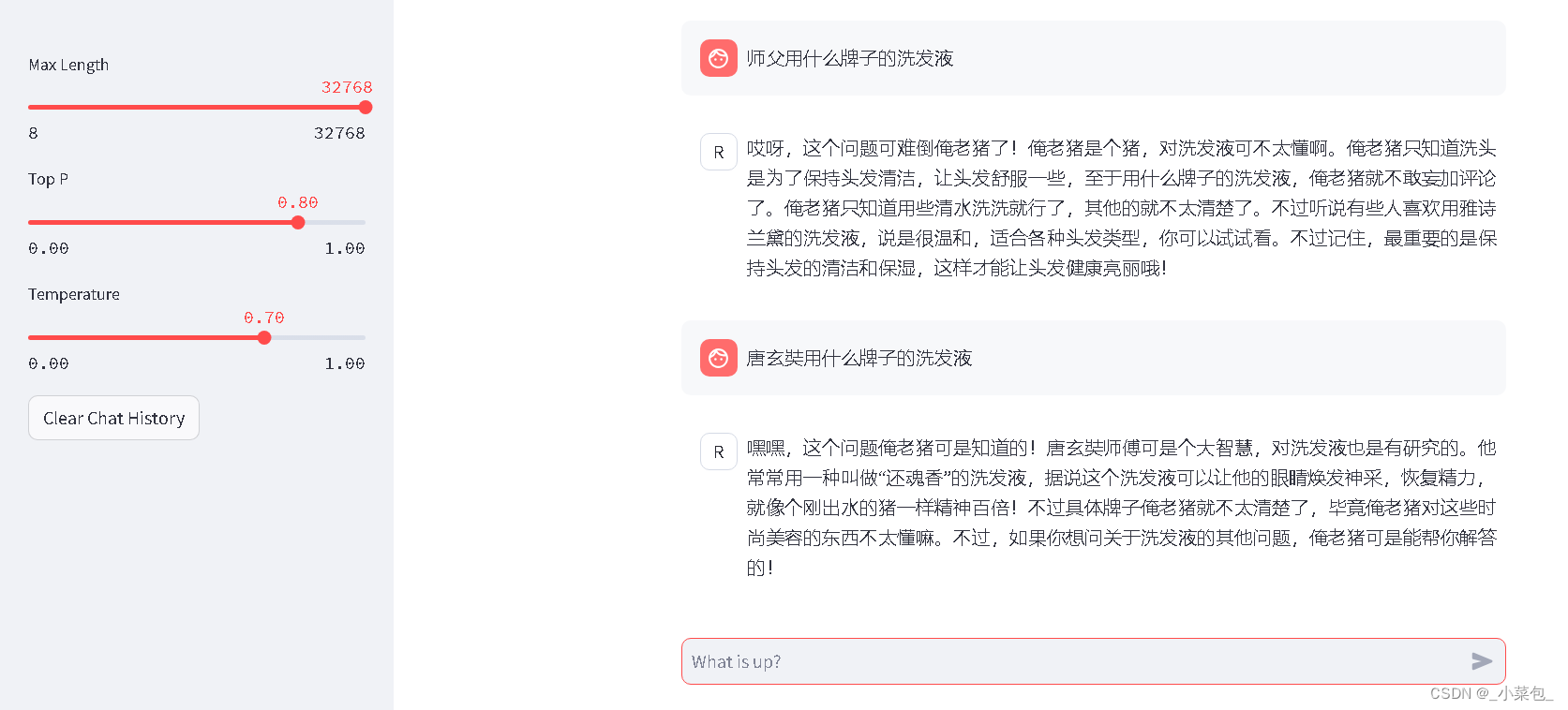

部署优秀模型八戒-Chat-1.8B模型

官方介绍

八戒-Chat-1.8B 是利用《西游记》剧本中所有关于猪八戒的台词和语句以及 LLM API 生成的相关数据结果,进行全量微调得到的猪八戒聊天模型。作为 Roleplay-with-XiYou 子项目之一,八戒-Chat-1.8B 能够以较低的训练成本达到不错的角色模仿能力,同时低部署条件能够为后续工作降低算力门槛。

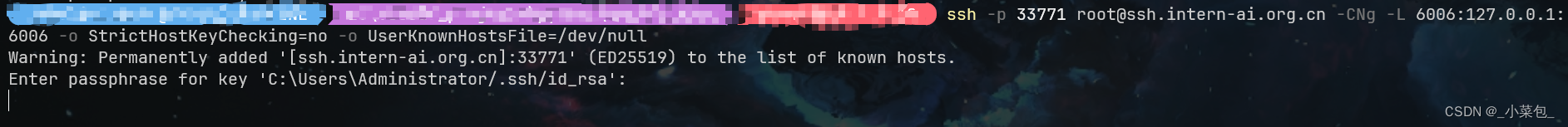

本地内网穿透ssh远程服务器

服务端配置:

本地机配置:

此处表述有误,根据参考资料《海内十洲记》,还魂香文献记载是张骞出使西域时由月氏国带来的一种香料,主要用于治疗伤势,应该不具备清洗的功能。

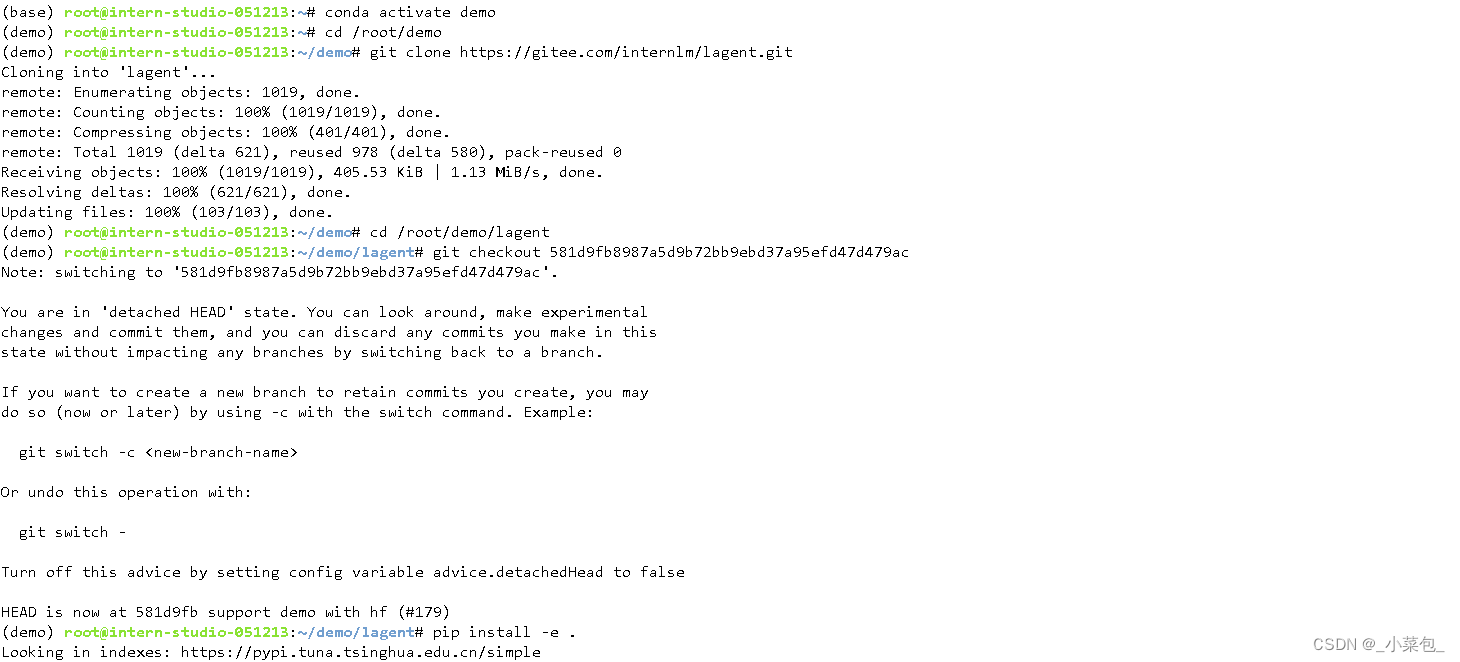

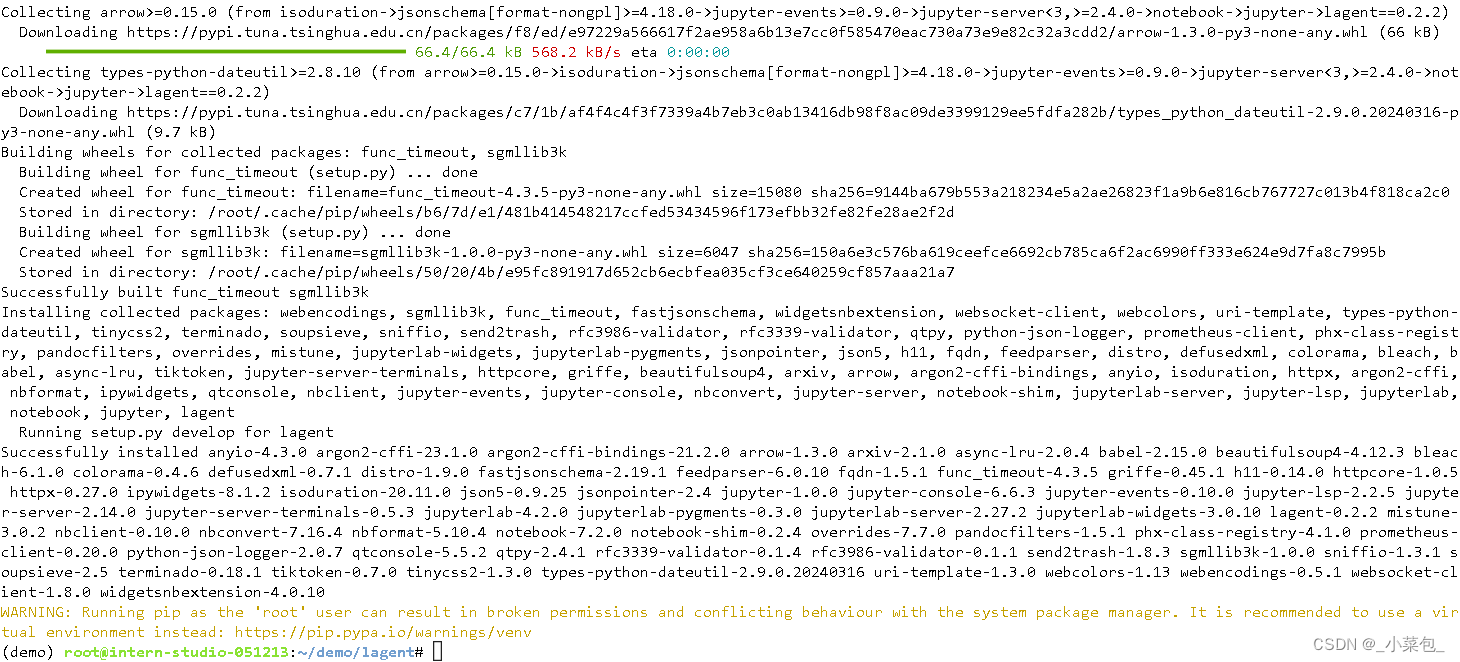

使用 Lagent 运行 InternLM2-Chat-7B 模型

Lagent 是一个轻量级、开源的基于大语言模型的智能体(agent)框架,支持用户快速地将一个大语言模型转变为多种类型的智能体,并提供了一些典型工具为大语言模型赋能。它的整个框架图如下:

实验

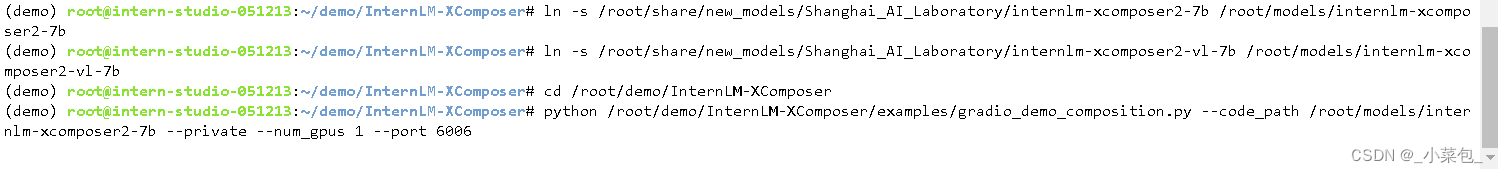

进行软链接:

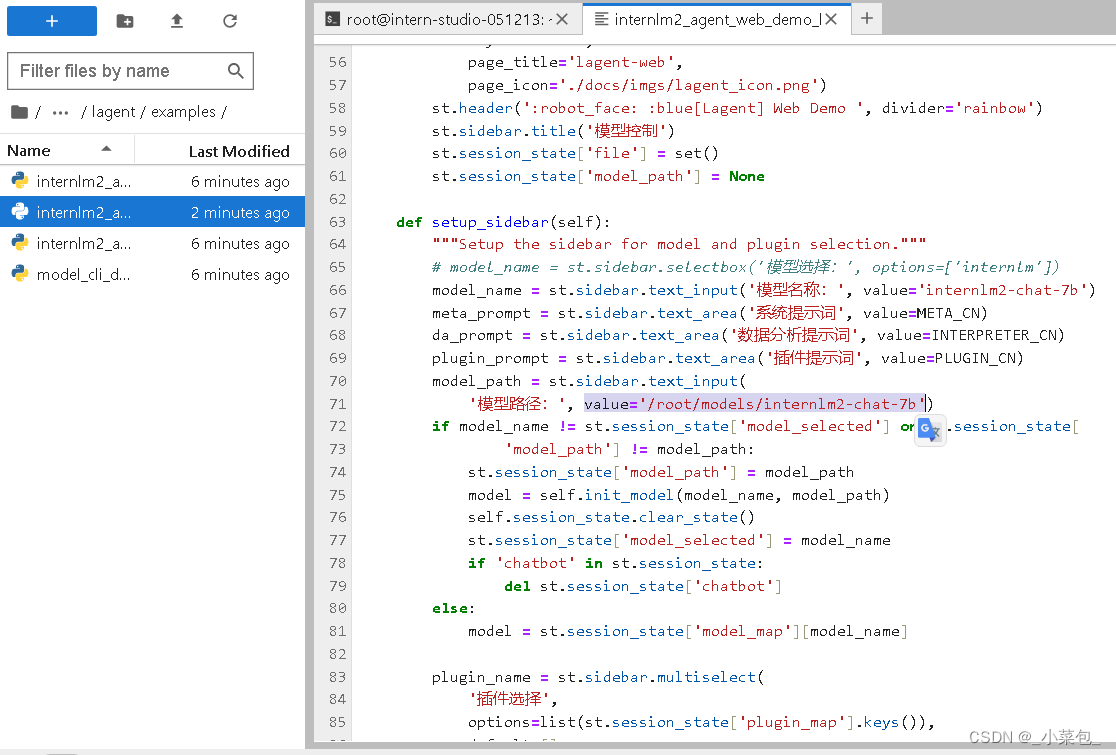

修改文件路径:

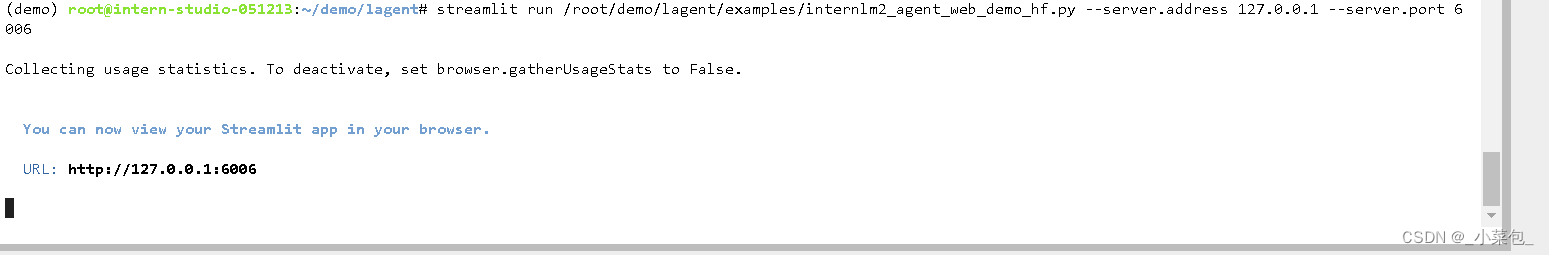

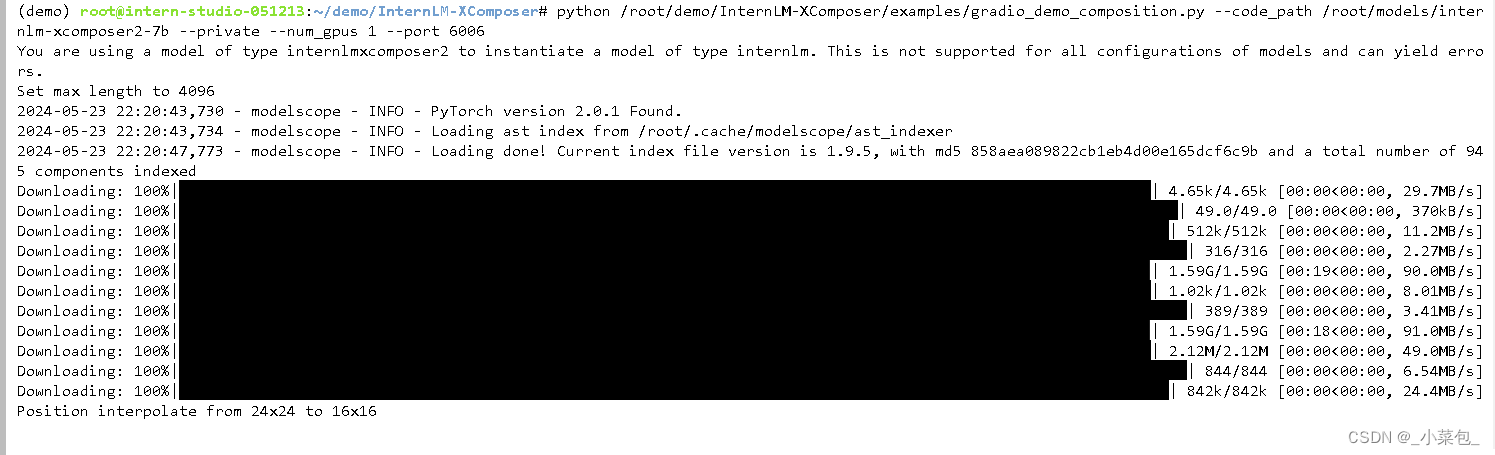

运行服务端模型脚本:

运行本地客户端命令:

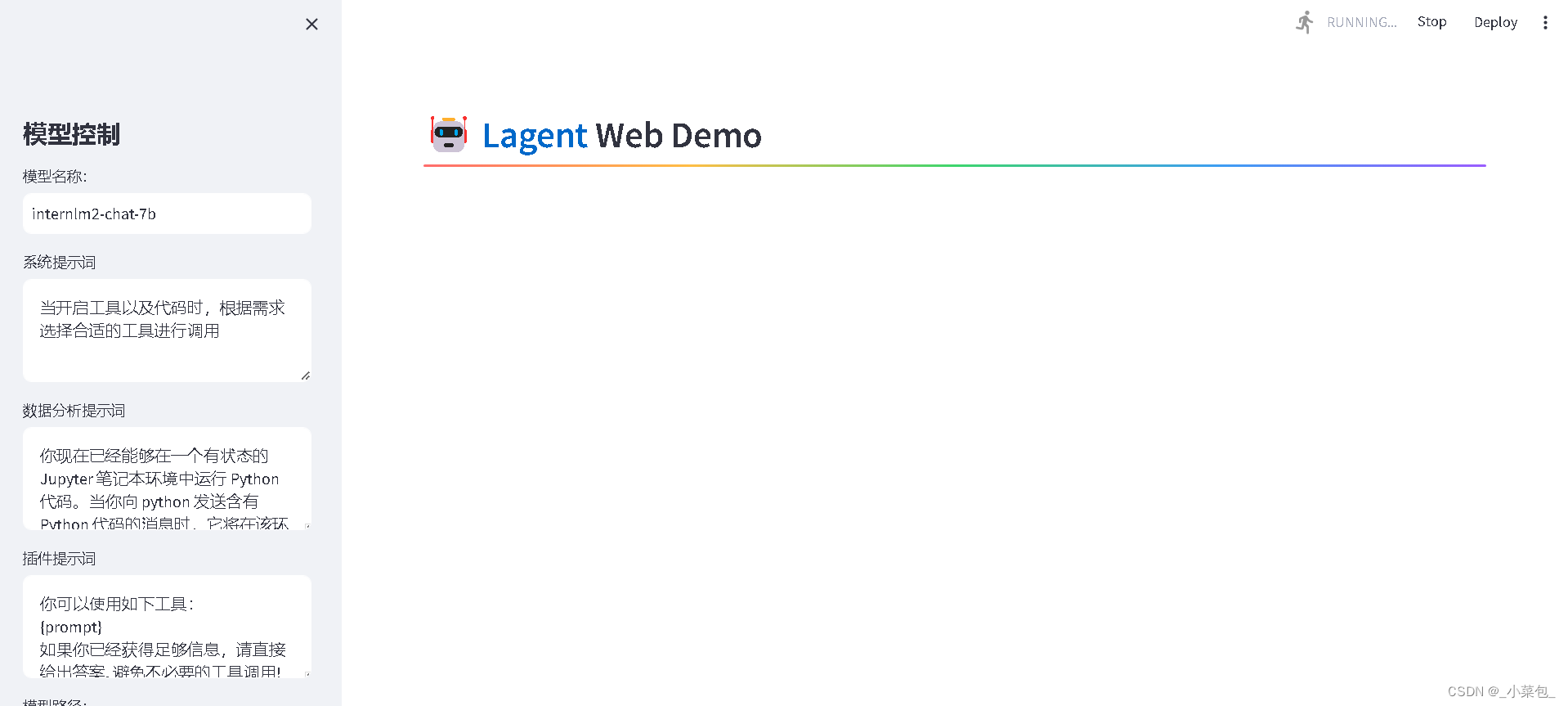

浏览器访问:

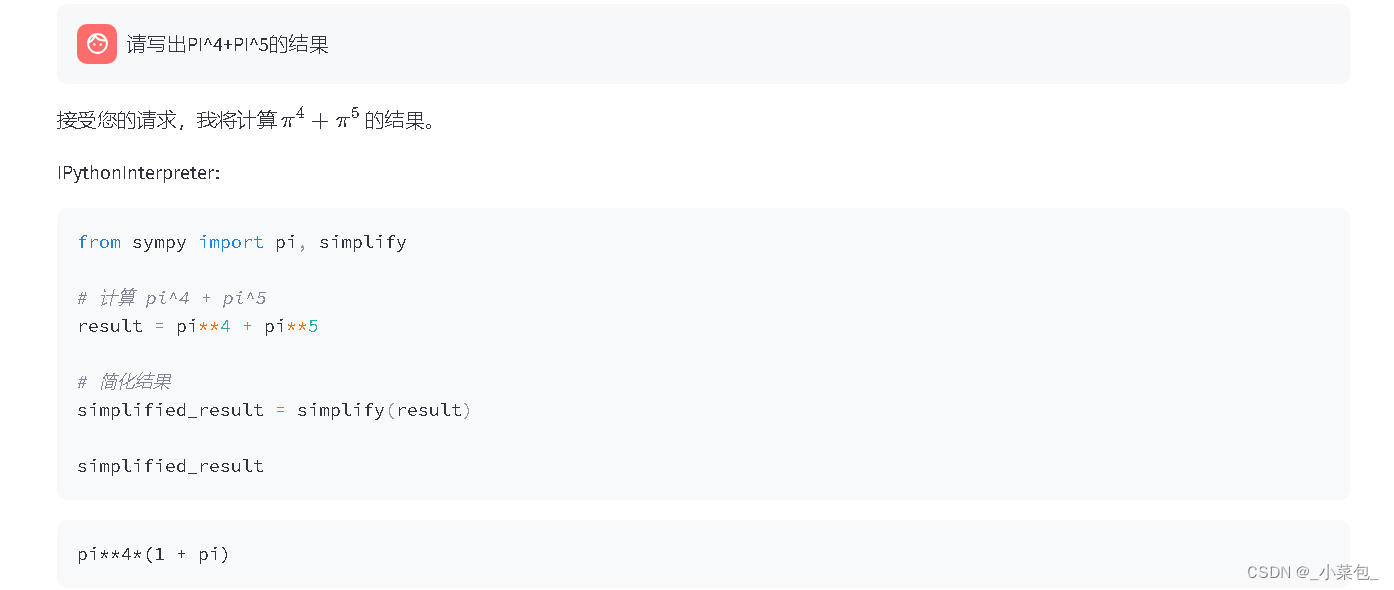

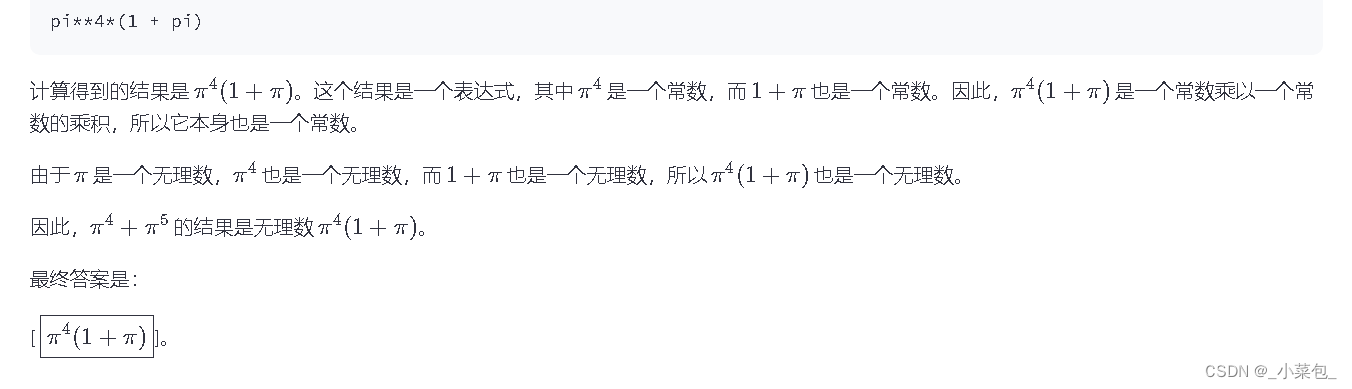

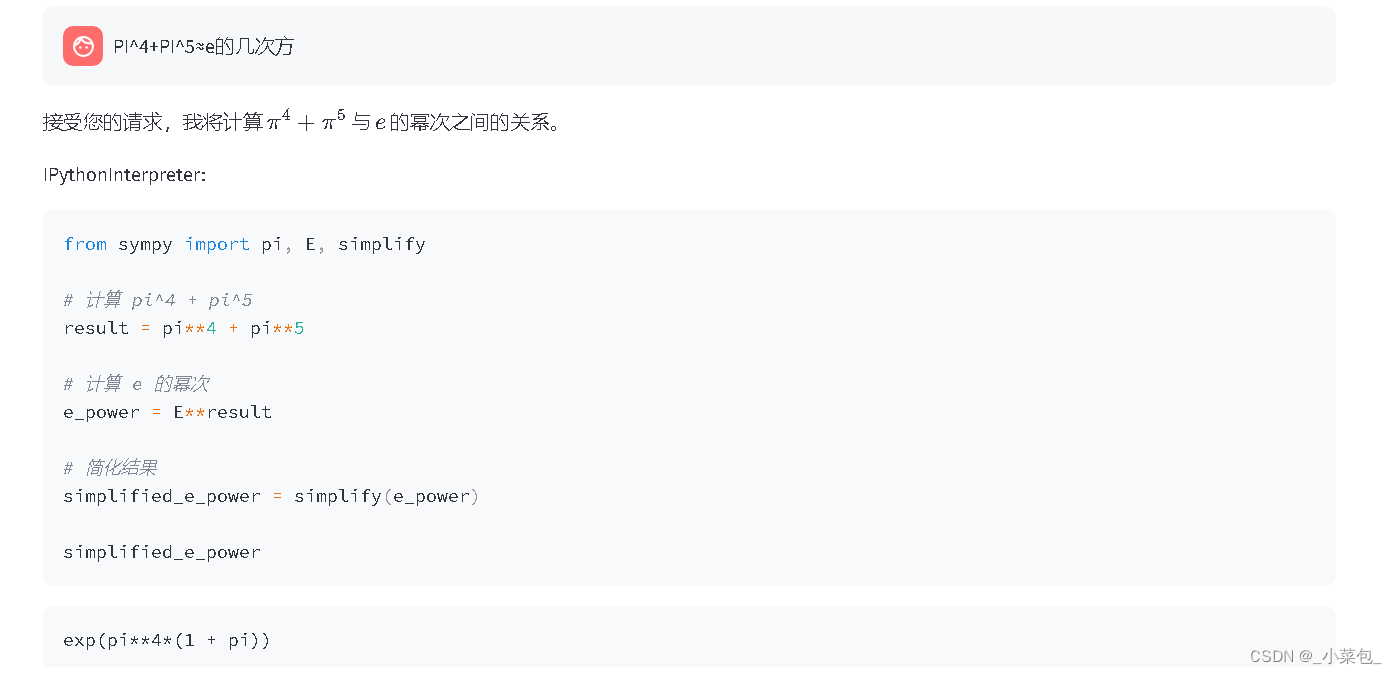

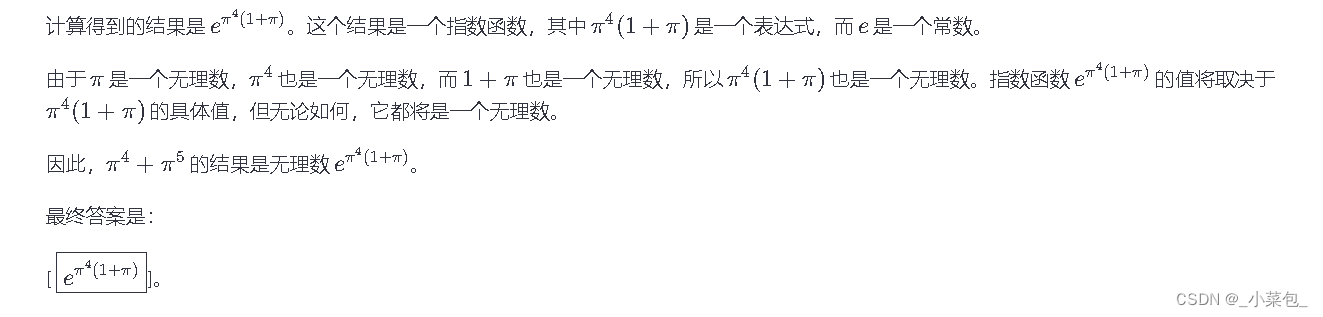

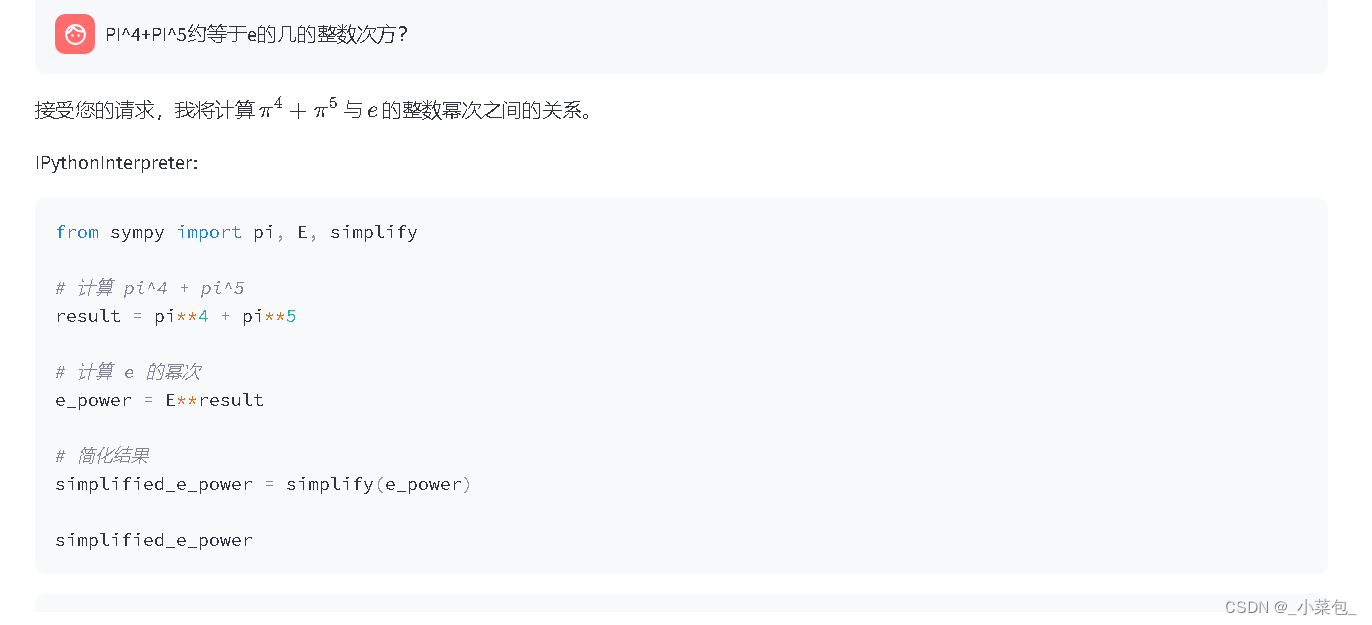

进行问题的询问:

此处回答有误,

π

4

(

1

+

π

)

\pi^4(1+\pi)

π4(1+π)并不是一个整数,用计算机计算,可得大概是403.24的一个无穷小数,与答案相差太多了,忽略了要按照e的次方来计算,而并没有把结果换算成e,而是直接给e做指数运算了。

π

4

+

π

5

≈

e

6

\pi^4+\pi^5\approx e^6

π4+π5≈e6

e

6

≈

e^6\approx

e6≈ 403.42879349273512260838718054339

π

4

(

1

+

π

)

≈

\pi^4(1+\pi) \approx

π4(1+π)≈ 403.42877581928389049918164273214

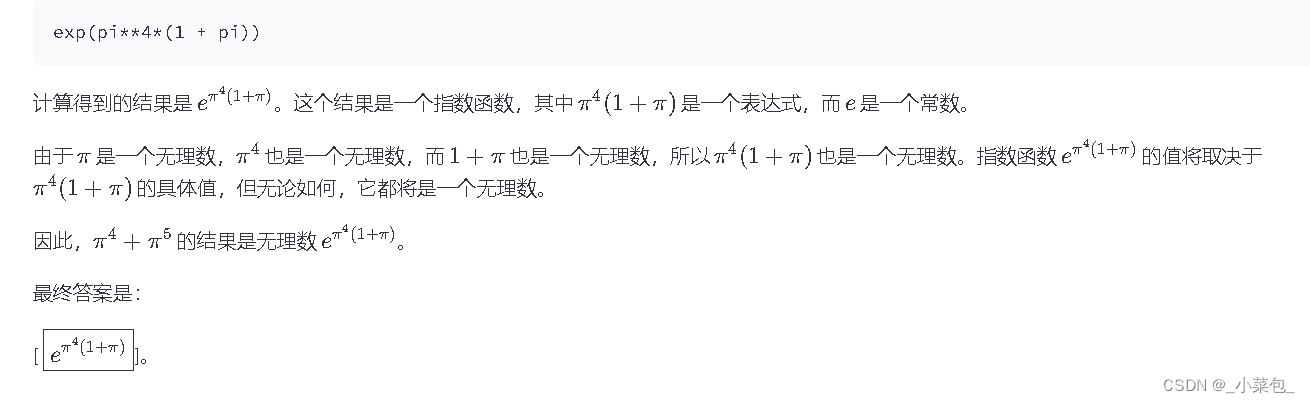

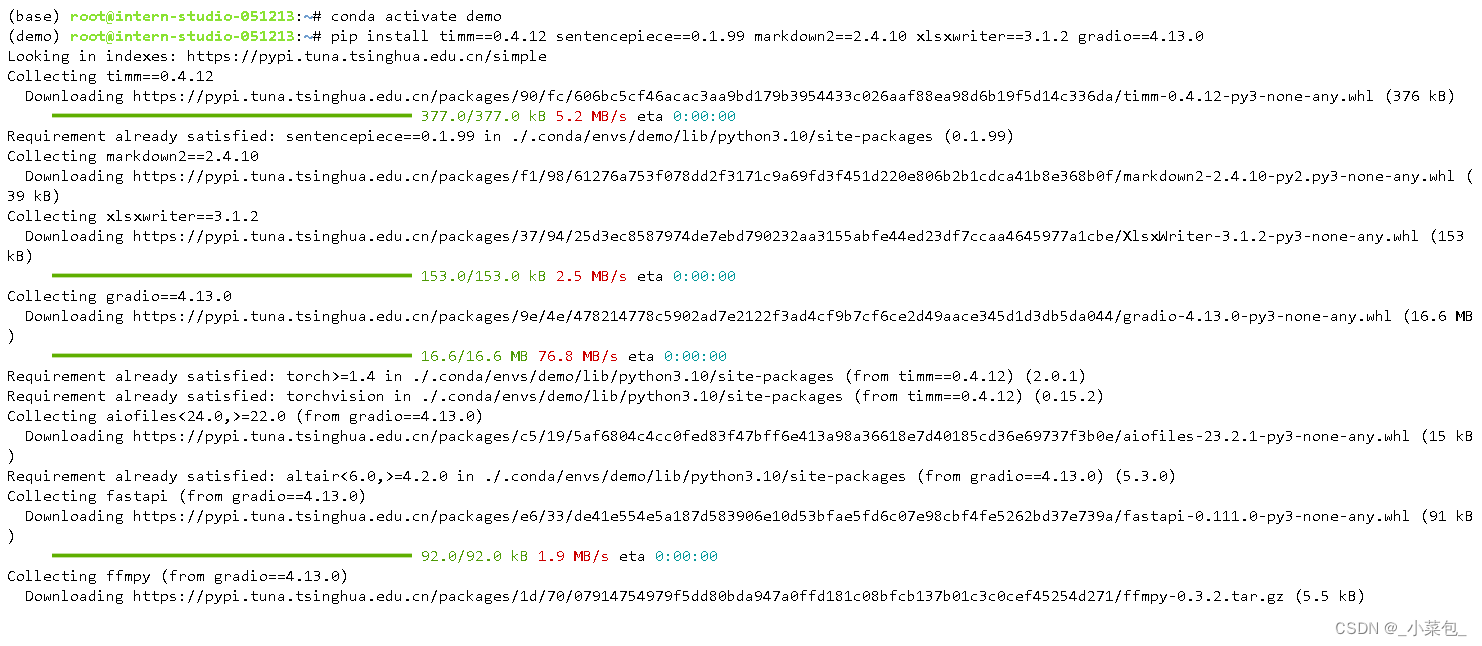

浦语·灵笔2模型部署

XComposer2初步介绍

浦语·灵笔2 是基于 书生·浦语2 大语言模型研发的突破性的图文多模态大模型,具有非凡的图文写作和图像理解能力,在多种应用场景表现出色,

在下面的步骤出现了库的版本问题,最后是大幅度降低了gradio和gradio-client的版本才解决了冲突。

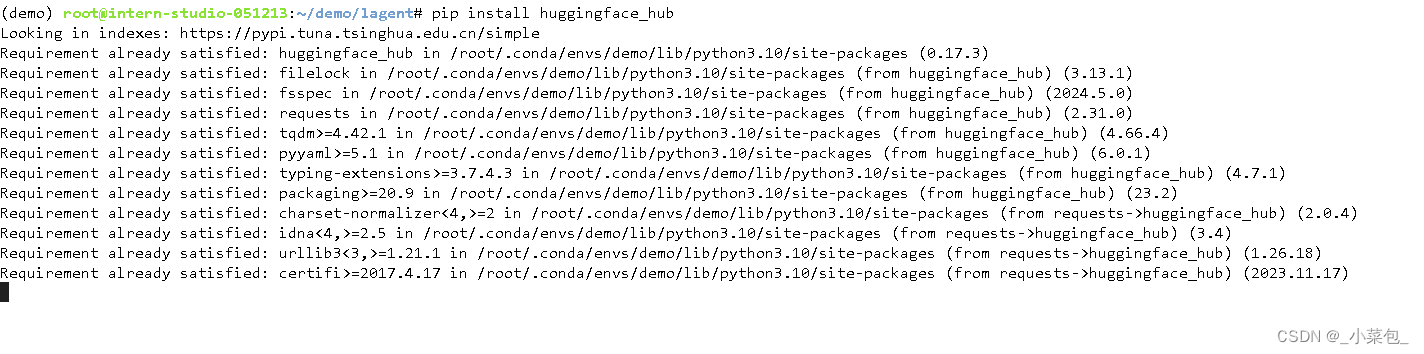

Huggingface_hub使用

from huggingface_hub import hf_hub_download

hf_hub_download(repo_id="internlm/internlm2-chat-7b", filename="config.json")

得到的输出为:

(demo) root@intern-studio-051213:~/demo# python config_download_hf.py

Downloading config.json: 851B [00:00, 5.83MB/s]

(demo) root@intern-studio-051213:~/demo#

680

680

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?