ResNet 简介和原理

1. 什么是 ResNet?

ResNet的目标是解决训练深层神经网络时出现的梯度消失问题。在深层网络中,梯度消失会导致难以训练。ResNet通过引入跳跃连接或快捷连接来有效地解决这个问题。由何凯明等人于2015年提出。这篇论文的正式标题是 《Deep Residual Learning for Image Recognition》

- 问题背景:深度神经网络的训练变得越来越困难,尤其是当网络层数增加时。

- 解决方案:ResNet引入了跳跃连接,允许网络层之间的直接连接,从而有效地解决了梯度消失问题。

- 核心思想:学习残差(即输入与输出之间的差异),使网络更易于训练。

- 层的重新定义:将网络层显式地重新定义为学习残差函数,而不是学习无参考的函数。

- 优点:ResNet网络更易于优化,可以通过增加深度获得更高的准确性。

2. 梯度消失问题

考虑一个网络层H(x)由两个子层组成:layer1和layer2。如果H(x)相对于x的偏导数的幅度远小于1,由于激活函数(如Sigmoid)的存在,从H(x)的梯度传播到x的梯度会非常小,这就是梯度消失问题。

3. ResNet 架构

ResNet有多个变体,包括ResNet18、ResNet34、ResNet50、ResNet101和ResNet152。每个变体都有不同的残差块结构和不同数量的残差块。

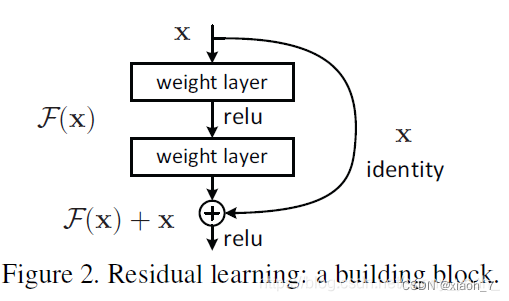

ResNet引入了跳跃连接,如下图所示:

通过从x到H(x)添加跳跃连接,网络学习残差F(x) = H(x) - x,这样更容易。有了这个跳跃连接,x的梯度可以轻松地从H(x)的梯度传播过来,有效地解决了梯度消失问题。

公式说明

ResNet的核心思想是学习残差,即F(x) = H(x) - x。这可以用公式表示为:

[ H(x) = F(x) + x ]

实验结果

- 在ImageNet数据集上,ResNet网络的深度可达152层,比VGG网络深8倍,但复杂度较低。

- 在ImageNet测试集上,ResNet集成模型的错误率为3.57%,在ILSVRC 2015分类任务中获得第一名。

- 在CIFAR-10数据集上,ResNet在100和1000层上进行了分析。

- 在COCO目标检测数据集上,由于极深的表示,ResNet相对于其他方法获得了28%的改进。

ResNet 代码实现(基于pytorch,分类问题)

环境安装

以下是在全新环境中配置Conda虚拟环境的步骤,确保已经安装了Conda和Python:

-

安装 Miniconda:

- 首先,请确保已经安装 Miniconda。可以从Miniconda 官网下载适合您操作系统的版本。(anaconda也可)

- 安装完成后,在命令行中输入

conda -V来验证是否成功安装了 Miniconda。

-

创建虚拟环境:

- 打开命令行或终端,输入以下命令来创建一个名为

my_env的虚拟环境(可以自行更改环境名称,如resnet):conda create -n my_env python=3.8 - 这将创建一个基于 Python 3.8 的虚拟环境。

- 打开命令行或终端,输入以下命令来创建一个名为

-

激活虚拟环境:

- 输入以下命令来激活刚刚创建的虚拟环境:

conda activate my_env - 现在您已经在

my_env环境中了。

- 输入以下命令来激活刚刚创建的虚拟环境:

-

安装所需的软件包:

- 在激活的虚拟环境中,您可以使用以下命令安装所需的软件包,例如 PyTorch 和 TorchVision:

conda install pytorch torchvision torchaudio cudatoolkit=11.1 -c pytorch - 这将安装 PyTorch 和相关依赖。

- 在激活的虚拟环境中,您可以使用以下命令安装所需的软件包,例如 PyTorch 和 TorchVision:

-

编写代码:

- 下面已经提供。

到这里就完成了虚拟环境的安装,可以开始编写和运行下面的代码了!

- 运行代码:

- 在虚拟环境中运行您的代码:

python resnet.py

- 在虚拟环境中运行您的代码:

代码实现

下面是基于ResNet-50的分类任务代码示例,我们将使用PyTorch和TorchVision库。

将下面代码copy到编辑器中,新建文件名字为“resnet.py”

import torch

import torch.nn as nn

import torchvision.models as models

import torchvision.transforms as transforms

from torchvision.datasets import CIFAR10

from torch.utils.data import DataLoader

# 设置设备(GPU 或 CPU)

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

# 加载预训练的 ResNet-50 模型

resnet50 = models.resnet50(pretrained=True)

resnet50.to(device)

resnet50.eval()

# 数据预处理

transform = transforms.Compose([

transforms.Resize((224, 224)),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])

])

# 加载 CIFAR-10 数据集

dataset = CIFAR10(root="./data", train=False, transform=transform, download=True)

dataloader = DataLoader(dataset, batch_size=1, shuffle=False)

# 分类任务

with torch.no_grad():

for images, labels in dataloader:

images = images.to(device)

outputs = resnet50(images)

_, predicted = torch.max(outputs, 1)

print(f"Predicted class: {predicted.item()}")

# resnet50=====cifar10=====分类问题======

这段代码会加载预训练的 ResNet-50 模型,并在 CIFAR-10 数据集上进行分类预测。可以根据自己的需求修改数据集和其他参数。

4589

4589

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?