目录

一、集成学习是什么

在机器学习的领域中,集成学习(Ensemble Learning)就像是一个神秘而强大的魔法,能够将多个看似普通的学习器组合在一起,发挥出意想不到的强大力量。简单来说,集成学习通过构建并结合多个学习器来完成学习任务,从而获得比单个学习器更好的性能。

我们可以用一个生活中的例子来类比。假如你要策划一场大型活动,你可以选择独自完成所有工作,但这可能会让你感到力不从心,而且容易出现各种疏漏。但如果你组建一个团队,团队成员分别负责活动策划、场地布置、物资采购、人员联络等不同方面,每个人都发挥自己的专长,最后将大家的工作成果整合起来,那么这场活动成功举办的概率就会大大提高。这就是集成学习的核心思想,将多个 “弱学习器” 组合起来,形成一个更强大的 “强学习器” ,也就是我们常说的 “三个臭皮匠,顶个诸葛亮”。

在集成学习中,这些学习器可以是相同类型的,比如多个决策树组成的随机森林;也可以是不同类型的,比如将决策树、支持向量机和神经网络等组合在一起。它们就像团队中的不同成员,各自有着独特的技能和优势,通过协作来解决复杂的问题。

二、为什么集成学习如此强大

集成学习之所以能在机器学习领域中脱颖而出,拥有强大的性能,是因为它巧妙地利用了多个学习器之间的互补性,有效地降低了模型的方差、偏差,减少了过拟合现象,从而显著提高了模型的泛化能力 。

从理论上来说,一个模型的泛化误差可以分解为偏差(Bias)、方差(Variance)和噪声(Noise)三部分。偏差衡量的是模型的预测值与真实值之间的差距,反映了模型的拟合能力;方差衡量的是模型在不同训练数据集上的波动程度,反映了模型对数据的敏感程度;噪声则是数据本身固有的,无法通过模型改进来消除。

集成学习中的 Bagging(如随机森林)方法,主要通过对训练数据进行有放回的随机采样,构建多个不同的训练子集,然后在这些子集上分别训练基学习器,最后将这些基学习器的预测结果进行平均(回归问题)或投票(分类问题)。这样做的好处是,每个基学习器都在不同的数据集上进行训练,它们之间的相关性较低,从而有效地降低了模型的方差 。就像一群人对同一件事情进行判断,每个人的观点都有一定的随机性,但当把他们的观点综合起来时,就能够减少个体的不确定性,得到更稳定的结论。

而 Boosting(如 AdaBoost、XGBoost)方法则是通过迭代训练一系列的弱学习器,每一轮训练都会根据上一轮的预测结果调整样本的权重,使得那些被错误分类的样本在后续的训练中得到更多的关注,从而逐步降低模型的偏差 。这就好比在学习过程中,不断地针对自己的薄弱环节进行强化训练,从而提高整体的学习效果。

我们可以通过一个简单的图表来直观地理解集成学习的优势。假设我们有三个基学习器 A、B、C,它们在不同的数据分布区域有着不同的表现,有的在区域 1 表现较好,有的在区域 2 表现较好。当我们将这三个学习器集成起来时,就能够在更广泛的数据分布上都取得较好的预测效果,大大提高了模型的泛化能力 。

[此处插入一张简单的示意图,展示三个基学习器和集成学习器在不同数据分布区域的预测效果对比,如三个基学习器的预测曲线在不同区域有起伏,而集成学习器的预测曲线相对更平滑且更接近真实值]

总之,集成学习通过合理地组合多个学习器,能够在偏差和方差之间找到更好的平衡,从而提升模型的整体性能,使其在面对复杂的数据和任务时表现得更加出色 。

三、集成学习的常见算法家族

集成学习经过多年的发展,已经形成了多个具有代表性的算法家族,每个家族都有其独特的思想和应用场景,下面我们就来详细了解一下其中最为经典的三个:Bagging、Boosting 和 Stacking 。

3.1 Bagging:并行协作的 “森林”

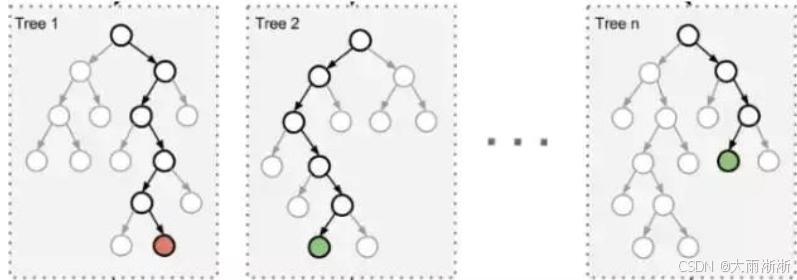

Bagging,全称为 Bootstrap Aggregating,即自助采样聚合,是一种并行式的集成学习方法 。它的核心思路就像是从一个大的训练数据 “宝库” 中,通过有放回的随机抽样,构建出多个不同的 “小宝藏”,也就是子数据集。然后,利用这些子数据集分别训练出多个个体学习器,最后将这些个体学习器的预测结果进行整合 。在分类问题中,通常采用投票的方式,让各个学习器进行 “投票表决”,得票最多的类别就是最终的预测结果;在回归问题中,则是将各个学习器的预测值进行平均,得到最终的预测值 。

以随机森林(Random Forest)为例,它是 Bagging 算法的一个典型应用,也是最为大家所熟知的集成学习算法之一 。随机森林以决策树作为基学习器,在构建每一棵决策树时,不仅对数据样本进行有放回的随机采样,还会在每个节点分裂时,从所有特征中随机选择一部分特征来寻找最优的分裂点 。这种双重随机性,使得每棵决策树都具有一定的差异性,就像森林中的每棵树都有自己独特的生长形态 。众多决策树组合在一起,就形成了一片强大的 “随机森林”,大大降低了模型的方差,提高了模型的泛化能力和稳定性 。

随机森林在特征选择上也有着独特的优势。它可以通过计算每个特征在所有决策树中的平均重要性得分,来评估特征的重要程度 。例如,在一个预测客户流失的项目中,我们可以利用随机森林算法对客户的年龄、性别、消费金额、购买频率等多个特征进行分析 。通过特征重要性评估,我们发现消费金额和购买频率这两个特征对于预测客户是否会流失具有较高的重要性,而客户的性别对预测结果的影响相对较小 。基于这些分析结果,我们可以选择保留消费金额和购买频率等重要特征,去除一些不重要的特征,从而简化模型,提高模型的训练效率和预测准确性 。

在实际应用中,随机森林在许多领域都发挥着重要作用。除了刚才提到的客户流失预测,它还广泛应用于图像识别、疾病诊断、金融风险评估等领域 。比如在图像识别中,随机森林可以对图像的各种特征进行分析和分类,帮助我们识别出图像中的物体类别;在疾病诊断中,它可以根据患者的症状、检查结果等多方面信息,辅助医生判断患者是否患有某种疾病 。

3.2 Boosting:迭代进化的 “逆袭者”

Boosting 则是另一种截然不同的集成学习思路,它采用的是串行的方式进行训练 。Boos

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

819

819

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?