Hadoop 3.3.6配置文件

提示:这篇教程对于 linux 安装 Hadoop 要写完成前置配置: 服务器创建、固定 IP、防火墙关闭、Hadoop 用户创建、SSH 免密、JDK 部署等操作

例如:JDK 部署等操作

前言

在网上找了好久好久的3.3.6或者其他的配置文件教程,都不是很满意,于是就自己总结写了这一篇有关3.3.6的配置文件

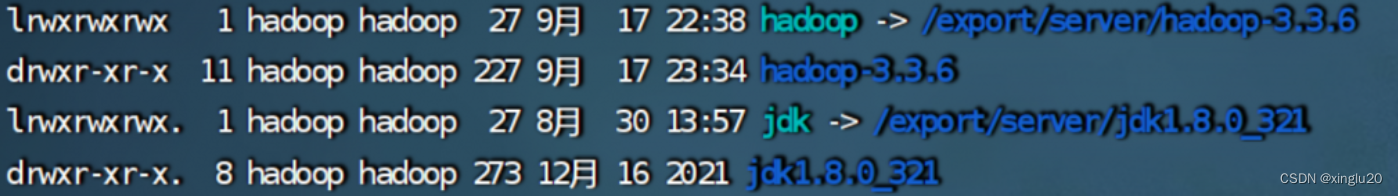

先看我的文件地址与说明

jdk 文件路径与 hadoop 都是在 /export/server/

提示:以下是本篇文章正文内容,下面案例可供参考

一、Hadoop上传并解压

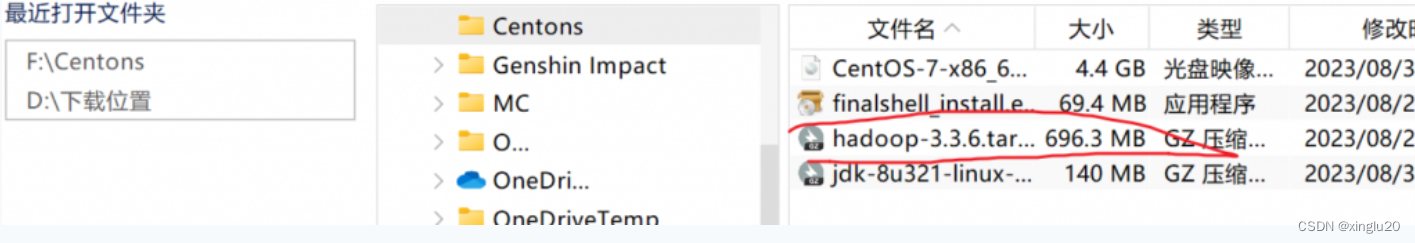

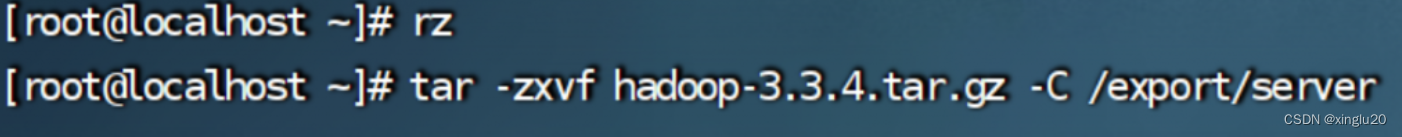

现在就正式开始: 通过 rz 命令上传

解压缩安装包到

/export/server/ 中 tar -zxvf hadoop-3.3.6.tar.gz -C /export/server

创建软链接方便后续配置操作

cd /export/server

ln -s /export/server/hadoop-3.3.6 hadoop

二、Hadoop文件配置

接下来就是真正的开始配置:先cd

cd hadoop/etc/hadoop/

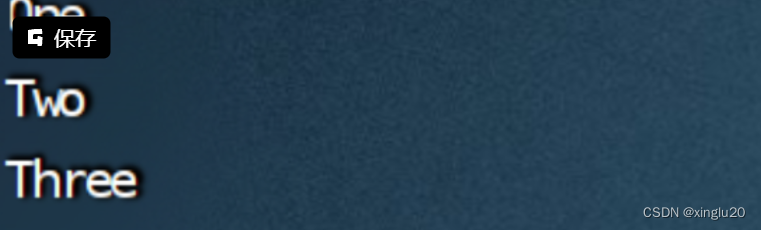

1. vim workers

这里根据自己的主机来 我是 One Two Three

主机1

主机2

主机3

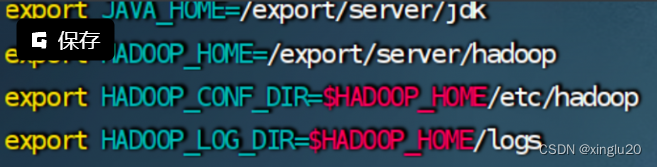

2. vim hadoop-env.sh

文件环境变量更具自己的来

export JAVA_HOME=/export/server/jdk

export HADOOP_HOME=/export/server/hadoop

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export HADOOP_LOG_DIR=$HADOOP_HOME/logs

3.vim core-site.xml

注意下面要改自己的主机名

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://自己的主机1:8020</value>

</property>

<property>

<name>io.file.buffer.size</name>

<value>131072</value>

</property>

</configuration>

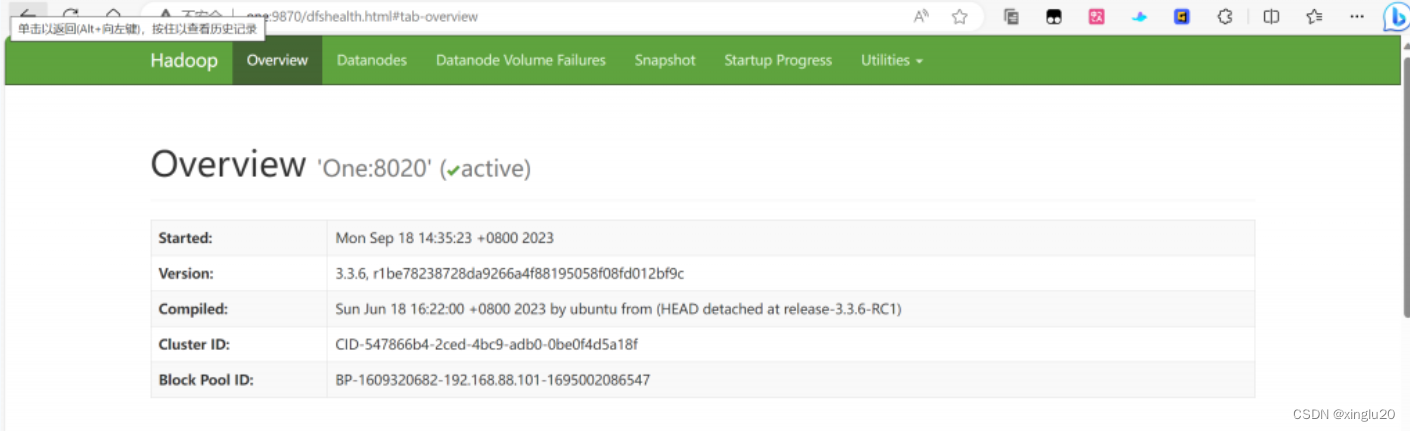

4.vim hdfs-site.xml

注意下面要改自己的主机名

<configuration>

<property>

<name>dfs.namenode.http-address</name>

<value>0.0.0.0:9870</value>

<description> The address and the base port where the dfs namenode web ui will listen on.

</description>

</property>

<property>

<name>dfs.datanode.data.dir.perm</name>

<value>700</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/data/nn</value>

</property>

<property>

<name>dfs.namenode.hosts</name>

<value>主机1,主机2,主机3</value>

</property>

<property>

<name>dfs.blocksize</name>

<value>268435456</value>

</property>

<property>

<name>dfs.namenode.handler.count</name>

<value>100</value>

</property>

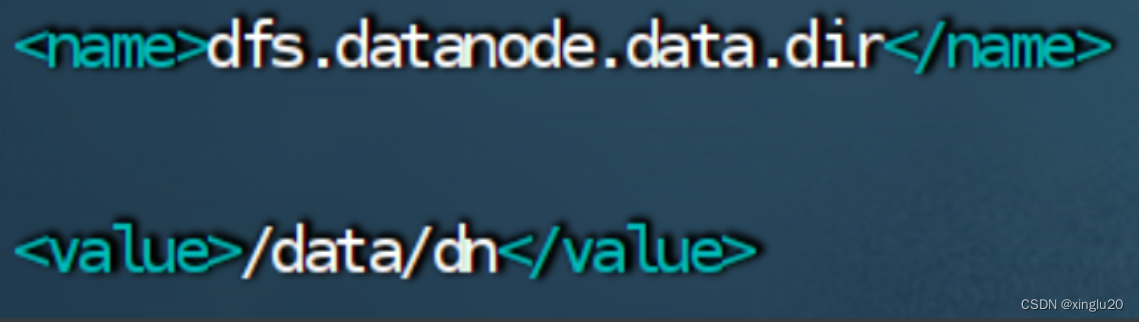

<property>

<name>dfs.datanode.data.dir</name>

<value>/data/dn</value>

</property>

</configuration>

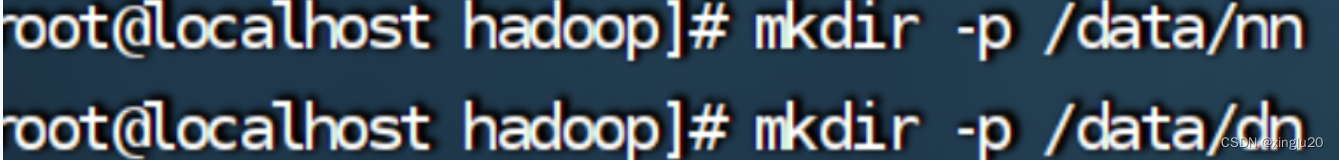

因为在这里配置了:

现在要创建这两个目录,上一步退出就可以直接创建,

现在要创建这两个目录,上一步退出就可以直接创建,主机 123 三个都要分别创建。主机23 先创建后面分发直接用:

5.vim mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.application.classpath</name>

<value>$HADOOP_MAPRED_HOME/share/hadoop/mapreduce/:$HADOOP_MAPRED_HOME/share/hadoop/mapreduce/lib/</value>

</property>

</configuration>

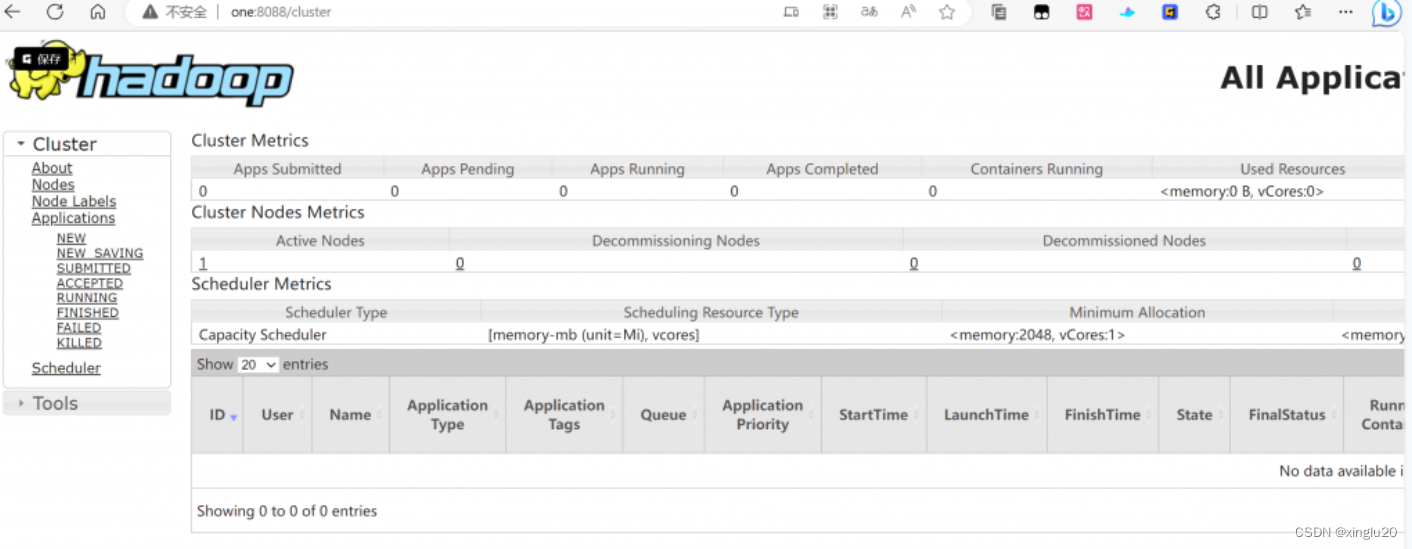

6.vim yarn-site.xml

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.env-whitelist</name> <value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value>

</property>

<property>

<name>yarn.scheduler.minimum-allocation-mb</name>

yarn.scheduler.minimum-allocation-mb

<value>2048</value>

</property>

</configuration>

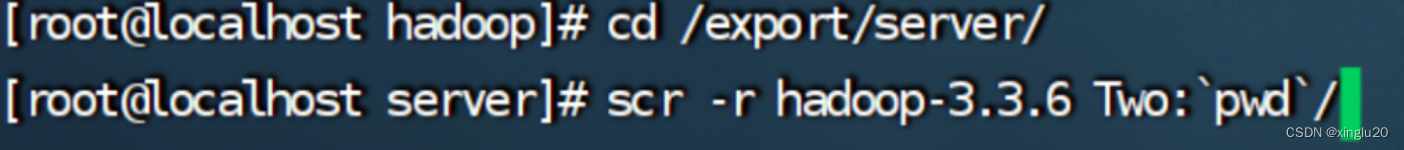

3.分发

1.分发hadoop到 主机2,3

先cd到hadoop的文件下

cd /export/server

scp -r hadoop-3.3.4 主机2:`pwd`/

scp -r hadoop-3.3.4 主机3:`pwd`/

2.创建软连接

主机2,3先cd在创建

cd /export/server/

ln -s /export/server/hadoop-3.3.6 hadoop

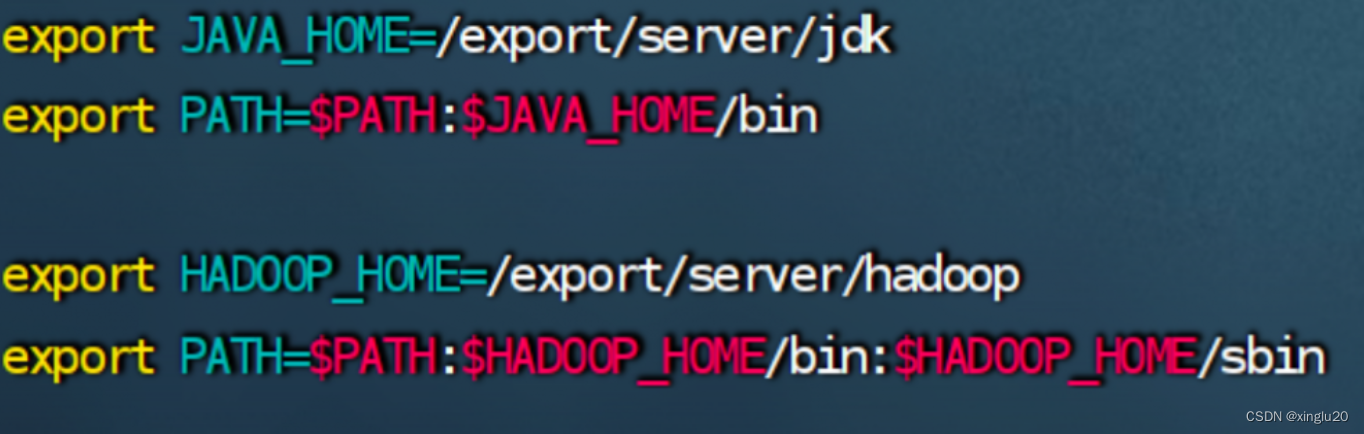

3.环境变量配置

在前置的java环境变量下配置Hadoop环境变量

vim /etc/profile

export HADOOP_HOME=/export/server/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

4.hadoop权限配置

主机 123 都执行: 以 root 权限 给 hadoop 用户配置相关权限(没有 hadoop 用户先创建一个也要无密互联 ssh)

chown -R hadoop:hadoop /data

chown -R hadoop:hadoop /export

4. 格式化与启动

1.切换用户hadoop

su - hadoop

2.进行格式化

hdfs namenode -format

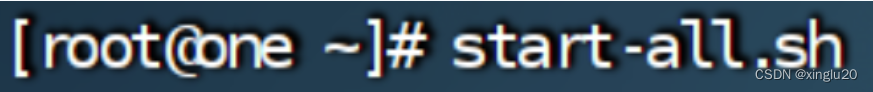

3.启动!!!

一键启动:

start-all.sh

分开启动:

start-hdfs.sh

start-yarn.sh

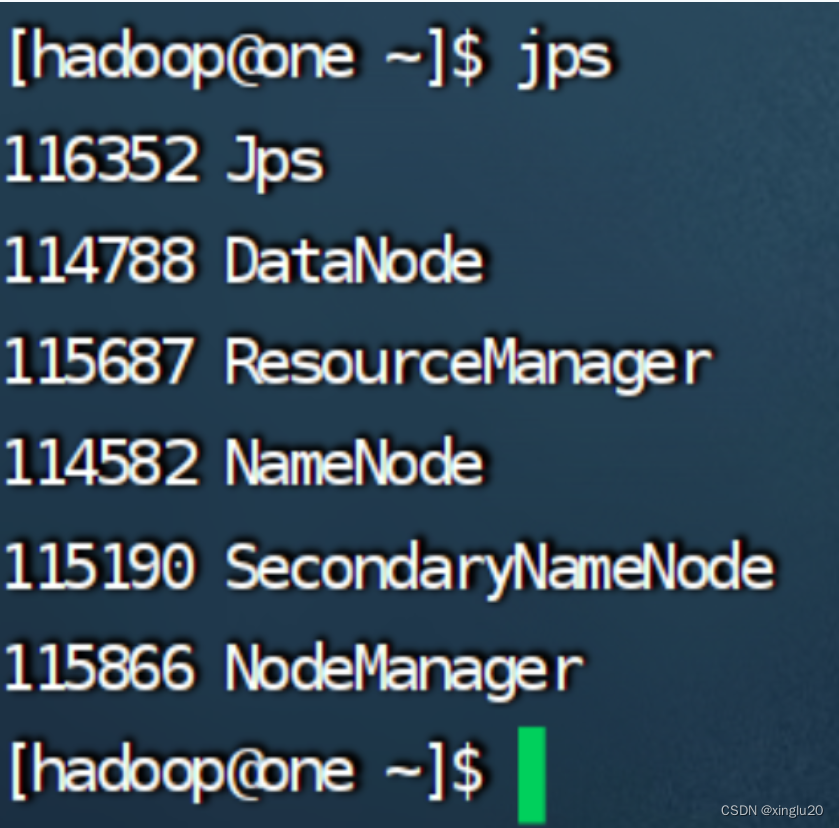

启动成功后有六个

5.部分问题解决

两个网页打不开

1.打开 hdfs-site.xml,增加如下配置

< property>

<name>dfs.namenode.http-address</name>

<value>0.0.0.0:9870</value>

<description>

The address and the base port where the dfs namenode web ui will listen on.

</description>

< /property>

2.打开 yarn-site.xml,增加如下配置

< property>

<name>yarn.resourcemanager.webapp.address</name>

<value>0.0.0.0:8088</value>

< /property>

上图

6351

6351

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?