论文翻译-Text Recognition in the Wild: A Survey

- 原文地址:https://arxiv.org/pdf/2005.03492v3.pdf

- 参考翻译:https://blog.csdn.net/qq_36268755/article/details/105998417

- 【推荐】相关阅读资料下载:

链接:https://pan.baidu.com/s/1Ezubqw6IAOFESSTQD26eBg

提取码:bptk- 【注】:翻译仅供参考,准确含义和表达参考英文原文

Text Recognition in the Wild: A Survey

摘要

文字的历史可以追溯到几千年前。文本承载的丰富而精确的语义信息在广泛的基于视觉的应用场景中具有重要意义。因此,自然场景中的文本识别一直是计算机视觉和模式识别中一个活跃的研究领域。近年来,随着深度学习的兴起和发展,众多方法在创新性、实用性和效率方面都表现出良好的前景。本文旨在(1)总结与场景文本识别相关的基本问题和最新技术; (2) 引入新的见解和想法; (3) 提供对公开可用资源的全面审查; (四)指出今后工作的方向。总之,这篇文献综述试图呈现场景文本识别领域的全貌。它为进入该领域的人们提供了全面的参考,并有助于激发未来的研究。我们的 Github 存储库中提供了相关资源:https://github.com/HCIILAB/Scene-Text-Recognition

1.介绍

文本是用于记录,交流或继承文化的符号系统。 作为人类最有影响力的发明之一,文本在人类生活中发挥了重要作用。 具体来说,文本携带的丰富而精确的语义信息在各种基于视觉的应用场景中都很重要,例如图像搜索,智能检测,工业自动化,机器人导航和 即时翻译。 因此,最近的“ ICDAR健壮阅读比赛”的出现表明自然场景中的文本识别已引起研究人员和从业者的关注。

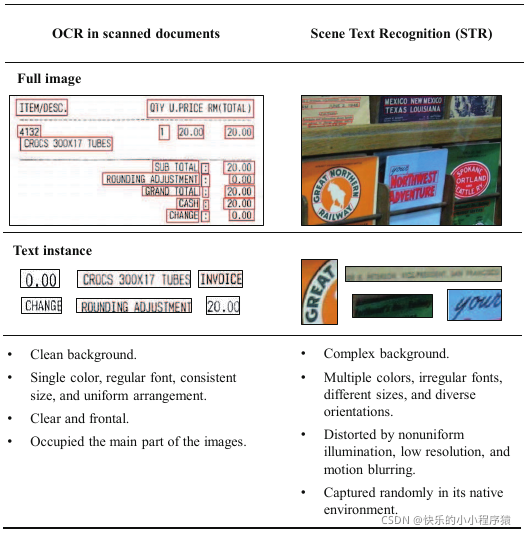

在自然场景中识别文本,也称为场景文本识别(STR),通常被认为是光学字符识别(OCR)的一种特殊形式,即基于相机的OCR。 尽管扫描文档中的OCR十分发达 ,但STR仍然具有挑战性,因为背景复杂,字体多种和成像条件不完善等诸多因素。 图1比较了扫描文档中STR和OCR的以下特征。

图1 扫描文档中 STR 和 OCR 的比较

-

背景:与扫描文档中的OCR不同,自然场景中的文本可以出现在任何物体(例如,招牌,墙壁或产品包装)上。 因此,场景文本图像可能包含非常复杂的背景。 此外,背景的纹理在视觉上可能类似于文本,这给识别带来了额外的挑战。

-

形式:扫描文档中的文本通常以单色打印,并具有规则的字体,一致的大小和均匀的排列。 在自然场景中,文本会以不规则的字体,不同的大小和不同的方向以多种颜色出现。 文本的多样性使STR比OCR在扫描的文档中更加困难和具有挑战性。

-

噪声:自然场景中的文本通常会因噪声干扰而失真,例如照明不均匀,分辨率低和运动模糊。 成像条件不完善会导致STR故障。

-

访问:扫描的文本通常是正面的,并且占据图像的主要部分。 但是,场景文本是随机捕获的,这会导致不规则变形(例如透视变形)。 各种形状的文本增加了识别字符和预测文本字符串的难度。

由于其重要性和挑战性,近年来在自然场景中识别文本引起了学术界和工业界的极大兴趣。

早期研究,主要依靠手工制作的特征。 这些功能的低功能限制了识别性能。 随着深度学习的发展,神经网络极大地提高了STR的性能。 几个主要因素正在驱动基于深度学习的STR算法。 第一个因素是硬件系统的先进性。 高性能计算系统可以训练大规模识别网络。此外,现代移动设备,能够实时运行复杂的算法。 第二种是基于深度学习的STR算法中的自动特征学习,它不仅使研究人员摆脱了设计和选择手工特征的繁琐工作,而且还大大提高了识别性能。 第三是对STR应用的需求不断增长。 自然场景中的文本可以提供丰富而精确的信息,这有助于理解场景。 在大数据时代,自然场景中的文本自动识别在经济上是可行的,吸引了研究者和从业人员。

本文试图全面回顾STR领域,并为算法的公平比较建立基线。 通过总结基本问题和最新技术,介绍新的见解和想法,并展望未来的趋势,我们展示了STR的全貌。 因此,本白皮书旨在为研究人员提供参考,并为将来的工作提供帮助。 此外,我们对包括标准基准数据集和相关代码在内的可公开获得的资源进行了全面的综述。

文献,中有几条STR综述。 但是,上述大多数调查,都已过时。许多最近的进展(例如,2018 2020年开发的算法)未包括在这些调查中。 我们请读者阅读这些论文,以进行更全面的历史文学评论。 此外,Zhu等和Long等 回顾了场景文本检测和识别的方法。 Yin等调查了视频中文本检测,跟踪和识别的算法。 与这些调查不同,本文主要关注STR,目的是对该领域进行更详细,全面的概述。

本文的其余部分安排如下:第二部分介绍了背景,基本问题以及与文本相关的特殊问题。 第三部分介绍了近年来为STR开发的新见解和构想。第四部分总结了标准基准数据集和评估协议,并比较了识别算法的性能。 最后,第5节总结了论文,并确定了STR未来工作的潜在方向

2.背景

为了全面了解STR领域,我们将介绍与文本相关的基本问题和特殊问题。 此外,本节将列出并分析STR的一些代表性应用。

2.1图像中的文字

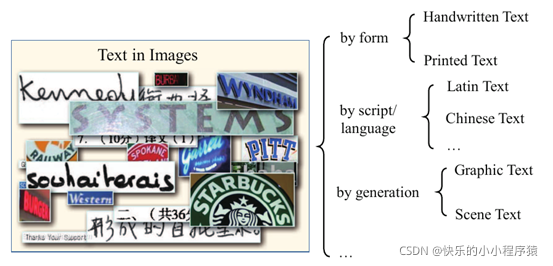

文字在图像中的显示方式可能有所不同。 图2显示了示例和典型分类。 例如,如果按文本形式分类,则手写文本和印刷文本是两个基本类。 值得注意的是,分类方法可能会重叠。 由于各种手写风格和字符触摸问题,手写文本识别比印刷文本识别更具挑战性。 根据脚本/语言,图像中的文本可能包含不同的字符,例如拉丁文,中文或印地文。 诸如文本类别和阅读顺序之类的文本特性在不同语言中差异很大。 按照中的定义,图像中的文本也可以分为“图形文本”和“场景文本”。 前者是指以数字形式叠加在视频或图像上的文本。 后者是指在其本机环境中捕获的对象上的文本。场景文本具有多种样式,可以出现在任何表面上,这使得很难区分复杂背景的文本。通常,STR处理印刷的拉丁场景文本。

本文总结的所有方法都使用这种类型的文本。

图2 图像中文本的典型分类

2.2基本问题和特殊问题

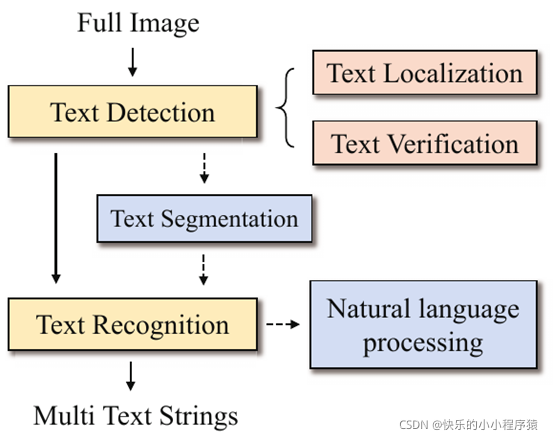

在许多基于视觉的应用场景中,文本携带的丰富而精确的信息非常重要。 但是,从自然场景中提取文本并在其他应用程序中使用它是一个复杂的过程。 如图3所示,文献中在此任务的各个阶段定义了各种基本问题:文本定位,文本验证,文本检测,文本分割,文本识别和端到端系统。 此外,由于文本的独特挑战,存在与文本相关的特殊问题。 还简要介绍了文本增强,文本跟踪和自然语言处理(NLP)。 对这些通用概念的清晰理解可以帮助研究人员分析不同任务之间的差异和联系。

图3 端到端系统的说明,它定义了各个阶段的各种基本问题:文本检测、文本定位、文本验证、文本分割和文本识别。有些阶段在端到端系统中没有被考虑到

2.2.1基本问题

- 文本定位:文本定位的目标是精确地定位文本组件,并将它们分组到尽可能少的背景的候选文本区域。 早期的文本本地化方法基于低级特征,例如颜色,渐变,笔画宽度变换,最大稳定的末梢区域(MSER) ,Canny检测器,和连接的分量分析。 当前的大多数方法基于深度神经网络。

- 文本验证:文本验证旨在验证文本候选区域为文本还是非文本。通常使用 在文本定位之后过滤候选区域,因为文本定位有时会引入误报。 文本验证的方法包括先验知识,支持向量机(SVM)分类器和条件随机场(CRF)。 最近的工作,使用卷积神经网络(CNN)来改善文本/非文本的辨别力。

- 文本检测:文本检测的功能用于通过定位和验证来确定是否存在文本28]。 作为端到端系统的基础,它提供了精确而紧凑的文本实例图像以进行文本识别。 文本检测方法可以粗略分类为基于回归的方法,和基于实例分割的方法。

- 文本分割:文本分割已被确定为最具挑战性的问题之一。 它包括文本行分割,和字符分割。 前者是指将多个文本行的区域拆分为单个文本行的多个子区域。 后者是指将文本实例分成单个字符的多个区域。 字符分割通常用于早期的文本识别方法。

- 文本识别:文本识别将裁剪的文本实例图像转换为目标字符串序列。 它是端到端系统的重要组成部分,可提供可靠的识别结果。 传统的文本识别方法依赖手工制作的功能,例如定向梯度描述符的直方图,连接的组件和笔划宽度变换。 最新研究使用深度学习编码器-解码器框架。

- 端到端系统:鉴于场景文本图像,端到端系统可以直接将所有文本区域转换为 目标字符串序列。 它通常包括文本检测,文本识别和后处理。 实时,高效的端到端系统,的构建已成为近年来的新趋势。 一些研究者,将文本检测和文本识别解释为两个独立的子问题,将它们组合起来构成一个端到端的系统。 另一种方法,是通过共享信息来共同优化文本检测和文本识别。

2.2.2特殊问题

- 脚本识别:脚本识别旨在预测给定文本图像的脚本。 它在多语言系统中扮演着越来越重要的角色。由于文本识别依赖于语言,因此检测脚本和语言有助于选择正确的语言模型。 脚本识别可以解释为图像分类问题,通常设计区别性表示,例如中级特征,卷积特征,和笔触部分表示。

- 文本增强:文本增强可以重新显示降级的文本,提高文本的分辨率,消除文本的变形或消除背景,从而降低了难度 文字识别。 已经研究了许多用于文本增强的算法,并获得了有希望的结果,例如反卷积,基于学习的方法和稀疏重构。

- 文本跟踪:文本跟踪的目的 ,是为了保持视频中相邻帧之间文本位置和跟踪文本的完整性。 与图像中的静态文本不同,用于移动文本的跟踪算法必须在像素级别或子像素级别标识精确的文本区域,因为错误的跟踪可能会将文本与其背景或噪声文本混合在一起。 时空分析,通常用于视频中的文本跟踪。 最近的一项研究也预测了跟踪字符的运动。

- 自然语言处理:自然语言处理(NLP)探索了如何使用计算机来理解和操纵自然语言文本或语音。 NLP是人机通信的桥梁。 文本作为非结构化数据的最重要类型,是NLP的主要对象。 NLP的基于文本的应用程序非常广泛,包括机器翻译,自动摘要,问题解答,和关系提取。

2.3应用

文本作为最重要的交流和感知世界的载体,丰富了我们的生活。场景文本识别在各个行业和日常生活中的众多应用:i) 智能交通。构建自动地理编码系统 、 不仅方便出行,而且使用户能够克服语言障碍,例如自动识别道路标志 并将文本翻译成另一种语言。 ii) 信息提取。图片中的文字虽然包含精确的信息,但在大数据时代,仅靠人力几乎不可能输入海量数据。例如,2017 年中国快递业务量已超过 400 亿 。在自然场景中自动识别文本可以节省大量资源并保护客户隐私。 iii) 视觉输入和访问。根据世界卫生组织 1 ,世界上至少有 22 亿人患有视力障碍或失明。除了先进的医疗方法,场景文本识别技术还可以改善他们的生活,例如,开发文本转语音设备来帮助理解书籍、ATM 说明和药品标签 。除了我们上面提到的应用之外,还有一些具体的STR应用场景,比如文本视觉问答(text VQA)、e-discovery、多媒体检索、,自动身份认证,也在悄然改变着我们的生活品质。

3.方法

在早期的研究中,手工制作的特征被用于文本识别,例如定向梯度描述符的直方图,连接的分量和笔划宽度变换。 但是,这些方法的性能受到低容量功能的限制。 随着深度学习的兴起和发展,社区在各种方法的创新,实用性和效率方面见证了实质性的进步。 与传统方法相比,深度学习方法具有以下优点:i)自动化:自动特征表示学习可以使研究人员免于凭经验设计手工特征。 ii)效率:出色的识别性能远远超过传统算法。 iii)通用化:算法可以轻松地应用于类似的基于视觉的问题。 在本节中,我们将介绍深度学习时代为STR和端到端系统提出的新见解和想法。 审查了每种方法的主要作用。 如果有多个贡献,我们将分别对其进行分析。

3.1裁剪场景文本图像识别

STR的目的是将裁剪的文本实例图像转换为目标字符串序列。 自然界中有两种类型的场景文本,即规则的和不规则的。 存在两种主要的STR类别:基于分割的方法和无分割的方法。 对于无分割方法,它们可以大致分为基于CTC的方法和基于注意力的方法。 此外,本节还介绍了其他有希望的想法,例如标签嵌入。 表1给出了这些识别方法的综合列表和分类。

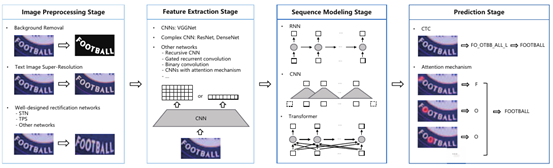

图4 无分割的STR方法的概述。图像预处理和序列建模阶段不一定需要。此外,图像预处理的要素可以结合起来,以进一步提高识别性能。

3.1.1基于分割的方法

STR方法的一类是基于分割,它通常包括三个步骤:图像预处理,字符分割和字符识别。 基于分割的方法尝试从输入文本实例图像中定位每个字符的位置,应用字符分类器识别每个字符,然后将字符分组到文本行中以获得最终识别结果。

早期成功的基于深度学习的STR系统 由Wang等人开发,它使用了一个图形模型,该图形模型以字符的分数和位置作为输入,以确定来自小词典的特定单词的最佳配置。 提出的识别算法优于领先的商用OCR引擎ABBYY FineReader1,后者是STR的基准。 后来,受深度卷积神经网络在视觉理解上的成功启发,Wang等,Mishra等,刘等结合了多层神经网络和无监督特征学习来训练一个高精度的字符识别器模块。 对于后处理,将具有字符间距的字符响应,基于波束搜索算法或基于加权有限状态换能器的表示应用于识别已定义词典中的目标单词。 为了进一步改善识别性能,研究人员探索了健壮的词图像表示形式,例如尺度不变特征变换(SIFT)描述符,Strokelets 和中层特征。

所有上述方法都依赖于词典来获得最终的识别结果。 但是,查询时间线性地取决于词典的大小。 对于openlexicon,由于搜索空间大,因此这些策略不切实际。 为了解决此问题,已对STR进行了无词典的尝试。 一些研究者通过采用大型词典作为高阶统计语言模型来克服了对受限词表的需求。 其他人则利用大型数据和更复杂的神经网络,例如卷积Maxout网络,以无词典的方式解决了STR。 最近,Wan等建立了一个基于语义分割的识别系统,该系统可以预测具有两个独立分支的字符的类和几何信息,并进一步提高识别性能。

尽管基于分割的STR方法已经取得了重大进展,但仍然存在关键缺点:i)所有这些流水线需要准确检测各个字符,这已被识别为社区中最具挑战性的问题之一。 因此,字符检测器/分割器的质量通常会限制识别性能。 ii)基于分割的识别器无法对超出单个字符的上下文信息进行建模,这可能会导致训练过程中单词级别的结果不佳。

3.1.2基于无分割的方法

第二类是无分割方法。 该方法是识别整个文本行,并着重于通过编码器-解码器框架将整个文本实例图像直接映射到目标字符串序列,从而避免了字符分割。图5显示了一种典型的无分割方法,该方法包含图像预处理,特征表示,序列建模和预测的四个阶段。

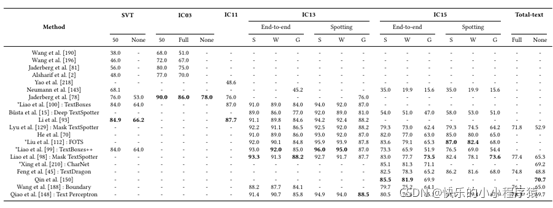

表1 现有识别方法的总结。 ‘SK’、‘ST’、‘ExPu’、‘ExPr’和‘Un’分别表示使用Synth90K数据集、SynthText数据集、额外公共数据、额外私有数据和未知数据的方法。 “常规”表示目标是常规数据集,其中大多数文本实例是正面和水平的。 “不规则”表示目标是不规则数据集,其中大多数文本实例是低分辨率、透视扭曲或弯曲的。 ‘*’表示使用除 Synth90k 和 SynthText 之外的额外数据集的方法。

图像预处理阶段

图像预处理旨在通过减轻来自不完美成像条件的干扰来提高图像质量,这可能会改善特征表示和识别。

- 背景去除。文本可能出现在背景复杂的各种场景中。 背景的纹理特征在视觉上可能与文本相似,这会导致识别上的额外困难。不是复杂的特征表示和综合方法,一种直观但鲜为人知的解决方案是将文本内容与复杂背景分开 。 尽管传统的二值化方法在文档图像上效果很好,但是它们无法处理自然图像中文本外观和噪点方面的实质性变化。 使用生成对抗网络(GANs)在保留文本内容的同时去除了背景,从而降低了识别难度并极大地提高了性能。

- 文本图像超分辨率(TextSR)。场景文本通常会因各种噪声干扰而失真, 例如低分辨率。 低分辨率可能导致错误识别的字符或单词。 文本图像超分辨率(TextSR)可以输出与给定的低分辨率图像一致的合理的高分辨率图像。 这种方法可以帮助低分辨率图像中的文本识别。经典方法,例如双线性,双三次或设计的过滤,旨在重建自然图像的详细纹理,但不适用于模糊文本。 Wang等并没有将超分辨率简单地视为回归问题。 首先将TextSR方法与识别任务相结合,从而大大提高了文本识别器的性能。

- 矫正。校正的功能是对输入的文本实例图像进行规范化处理,消除失真并减少不规则文本识别的难度 。 具体来说,不规则文本指的是具有透视失真或任意弯曲形状的文本,通常会引起其他识别方面的挑战。空间Transformer网络(STN)被用作早期纠正模块,以纠正整个文本图像,]或单个字符区域。 后来,Shi等和Jeonghunet等158]采用薄板样条(TPS)处理更复杂的失真。 最近,提出了一些设计合理的校正网络。例如,开发了一种多对象校正网络,通过预测输入图像各部分的偏移量来校正不规则文本。 Zhan等设计了一种新颖的行拟合变换和一个基于TPS的迭代校正框架,以实现最佳的场景文本校正。 根据中心线,比例尺和方向等局部属性,Yang等 提出了一种对称约束整流网络。为了处理各种畸变,复杂的整流模块是必需的,并成为一种新趋势。 但是,这些都会影响识别算法的速度和内存消耗。 从业者应根据不同应用场景下的需求选择最佳的权衡。 此外,随着不规则文本检测的发展,值得重新考虑STR系统是否需要校正模块。

图像预处理包括但不限于上述类型。 它可以通过改善图像质量来显著降低识别难度。 各种方法可以组合使用。 尽管存在许多识别算法,但这些用于文本的辅助预处理方法在社区中并不常用,尤其是用于背景去除和TextSR。 此外,大多数通用的现成算法都集中在单个对象的样式上,而场景文本图像通常包含多个字符。 因此,针对STR的精心设计和专门设计的预处理算法值得研究人员在未来的工作中关注。

特征表示阶段

特征表示法将输入文本实例图像映射到反映与字符识别相关的属性的表示法,同时抑制字体,颜色,大小和背景等不相关的特征。

受,成功的启发 ,Su等在他们的STR系统中使用定向梯度直方图(HOG)功能来构造单词图像的顺序特征。 后来,CNN ,已广泛用于特征表示阶段,例如VGGNet 。 为了更强大的特征表示,在STR算法中应用了一些复杂的神经网络,例如ResNet ,和DenseNet 。 近来,已经进行了一些尝试以从不同的角度来改进特征表示模块。 Lee等人使用了递归CNN 为参数有效和有效的图像特征表示,它可以在相同的参数容量下增加传统CNN的深度,并产生更紧凑的特征响应。 Wang等人受递归卷积神经网络(RCNN)图像分类的启发。 通过引入控制RCNN中的上下文调制的门,设计了用于特征序列表示的延迟循环卷积层。 Liu等 专注于实时STR,并提出了一种新颖的二进制卷积层。他们声称二进制表示显著加快了运行时推断并减少了内存使用。认为,由CNN直接处理源图像会引入额外的噪声。 因此,他们将CNN与注意力机制结合起来来增强前景文本的表示并抑制背景噪声。

更深,更高级的特征提取器通常会产生更好的表示能力,这适合于改善具有复杂背景的STR。 然而,性能的提高是以存储器和计算消耗为代价的。 背景去除技术与简单特征提取器的组合可能是未来研究的替代方法。

序列建模阶段

序列建模作为视觉特征和预测之间的桥梁,可以在一系列字符中捕获上下文信息,以供下一阶段预测每个字符,这比独立处理每个符号更加稳定和有用。

多个双向长期短期记忆(BiLSTM) 模型是在中引入的,并广泛用于,作为序列建模模块,因为它具有捕获能力 远程依赖关系。 Litman等。 在网络层增加了中间监督,并成功地训练了一个更深的BiLSTM模型来改善上下文依赖的编码。 但是,一些研究者,认为BiLSTM不是STR算法的必要组成部分。 他们认为,尽管BiLSTM有效地建模了上下文,但其结构在计算上非常耗时且费时。 此外,在训练过程中可能会导致梯度消失/爆炸。 因此,使用滑动窗口或深一维CNN ,代替BiLSTM。 最近,Yu等引入了全局语义推理模块,以通过多路并行传输来捕获全局语义上下文。

上下文线索对于基于图像的序列识别是有益的。 尽管基于递归神经网络(RNN)的结构(例如BiLSTM或LSTM)可以对字符序列进行建模,但存在一些固有的局限性。 与此相反,CNN或Transformer不仅可以有效地处理长序列,而且可以高效地并行化。由于CNN或Transformer结构的固有优势,使用CNN或Transformer结构对语言序列进行建模可能是一种新的趋势。

预测阶段

预测阶段的目的是从输入文本实例图像的识别特征中估计目标字符串序列。 连接主义的时间分类(CTC)和注意力机制是两种主要技术。 此外,本节还介绍了有关预测阶段的其他潜在想法。

连接主义时间分类

CTC由Graves等提出用于训练RNN ,直接标记未分段的序列。CTC在许多领域都取得了重大进步,例如语音识别,和在线手写文本识别。 CTC通常在STR中用作预测模块,即通过计算条件概率将CNN或RNN产生的输入特征转换为目标字符串序列的转录层。 特别地,CTC可以通过有效地汇总所有可能的输入-输出序列比对来最大化输出序列的可能性,并允许训练分类器而无需在输入序列和目标序列之间进行任何事先比对。

条件概率的表述可以简述如下。 输入特征用y =(y1,y2 … yT)表示,其中T是序列长度。 每一个yT是在L上的概率分布。 具体来说,L代表所有标签的集合,包括所有字符和代表无效输出的额外的空白符号。 CTC 路径 π 是一个长度为 T 的序列,它由空白符号和标签索引组成。由于有许多可能的方式将这些路径映射到转录 l,因此定义了一个 CTC 映射函数 B 来去除重复标签并从每个路径中删除空白符号。 然后,通过对 B 映射到 l 的所有路径的概率求和来计算条件概率:

其中,将π的概率定义为,y_(π_t)^t 是在时间步长 t 有标签 π_t 的概率。 由于直接计算上述方程的计算成本很高,因此大多数研究人员 、 采用前向后向算法 来有效地计算它。

受CTC在语音处理方面的成功启发,Su等,He等和Shi等首先将其应用于STR。 从那时起,许多基于CTC的预测算法,已经显示出有希望的转录性能。 但是,Liu认为CTC倾向于产生高度尖峰和过度自信的分布,这是过度拟合的症状。 为了解决这个问题,他们提出了一种基于最大条件熵增强和CTC探索能力的正则化方法。 通过融合焦点损失来修改传统的CTC,以解决对极端不平衡样本的识别问题。 最近,Hu等通过在STR中使用图卷积网络(GCN)提高了CTC的准确性和鲁棒性。

CTC具有出色的转录性能和稳定性。 但是,它面临一些固有的局限性:i) CTC 的底层方法是复杂的,这导致长文本序列的计算成本很大。 ii) CTC 存在峰值分布问题 、,并且其性能通常会因重复模式而降低。 iii) CTC 很难应用于二维 (2D) 预测问题,例如不规则场景文本识别,其中输入文本实例图像中的字符分布在空间结构中。 为了解决这个问题,Wan等人。 通过沿高度方向添加另一个尺寸来扩展普通的CTC。 尽管认知性能有所提高,但提出的2D-CTC模型尚未完全解决2D预测问题。 因此,应用CTC解决二维预测问题可能是未来研究的潜在方向。

注意力机制

注意机制是由Bahdanau等在神经机器翻译领域提出的,它可以自动搜索与给定源句的各个部分相关的预测词。 基于注意力机制的许多方法已经在各个领域取得了显著的进步,例如图像标题,文本识别和遥感图像的场景文本分类。对于STR,注意机制通常与RNN结构结合在一起作为预测模块。

特别是注意机制通过参考目标字符的历史和编码的特征向量来学习输入实例图像和输出文本序列之间的对齐方式。 令输出预测序列表示为o =(o1,o2 … oM),其中 M 表示最大解码步长。 在第 t 步,输出预测 o t 由下式给出:

其中 st 是 RNN 在时间步 t 的隐藏状态。 通常,门控循环单元(GRU)用于更新和模拟长期依赖性。 因此,st的计算公式为:

其中 oprev 是前一个输出 ot−1 的嵌入向量。 此外,gt 表示瞥见向量,计算为特征的加权和 h = (h1, h2 …hN )

其中,N是特征长度。是注意力权重向量,计算方式如下:

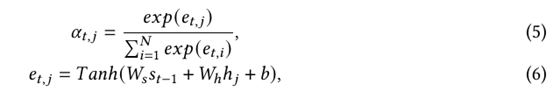

其中,为对齐分数,表示高级特征表示与当前输出之间的相关程度。 在上面的等式2和6中,Wo,bo,Ws,Wh和b是所有可训练参数。

受神经机器翻译系统发展的启发,大量基于注意力的方法, 已经出现在STR领域。 此外,还从不同的角度进行了一些尝试来提高寻常的注意力:i)应用于二维预测问题。对于不规则的场景文本识别,各种字符的放置大大增加了识别的难度。 寻常的注意被应用于表示1D特征选择和解码。 通过直接施加普通注意力,在2D文本分发和1D特征表示之间存在显著冲突。 因此,Yang等,Li等和Huang等提出了用于不规则文本识别的2D注意机制。ii)改进隐式语言模型的构建。 Chen等和Wang等认为,生成的glimpse vector的功能不足以表示预测的字符。 将高阶字符语言模型引入了普通的注意力机制,而Wang等 通过输入已经生成的部分字符序列和所有出席的对齐历史记录,构建了一个记忆增强的注意力模型。 Shi等指出,基于普通注意力的预测模块仅在一个方向上捕获了输出依存关系,而在另一个方向上忽略了输出依存关系。 因此,他们提出了一种双向注意的双向解码器,该解码器具有相反的方向。iii)改进并行化并降低了复杂度。尽管基于RNN结构的普通注意力机制可以捕获远距离依赖性,但计算量大且耗时。 在,中广泛采用了一种最新的变体,即Transformer ,以提高STR的并行度并降低其复杂性。iv)解决注意力漂移。注意力漂移现象意味着注意力模型无法将每个特征向量与输入图像中的对应目标区域准确关联。 一些研究者通过将偏离的注意力重新集中到目标区域上来增加了解决该问题的信息,例如定位监督和编码坐标。 其他,以级联的方式提高了注意力的对齐精度。 具体来说,Wang等认为严重的对齐问题是由其重复对齐机制引起的。 因此,他们将对齐操作与使用历史解码结果解耦。

近年来,基于注意力的预测方法已成为STR领域的主流方法,并且由于其专注于信息领域的能力而在解码方面优于CTC。 此外,注意方法可以轻松地扩展到复杂的2D预测问题。 但是,注意力机制存在一些缺点:i)由于此方法依赖于注意力模块进行标签对齐,因此需要更多的存储和计算量。 ii)对于长文本序列,由于输入实例图像和输出文本序列之间没有对齐,即注意力漂移现象,很难从零开始训练注意力机制。 iii)当前对注意力机制的研究主要集中在仅涉及几个字符类别(例如,英语,法语)的语言上。 据我们所知,没有公开报道有效地应用注意力机制来处理诸如中文文本识别之类的大型类别文本识别任务。

讨论

CTC和注意机制都有其优势和局限性。 最近,一些研究者,同时应用了CTC和注意力机制来实现准确的预测并保持快速的推理速度。 Cong等 在大规模的现实世界场景文本句子识别任务中,综合比较了这两种预测方法。 基于广泛的实验,他们为研究人员和从业人员提供了实用的建议。 例如,与基于CTC的方法相比,基于注意力的方法在孤立的单词识别任务上可以实现更高的识别精度,但在句子识别任务上却表现较差。 因此,应根据不同的应用场景和约束条件选择正确的预测方法。 此外,在未来的工作中探索替代的预测策略也很有价值。 例如,设计了聚合交叉熵函数来代替CTC和注意力机制。 它以更快的实施速度,减少的存储需求和便捷的使用实现了竞争性性能。

3.1.3 其他潜在方法

已经以不同的观点考虑和探索了其他方法。 Goel等人的动机是“整体大于部分之和”。 通过将场景和合成图像特征与加权动态时间规整(wDTW)方法进行匹配来识别自然场景中的文本。 后来,阿尔玛兹等人。 和Rodriguez等人 将识别和检索的任务解释为最近的邻居问题。 他们将标签图像嵌入和属性学习结合在一起,将单词图像和文本字符串都嵌入到一个公共的向量子空间或欧氏空间中。 具体来说,代表相同单词的图像和字符串将靠近在一起。 最近,Jaderberget等。 将STR列为多类分类问题。 他们仅根据合成数据训练了一个深层的CNN分类器:来自90个单词词典的大约900万张图像。 由于每个单词都对应一个输出神经元,因此建议的文本分类器无法识别字典外单词。 此外,他们将CNN与CRFgraphical模型相结合以实现不受约束的文本识别。

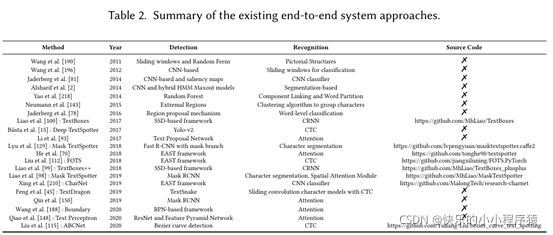

3.2端到端网络

给定具有复杂背景的文本图像作为输入,端到端系统旨在将所有文本区域直接转换为字符串序列。 通常,它包括文本检测,文本识别和后处理。 过去,文本检测和识别已被解释为两个独立的子问题,这些子问题结合起来可以从图像, 。最近,实时,高效的端到端系统的构建已成为社区中的新趋势。表2比较了这些端到端方法的特征。

有几个因素促进了端到端系统的出现:i)错误可能以文本检测和识别的级联方式累积,这可能导致很大一部分垃圾预测,而端到端系统可以防止错误的产生以及在训练过程中积累。 ii)在端到端系统中,文本检测和识别可以共享信息,并且可以共同优化以提高总体性能。 iii)端到端系统更易于维护和适应新的领域,而维护具有数据和模型相关性的级联管道需要大量的工程工作。 iv)端到端系统具有竞争优势,具有更快的推理速度和较小的存储需求。

最近的许多研究显示了联合优化的端到端模型的有效性,该模型通常包括检测分支和识别分支。 Bartz等 集成并共同学习了一个STN 以检测图像的文本区域。 相应的图像区域被直接裁剪并馈入一个简单的神经网络以识别文本内容。 然后使用高级的检测和识别算法来构建联合的端到端系统。 两个分支都通过裁剪检测分支的兴趣区域(RoIs)特征并将其馈送到识别分支来桥接。 通常,Girshick 提出了RoIPool,将不同比例和长宽比的RoI转换为固定大小的特征图,以进行物体检测。 但是,由于文本长度的较大变化,此方法可能导致明显的失真。 为了解决这个问题,Li等提出了可变大小的RoIPool,以适应原始的宽高比。由于RoIPool进行的量化会导致RoIs与提取的特征之间出现失准,因此许多方法都使用双线性插值来提取文本实例特征,例如双线性采样,RoIRotate ,以及文本对齐层。 最近的端到端系统,集中于任意形状的弯曲文本。 例如,Liao等 他们的扩展工作使用RoIAlign 来保存更准确的位置信息,将每个字符检索为通用对象,并使用字符级注释组成最终文本。 Feng等生成密集的检测四边形,并使用提出的RoIS-lide将从每个四边形裁剪的特征转换为已校正的特征。 然后将所有文本功能输入到基于CTC的识别器中,使框架摆脱字符级注释。 Wang等没有将文字检测分支公式化为边界框提取或实例分割任务,而在边界上定位了一组点,并采用了TPS 变换来使每个文本的特征扁平化。Qiao等提出了形状转换模块,该模块迭代生成潜在的基准点,并使用TPS将检测到的文本区域转换为没有额外参数的规则形态。 Liu等引入参数化的贝塞尔曲线以适应任意形状的文本,并设计了新颖的BezierAlign层以精确计算弯曲形状的文本实例的卷积特征。上述双线性插值方法的目的是将不规则形状的特征校正为文本的轴对齐特征识别器,其中差异是生成采样网格的方式。 然而,Qin等认为,特征校正是推广到不规则形状文本的关键瓶颈。 他们引入了RoI遮罩以滤除邻近的文本和背景,从而使识别器无需进行纠正。Xing等在没有任何RoI操作的情况下直接对全部功能执行字符检测和识别。

尽管当前的端到端系统在许多实际场景中都能很好地工作,但它们存在局限性。应考虑以下困难:i)如何有效地桥接并在文本检测和识别之间共享信息? ii)如何在文本检测和识别之间学习难度和收敛速度的显著差异之间取得平衡? iii)如何改善联合优化? 此外,尚未开发出一种简单,紧凑且功能强大的端到端系统。

4.评估和协议

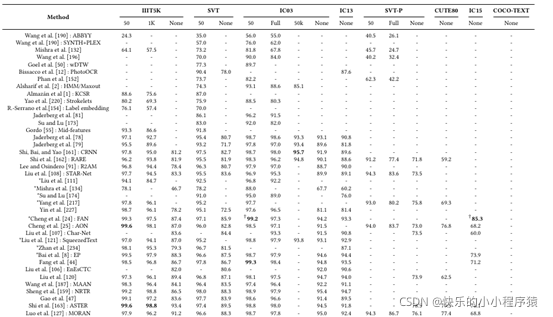

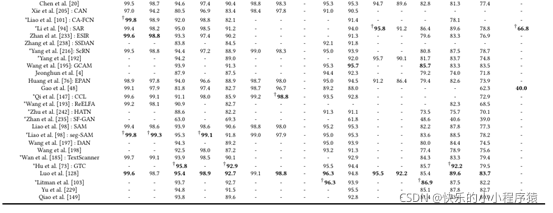

多样化的数据集和统一的评估协议分别给社会带来了新的挑战和公平的比较,但这两者对于推动STR领域的发展都是必要的。在本节中,我们研究了标准的基准数据集和评估协议。表4和表5比较了当前先进算法在STR和端到端系统中的表现。

4.1 数据集

有几个主要原因证明了对额外数据集的需求:i) 大多数深度学习方法都是数据驱动的。大规模的数据集对于训练一个好的文本识别器是非常重要和关键的。 ii)先进的STR算法在以前的数据集上被过度使用,表明可以研究更多具有挑战性的方面。 iii)新的数据集通常代表未来工作的潜在方向,如无词库文本识别、不规则文本识别、无监督或弱监督文本识别和大规模类别文本识别。

根据数据集收集的类型,我们将标准基准数据集分为两类:合成数据集和现实数据集。特别是,现实数据集包括常规拉丁语数据集、不规则拉丁语数据集和多语言数据集。表3描述了这些数据集的全景,图5-8显示了代表性样本。

4.1.1 合成数据集

大多数深度学习算法都依赖于足够的数据。然而,现有的现实数据集对于训练高度准确的场景文本识别器来说相对较小,因为它们只包含数千个数据样本。此外,手动收集和注释大量的现实世界的数据将涉及巨大的努力和资源。因此,合成和人工数据生成一直是一个热门的研究课题。

表3 基准数据集的比较。 “50”、“1k”和“full”是词典大小。

- Synth90k. Synth90k 数据集 包含来自一组 90k 个常用英语单词的 900 万个合成文本实例图像。 文字通过随机变换和效果(例如随机字体、颜色、模糊和噪声)渲染到自然图像上。 Synth90k 数据集可以模拟场景文本图像的分布,并且可以代替真实世界的数据来训练需要大量数据的深度学习算法。 此外,每张图像都用一个真实的词来注释。

- SynthText. SynthText 数据集 包含 800, 000 张图像和 600 万个合成文本实例。 在 Synth90k 数据集的生成中,文本样本使用随机选择的字体渲染,并根据局部表面方向进行转换。 此外,每个图像都用一个真实的词进行注释。

- Verisimilar Synthesis. Verisimilar Synthesis 数据集 包含 500 万个合成文本实例图像。 给定背景图像和源文本,首先确定语义图和显著性图,然后将它们组合起来以识别文本嵌入的语义合理和恰当的位置。 根据背景图像中嵌入位置周围的颜色、亮度和上下文结构,进一步自适应地确定源文本的颜色、亮度和方向。

- UnrealText. UnrealText 数据集 包含 600K 合成图像和 1200 万个裁剪文本实例。 它是基于 Unreal Engine 4 和 UnrealCV 插件开发的 。 文本实例被视为平面多边形网格,文本前景加载为纹理。 这些网格被放置在 3D 世界中的合适位置,并与整个场景一起渲染。 与 SynthText 一样使用来自 Google Fonts4 的相同字体集和相同的文本语料库,即 Newsgroup20。

4.1.2 真实数据集

当前大多数现实数据集仅包含数千个文本实例图像。 因此,对于 STR,现实数据集通常用于评估现实条件下的识别算法。 随后,我们将列出并简要描述现有的现实数据集:常规拉丁数据集、不规则拉丁数据集和多语言数据集。

图5 来自 Synth90k、SynthText、Verisimilar Synthesis 和 UnrealText 数据集的文本合成示例图像。

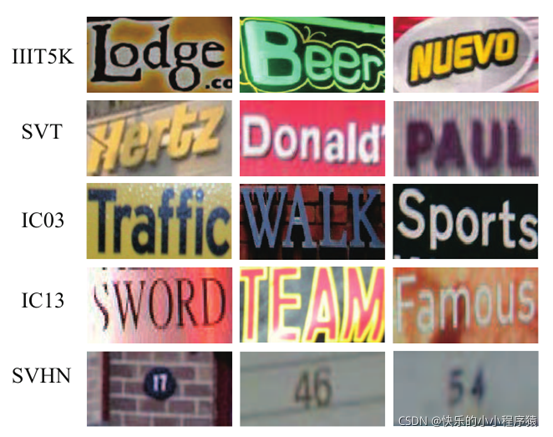

常规拉丁数据集

对于常规拉丁数据集,大多数文本实例是正面和水平的,而其中一小部分是扭曲的。

- IIIT5K-Words (IIIT5K). IIIT5K 数据集 包含 5, 000 个文本实例图像:2, 000 用于训练,3, 000 用于测试。 它包含来自街景和原始数字图像的文字。 每个图像都与一个 50 字的词典和一个 1, 000 字的词典相关联。 具体来说,词典由一个真实的词和一些随机挑选的词组成。

- Street View Text (SVT). SVT 数据集 、 包含 350 张图像:100 张用于训练,250 张用于测试。 一些图像因噪声、模糊和低分辨率而严重损坏。 每个图像都与一个 50 字的词典相关联。

- ICDAR 2003 (IC03). IC03 数据集 包含 509 张图像:258 张用于训练,251 张用于测试。 具体来说,它在丢弃包含非字母数字字符或少于三个字符的图像后包含 867 个裁剪文本实例。 每个图像都与一个 50 字的词典和一个完整的词词典相关联。 此外,完整词典结合了所有词典词。

图6 来自 IIIT5K、SVT、IC03、IC11、IC13 和 SVHN 数据集的常规拉丁文本的真实样本图像

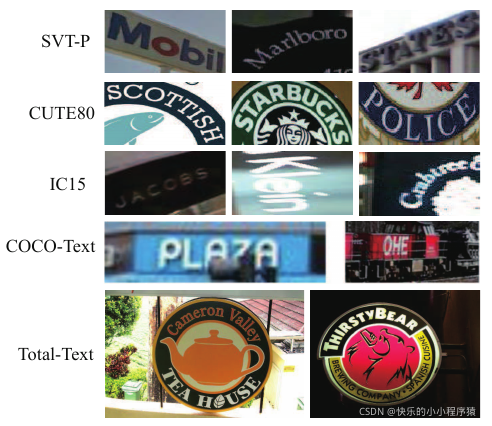

图7 来自 SVT-P、CUTE80、IC15、COCO-Text 和 Total-Text 数据集的不规则拉丁文本的真实样本图像。

- ICDAR 2011 (IC11). IC11 数据集 包含 485 张图像。 这是用于ICDAR 2003文本定位比赛的数据集的扩展。

- ICDAR 2013 (IC13). IC13 数据集 包含 561 张图像:420 张用于训练,141 张用于测试。 它从 IC03 数据集继承数据并使用新图像对其进行扩展。 与 IC03 数据集类似,IC13 数据集包含 1, 015 张在去除非字母数字字符后的裁剪文本实例图像。 没有词典与 IC13 相关联。 值得注意的是,IC03 训练数据集和 IC13 测试数据集之间存在 215 个重复的文本实例图像 。 因此,在基于 IC13 测试数据评估模型时,应注意重叠数据。

- Street View House Number (SVHN). SVHN 数据集 包含超过 600, 000 位自然场景中的门牌号码。 它是使用自动算法和 Amazon Mechanical Turk (AMT) 框架的组合从大量街景图像中获得的。 SVHN 数据集通常用于场景数字识别。

不规则拉丁数据集

对于不规则的基准数据集,大多数文本实例是低分辨率、透视扭曲或弯曲的。 不规则文本的各种字体和扭曲图案给 STR 带来了额外的挑战。

- StreetViewText-Perspective (SVT-P). SVT-P 数据集 包含 238 个图像和 639 个裁剪文本实例。 它专门用于评估透视扭曲文本识别。 它是基于原始 SVT 数据集通过在 Google 街景中选择相同地址但具有不同视角的图像构建的。 因此,大多数文本实例被非正面视角严重扭曲。 此外,每张图像都与一个 50 个词的词典和一个全词词典相关联。

- CUTE80 (CUTE). CUTE 数据集 包含 80 个高分辨率图像和 288 个裁剪文本实例。 它专注于弯曲文本识别。 CUTE 中的大多数图像具有复杂的背景、透视失真和较差的分辨率。 没有词典与 CUTE 相关联。

- ICDAR 2015 (IC15). IC15 数据集 包含 1, 500 张图像:1, 000 张用于训练,500 张用于测试。 具体来说,它包含 2, 077 个裁剪文本实例,其中包括 200 多个不规则文本样本。 由于文字图片是谷歌眼镜拍摄的,没有保证图片质量,所以大部分文字都很小,模糊,多方位。 没有提供词典。

- COCO-Text. COCO-Text 数据集 包含 63, 686 张图像和 145, 859 个裁剪文本实例。 它是第一个用于自然图像中文本的大规模数据集,也是第一个使用易读性和文本类型等属性注释场景文本的数据集。 但是,没有词典与 COCO-Text 相关联。

- Total-Text. Total-Text 包含 1, 555 张图像和 11, 459 张裁剪的文本实例图像。 它专注于弯曲场景文本识别。 Total-Text 中的图像具有三种以上不同的方向,包括水平、多方向和弯曲。 没有词典与 Total-Text 相关联。

多语言数据集

多语言文本可以在现代城市中找到,多种文化的代表在这里生活和交流。双语数据集是最简单的形式。随后,下面介绍一些双语或多语场景文本数据集。本文介绍的双语数据集主要由拉丁文和中文组成。选择中文作为双语场景文本数据集的第二语言的原因有三个。首先,汉语是世界上使用最广泛的语言之一。其次,虽然存在很多 STR 算法,但大多数都侧重于拉丁字符。中文场景文本的识别问题没有得到很好的解决。第三,中文文本与拉丁文本相比具有独特的特点: i) 中文是一个大类文本,字符集比拉丁文本大得多。 ii) 由于字符集较大,汉字的类别不平衡问题更加明显。 iii) 汉语中存在许多结构相似、易混淆的汉字,难以区分。因此,在野外阅读中文是一个重要且具有挑战性的问题。

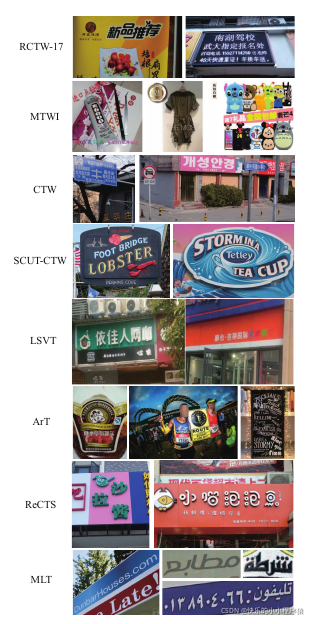

图 8. 来自 RCTW-17、MTWI、CTW、SCUT-CTW1500、LSVT、ArT、ReCTS-25k 和 MLT 数据集的多语言场景文本的真实样本图像。

- Reading Chinese Text in the Wild (RCTW-17). RCTW-17 数据集 包含 12, 514 张图像:11, 514 张用于训练,1, 000 张用于测试。 大多数是由相机或手机收集的自然图像,而另一些则是数字生成的。 文本实例使用标签、字体、语言等进行注释。

- Multi-Type Web Images (MTWI). MTWI 数据集 包含 20, 000 张图像。 这是第一个由中文和拉丁文网络文本构建的数据集。 MTWI 中的大多数图像具有相对较高的分辨率,涵盖多种类型的网络文本,包括多向文本、紧密堆叠的文本和复杂形状的文本。

- Chinese Text in the Wild (CTW). CTW 数据集 包括 32、285 个高分辨率街景图像,具有 1、018、402 个字符实例。 所有图像都有字符级注释:底层字符、边界框和其他六个属性。

- SCUT-CTW1500. SCUT-CTW1500 数据集 包含 1, 500 张图像:1, 000 张用于训练,500 张用于测试。 特别是,它提供了 10, 751 张裁剪文本实例图像,其中 3, 530 张带有弯曲文本。 这些图像是从互联网、图像库(如 Google Open-Image )或手机摄像头手动采集的。 该数据集包含大量水平和多向文本。

- Large-Scale Street View Text (LSVT). LSVT 数据集 、 包含 20, 000 个测试样本、30, 000 个完全注释的训练样本和 400, 000 个带有弱注释(即带有部分标签)的训练样本。 所有图像都是从街道上捕获的,反映了各种各样复杂的现实世界场景,例如店面和地标。

- Arbitrary-Shaped Text (ArT). ArT 数据集 包含 10, 166 张图像:5, 603 用于训练,4, 563 用于测试。 ArtT是Total-Text、SCUT-CTW1500和百度曲线场景Text6的组合,收集来介绍任意形状的文本问题。 此外,所有现有的文本形状(即水平、多向和弯曲)在 ArT 数据集中多次出现。

- Reading Chinese Text on Signboard (ReCTS-25k). ReCTS-25k 数据集 包含 25, 000 张图像:20, 000 张用于训练,5, 000 张用于测试。 所有文本行和字符都带有位置和转录的注释。 所有图片均来自美团点评,由美团商户收集,在不受控制的情况下使用手机摄像头。 具体来说,ReCTS-25k 数据集主要包含招牌上的中文文本图像。

- Multi-lingual Text (MLT-2019). MLT-2019 数据集 包含 20, 000 张图像:10, 000 张用于训练(每种语言 1, 000 张)和 10, 000 张用于测试。 该数据集包括十种语言,代表七种不同的文字:阿拉伯语、孟加拉语、中文、梵文、英语、法语、德语、意大利语、日语和韩语。 每个脚本的图像数量相等。

4.2 评估协议

在本节中,我们总结了拉丁文本和多语言文本的评估协议。

4.2.1 拉丁文本的评估协议。

识别协议

单词识别准确率 (WRA) 和单词错误率 (WER) 是两种广泛使用的拉丁文本识别评估协议。

- WRA. W RA 定义为

其中 W 是单词总数,W r 表示正确识别的单词数。

- WER. W ER 定义为

端到端协议

中定义了广泛用于拉丁语端到端系统的评估协议,其中以两种方式评估识别算法:端到端识别和单词识别。 特别是场景文本图像中的所有单词都应该在端到端识别下进行检测和识别。 在单词识别下,只应检测和识别词汇表中提供的单词。 此外,为候选转录提供了三种不同的词汇:强语境化、弱语境化和通用(分别表示为 S、W 和 G)。

- Strongly Contextualised (S). 每个图像的词汇由 100 个单词组成,包括相应图像中的所有单词以及从训练/测试集的其余部分中选择的干扰项,遵循 的设置。

- Weakly Contextualised (W). 词汇表包括训练/测试集中的所有单词。

- Generic (G). 通用词汇表包含来自 Jaderberg 等人的数据集 8 的大约 90K 个单词。

4.2.2 多语言文本的评估协议。

在本节中,我们简要介绍了近期比赛中广泛使用的多语言文本评估协议,例如 RCTW 、MTWI 、LSVT 、Art 、ReCTS 和 MLT ] 比赛。

识别协议

大多数比赛、通过传统的评估指标——归一化编辑距离(NED)来衡量算法识别性能:

其中 D (.) 代表 Levenshtein 距离。 si 和 (s_i ) ̂ 分别表示预测文本和相应的地面实况。 此外, li 和 (l_i ) ̂是它们的文本长度。 N是文本行的总数。 NED 协议测量预测文本和相应地面实况之间的不匹配。 因此,识别分数通常计算为 1-NED。

端到端协议

最近的比赛中使用了两种主要的端到端系统评估协议:

表4 识别算法在基准数据集上的性能比较。 “50”、“1k”和“Full”是词典大小。 “无”表示无词典。 ‘*’表示使用除 Synth90k 和 SynthText 之外的额外数据集的方法。 粗体代表最好的识别结果。 ‘†’表示使用额外数据集的最佳识别性能。

- 第一个协议从几个方面评估算法性能,包括基于 NED 的精度、召回率和 F-score。 根据预测和ground truth边界框之间的匹配关系,预测文本和ground truth文本的1-NED作为精度和召回分数。 F-score 是精度和召回率的调和平均值。 这是同时评估检测和识别性能的主流指标。 该协议在、、中被广泛使用。

- 第二个协议通过平均 NED 来衡量算法性能,即 AED。 特别是,计算了预测文本和相应地面实况之间的 NED。 然后,将所有的 NED 相加并除以测试图像的数量,结果称为 AED。 具体来说,较低的 AED 意味着更好的性能。 该协议评估在 中被引入,以提高长文本检测和识别的公平性,这对现实世界的系统非常有用。

表5 端到端系统算法在基准数据集上的性能比较。 “50”和“Full”是词典大小。 “无”意味着无词典。 “S”、“W”和“G”代表三种不同的词汇,即强语境化、弱语境化和通用。 ‘*’代表多尺度测试。 粗体代表最佳结果。

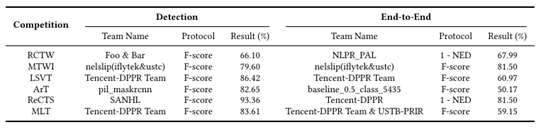

表6 比赛成绩对比。 NED 代表标准化编辑距离。

这两种类型的评估协议从不同的角度评估算法。 如表 6 所示,最近几场端到端比赛的获胜系统的表现表明,端到端识别问题仍未解决。

4.3 讨论

各种新的具有挑战性的数据集激发了促进该领域进步的新研究。 然而,由于不同数据集、先验、评估协议和测试环境的多样性,很难评估新提出的算法是否以及如何改进当前技术。 因此,未来的工作需要进行全面和公平的比较。 最近的数据集和竞赛表明,社区正在转向更具挑战性的文本识别任务(例如,从水平文本到不规则文本,从拉丁文本到多语言文本)。 除了挑战之外,高质量的注释对于一个好的数据集也很重要。 此外,新的数据集和竞赛可能会弥合学术界和工业界之间的鸿沟。

5.讨论和未来方向

文字在人类生活中扮演着重要的角色。 在自然场景中自动阅读文本具有很大的实用价值。 因此,场景文本识别已成为计算机视觉和模式识别中一个重要且充满活力的研究领域。 本文总结了与场景文本识别相关的基本问题和最先进的方法,介绍了新的见解和想法,并对公开可用的资源进行了全面回顾。 在过去的几十年里,识别方法的创新性、实用性和效率都有了实质性的进步。 然而,仍有足够的空间供未来研究:

- 泛化能力。 泛化能力是指识别算法在一系列输入和应用中有效的能力。 尽管由合成数据集训练的识别算法在几个现实的评估数据集上取得了良好的性能,但它们无法适应不同的输入,例如具有较长字符、较小尺寸和不可见字体样式的文本实例。 此外,大多数识别算法对环境干扰很敏感,难以处理现实世界的复杂性,例如 COCO-Text 数据集上报告的性能不佳。 因此,研究人员和从业者必须根据特定的输入和场景从头开始训练模型。

相比之下,人类擅长在复杂场景下识别不同风格的文本,几乎没有监督学习,这表明目前机器的理解水平与人类水平的表现之间仍然存在巨大差距。 除了简单地使用丰富多样的数据作为训练样本之外,一个可行的解决方案可能是探索文本的独特和本质表示,例如视觉级和语义级。 - 评估协议。近年来提出的许多方法声称已经突破了该技术的界限。然而,数据集、先验和测试环境的不一致使得很难公平地评估表 4 和表 5 中报告的数字。研究人员和从业者必须确认和比较新提出算法中的实验设置。例如,使用了哪些训练数据集,例如合成数据集、真实数据集或两者的混合?使用了哪些注释,例如,单词级、字符级或像素级?考虑到这一点,需要在社区中进行公平的比较。例如,未来的工作可能会报告统一训练/测试数据集的识别性能,甚至报告单个模型的识别性能,即评估同一模型在不同数据集上的性能。此外,论文中介绍的清晰详细的实验设置对于推进研究进展也很重要。

- 数据问题。 大多数深度学习算法高度依赖于足够数量的高质量数据。 现有的现实数据集仅包含数千个数据样本,对于训练准确的场景文本识别器来说相对较小。 此外,手动收集和注释大量真实世界的数据将需要付出巨大的努力和资源。 因此,有两个方面需要考虑。 一方面,合成尽可能真实有效的数据在社区中具有潜力。 与现实数据集相比,在合成过程中可以轻松获得多级注释信息(即单词级、字符级和像素级),可用于训练数据饥饿算法。 例如,一些研究人员 正在努力通过 3D 引擎合成逼真的文本实例。 另一方面,使用未标记的真实世界数据的方法在未来值得考虑。

探索如何有效地使用现有数据是很有价值的。 例如,随着许多现实数据集的出现,我们应该重新考虑统一合成数据集是否是训练模型的唯一选择,然后用现实数据集进行评估。 (这种策略在当前的大多数研究中被广泛采用。)需要进一步发展现实数据集和合成数据集之间的平衡。 此外,为文本开发有效的数据增强方法可能是一种可行且有前景的解决方案,它应该更多地关注多对象的风格。 - 场景。 该研究旨在提高人类的生活质量。 然而,对于STR,研究和应用之间的差距仍然存在。 在实际应用中,文本出现的图像质量通常较差,背景更复杂,噪声也更大,这就需要识别系统具有处理现实世界复杂性的能力。 同时,对于银行卡等简单但私密的基于视觉的场景,识别性能尤为重要。 因此,研究人员和从业人员不应局限于几个标准基准。 现实世界应用中的挑战可能会提供新的研究机会并推动未来的研究进展,例如现代城市中的多语言文本识别、私人场景中的超高精度识别以及移动设备的快速文本识别。

- 图像预处理。 为了提高算法的识别性能,越来越复杂的识别器已经成为社区的新趋势。 然而,这并不是唯一值得考虑的观点。 一些潜在的图像预处理问题值得研究人员关注,例如TextSR和背景去除,它们可以从新的角度显着降低STR的难度并提高性能。

- 端到端系统。 构建实时高效的端到端系统引起了研究人员和从业者的兴趣。 然而,与扫描文档中的 OCR 相比,端到端系统的性能仍然远远落后。 应该考虑一些困难,例如在文本检测和识别之间有效地桥接和共享信息,平衡文本检测和识别之间学习难度和收敛速度的显着差异,以及改进联合优化。 在这方面,还有很多工作要做。 此外,值得考虑端到端的解决方案是否是工业应用所必需的。

- 语言。 多种文化的代表在现代城市中生活和交流。 多语言文本识别对于人类交流和智慧城市发展至关重要。 除了构建大规模的合成/现实多语言训练数据集外,可行的解决方案可能会与脚本识别相结合。 此外,虽然存在许多识别算法,但大多数只关注拉丁文本。 对非拉丁文的识别还没有得到广泛的研究,例如中文场景文本,它是大规模的类别文本,与拉丁文本相比具有独特的特征。 现有的识别算法不能很好地推广到不同的语言。 为特定语言开发依赖于语言的识别算法可能是一个可行的解决方案。

- 安全。 由于 STR 算法可以适应许多基于私人视觉的场景(如银行卡、身份证和驾照),因此识别方法的安全性非常重要。 尽管性能很高,但大多数基于深度学习的文本识别器很容易受到对抗性示例的影响。 加强STR算法的安全性将是未来的一个潜在方向。

- NLP 是人机交流的桥梁。 同时,文本是世界上最重要的交流和感知载体。 NLP 和 STR 的结合可能是各个领域的重要趋势,例如文本 VQA 、文档理解 、信息提取。

参考文献

创作不易,喜欢的话加个关注点个赞,❤谢谢谢谢❤

518

518

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?