Deep Residual Network(DRN) 是微软亚研 何凯明组在15年10月份挂在arXiv 上的文章。所用的网络在ILSVRC&COCO 2015比赛中取得第一名的成绩(识别,分类,分割)。所用的152层网络要比VGG-16深8倍,但网络的计算复杂度(参数数量)却要比VGG少。

一. 思想

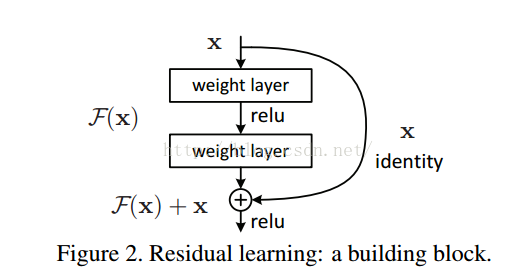

众所周知,网络的性能与深度息息相关。如果在一个浅层网络A上叠加几层layer形成网络B,如果这些新添加的layer是Identity mapping(权值矩阵全是单位矩阵?),那么网络B性能至少不会比A差。但是实际实验结果却显示网络越深,性能越差,所以作者猜测solver 对于学习单位映射比较困难。既然学习单位映射比较麻烦,那干脆直接给它加上一个shortcut,直接给这个模块输出叠加上输入。实际情况中,单位映射x并不是最优解H(x),最优解在单位映射附近,这个最优解与单位映射之间的差就叫做residual F(x)。形成下面的网络。

学习H(x)-x要比直接学习H(x)要简单多(这个有点类似于做数据处理,如网络的输入图像要减图像均值一样),所以网络训练也比较简单。

二. 与 highway network区别

1. DRN 的shortcut一直是x,没有参数,学习比较简单。而且一直传递x,每个模块只学习残差F(x), 网络稳定而且容易学习。

2. DRN证明了随着网络深度的增加,性能变好。而Highway Network 并没有证明。

注:实际运用中,DRN中的shortcut有些是带有参数的,因为有的模块有降维操作,输入输出的维度不一样。

三. 网络的训练

用bn,不用dropout。其余的参数设置以及初始化与 hinton 2012在imagenet上的训练类似。

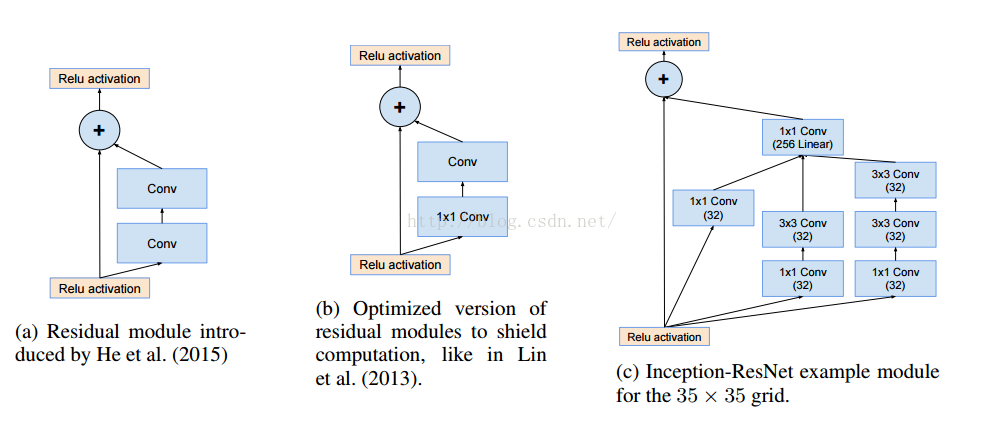

四. 与 inception v4的关系

近期搞googlenet那帮人在arxiv挂载了inceptionV4的文章,文章将DRN与googlenet结合了一下,在imagenet上的分类精读达到了3.08% top 5 error。

具体参考http://t.cn/RGXlXQS网络结构如下:

339

339

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?