Tensorflow-GPU版本安装与使用

目前在服务器上已经部署了Tensorflow-GPU-1.12版本(最新为1.14),且已经测试通过,具体的安装以及使用的步骤如下:

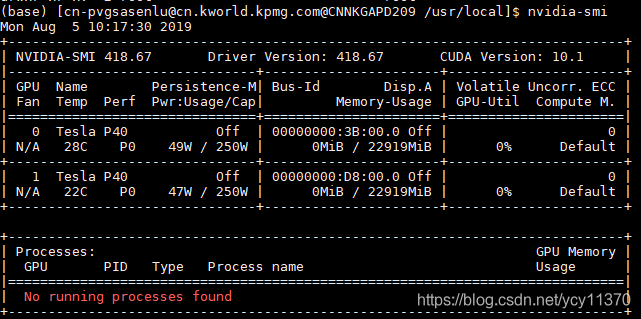

Step0: 安装服务器显卡驱动。服务器显卡有可能是没有打上的,可以通过nvidia-smi命令进行测试,如果没有显示或者显示异常,那就是驱动安装有误,需要根据显卡的型号去英伟达官网下载对应的显卡驱动,安装完成即可;以下是正常情况:

没有显卡驱动是真的坑爹!!!

以下开始才算是真正意义上的安装Tensorflow-GPU:

Step1:安装cuda; cuda从英伟达官网下载,下载过程需要根据自己的需求下载对应的版本。各个版本的cuda下载链接为:

https://developer.nvidia.com/cuda-toolkit-archive

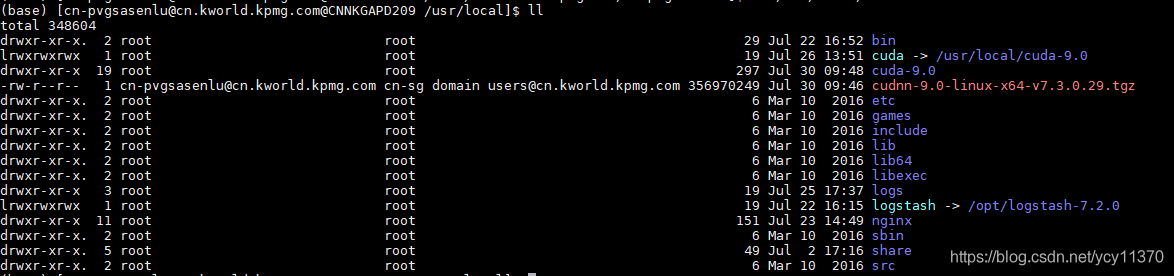

目前在服务器上,已经安装的cuda版本为9.0,安装权限为root,安装路径为/usr/local/cuda:

安装之后,需要将cuda的安装路径添加到环境变量中;由于没有root权限,无法修改/etc/profile,目前只在用户目录下修改.bashrc文件,文件末尾添加内容如下:

export PATH=/usr/local/cuda/bin${PATH:+:${PATH}}

export LD_LIBRARY_PATH=/usr/local/cuda/lib64${LD_LIBRARY_PATH:+:${LD_LIBRARY_PATH}}

export CUDA_HOME=/usr/local/cuda

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/usr/local/cuda/extras/CUPTI/lib64

需要根据自己的安装路径修改对应的内容;

Step2:安装 cudnn;从英伟达官网下载,下载过程需要根据自己所安装的cuda版本进行对应,切记要对应!各个版本的cudnn的下载链接为:

https://developer.nvidia.com/rdp/form/cudnn-download-survey

下载需要英伟达账号,自行注册即可。下载后可以将之移动到与cuda相同目录下,如上图所示。执行tar –zxvf cudnn-xxx.tgz 命令解压缩即可。解压缩之后,cudnn中所带的内容会自动加载到cuda的lib库中。只要版本对应上就好,这边不会出问题。

Step3:此时开始安装GPU版本Tensorflow;当前我们的所有环境版本如下:cuda9.0+cudnn9.0+Tensorflow-GPU1.12

在windows环境下,从pypi(https://pypi.org/project)上根据系统环境下载所需版本的Tensorflow-GPU,然后上传到服务器上。执行pip install tensorflow-gpu-xxx-xxx-whl 命令就可以完成安装;安装过程可能会出现各种依赖库的缺失,再去pypi下下载对应的依赖即可,安装完所有依赖即可。

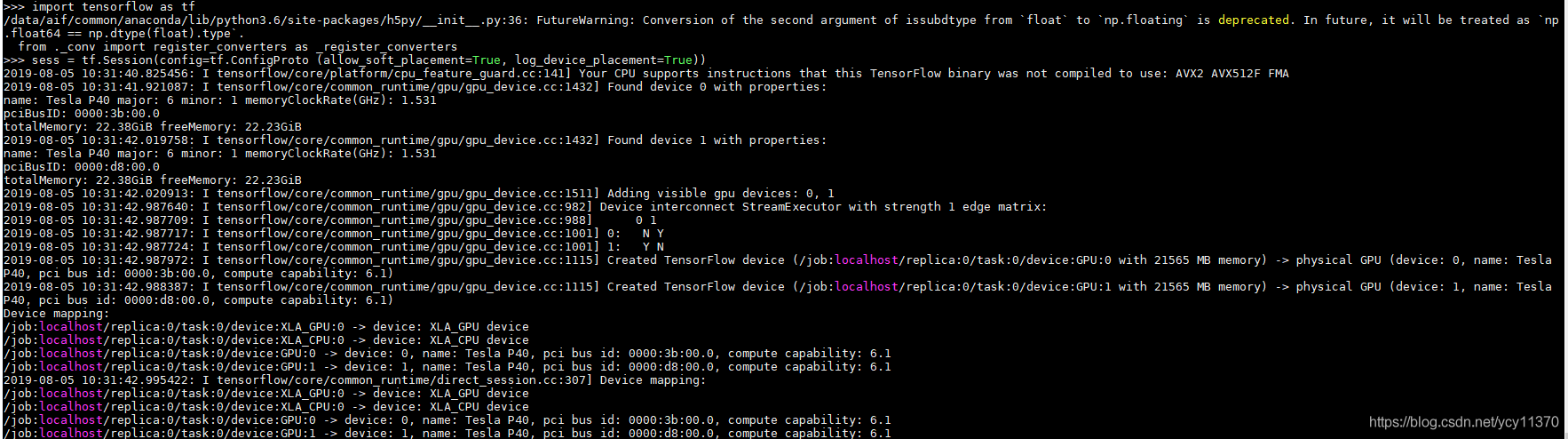

Step4:测试Tensorflow-GPU安装成功。python执行如下,显示正常就安装成功:

>>import tensorflow as tf

>>sess = tf.Session(config=tf.ConfigProto (allow_soft_placement=True, log_device_placement=True))

上图就能够看出显卡的可用情况等,一切正常。

7825

7825

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?