今年6月份时,为了测评主流LLM本地部署框架的性能,试用过LMDeploy。

在4090上,InternelLM:7b配合turbermind模式,推理速度飞起,回答秒出。远超ollama(内部实llama.cpp), 以及llama.cpp,vllm的速度,给我留下非常深刻的印象。唯一的缺点是占用显存较多,7b参数模型占据了20G显存,其他同规模的7b量化模型也就是占据6G左右。

本次参加书生·浦语大模型的第三期训练营,也是因为这个缘故很希望有更深入的理解。

-

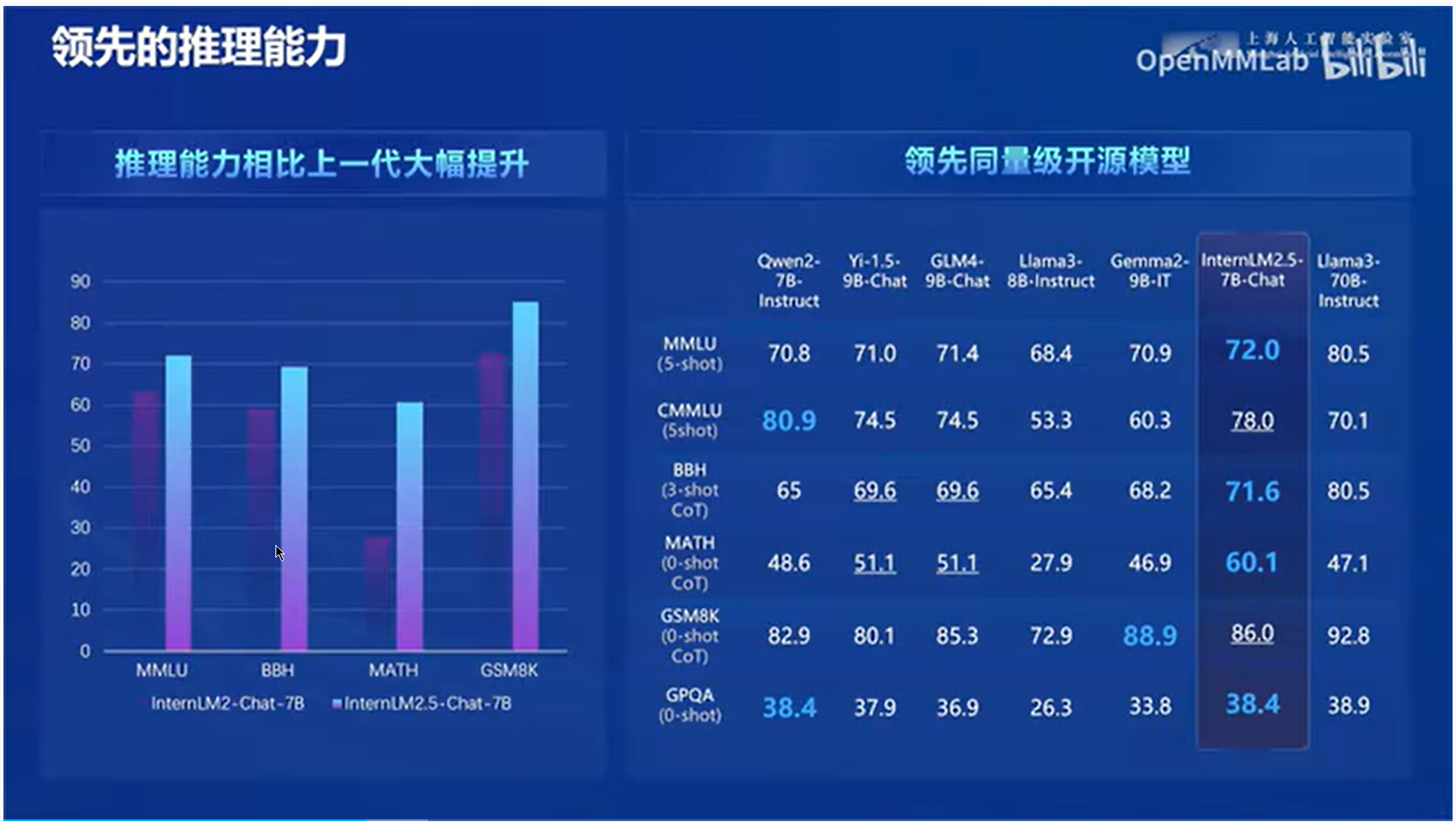

可以看到书生·浦语大模型的发展非常迅速,也符合现在开源LLM的高频迭代的风格。

-

7B和20B是小型企业的应用主力

-

2.5开始,100万token的支持非常重要

我自己实际运用的经验,感觉RAG的效果一般,因为环节越多,瓶颈也越多。效果应该不如长上下文,所以100Wtoken的支持非常有价值,当然token多了,推理性能也会下降和成本提高,这需要我们平衡的进行选择。

-

通过lable-llm可以很方便的标注数据。这对模型微调很有帮助。

-

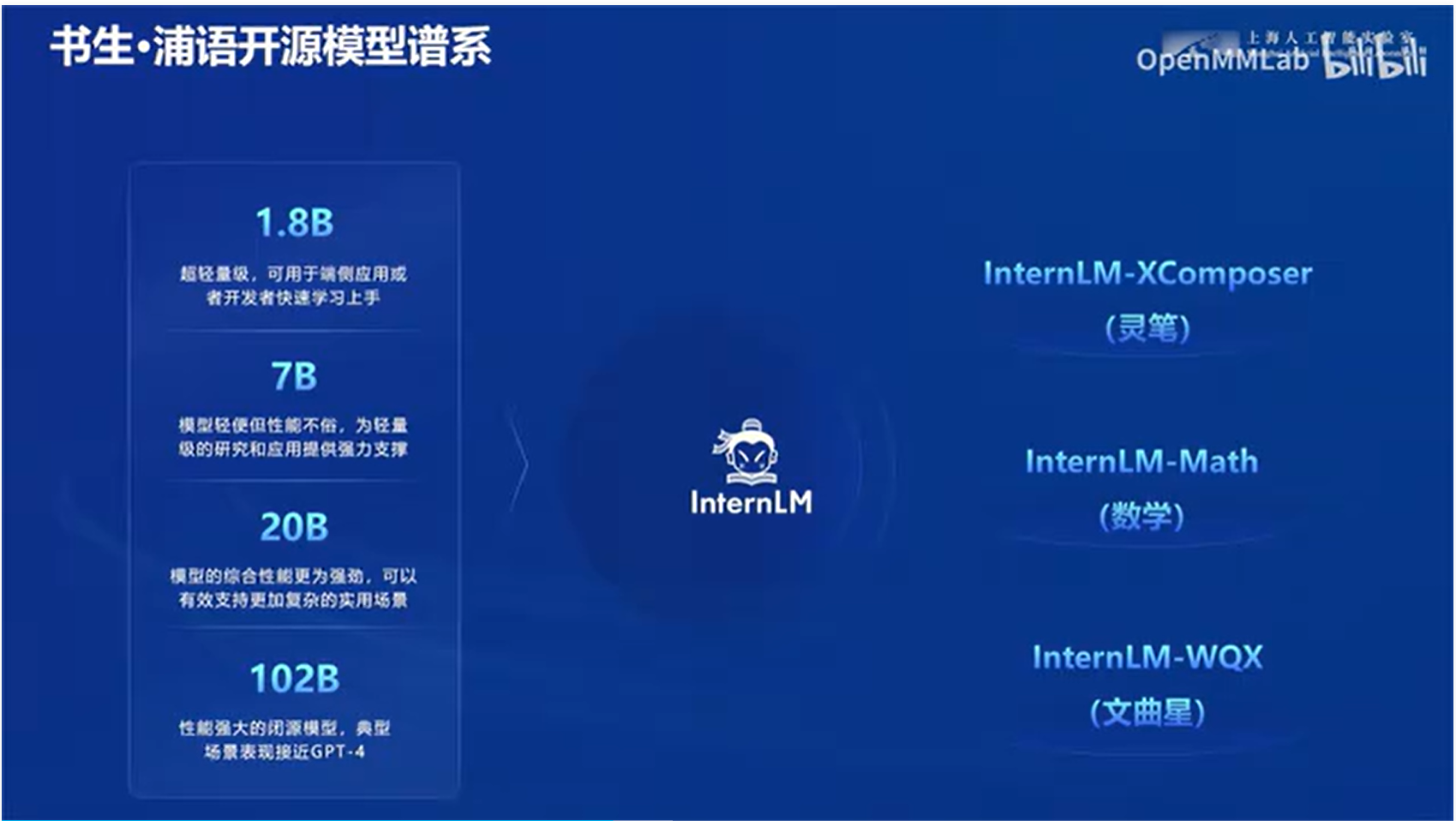

谱系众多,根据需求可以自由选择

- 8B各种用端侧

- 7B轻量级应用

- 20B复杂的实用场景(真正会有涌现现象)

- 102B(尚未开源)

- DComposer多模态模型

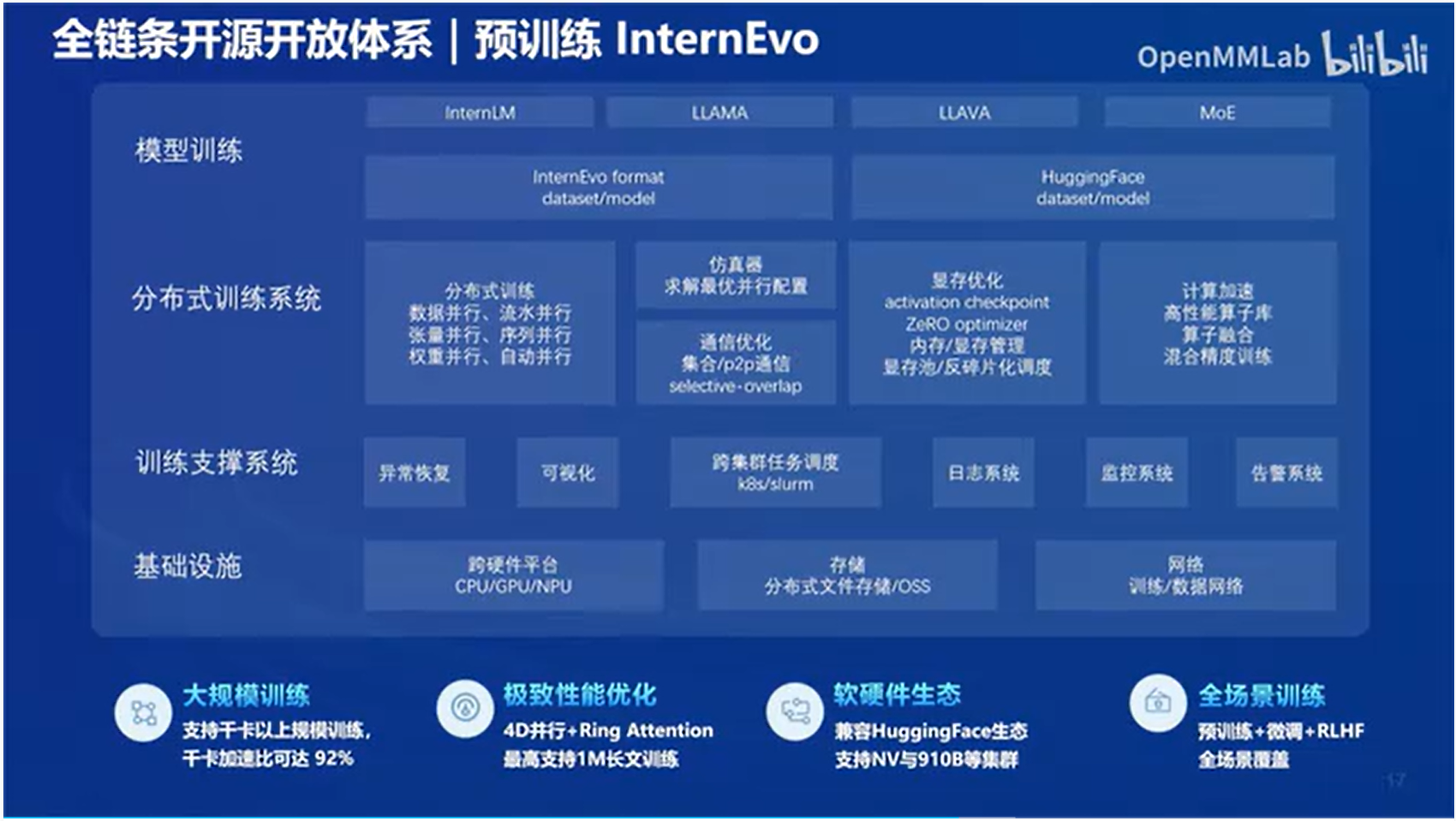

6. 全链条工具开源

这一点InternML做的非常好,打通了数据、训练、微调、部署、应用(RAG/Agent)的全链条。提供了全栈工具链。

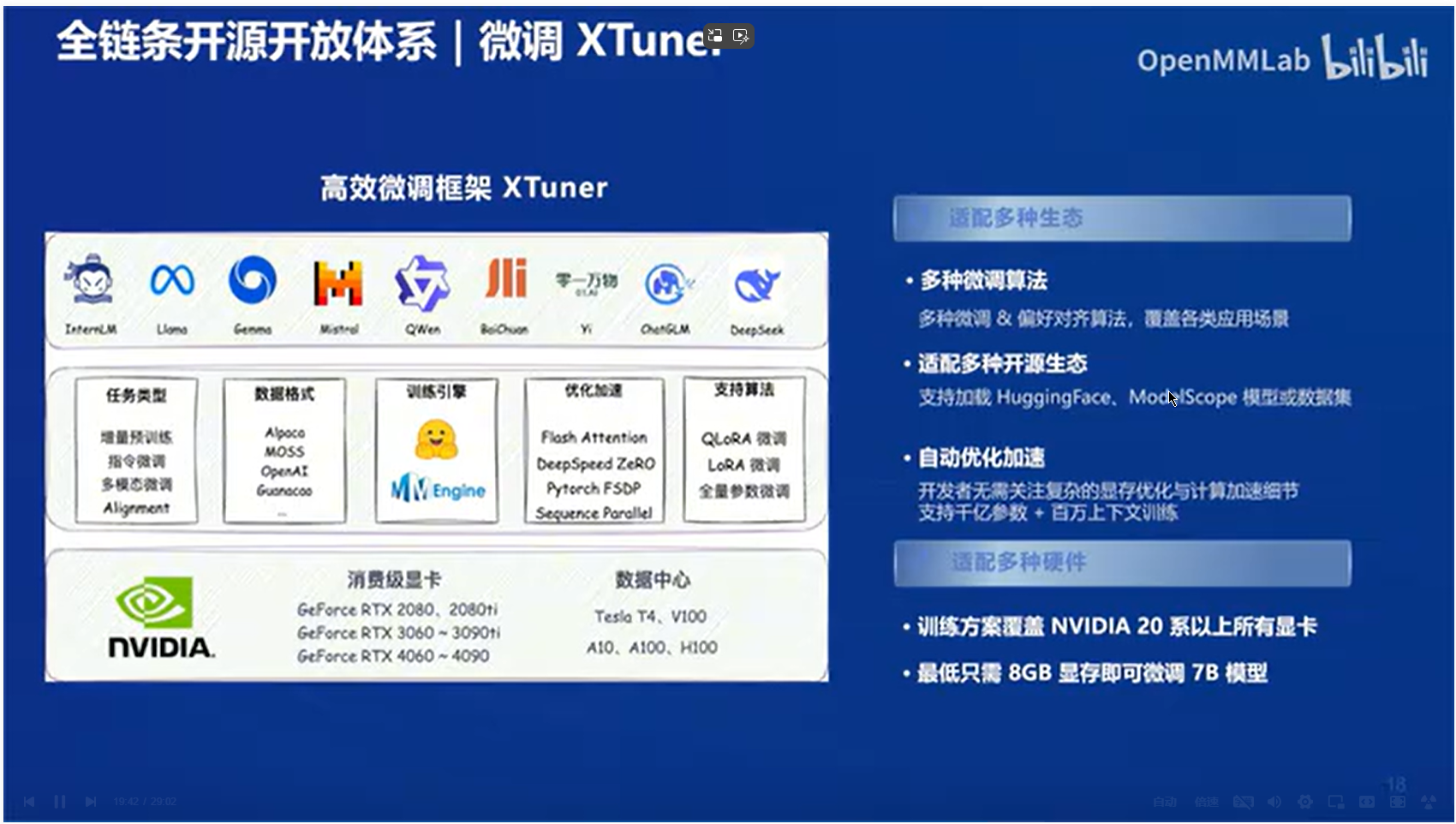

- XTunner:微调工具

- LMDeploy:部署工具,性能超过了vllm框架

- OpenCompass:评测工具

- 茴香豆:RAG方案

- MinerU:文档解析方案,集成了OCR

- Lagent:Agent智能体应用

- 数据集工具

LabelLLM和LabelU没有用过,可以考虑试用,减轻工作量。

-

训练工具:显存优化、通信优化,降低硬件要求,降低成本

-

微调工具

最重要的工具之一。

支持各种数据集格式(内部统一),支持QLoRA和LoRA微调方案。全量参数微调也支持,但消费级硬件不现实。

-

模型评测工具

-

部署框架LMDeploy

最重要的工具之一,支持很多模型种类,超过vllm。但是目前没有像ollama这么方便。

-

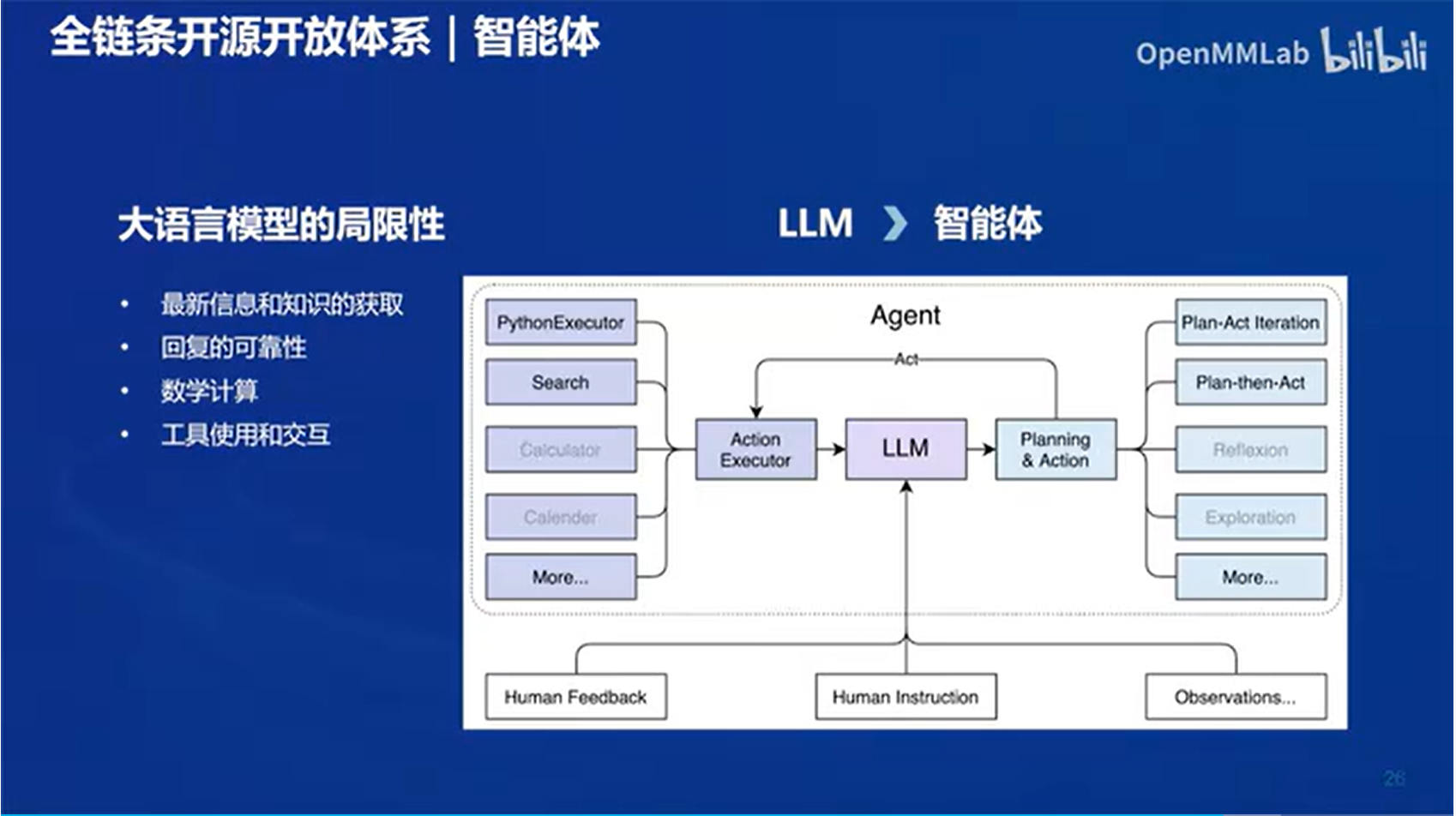

Agent智能体的应用

潜力巨大的应用方向,需要好好把握。

支持ReAct, ReWoo,AutoGPT三种主流的Agent方案

-

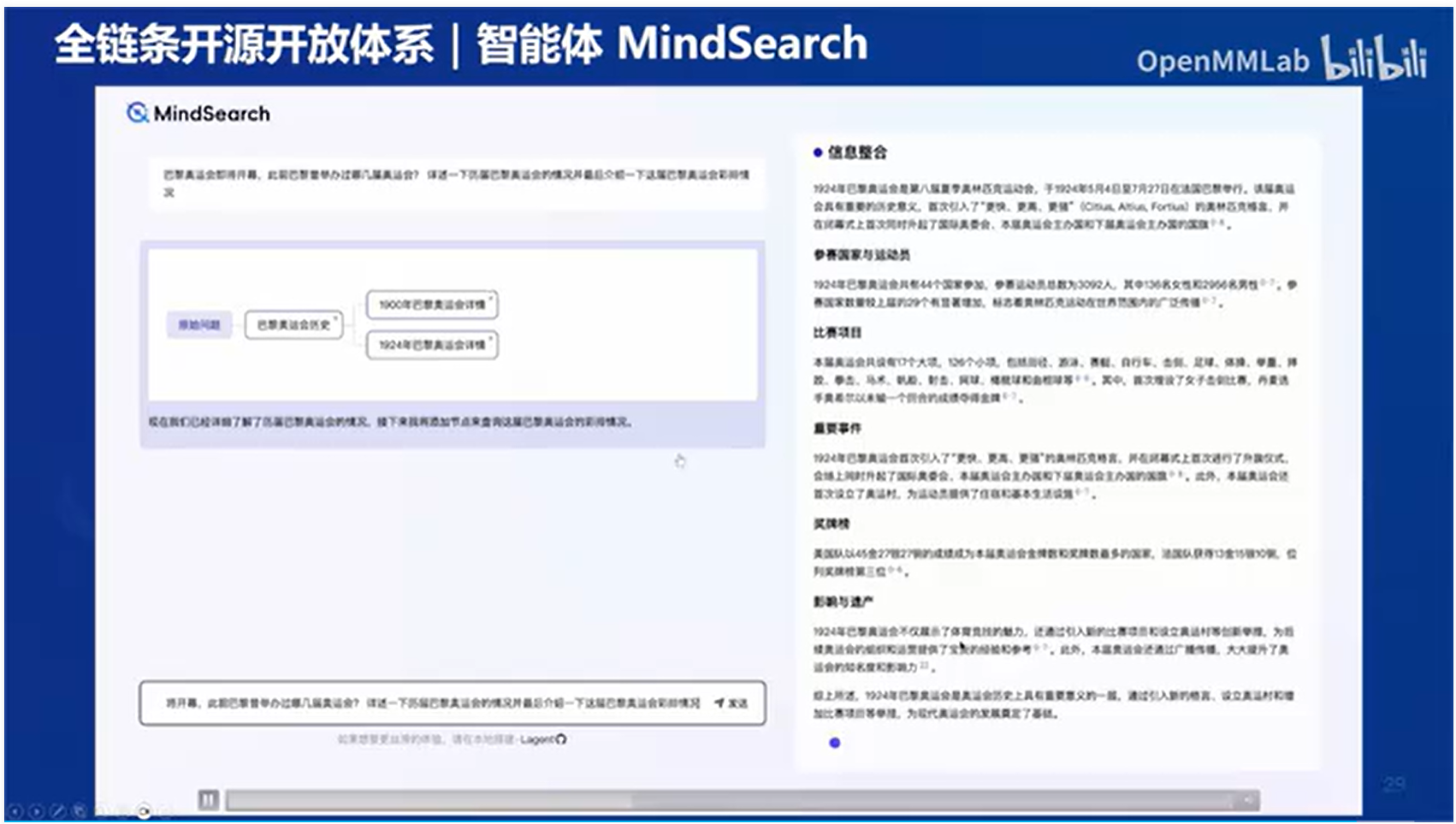

MindSearch会把agent推理过程UI化

这个挺有趣的,可视化效果应该很抓眼球,但是应该也需要LLM的一些配合

-

茴香豆RAG,可以免费商用。相当千问的QAnything。

RAG的应用框架很多,难谈优劣,一言难尽。目前最好的应该还是微软的GraphRAG,不过速度太慢,大数据量感觉不实用。

长期来看,也许会被长上下文LLM取代吧。

1344

1344

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?