概述

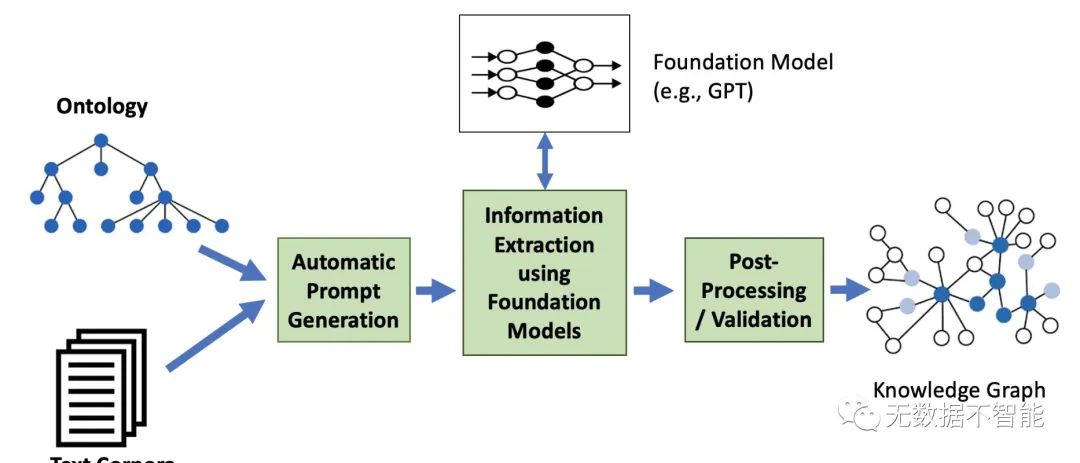

该论文的研究背景是大型语言模型(LLM)和基于本体的知识图谱(KG)在自然语言处理(NLP)任务中的性能提升。 过去的方法存在一些问题,该论文提出的方法通过从文本中生成KG并遵循给定的本体,解决了这些问题,并鼓励了新的方法。 本文提出了Text2KGBench,一个基准测试,用于评估语言模型根据本体从自然语言文本中生成KG的能力。该方法使用两个数据集和七个评估指标来评估抽取性能、本体合规性和LLM的"幻觉"。还提供了两个基准模型的结果。 该方法在从文本中生成KG的任务上取得了一定的性能。基准结果显示使用语义网和自然语言处理技术可以进一步改进性能,支持了论文的目标。

重要问题探讨

1. 介绍中提到大型语言模型(LLM)和基础模型的最新进展对自然语言处理(NLP)任务的性能有所改善,但是这些模型如何与知识图谱(KG)相互补充,使得LLM可以用于KG的构建或补全,而现有的KG则可以用于解释LLM输出或以神经符号方式进行事实核实?

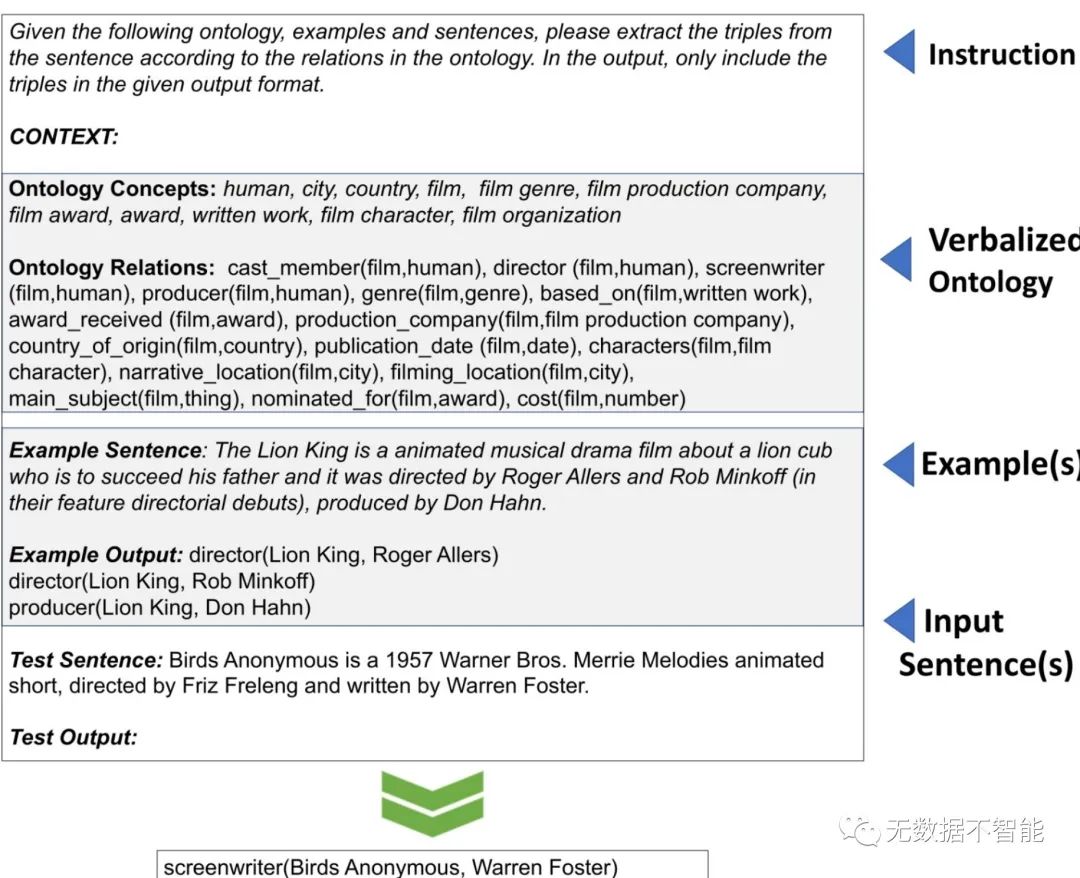

○ LLM和KG可以相互补充,LLM可以通过指导本体从自然语言文本中生成KG。LLM可以用于从文本中提取事实,并确保这些事实符合给定的本体(包括概念、关系、领域/范围约束),同时又忠实于输入的句子。通过将LLM与KG结合起来,可以提高自然语言处理任务的性能,并实现解释性输出和事实核实。

2. 文章提到了Text2KGBench这一基准测试工具,其主要目的是评估语言模型从自然语言文本中生成KG的能力。请问,Text2KGBench提供了哪些数据集和评估指标用于测试和评估语言模型的表现?

○ Text2KGBench提供了两个数据集:Wikidata-TekGen(包含10个本体和13,474个句子)和DBpedia-WebNLG(包含19个本体和4,860个句子)。为了评估语言模型的表现,Text2KGBench定义了七个评估指标,包括事实提取性能、本体一致性和LLM的虚构情况。

3. 在本文中,为了提供基线模型的结果,作者使用了Vicuna-13B和Alpaca-LoRA-13B进行实验。根据自动的提示生成测试用例,请问基线结果显示使用语义Web和自然语言处理技术仍然有改进的空间吗?

○ 基线结果显示,使用Vicuna-13B和Alpaca-LoRA-13B这两个基线模型进行实验后,仍然存在使用语义Web和自然语言处理技术改进的空间。这意味着目前的技术尚未完全充分利用语义Web和自然语言处理的潜力,在语言模型生成KG的任务中还有改进的余地。

4. 文章提到了知识图谱(KG)的应用范围,包括问答、推荐、语义搜索和可解释性高级分析等。请问在构建知识图谱时,当数据以非结构化的文本格式存在且无法使用众包方法进行构建时,可以采用哪些自然语言处理技术来构建知识图谱?

○ 当数据以非结构化文本形式存在且无法使用众包方法进行构建时,可以采用自然语言处理技术来构建知识图谱。这些技术包括命名实体识别(NER)、关系抽取、开放信息抽取、实体链接和关系链接等。通过将这些自然语言处理技术应用于文本数据,可以从中提取结构化的知识,并构建知识图谱。

5. 在Semantic Web社区中,对使用自然语言处理(NLP)技术构建知识图谱的方法越来越感兴趣。请问目前在这方面有哪些工作已经进行或研究?如有,请举例说明。

○ 目前,Semantic Web社区对使用自然语言处理技术构建知识图谱的方法已经进行了一些工作和研究。例如,已经有一些学术研讨会涉及到这个领域,比如Text2KG和NLP4KGC。这些研讨会旨在促进语义Web和NLP相结合的研究,并探索使用NLP技术从文本中构建知识图谱的方法和技术。这些工作和研究表明Semantic Web社区对于利用NLP方法构建知识图谱的兴趣不断增长。

论文链接:https://arxiv.org/abs/2308.02357.pdf

论文探讨了大型语言模型与知识图谱在NLP任务中的互补性,提出Text2KGBench评估工具,评估从文本生成KG的能力。基线模型显示仍有改进空间,强调了自然语言处理技术在构建知识图谱中的潜力。

论文探讨了大型语言模型与知识图谱在NLP任务中的互补性,提出Text2KGBench评估工具,评估从文本生成KG的能力。基线模型显示仍有改进空间,强调了自然语言处理技术在构建知识图谱中的潜力。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?