目录

概述

Apache Spark 是专为大规模数据处理而设计的快速通用的计算引擎。由于Apache Spark的认证机制存在缺陷,导致共享密钥认证失效。攻击者利用该漏洞,可在未授权的情况下,远程发送精心构造的过程调用指令,启动Spark集群上的应用程序资源,获得目标服务器的权限,实现远程代码执行。

影响版本

Apache Spark <= 2.4.5

全版本,但利用需要目标 开放REST API 6066 端口 或者 开放submissions网关 7077 端口。

漏洞复现

1、环境搭建

漏洞环境:docker + vulhub

环境启动后,会自动启用三个端口:8080,8081,6066,7077

他们分别为

(1)master的管理页面:http://your-ip:8080

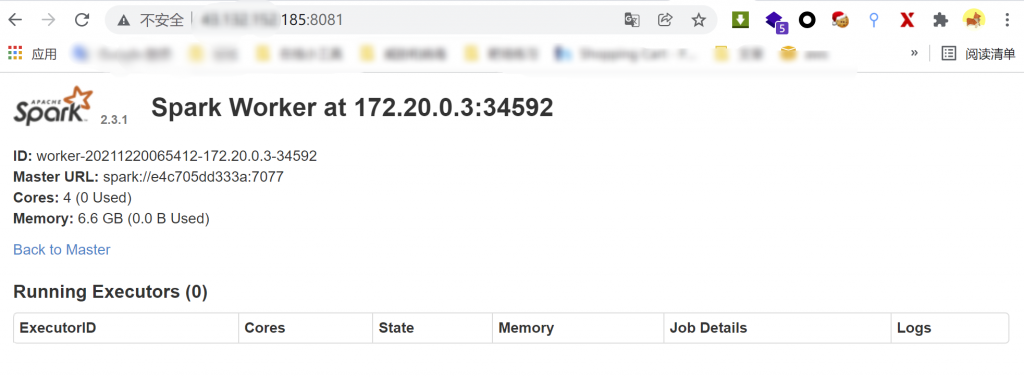

(2)slave的管理页面:http://your-ip:8081

(3)stadalone模式下,master将在6066端口启动一个http服务器

(4)7077,是在6066端口不能访问的情况下,或做了权限控制,可以利用master的主端口来提交应用。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4547

4547

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?