这里写链接内容ImageNet Classification with Deep Convolutional Neural Networks

在看caffe教程中example/ImageNet 时,看这篇文章,了解该网络结构,各个layer在网络中的设置和作用。

一、ImageNet介绍

ImageNet由15 million 有标签的高分辨率图像组成,有大约22,000个类别。

开始于2010年的ILSVRC(ImageNet Large-Scale Visual Recognition Challenge),使用ImageNet的子集,每个类大约1000张图像,共1000个类别。

本文中大约使用1.2million个训练图片,50,000个验证图片和150,000个测试图像。ILSVRC-2010是唯一一个提供测试集标签的ILSVRC。

二、网络结构

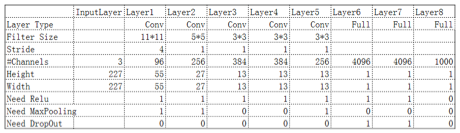

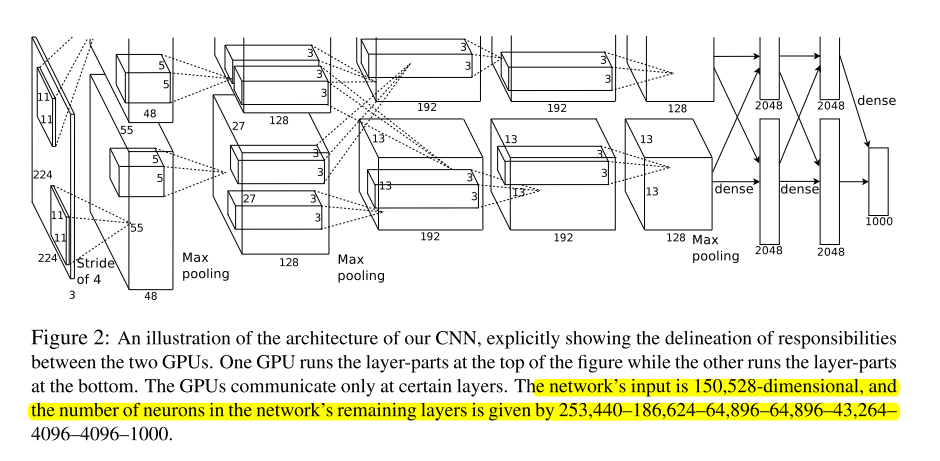

一共有8层,5个卷积层和3个全连接层,最后一层是一个1000way 的softmax。由于网络较大,用两个GPU进行训练。

从图中可看到:2,4,5层只和贮存在当前GPU中的先前层进行链接,而第3层和第2层所有的kernel map链接。

Response-normalization layers follow: 第1,2卷积层。

Max pooling layers: follow前两个response-normlization layer 和第5个卷积层。

ReLU:被应用在每一层后面

三、关键的部分

1、ReLU

rectified linear unit(ReLU) 非线性修正

f(x)=max(0,x)

使用这个函数替代传统的tanh或者sigmoid,能够加快收敛速度。

2、LRN

Local response normalization

ReLU计算后不是0的(被激活)neuron,可以开始计算LRN.

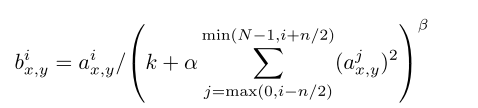

论文中给的公式:

这就是caffe教程中的Across-Chanels(default)的方式。另外还有,within-chanel方式(一个channel中以该点为中心的n*n的区域,进行上述类似的规范化计算)。

达到类似Lateral inhibition(侧抑制)的作用。

侧抑制:指的是某神经元的活动引起另一个神经元的兴奋性下降。侧抑制具有生物意义,因此它增加了物体边沿的对比度,从而使机体容易区分一个物体和另一个物体的边沿。

能够降低识别错误率

3、Overlapping pooling

传统的pooling是不重叠的,这里是在彼此有重叠的块中进行pooling。

作用:能有效降低识别错误率,而且不易产生拟合。

四、减少拟合的方法

1、数据增广

(1)平移和水平翻转

从256*256的image中随机抽取224*224的块,并对他们进行水平翻转。

水平翻转:fg=im(:,end:-1:1,:)

(2)改变rgb通道的灰度值

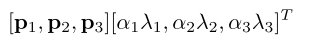

在整个ImageNet 训练集上对灰度值进行PCA

Ix,y代表三通道的像素向量,对Ix,y进行如下量化:

2、 dropout

设置每个隐藏单元设为0的概率为0.5,被dropout的点不参与向前向后计算,因此相当于是训练了多个模型。减少了神经元间的依赖。

1881

1881

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?