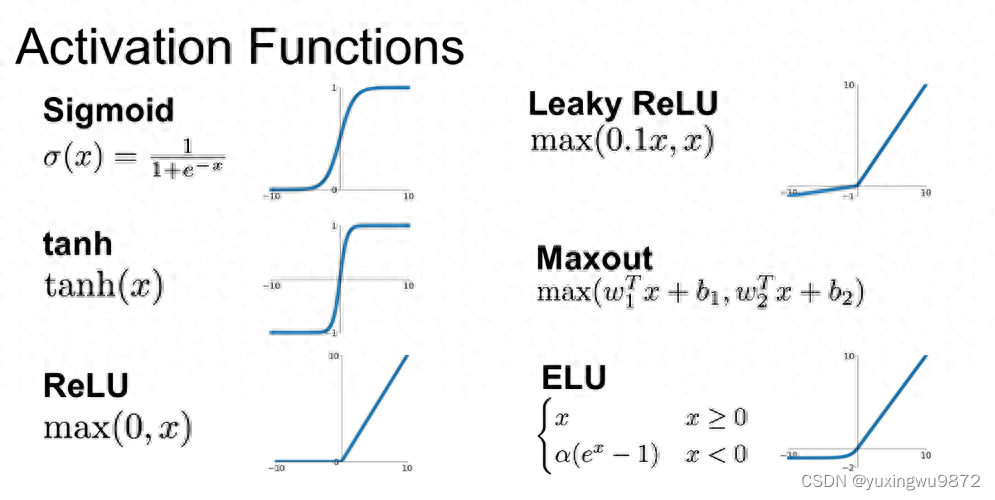

Sigmoid和Relu都是常用的激活函数,但它们的作用不同。Sigmoid函数将输入值映射到0到1之间的连续输出,适用于二分类问题。而Relu函数则将输入值映射到大于0的输出,适用于多分类和回归问题。

Sigmoid和Relu的区别和差异主要有以下几个方面:

- Sigmoid函数是双侧饱和的,即朝着正负两个方向函数值都会饱和;但Relu函数是单侧饱和的,即只有朝着负方向,函数值才会饱和。

- Sigmoid函数在输入值过大或过小时,会出现饱和现象,导致输出值接近于0或1,从而使得导数值接近于0。这样,在反向传播时,就会造成梯度消失的问题,影响网络的训练效果。而Relu函数在正区间保持恒定的导数值(通常为1),从而避免了梯度消失的问题。

- Relu函数在零点附近不可微,只能求右偏导,解决这个问题的思路就是Leaky Relu. 另外,它会“谋杀”一些神经元,使得一些神经元的导数永远为0,也就是说这个神经元不会经历训练,即所谓的稀疏性。

- Relu函数的导数计算更快,程序实现就是一个if-else语句,而Sigmoid函数要进行浮点四则运算。

- Relu函数更加接近脑神经元的激活模型,而Sigmoid函数更加接近概率模型。

综上,Sigmoid和Relu各有优缺点,选择哪种激活函数要根据具体的问题和数据来决定。一般来说,Relu更适合深层网络的隐藏层,而Sigmoid更适合二分类问题的输出层。

1000

1000

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?