1 分类 classification

1.1分类描述

前面学习的线性回归输出的预测值是连续的,但对于有些问题,比如判断一封邮件是否为垃圾邮件,肿瘤的恶性还是良性等问题,其分类的结果思离散的,对于这些问题,我们可以通过输出值y ϵ {0, 1} 来表示,其值不再连续,而是离散,故前面的线性回归模型不再适用,需要提出新的模型。

1.2 分类模型表示

根据前章节的学习思路,依旧利用假设函数y=hθ(x)来预测分类:

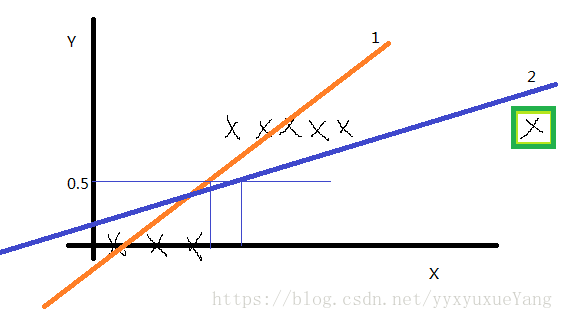

如果y的取值只有0和1,训练集画出来这这个样子(先没有绿框中的点),我们用线性回归得到1号直线,如果认为模拟直线的取值小于0.5时则预测值就为0,如果模拟直线的取值大于0.5时预测值就为1,似乎可以有效预测分类。但是将绿框中的点加入后,线性回归得到的直线2,绿色框中的点大于0.5,预测结果为1,但实际上应该为0。于是2号线就显得不是很完美了。经过大量的实验证明,线性回归不适合这种训练集。所以我们要构造特殊函数使0≤hθ(x)≤1。

于是提出一种新的回归模型:

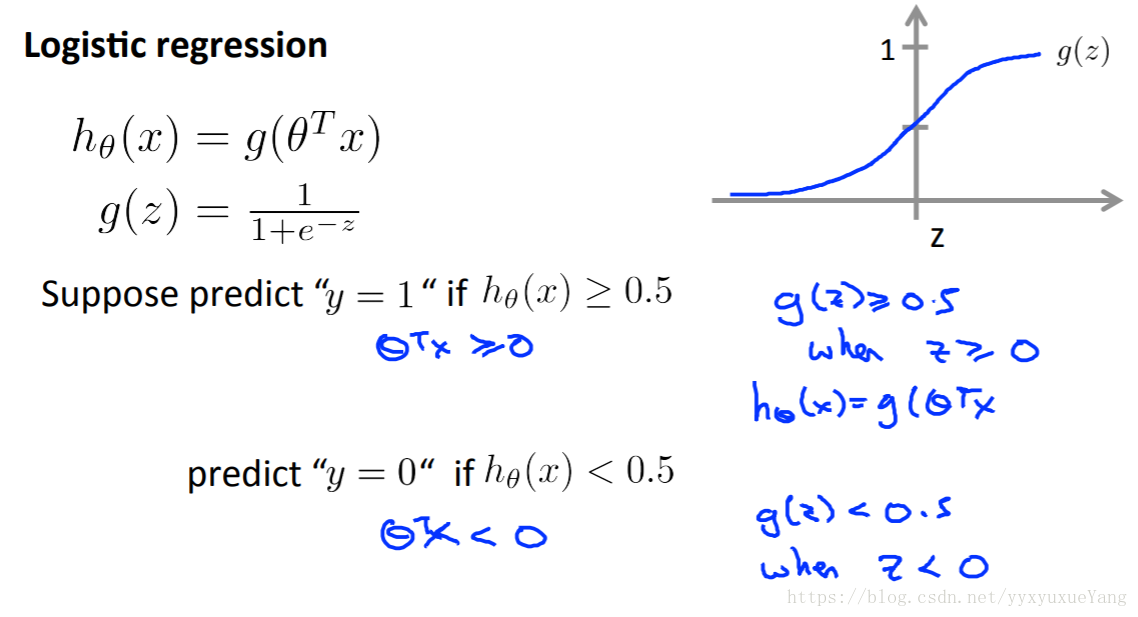

y=hθ(x)=g(θ^Tx)

模型表示和图像如下:

g(z)这个函数称之为:logistic function 或者 sigmoid function

1.3 分类边界

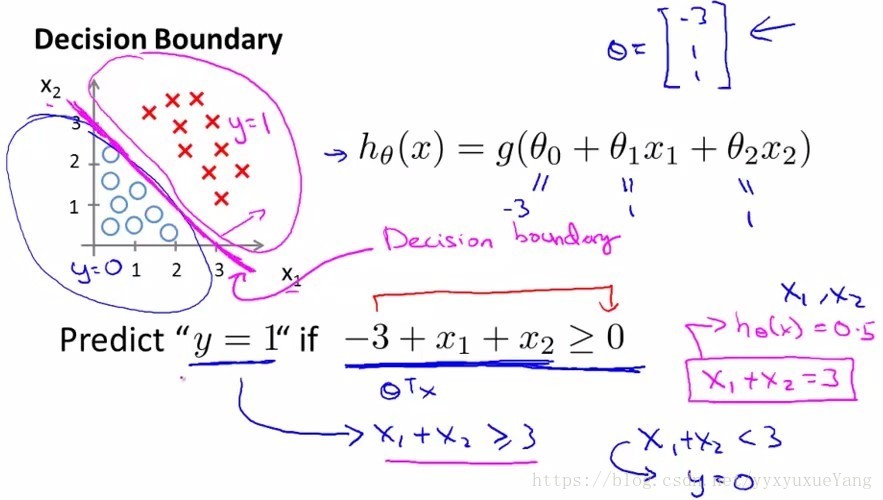

分类边界,就是能够将所有的目标点进行很好的分类的h(x)的边界。

如何确定分类边界:当y>0.5的时候,为正。由图像可知:

hθ(x)≥0.5

θTx≥0

且看以下两个分类边界的例子

1).线性判定边界:

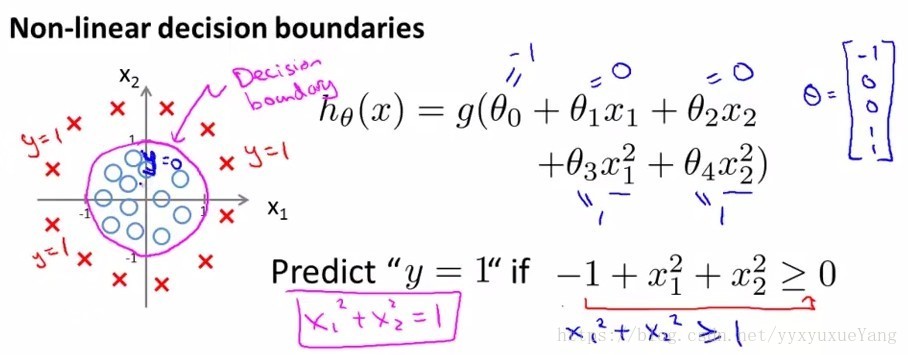

2)非线性判定边界:(除了线性判定边界,还有较复杂的非线性判定边界:下例中decision boundary就是半径为1的圆)

2 逻辑回归模型

2.1 代价函数 cost function

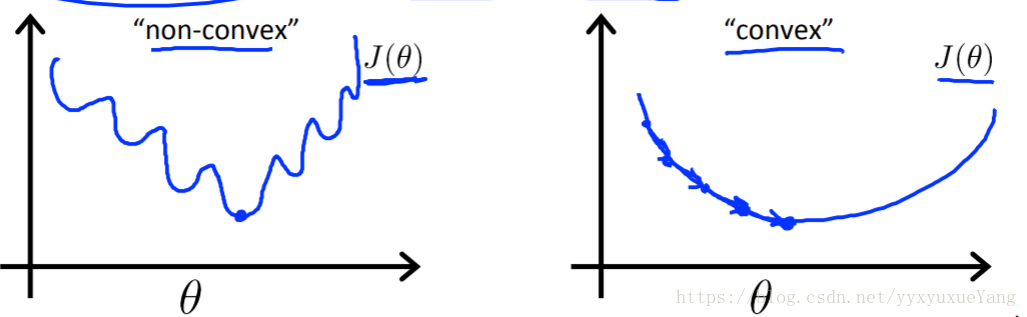

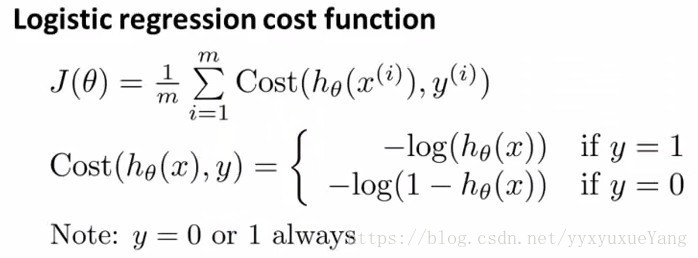

线性回归的损失函数对逻辑回归不可用,因为逻辑回归的值是0或者1,求距离平均值会是一条不断弯曲的曲线,不是理想的凸函数。如下图左一所示,图像呈现出非凸性,也就是说,如果我们运用梯度下降法,不能保证算法收敛到全局最小值。

所以用以下方法定义损失函数:

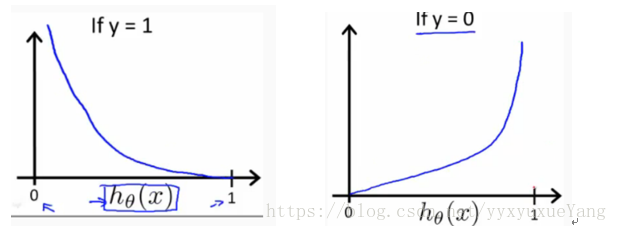

其中hθ(x)是一个概率值,y=1表示正样本,y=0表示负样本。当y是正样本时,如果给定的概率特别小(预测为负样本),损失就会很大;给定的概率很大(预测为正样本),损失就会接近0。损失值的函数如图:图像如下:

2.2 梯度下降

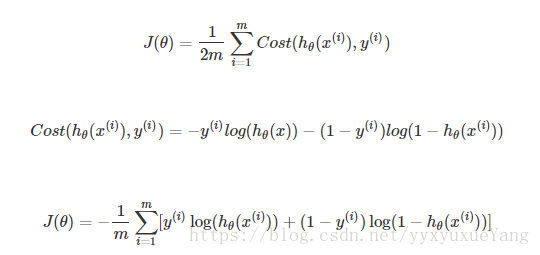

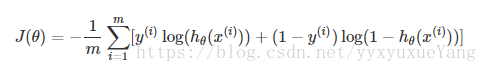

Y只会取值0者1,所以以上式子改写成:(该函数依旧可以用梯度下降法)

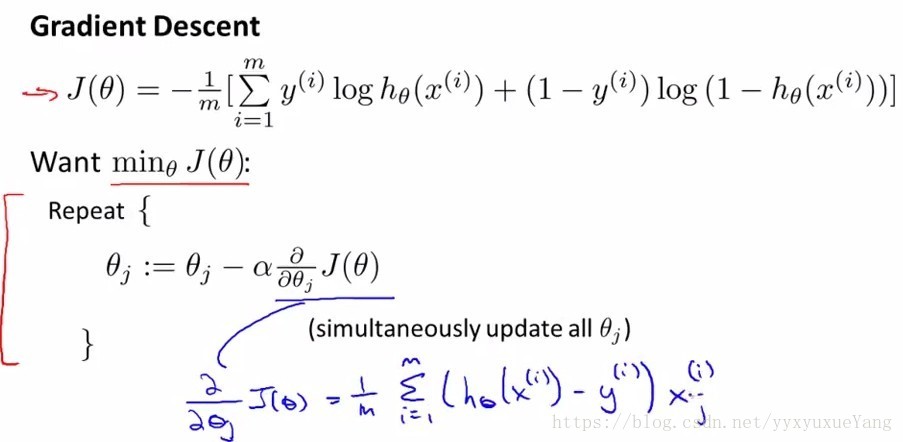

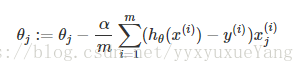

对上述式子运用梯度下降算法:

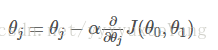

这与第一章线性回归得到的方程 是一样的,也就是说,不管是线性回归模型还是逻辑回归模型,其参数更新过程是一样的,那么在参数更新的过程中,我们同样可以用vectorization,用一个矩阵乘法同时更新参数,而不是用for循环一个个的更新。

2.3高级优化算法

不是很了解,需要继续学习。

2.4逻辑回归小结

和线性回归一样,从以下三层理解逻辑回归:

1)模型:逻辑回归模型(sigmoid function)

2)代价函数:

3)参数更新:梯度下降(与线性回归一致)

3 多分类Multi-class Clasisfication

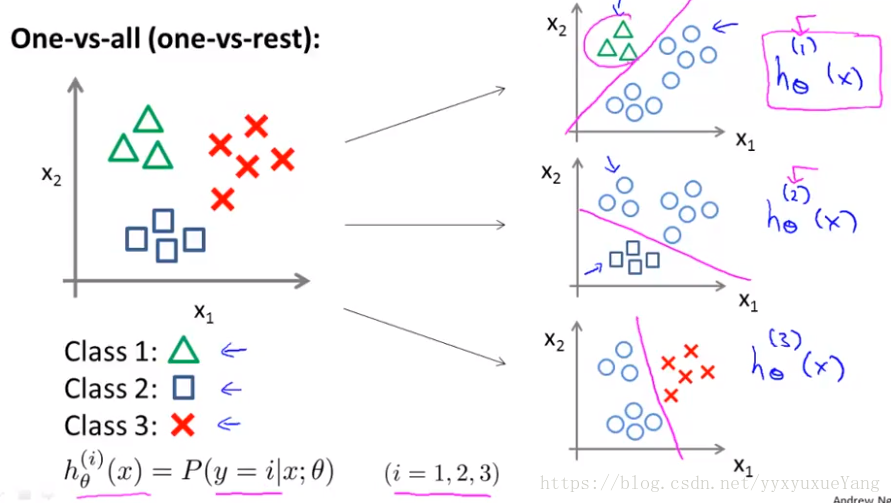

多分类解决办法:把K分类转换为K个2分类(例如下图的划分方式)

将多类分类问题转换成二元分类问题,根据特征,一层层细化类别:假设一共有k类,将其中一类作为类别1,剩下的(k-1)归为类别2,这样进行K个h(θ)的参数优化,每次得到的一个hθ(x)是指给定θ和x,它属1的类的概率。

4 过拟合 overfitting

4.1过拟合概念及样例

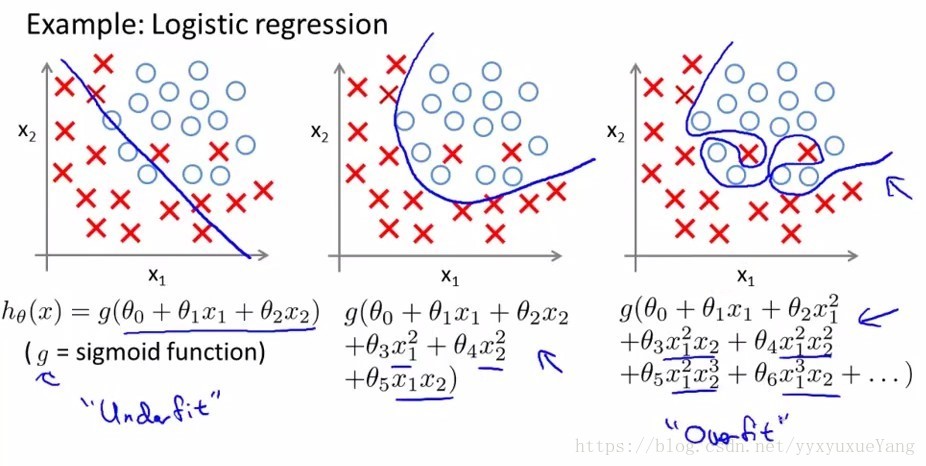

overfitting通常是由一个复杂的函数造成的,这个函数会产生大量与数据无关的不必要的曲线和角度。

4.2过拟合解决方法

有两个主要的选择来解决过度拟合的问题:

1)减少特征的数量:

- 手动选择要保留的功能。

- 使用模型选择算法。

2)正则化

- 保留所有的特征,但是减小参数θj的大小。

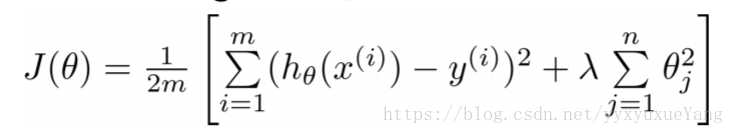

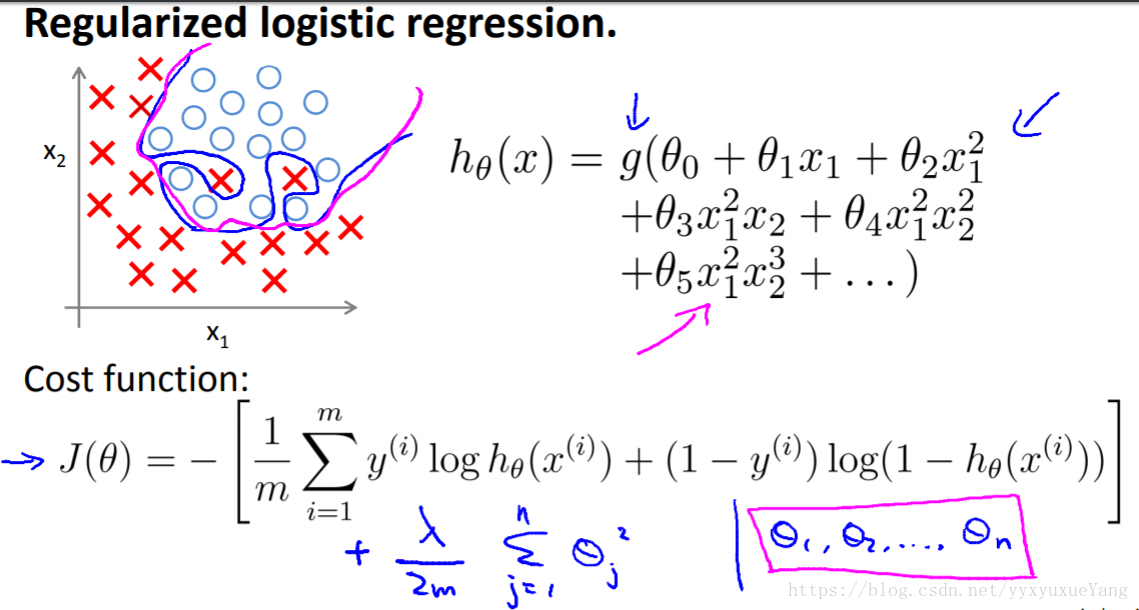

4.3 修改cost function实现正则化

在cost function中增加惩罚项:

其中λ是正则化参数 regularization parameter。它决定了我们θ参数的成本膨胀了多少。

- 如果选择的lambda太大,可能会使功能过于平滑: under fitting。

- 如果λ= 0或太小会发生泛化失败: overfitting

4.4 在线性回归中使用正则化

我们可以将正则化应用于线性回归和逻辑回归。

首先处理线性回归。 一共有两种方法,梯度下降和正规方程

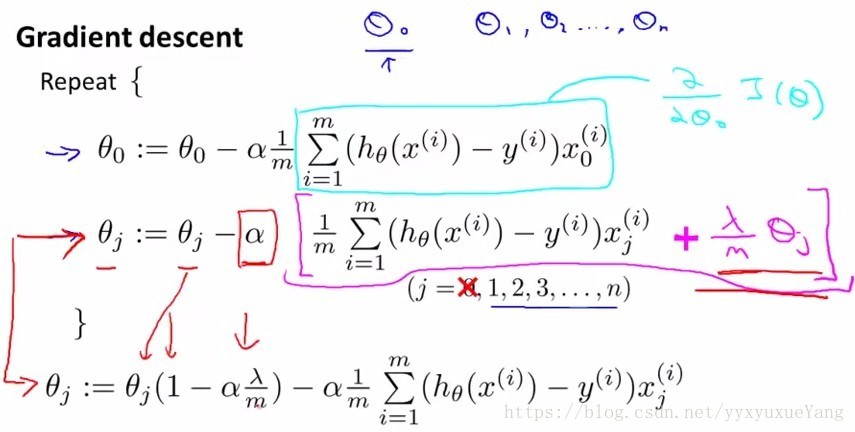

1)梯度下降

我们将修改我们的梯度下降函数,从其他参数中分离出θ0,因为我们不想惩罚θ0。

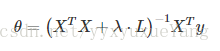

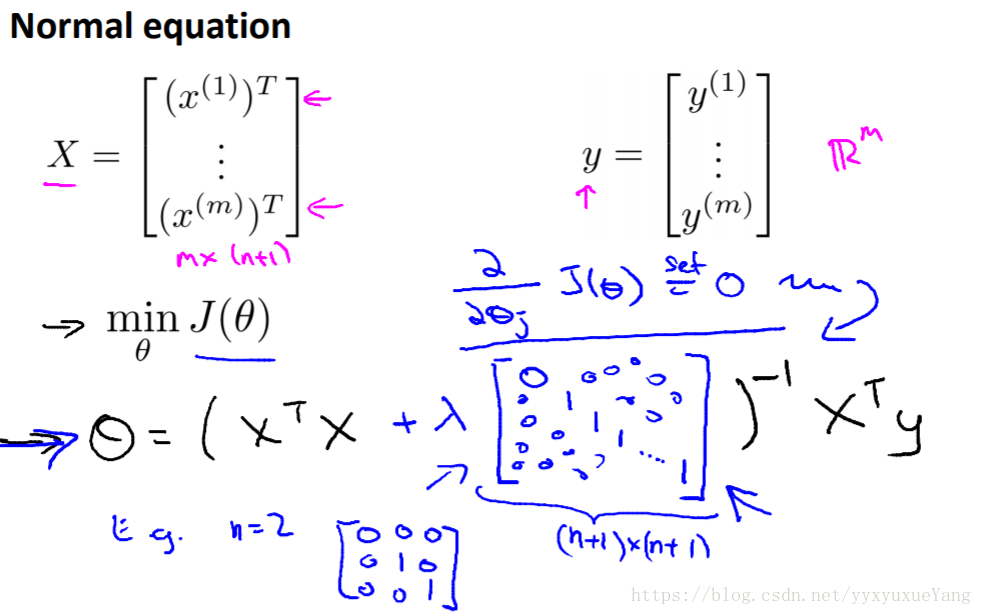

上面的等式中的第一项1-α λ/m将总是小于1.- 2)正规方程

现在让我们使用非迭代法线方程的替代方法来进行正则化。

L是一个矩阵,左上角为0,下角为1,其他地方为0。

它应该有维度(n 1)×(n 1)。

直观地说,这是单位矩阵(尽管我们不包括x0),乘以单个实数λ。

- 2)正规方程

4.5 逻辑回归中实现正则化

参考

1.https://blog.csdn.net/u012052268/article/details/78653293

2.https://www.coursera.org/learn/machine-learning/supplement/CUz2O/lecture-slides

3487

3487

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?