前言

被广大网友誉为“开源文生图模型之光”的AuraFlow详细搭建教程来啦!下面将介绍ComfyUI - AuraFlow在算家云的搭建流程以及本地部署教程,希望能帮助到大家~

一

模型介绍

AuraFlow 是唯一一个真正开源的文生图模型,由 Fal 团队开源,其代码和权重都放在了 FOSS 许可证下。

模型基于 6.8B 参数优化模型架构,采用最大更新参数化技术,在物体空间和色彩上有很大的优势,并支持在线试用和与主流平台集成。未来有望在多领域广泛应用,以开源特色和强大实力吸引更多用户和开发者。

所有的AI设计工具,安装包、模型和插件,都已经整理好了,👇获取~

二

算家云平台搭建流程

1. 创建容器镜像

进入算家云平台的“应用社区”,点击搜索或者找到"ComfyUI-AuraFlow"

点击进入之后选择模型和 3090 卡,点击创建即可创建实例

也可以点击“专业创建”自己自主选择 GPU 型号:

2.启动项目

实例创建成功之后,点击“项目实例”再点击“webShell”开启终端(小黑屏)

进入终端后复制以下命令输入到终端即可开始运行:

conda activate comfyui``cd ComfyUI``python main.py

出现下图即表示模型开始运行:

3.开启外部访问

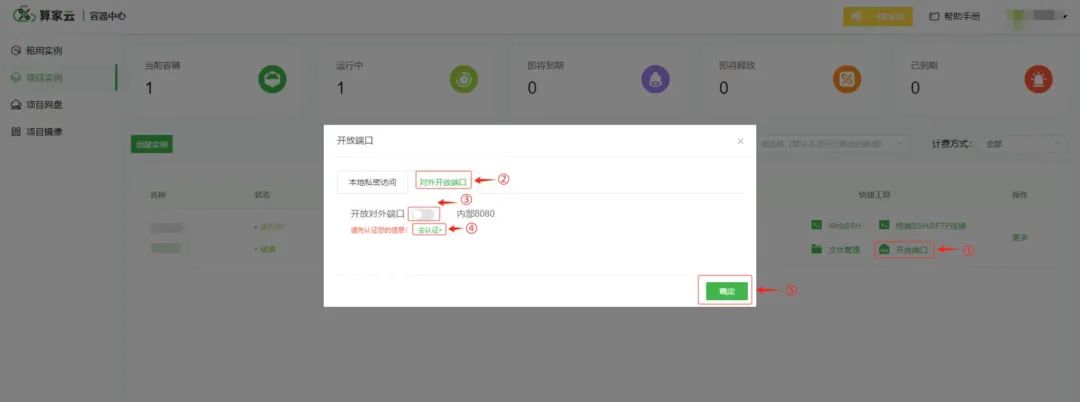

两种访问方式可以选择:本地私密访问、对外开放端口。

(1)对外开放端口

返回“项目实例”列表,选择并点击对应实例的“开放端口”按下图操作。

点击后访问的网址就已经复制到剪切板:

(2)本地私密访问

如果选择 ssh 工具访问,请查看使用文档:进入官网–> 帮助文档(帮助手册)–> 容器实例–> 开放端口。

4.访问获取的地址,开始使用

将复制的访问网址复制到新网页即可开始 ui 界面的使用

具体使用方法见"使用说明"

以上就是ComfyUI-AuraFlow在算家云的搭建流程,下面将介绍本地部署教程,有需要的可以参考。

三本地部署教程**

本文档针对ComfyUI进行部署使用,因此在正式部署之前需要部署ComfyUI。

1. 部署ComfyUI

(1)使用命令克隆ComfyUI

git clone https://github.com/comfyanonymous/ComfyUI.git``cd ComfyUI

(2)安装 conda(如已安装则跳过)

下面需要使用 Anaconda 或 Mimiconda 创建虚拟环境,可以输入 conda --version 进行检查。下面是 Mimiconda 的安装过程:

- 下载 Miniconda 安装脚本:

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

- 运行安装脚本:

bash Miniconda3-latest-Linux-x86_64.sh

- 遵循安装提示并初始化:

按 Enter 键查看许可证条款,阅读完毕后输入 yes 接受条款,安装完成后,脚本会询问是否初始化 conda 环境,输入 yes 并按 Enter 键。

-

运行 source ~/.bashrc 命令激活 conda 环境

-

再次输入 conda --version 命令来验证是否安装成功,如果出现类似 conda 4.10.3 这样的输出就成功了。

(3)创建虚拟环境

输入下面的命令:

conda create -n comfyui python=3.10conda activate comfyui

(4)安装pytorch

pip install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu121

(5)安装项目依赖

pip install -r requirements.txt

此时所需环境就已经搭建完成,通过下面命令进行启动:

python main.py

访问网址得到类似下图界面即表示成功启动:

2.部署AuraFlow

(1)下载模型

模型放置在 ComfyUI/models/chekpoints/ 文件夹下

模型主页:fal/AuraFlow-v0.3 at main (huggingface.co)

点击上面链接,访问 Hugging Face 下载模型,如下图。首次访问该页面时,可能需要同意用户协议才能看到模型下载页。

官方目前已经更新到v0.3版本:

(2)获取工作流

访问AuraFlow Examples | ComfyUI_examples (comfyanonymous.github.io)下载下面的图片(或者直接下载这张图片),然后拖入comfyui界面中即可出现工作流,因为图中已包含相关信息。

此时comfyui中会出现下面AuraFlow的工作流:

这样AuraFlow就可以在comfyui中使用了。

3. 拓展插件安装(可选)

(1)下载manager管理器

manager 是一个用来加强ComfyUI可用性的扩展,提供了对ComfyUI各种自定义节点的安装、删除、禁用、启用等管理功能。同时还提供了中心功能和便利功能,用来访问 ComfyUI 中各种信息。

cd /ComfyUI/custom_nodes``git clone https://github.com/ltdrdata/ComfyUI-Manager.git

成功安装之后重启界面会出现一个“Manager”如图:

(2)界面汉化插件

git clone https://github.com/AIGODLIKE/AIGODLIKE-ComfyUI-Translation.git

下载文件之后需要重新启动,重启模型之后:

设置一次之后可点击图中框选出的选项进行语言的切换:

(3)中文提示词插件安装

cd /ComfyUI/custom_nodes``git clone https://github.com/thisjam/comfyui-sixgod_prompt.git

然后重启ComfyUI后看到下图的小标志就表示可以了:

使用方法:双击页面,在搜索框中搜索“six”即可出现,点击sixGodPrompts,此时出现的就是提示词的中文输入框可以替代自带的clip输入框,可点击左下角的小标或按“AIT”+“q”打开和隐藏。

使用方法如下:

以上就是ComfyUI-AuraFlow在算家云搭建以及本地部署的详细教程。怎么样,有帮助到大家吗?欢迎在评论区交流提问~

关于AI绘画技术储备

学好 AI绘画 不论是就业还是做副业赚钱都不错,但要学会 AI绘画 还是要有一个学习规划。最后大家分享一份全套的 AI绘画 学习资料,给那些想学习 AI绘画 的小伙伴们一点帮助!

对于0基础小白入门:

如果你是零基础小白,想快速入门AI绘画是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以找到适合自己的学习方案

包括:stable diffusion安装包、stable diffusion0基础入门全套PDF,视频学习教程。带你从零基础系统性的学好AI绘画!

零基础AI绘画学习资源介绍

👉stable diffusion新手0基础入门PDF👈

👉AI绘画必备工具👈

温馨提示:篇幅有限,已打包文件夹,获取方式在:文末

👉AI绘画基础+速成+进阶使用教程👈

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

温馨提示:篇幅有限,已打包文件夹,获取方式在:文末

👉12000+AI关键词大合集👈

这份完整版的AI绘画全套学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

1506

1506

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?