目录

1、 无监督学习

没有目标值的,从无标签的数据开始学习的

- 聚类

- K-means(K均值聚类)

- 降维

- PCA

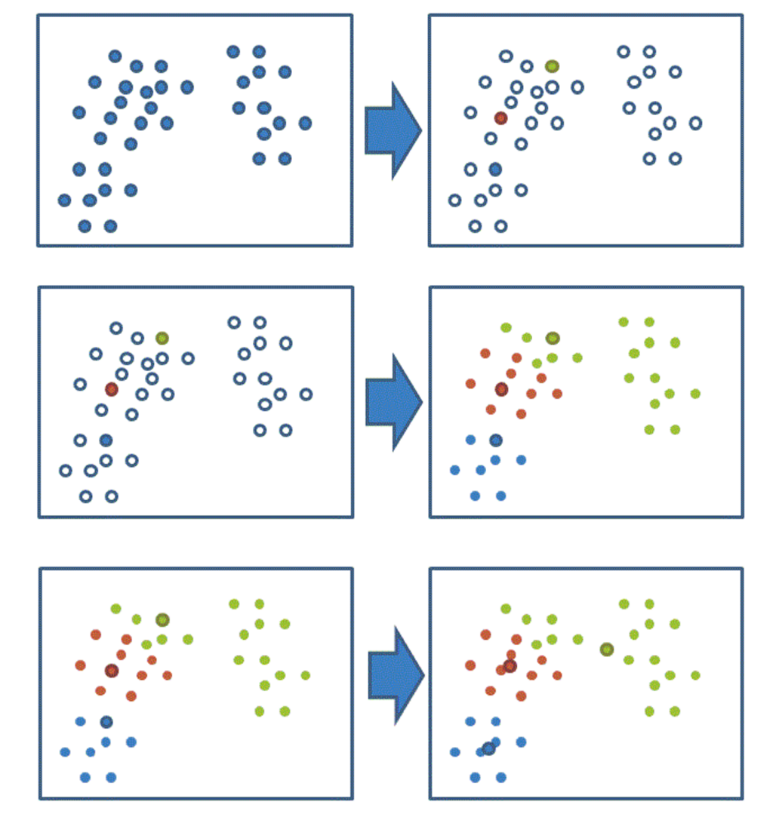

2、 K-means原理

- 随机设置K个特征空间内的点作为初始的聚类中心

- 对于其他每个点计算到K个中心的距离,未知的点选择最近的一个聚类中心点作为标记类别

- 接着对着标记的聚类中心之后,重新计算出每个聚类的新中心点(平均值)

- 如果计算得出的新中心点与原中心点一样,那么结束,否则重新进行第二步过程

3,API

from sklearn.cluster import KMeans- KMeans(n_clusters=8,init=‘k-means++’)

- n_clusters:开始的聚类中心数量

- init:初始化方法,默认为 'k-means ++’

- labels_:默认标记的类型,可以和真实值比较(不是值比较)

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

842

842

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?