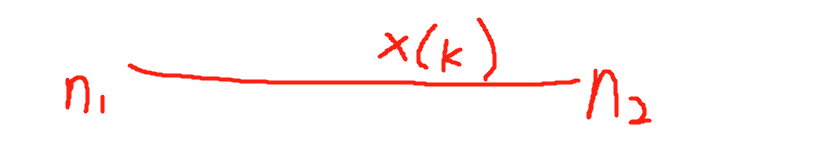

假设对x(k)和h(k)做卷积,x(k)的非零范围为n1~n2,h(k)的范围是m1~m2,以图形的方式做推导,效果最直观。

卷积的步骤可以整理为 翻转 移位 相乘 累加,我们选取h(k)做翻褶操作,得到h(-k)

接下来就是最重要的移位环节了,我们可以看到随着不断把h(-k)左移,二者有交集的部分越来越小,极限值就在向左移动-m1-n1长度,也即h(m1+n1-k),而x(k)*h(m1+n1-k)=y(m1+n1),所以左侧的起始点,可以推出是m1+n1,右侧的起始点,同理可以推出为m2+n2,整个序列长为m2+n2-m1-n1+1 = L1 + L2 - 1(L1,L2分别为x(k)与h(k)序列长度)

3410

3410

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?