前言:

本人在学习这次的大数据课程中,着实涨了不少见识呢,几乎把该遇到的、不该遇到的问题都遇到了呢。同时,本人也是把遇到过的这些问题都通过博客的形式记录了下来。一是,希望自己以后遇到同样问题的时候,第一时间可以来翻一下自己的博客;二是,希望可以帮助到那些跟我一样初学大数据的小伙伴们。

话锋急转,咱们回归正题。new hadoop location的时候没有反应,主要还是因为hadoop-eclipse-plugin插件没有弄好,问题的解决从编译插件开始着手。

1. 本人为什么出现了该问题??(问题来源)

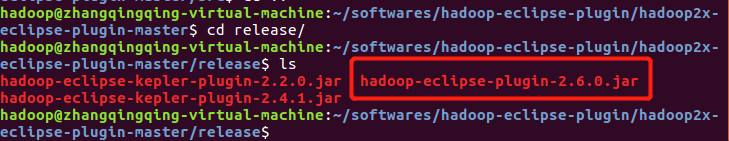

一开始本人是采用网络上普遍的方法,下载一个hadoop-eclipse-plugins.zip,并解压该文件,将其文件中的release里边的hadoop-eclipse-plugin-2.6.0.jar文件直接复制到eclipse安装目录下的plugins文件夹中,但是在new hadoop location的时候,就出现了没有反应的情况。

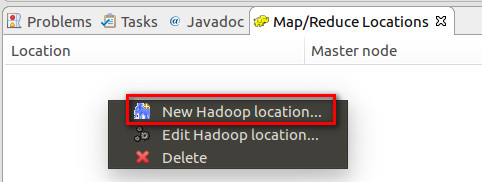

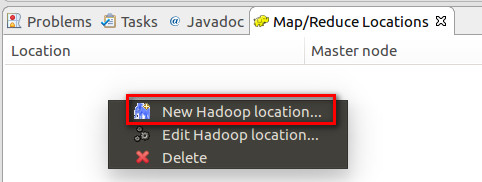

2. 具体的问题如下图(在右键单击New Hadoop location...的时候,选择之后并没有什么动静???):

3. 问题的解决方案:

第一步:下载一个hadoop-eclipse-plugin插件,本人是通过本地电脑下载,并上传至Ubuntu系统中的方式。

hadoop2x-eclipse-plugin.zip资源链接:https://pan.baidu.com/s/1opWEmgefoEA9fRxUwzketw

提取码:xw7i

hadoop-eclipse-plugin-3.1.2.jar资源链接:https://pan.baidu.com/s/1dgPJP8v5asCgUiI5yFOUSw

提取码:8hbv

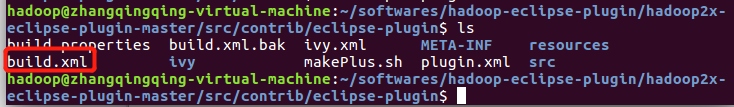

第二步:切换到以下目录(HADOOP-ECLIPSE-PLUGIN_INSTALL_PATH是hadoop-eclipse-plugin的安装目录):

HADOOP-ECLIPSE-PLUGIN_INSTALL_PATH/src/contrib/eclipse-plugin

第三步:为了节省大家的时间,本人会把自己一步一步执行遇到的问题,把问题的解决办法放在前边的步骤(第三步)中。当然,如果有些小伙伴享受自己一步一步地尝试解决问题的过程,也可以直接先执行第四步的命令。

遇到的问题一:在执行第四步中的命令的时候,执行到ivy-resolve-common处,就停止了。

解决方案:修改HADOOP-ECLIPSE-PLUGIN_INSTALL_PATH/src/contrib/eclipse-plugin目录下的build.xml文件,去除对ivy的依赖。

将<target name="compile" depends="init,ivy-retrieve-common" unless="skip.contrib">修改成<target name="compile" unless="skip.contrib">,即删除depends部分。

遇到的问题二:在执行第四步命令的出现出现copy XXX.jar出现错误。

解决方案:根据HADOOP_INSTALL_PATH/share/hadoop/common/lib目录下的jar来具体修改build.xml文件中copy里边的jar的版本(修改成具体的jar版本)。

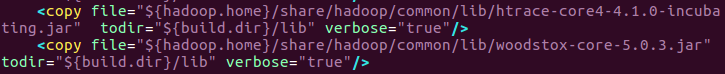

遇到的问题三:new hadoop location没反应,缺少了两个jar。

解决方案:在build.xml文件中添加这两个jar的内容(注意:添加第一个.jar时,记得先添加一个逗号)。

lib/woodstox-core-5.0.3.jar,

lib/stax2-api-3.1.4.jar

<copy file="${hadoop.home}"/share/hadoop/common/lib/woodstox-core-5.0.3.jar" todir="${build.dir}/lib" verbose="true"/>

<copy file="${hadoop.home}"/share/hadoop/common/lib/stax-api-3.1.4.jar" todir="${build.dir}/lib" verbose="true"/>如图:

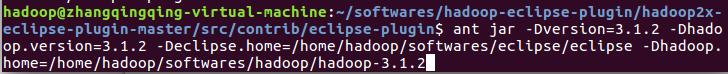

第四步:在HADOOP-ECLIPSE-PLUGIN_INSTALL_PATH/src/contrib/eclipse-plugin目录下执行如下命令:

ant jar -Dversion=3.1.2 -Dhadoop.version=3.1.2 -Declipse.home=/home/hadoop/softwares/eclipse/eclipse -Dhadoop.home=/home/hadoop/softwares/hadoop/hadoop-3.1.2

其中,-Declipse.home是eclipse的安装路径,-Dhadoop.home是hadoop的安装路径。

第五步:成功执行完第四步的命令之后,会在HADOOP-ECLIPSE-PLUGIN_INSTALL_PATH/src/contrib/eclipse-plugin目录下生成一个hadoop-eclipse-plugin-3.1.2.jar插件,此时需要将这个插件复制到ECLIPSE_INSTALL_PATH/plugins目录下。

注意:本人通过图形界面的方式没有复制成功,最后是通过命令的方式复制成功的。

复制命令如下:

cp hadoop-eclipse-plugin.jar /home/hadoop/softwares/eclipse/eclipse/plugins第六步:启动eclipse。本人首次启动eclipse的时候,在Project Explorer下并没有出现DFS Locations,而是...

解决方案:新建一个java project,之后就出现DFS Locations了。

第七步:然后,选择window —> preferences,点击Hadoop Map/Reduce按钮中,添加hadoop的安装目录。

第八步: 选择window —> Perspective —> Open Perspective —> Other,打开Map/Reduce视图。

Map/Reduce视图打开如下:

第九步: 在如下图空白部分(红色框住部分),通过右键单击或者点击蓝色的小象来new hadoop location.

此时,New Hadoop location之后会弹出如下弹框:

好了,今天的博客就到这里了,希望也能帮助到看到我博客的每一个小伙伴!!!

452

452

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?