一、缺失值处理

1.删除记录

删除数据缺失组,但是数据较少时慎重使用;若某个指标缺失值太多,直接指标删除

2.插补

①均值/众数插补:连续型、数值型——平均值/中位数,离散型——众数

适用赛题:缺失值占比较少,适用于对个体精度要求不大的统计数据,如人口的数量年龄、经济产业情况…

②最近邻插补(对众数插补的优化):

适用条件:数据量较少,离散数据,空间或时间具有接近性(欧氏距离衡量)

优点:保留离散特性

缺点:精度较低,有时会引入显著的偏差

适用赛题:适用于空间或时间连续的数据,如气候站点观测数据,时间序列插值…

③样条插值法:

用分段光滑的曲线去插值,光滑意味着曲线不仅连续,还要有连续的曲率

适用赛题:零件加工,水库水流量,图像“基线漂移”,机器人轨迹等精度要求高、没有突变的数据

④回归插补:

逻辑回归、决策树、随机森林、支持向量机、K近邻算法…

适用赛题:数据量较大,缺失值与相邻数据均有逻辑关系的问题

二、异常值处理

注意“假异常”和“真异常”

1.正态分布3σ原则

数值分布在(μ-3σ,μ+3σ)中的概率为99.73%,其中μ为平均值,σ为标准差。

求解步骤:1.计算均值μ和标准差σ;2.判断每个数据值是否在(μ-3σ,μ+3σ)内,不在则为异常值。

适用题目:总体符合正态分布,例如人口数据、测量误差、生产加工质量、考试成绩等。

不适用题目:总体符合其他分布,例如公交站人数排队论符合泊松分布

2.画箱型图

求解步骤:1.数据从小到大进行排序

2.下四分位数 Q1 是排第25%的数值,上四分位数 Q3 是排第75%的数值,四分位距 IQR=Q3-Q1

3.一般设 [ Q1−1.5×IQR, Q3+1.5×IQR ] 内为正常值,区间外为异常值

适用题目:适用于各种类型的问题,例如统计分析、财务分析、市场分析等

不适用题目:数据集非常小时不是很好用,因为不够敏感;数据集非常大,绘制箱型图比较困难,且会消耗大量的计算资源

3.视为缺失值,借助缺失值的处理方法进行处理

三、数据变换

即Z Score方法,将原始数据中心化后,再按照标准差缩放

即Z Score方法,将原始数据中心化后,再按照标准差缩放

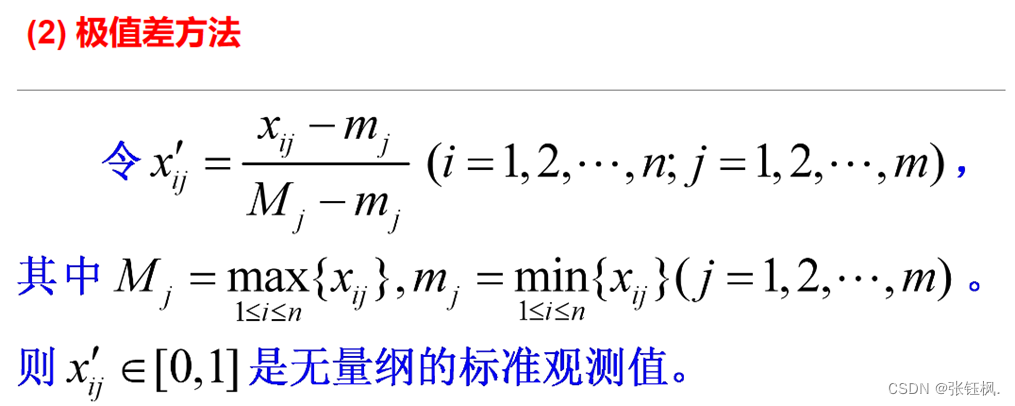

即Max-Min实现归一化处理,最后能够将数据收敛到[0,1]区间内

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?